hive数据仓库配置一个

- 行业动态

- 2025-05-13

- 2

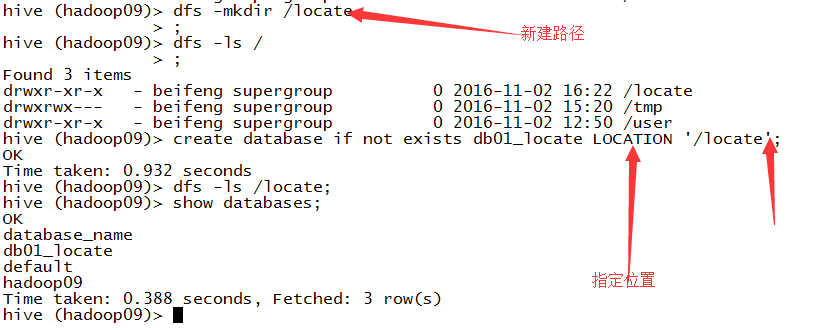

编辑hive-site.xml,配置Metastore URI(如mysql://user:pwd@host:3306/metastore)、HDFS路径,初始化元

Hive数据仓库配置详解

基础环境准备

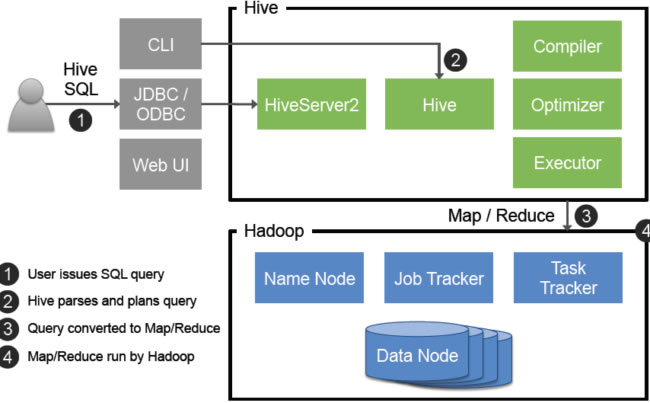

Hive作为大数据生态系统中的数据仓库工具,其运行依赖底层的Hadoop环境和Java环境,以下是配置前需完成的基础环境准备:

| 组件 | 版本要求 | 说明 |

|---|---|---|

| JDK | JDK 8+ | Hive编译和运行依赖Java环境,建议使用与Hadoop版本兼容的JDK版本。 |

| Hadoop | Hadoop 2.x/3.x | Hive依赖HDFS存储数据,YARN管理资源(非必须但推荐)。 |

| Hive | 与Hadoop版本匹配 | 需下载对应Hadoop版本的Hive发行包(如Hadoop 3.x对应Hive 3.x)。 |

操作步骤:

安装JDK并配置环境变量

export JAVA_HOME=/usr/java/jdk1.8.0_361 export PATH=$JAVA_HOME/bin:$PATH

部署Hadoop集群

- 配置HDFS(

core-site.xml、hdfs-site.xml) - 启动NameNode和DataNode服务

- 验证HDFS可用性:

hadoop fs -ls /

- 配置HDFS(

解压Hive安装包

tar -xzf apache-hive-3.1.2-bin.tar.gz -C /opt/ export HIVE_HOME=/opt/apache-hive-3.1.2 export PATH=$HIVE_HOME/bin:$PATH

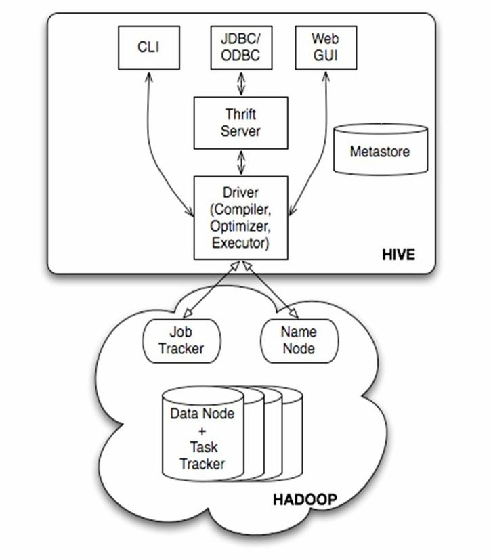

核心配置文件解析

Hive的核心配置文件为hive-site.xml,位于$HIVE_HOME/conf目录下,以下是关键配置项:

| 参数 | 默认值 | 作用 |

|---|---|---|

javax.jdo.option.ConnectionURL | jdbc:derby:memory:metastore | 元数据存储的JDBC连接URL(默认使用内嵌Derby数据库)。 |

javax.jdo.option.ConnectionDriverName | org.apache.derby.jdbc.ClientDriver | 元数据库驱动类名。 |

hive.metastore.uris | thrift://localhost:9083 | Metastore服务地址(用于客户端连接元数据服务)。 |

hive.execution.engine | mr | 执行引擎类型(可选mr、tez、spark)。 |

hive.exec.scratchdir | /tmp/hive | 临时文件存储目录(需在HDFS中创建并授权)。 |

hive.server2.thrift.port | 10000 | Beeline和JDBC连接的Thrift服务端口。 |

示例配置(hive-site.xml):

<property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:mysql://localhost:3306/hive_metastore?createDatabaseIfNotExist=true</value> </property> <property> <name>javax.jdo.option.ConnectionDriverName</name> <value>com.mysql.cj.jdbc.Driver</value> </property> <property> <name>hive.execution.engine</name> <value>tez</value> </property>

元数据存储配置

Hive元数据存储支持多种数据库,推荐使用MySQL或PostgreSQL以支持多实例共享元数据。

| 元数据库类型 | 优势 | 配置步骤 |

|---|---|---|

| 内嵌Derby | 零配置,开箱即用 | 直接启动Hive(适合测试环境)。 |

| MySQL | 高性能、广泛支持 | 创建数据库hive_metastore在 hive-site.xml中配置JDBC URL和驱动。 |

| PostgreSQL | 开源、事务支持 | 创建数据库hive_metastore配置JDBC URL和驱动。 |

MySQL配置示例:

- 创建数据库:

CREATE DATABASE hive_metastore;

- 在

hive-site.xml中添加:<property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:mysql://localhost:3306/hive_metastore?useSSL=false</value> </property> <property> <name>javax.jdo.option.ConnectionDriverName</name> <value>com.mysql.cj.jdbc.Driver</value> </property> <property> <name>javax.jdo.option.ConnectionUserName</name> <value>root</value> </property> <property> <name>javax.jdo.option.ConnectionPassword</name> <value>password</value> </property>

执行引擎选择与配置

Hive支持多种执行引擎,需根据业务场景选择:

| 引擎类型 | 适用场景 | 配置参数 |

|---|---|---|

| MR(MapReduce) | 兼容性优先,资源消耗较高 | hive.execution.engine=mr(默认) |

| Tez | 低延迟、高并发查询 | hive.execution.engine=tez需部署Tez服务 |

| Spark | 内存计算、复杂数据分析 | hive.execution.engine=spark集成Spark集群 |

Tez配置示例:

- 在

hive-site.xml中启用Tez:<property> <name>hive.execution.engine</name> <value>tez</value> </property> <property> <name>tez.lib.uris</name> <value>/path/to/tez-0.9.2.jar</value> </property>

- 启动Tez服务并验证:

tez-ui.sh

安全性配置

在生产环境中,需启用Kerberos认证和权限控制:

启用Kerberos认证

在hive-site.xml中配置:<property> <name>hive.server2.authentication</name> <value>kerberos</value> </property> <property> <name>hive.server2.authentication.kerberos.principal</name> <value>hive/_HOST@REALM.COM</value> </property>

配置HDFS ACL或Ranger权限

通过Ranger或Hadoop ACL限制用户对表、目录的访问权限。

性能优化配置

通过调整以下参数可显著提升查询性能:

| 参数 | 作用 | 推荐值 |

|---|---|---|

hive.exec.parallel | 是否允许并行执行 | true(默认) |

hive.exec.parallel.thread.number | 并行线程数 | 物理CPU核心数×2(如8核则设为16) |

hive.vectorized.execution.enabled | 向量化执行优化 | true(需开启C++编译器支持) |

hive.exec.dynamic.partition | 动态分区插入 | true(需配合hive.exec.dynamic.partition.mode=nonstrict) |

hive.optimize.sort.dynamic.partition | 动态分区排序优化 | true(减少Move任务) |

集群管理与高可用配置

Metastore高可用

通过MySQL/PostgreSQL主从复制实现元数据高可用。HiveServer2高可用

部署多实例HiveServer2并配合负载均衡器(如HAProxy)。集成Ambari/Cloudera Manager

通过管理工具统一监控Hive服务状态、日志和配置。

FAQs

Q1:如何选择Hive元数据库?

A1:若为测试环境或单节点部署,可使用内嵌Derby;生产环境推荐MySQL或PostgreSQL,因其支持多客户端共享元数据且性能更优,需提前创建数据库并配置JDBC驱动。

Q2:为什么Hive查询速度慢?如何优化?

A2:可能原因包括:

- 数据未分区或分区不合理 → 按业务字段(如日期)创建分区。

- 执行引擎效率低 → 切换为Tez或Spark。

- 资源不足 → 调整YARN队列内存和并行线程数。

- 未开启向量化执行 → 设置`hive.vectorized.