上一篇

hive数据仓库教程

- 行业动态

- 2025-05-07

- 2

Hive是基于Hadoop的数据仓库工具,支持SQL查询,适用于PB级数据分析,提供高效存储与

Hive数据仓库教程:从入门到实践

Hive

Hive是基于Hadoop的数据仓库工具,用于处理结构化数据,它通过类SQL语言(HiveQL)实现对大规模数据的存储、查询和管理,Hive将SQL语句转换为MapReduce任务,依赖HDFS存储数据,适合离线批处理场景。

核心特点:

- 扩展性:支持PB级数据存储。

- 兼容性:HiveQL与标准SQL语法高度相似。

- 灵活性:支持自定义函数(UDF)、存储格式(如ORC、Parquet)。

环境搭建与配置

前置条件

- Hadoop集群:Hive依赖HDFS,需提前部署Hadoop。

- JDK:版本需与Hadoop兼容(如JDK 8+)。

- MySQL:用于存储Hive元数据(MetaStore)。

安装步骤

| 步骤 | 命令/路径 | |

|---|---|---|

| 1 | 下载Hive | wget https://archive.apache.org/dist/hive/hive-3.1.2/apache-hive-3.1.2-bin.tar.gz |

| 2 | 解压至指定目录 | tar -xzf apache-hive-3.1.2-bin.tar.gz -C /opt/ |

| 3 | 配置环境变量 | 在~/.bashrc中添加:export HIVE_HOME=/opt/apache-hive-3.1.2export PATH=$PATH:$HIVE_HOME/bin |

| 4 | 初始化MetaStore数据库 | 使用MySQL创建数据库hive,并执行schematool -initSchema -dbType mysql |

| 5 | 启动Hive服务 | hive --service metastore(后台运行) |

配置文件说明

- hive-site.xml:关键配置项示例

<property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:mysql://localhost:3306/hive?useSSL=false</value> </property> <property> <name>hive.metastore.uris</name> <value>thrift://localhost:9083</value> </property>

Hive架构与核心组件

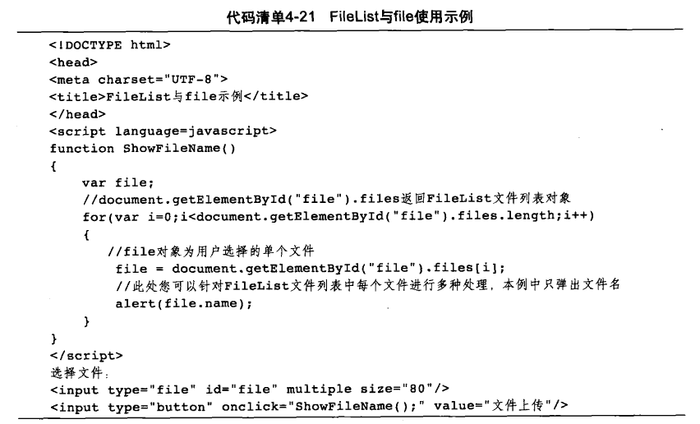

!Hive架构图 (示意图:Hive架构包含MetaStore、Driver、Executor等组件)

| 组件 | 功能描述 |

|---|---|

| MetaStore | 存储元数据(数据库、表、列信息),默认用MySQL或Derby。 |

| Driver | 解析HiveQL,生成执行计划,调用底层执行引擎(如MR或Tez)。 |

| Executor | 执行查询任务,管理MapReduce作业。 |

| HDFS | 存储实际数据文件(如Text、ORC、Parquet格式)。 |

| User Interface | Beeline(命令行)、HiveServer2(JDBC/ODBC接口)、Hues(Web UI)。 |

HiveQL基础操作

数据库与表管理

- 创建数据库:

CREATE DATABASE IF NOT EXISTS sales; USE sales;

- 创建表:

CREATE TABLE user_behavior ( uid STRING, event_time TIMESTAMP, event_type STRING, page_url STRING ) STORED AS ORC; -推荐使用ORC格式优化查询

- 外部表:指向已有HDFS数据,避免数据复制。

CREATE EXTERNAL TABLE external_logs ( line STRING ) STORED AS TEXTFILE LOCATION '/data/logs/';

数据加载与查询

从本地文件导入:

LOAD DATA INPATH '/tmp/user_behavior.csv' INTO TABLE user_behavior;

SELECT查询:

SELECT event_type, COUNT() AS cnt FROM user_behavior WHERE event_time >= '2023-01-01' GROUP BY event_type;

分区表操作:按时间分区优化查询。

CREATE TABLE orders ( order_id BIGINT, user_id BIGINT, price DOUBLE ) PARTITIONED BY (dt STRING) STORED AS ORC; -加载数据时指定分区 ALTER TABLE orders ADD PARTITION (dt='2023-05-01');

桶(Bucket)与排序

- 分桶表:将数据均匀分配到多个桶中,加速JOIN操作。

CREATE TABLE user_profile ( uid BIGINT, name STRING, age INT ) CLUSTERED BY (uid) INTO 10 BUCKETS; -分为10个桶

- 全局排序:

CREATE TABLE sorted_logs ( ts TIMESTAMP, log_content STRING ) CLUSTERED BY (ts) INTO 4 BUCKETS SORTED BY ts; -按时间排序

高级功能与优化

函数与自定义处理

- 内置函数:

CONCAT,SUBSTR,YEAR,UNIX_TIMESTAMP等。 - 自定义UDF:Java编写并部署到Hive。

public class ReverseString extends UDF { public String evaluate(String str) { return new StringBuilder(str).reverse().toString(); } } - 使用示例:

ADD JAR /path/to/udf.jar; CREATE TEMPORARY FUNCTION reverse AS 'com.example.ReverseString'; SELECT reverse(name) FROM user_profile;

索引与视图

- 索引:加速WHERE条件查询(需配合COMPACT存储格式)。

CREATE INDEX idx_user_id ON TABLE user_profile (uid) AS 'COMPACT';

- 视图:虚拟表,简化复杂查询。

CREATE VIEW recent_orders AS SELECT FROM orders WHERE dt = '2023-05-01';

性能优化策略

| 优化方向 | 具体措施 |

|---|---|

| 数据分区 | 根据业务字段(如日期、地区)分区,减少全表扫描。 |

| 文件格式 | 使用ORC/Parquet替代Text,支持列式存储和压缩。 |

| 并行执行 | 设置set hive.exec.parallel=true,启用多线程执行。 |

| 倾斜处理 | 通过MAPJOIN或skew join优化数据分布不均的JOIN操作。 |

| 资源配置 | 调整mapreduce.job.reduces、hive.exec.dynamic.partition等参数。 |

Hive与其他组件集成

- Impala:实时查询引擎,与Hive共享MetaStore,适合低延迟场景。

- Spark:通过

spark.sql读取Hive表,支持内存计算加速。 - Airflow:调度Hive脚本,实现ETL流程自动化。

FAQs(常见问题解答)

Q1:Hive与关系型数据库(如MySQL)的核心区别是什么?

A:Hive专为大规模数据处理设计,依赖HDFS分布式存储,适合批量分析;而MySQL是集中式数据库,适用于OLTP(在线事务处理)场景,Hive不支持事务和实时更新,但可通过分区和分桶优化查询性能。

Q2:如何处理Hive中的小表(数据量<1GB)?

A:小表建议使用MAPJOIN(内存中完成JOIN),避免生成大量MapReduce任务。

SELECT /+ MAPJOIN(b) / a., b.name FROM orders a JOIN user_profile b ON a.user_id =