hive数据仓库处理逻辑

- 行业动态

- 2025-05-08

- 2

Hive将SQL转为MapReduce任务,数据存HDFS,支持ET

Hive数据仓库处理逻辑详解

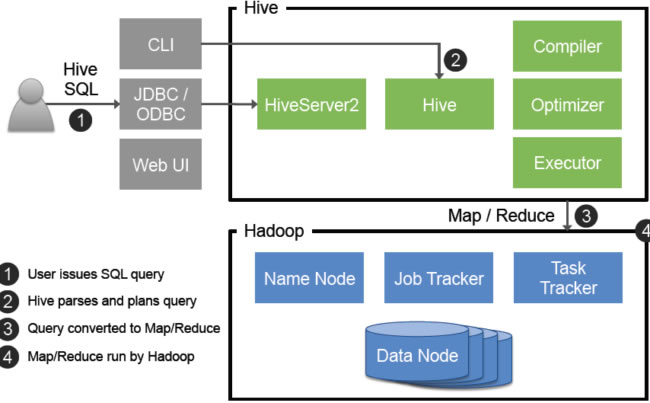

Hive是基于Hadoop的数据仓库工具,其核心目标是通过类SQL语言(HiveQL)实现对大规模数据的存储、管理和分析,以下是Hive数据仓库的完整处理逻辑,涵盖数据加载、存储管理、计算引擎、查询优化等关键环节。

数据加载与存储逻辑

Hive的数据存储依赖于HDFS(Hadoop Distributed File System),其处理逻辑从数据加载开始,分为以下步骤:

| 阶段 | 核心逻辑 |

|---|---|

| 数据导入 | 支持多种数据源(HDFS、本地文件、数据库、Kafka等)。 通过 LOAD DATA命令将数据写入Hive表,或通过INSERT INTO从其他表导入。 |

| 数据存储格式 | 默认存储为TextFile,但推荐使用列式存储格式(如ORC、Parquet)以提升查询性能。支持压缩(SNAPPY、ZLIB)、索引(BloomFilter)和统计信息收集。 |

| 分区与分桶 | 分区(Partition):按字段(如日期、地区)划分目录,减少全表扫描。 分桶(Bucket):根据哈希值将数据均匀分配到多个桶中,优化JOIN和聚合操作。 |

示例:创建分区表并加载数据

CREATE TABLE user_logs ( uid STRING, action STRING, timestamp BIGINT ) PARTITIONED BY (dt STRING) STORED AS ORC; -加载数据到分区 ALTER TABLE user_logs ADD IF NOT EXISTS PARTITION (dt='2023-10-01'); LOAD DATA INPATH '/raw_data/2023-10-01/' INTO TABLE user_logs PARTITION (dt='2023-10-01');

元数据管理与架构设计

Hive的元数据(表结构、分区信息、权限等)存储在关系型数据库(如MySQL、PostgreSQL)中,通过MetaStore服务管理,其核心逻辑包括:

表类型

- 内部表(Managed Table):Hive完全管理生命周期,删除表时数据一并删除。

- 外部表(External Table):仅管理元数据,删除表时保留数据,适合与其他工具共享数据。

Schema演进

- 支持

ALTER TABLE添加/删除列(需兼容ACID或MERGE操作)。 - 通过

CTAS(Create Table As Select)重构表结构。

- 支持

权限控制

基于角色(Role)和用户(User)的细粒度权限管理(读、写、执行)。

数据处理引擎与执行流程

Hive的查询执行依赖底层计算引擎,其处理逻辑如下:

| 步骤 | 逻辑描述 |

|---|---|

| 编译与优化 | 解析HiveQL为抽象语法树(AST)。 生成执行计划(Query Plan),应用谓词下推、列裁剪等优化。 |

| 转换为MapReduce/Tez/Spark | 将执行计划拆分为多个Stage(如Map阶段、Reduce阶段)。 支持多种计算引擎: MapReduce:默认引擎,适合高延迟任务。 Tez:基于DAG的内存计算,降低延迟。 Spark:支持迭代式计算和内存缓存。 |

| 任务提交与调度 | 由YARN或Tez调度器分配资源,启动容器执行任务。 支持动态分区插入和并发任务。 |

示例:查询执行流程

SELECT COUNT() FROM user_logs WHERE dt='2023-10-01' AND action='click';

- 优化逻辑:仅扫描

dt='2023-10-01'分区,利用BloomFilter跳过无关文件。 - 执行引擎:若配置Tez,则直接生成DAG任务,减少MapReduce阶段。

数据优化与性能调优

Hive的性能优化贯穿整个处理流程,关键策略包括:

| 优化方向 | 具体措施 |

|---|---|

| 存储优化 | 使用ORC/Parquet格式减少IO开销。 开启压缩(如SNAPPY)和索引(BloomFilter)。 定期合并小文件( OPTIMIZE命令)。 |

| 查询优化 | 合理设计分区字段,避免全表扫描。 使用分桶表加速JOIN操作。 开启CBO(Cost-Based Optimizer)优化执行计划。 |

| 参数调优 | 调整mapreduce.job.reduces控制Reducer数量。设置 hive.exec.parallel启用并行执行。调整 hive.exec.dynamic.partition允许动态分区。 |

典型应用场景与限制

Hive适用于离线批处理场景(如ETL、报表生成),但不擅长低延迟查询或实时计算,其核心特点包括:

- 优势:可扩展性(PB级数据)、兼容性(SQL语法)、与Hadoop生态无缝集成。

- 限制:实时性差(分钟级延迟)、不支持事务(需配合ACID或事务表)。

FAQs

问题1:Hive如何处理小文件过多的问题?

- 原因:小文件会占用大量HDFS块,增加NameNode压力并降低查询效率。

- 解决方案:

- 使用

ORC或Parquet格式合并文件。 - 通过

INSERT OVERWRITE或OPTIMIZE命令合并小文件。 - 调整

hive.merge.smallfiles.avgsize参数,自动合并小文件。

- 使用

问题2:Hive中如何解决数据倾斜问题?

- 原因:某些Key对应的数据量过大,导致部分Reducer任务长时间运行。

- 解决方案:

- 使用

MAPJOIN(小表广播)避免JOIN时的数据倾斜。 - 对倾斜Key添加随机前缀(如

UUID)进行分桶。 - 启用

hive.groupby.skewindata参数,自动优化GROUP BY操作。

- 使用

— 覆盖了Hive数据仓库的核心处理逻辑,从数据加载到查询优化,结合实际场景和调优策略,可满足企业级数据分析需求