上一篇

hive数据仓库和传统数据仓库

- 行业动态

- 2025-05-09

- 4

Hive属大数据仓库,依托Hadoop分布式存储,批处理非结构化数据;传统侧重OLTP,结构化存储,成本高

核心概念对比

| 维度 | Hive数据仓库 | 传统数据仓库 |

|---|---|---|

| 架构基础 | 基于Hadoop生态(HDFS+YARN) | 专用硬件+MPP架构(如Teradata、Netezza) |

| 数据存储 | 列式存储(ORC/Parquet) | 行式存储(如InnoDB、Greenplum) |

| 计算模型 | 批量处理(MapReduce/Tez/Spark) | 实时/准实时处理(物化视图、索引) |

| 扩展性 | 横向扩展(添加节点) | 纵向扩展(依赖高端硬件) |

| 成本 | 开源软件+廉价PC服务器 | 专有硬件+授权费用 |

| 数据类型支持 | 非结构化/半结构化(JSON/XML/日志) | 结构化数据为主 |

| 开发门槛 | 需掌握Hadoop生态、Java/Python | 传统SQL开发 |

技术特性深度解析

存储与计算分离

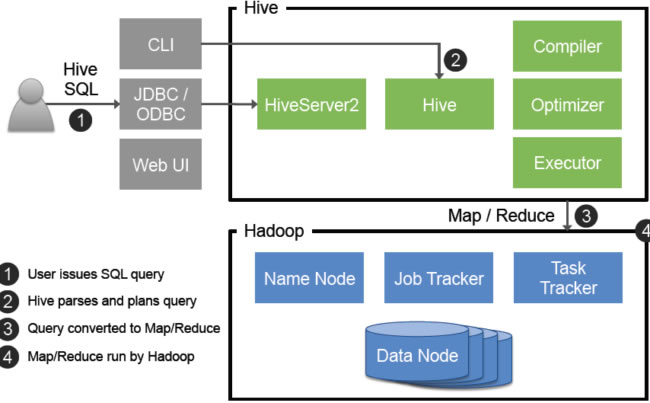

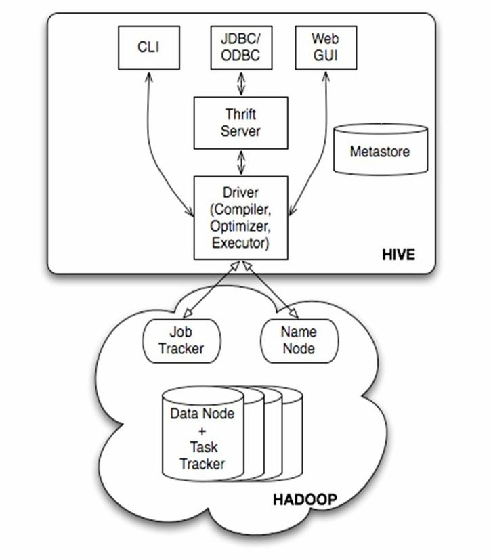

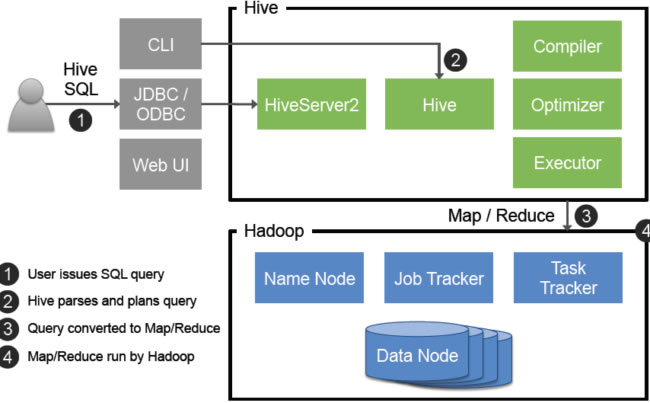

- Hive:数据存储在HDFS中,计算任务由YARN调度资源,天然解耦,支持PB级数据存储,但小文件过多会影响性能。

- 传统数仓:存储与计算强耦合,通过列存索引(如B+树)加速查询,但扩展时需整体升级硬件。

数据处理模式

- Hive:适合离线批处理,典型流程为:加载数据到HDFS → 编写HiveQL脚本 → 生成中间结果 → 存储回HDFS,对流式数据处理支持有限(需配合Kafka+Spark)。

- 传统数仓:支持实时ETL(如Change Data Capture),通过物化视图预聚合数据,适合高并发OLAP查询。

性能优化手段

| 优化方向 | Hive | 传统数仓 |

|---|---|---|

| 分区 | 按时间/业务维度分区(如PARTITIONED BY) | 哈希分区/范围分区 |

| 索引 | 无原生索引,依赖Bitmap索引(需手动创建) | 自动创建B+树索引 |

| 并行度 | 依赖Hadoop Task数量配置 | 自动负载均衡 |

| 缓存 | 内存缓存(如LLC)需手动配置 | 自动结果集缓存 |

数据治理能力

- Hive:依赖外部工具(如Apache Ranger)实现RBAC权限管理,元数据存储在关系型数据库(如MySQL)。

- 传统数仓:内置完整元数据管理(如Teradata Viewpoint),支持细粒度审计和血缘分析。

典型应用场景对比

| 场景 | 推荐方案 | 原因 |

|---|---|---|

| 日志分析(PB级) | Hive+HDFS | 低成本存储、批处理能力强 |

| 实时风控系统 | 传统数仓(如Greenplum) | 低延迟查询、事务一致性支持 |

| 数据湖构建 | Hive+Iceberg | 支持ACID事务、兼容多种数据格式 |

| BI报表(亚秒级响应) | 传统数仓+列式存储引擎 | 预聚合优化、物化视图刷新机制 |

混合部署实践

企业常采用”Lambda架构”结合两者优势:

- 热数据层:传统数仓处理实时流(Kafka+Flink)

- 冷数据层:Hive存储历史数据(ORC格式+Snappy压缩)

- 查询层:通过Impala实现实时查询,底层数据仍存储在HDFS

FAQs

Q1:Hive是否支持事务型操作?

A:原生Hive不支持ACID事务,但可通过以下方案实现:

- 使用

INSERT OVERWRITE替代UPDATE - 集成Iceberg/Hudi等数据湖框架

- 配合Kafka实现变更数据捕获(CDC)

Q2:传统数仓能否处理非结构化数据?

A:传统数仓主要面向结构化数据,但可通过以下方式扩展:

- 预处理清洗:将JSON/XML转换为关系表

- 集成文档数据库(如MongoDB Connector)

- 使用对象-关系映射工具(如Talend)

代价是牺牲部分性能且运维复杂度增加,因此非结构化