hive数据仓库基础使用

- 行业动态

- 2025-05-08

- 2

Hive是基于Hadoop的数据仓库工具,支持SQL查询,通过HDFS存储数据,适用于大规模数据分析与ETL处理

Hive数据仓库基础使用详解

Hive与核心概念

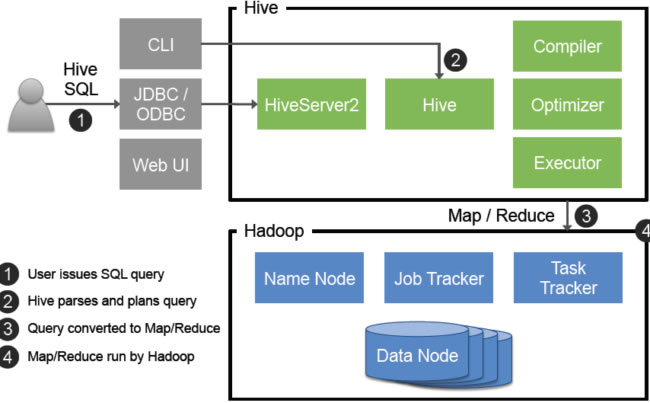

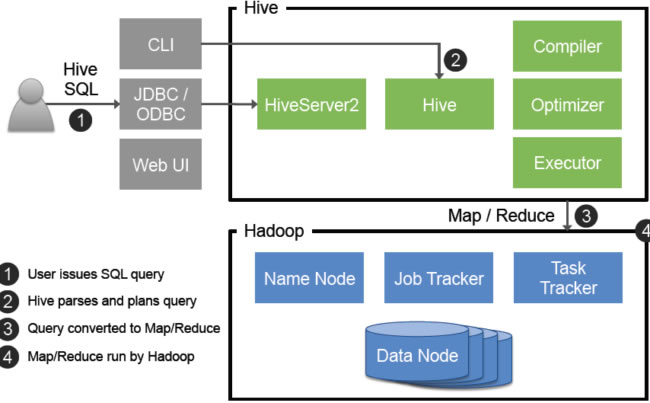

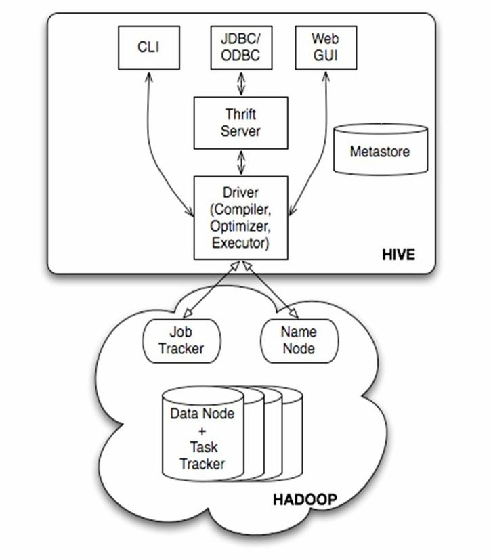

Hive是基于Hadoop的数据仓库工具,通过类SQL语法(HiveQL)实现对大规模数据的存储、计算和管理,其核心特点包括:

- 分布式架构:依赖HDFS存储数据,利用YARN调度计算资源。

- Schema-On-Read:数据写入时无严格模式限制,读取时通过定义Schema解析。

- 延迟计算:查询提交后生成执行计划,实际计算由MapReduce/Tez/Spark引擎执行。

核心组件:

| 组件 | 功能 |

|—————|———————————————————————-|

| Metastore | 元数据存储(表结构、分区信息等),默认用内嵌Derby,生产环境建议MySQL/PostgreSQL |

| Driver | 编译HiveQL为执行计划,提交到YARN/MapReduce |

| CLI/Beeline | 命令行/JDBC接口 |

| UDF/SerDe | 用户自定义函数与序列化/反序列化库 |

环境搭建与配置

前置条件

- Hadoop集群(HDFS + YARN)

- Java 8+环境

- MySQL(推荐5.7+)用于Metastore

配置关键参数

# hive-site.xml核心配置 hive.metastore.uris=thrift://metastore_host:9083 # Metastore服务地址 hive.execution.engine=mr # 可选mr/tez/spark hive.exec.scratchdir=/tmp/hive # 临时数据目录 fs.defaultFS=hdfs://namenode:8020 # HDFS地址

初始化Metastore

# 初始化元数据库(首次启动需执行) schematool -initSchema -dbType mysql -username root -password 'your_pwd'

基础操作实战

创建数据库与表

-创建数据库

CREATE DATABASE retail_db COMMENT '零售数据仓库';

USE retail_db;

-创建分区表(按日期分区)

CREATE TABLE orders (

order_id BIGINT,

user_id STRING,

price DOUBLE,

order_date DATE

) PARTITIONED BY (dt STRING)

STORED AS ORC;数据加载

# 从本地文件加载(需先上传到HDFS) LOAD DATA INPATH '/data/orders/2023-10-01.csv' INTO TABLE orders PARTITION (dt='2023-10-01'); # 从HDFS目录批量加载 ALTER TABLE orders ADD PARTITION (dt='2023-10-02') LOCATION 'hdfs:///data/orders/2023-10-02';

基础查询

-查询某天订单总额 SELECT SUM(price) FROM orders WHERE dt='2023-10-01'; -多分区联合查询 SELECT user_id, COUNT() FROM orders WHERE dt RLIKE '2023-10.' GROUP BY user_id;

数据存储格式对比

| 格式 | 适用场景 | 压缩支持 | 查询性能 |

|---|---|---|---|

| Text | 简单日志分析 | 无 | 低 |

| SequenceFile | 中等规模数据快速读写 | Block压缩 | 中 |

| ORC | 复杂分析、列式存储 | Zlib/Snappy | 高(列式存储+优化) |

| Parquet | 跨引擎兼容(Spark/Presto) | 多种压缩 | 高 |

示例:创建Parquet格式表

CREATE TABLE user_logs (

uid STRING,

event_time TIMESTAMP,

event_type STRING,

properties MAP<STRING, STRING>

) STORED AS PARQUET;高级功能实践

动态分区与桶排序

-创建桶排序表(按user_id哈希分桶)

CREATE TABLE user_buckets (

uid STRING,

region STRING,

login_time TIMESTAMP

) CLUSTERED BY (uid) INTO 10 BUCKETS;

-插入数据时启用动态分区

INSERT OVERWRITE TABLE user_buckets PARTITION (region)

SELECT uid, region, login_time, region FROM user_logs;窗口函数与CTE

-计算用户7日留存率

WITH user_stream AS (

SELECT uid, MIN(event_time) first_login

FROM user_logs GROUP BY uid

)

SELECT

COUNT(DISTINCT CASE WHEN datediff(event_time, first_login) < 7 THEN uid END) / COUNT()

FROM user_logs u JOIN user_stream s ON u.uid = s.uid;性能优化策略

分区裁剪

-错误写法(全表扫描) SELECT FROM orders WHERE substr(dt,1,7) = '2023-10'; -正确写法(分区字段直接过滤) SELECT FROM orders WHERE dt LIKE '2023-10%';

文件合并设置

# hive-site.xml配置合并小文件 hive.merge.mapfiles=true # Map阶段输出合并 hive.merge.mapredfiles=false # Reduce阶段不合并(避免过度合并) hive.merge.size.per.task=256M # 合并目标文件大小

索引使用

-创建Compacted索引(适合高频查询字段) CREATE INDEX idx_user_id ON TABLE user_buckets (uid) AS 'COMPACT' WITH DEFERRED REBUILD;

日常管理维护

Metastore维护

# 查看所有数据库 hive -e "SHOW DATABASES;" # 修复元数据不一致问题 MSCK REPAIR TABLE orders;

权限控制

-基于角色授权(需开启RBAC) CREATE ROLE data_analyst; GRANT ROLE data_analyst TO USER alice; GRANT SELECT ON TABLE orders TO ROLE data_analyst;

FAQs常见问题解答

Q1:Hive与关系型数据库的核心区别是什么?

A:主要差异体现在:1)Hive适合PB级离线分析,传统数据库侧重实时事务;2)Hive采用最终一致性模型,不支持ACID事务;3)数据存储格式优化为列式存储(如ORC),压缩比高;4)计算引擎依赖Hadoop生态,可扩展性更强。

Q2:如何处理小文件过多导致的性能问题?

A:解决方案包括:1)启用CombineTextInputFormat合并小文件;2)使用hive.input.format=org.apache.hadoop.hive.ql.io.HiveInputFormat自动合并;3)通过ALTER TABLE ... CONCATENATE合并分区;4)业务侧设计时增加分区粒度(如按小时分区