上一篇

hive数据仓库使用方法

- 行业动态

- 2025-05-10

- 1

建表定义结构,数据存HDFS,写HiveQL查询,执行分析

Hive数据仓库使用方法详解

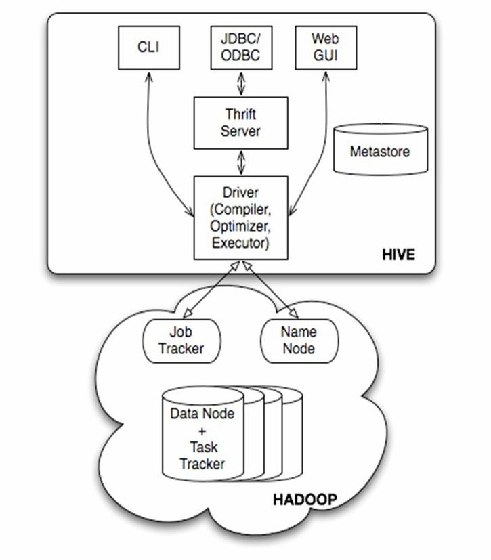

Hive与核心架构

Hive是基于Hadoop的分布式数据仓库工具,通过类SQL语法(HiveQL)实现对大规模数据的存储、查询和管理,其核心架构包含以下组件:

| 组件 | 功能描述 |

|---|---|

| Metastore | 元数据管理系统,存储表结构、分区信息、权限等(默认基于MySQL/PostgreSQL) |

| Driver | 解析HiveQL语句并生成执行计划 |

| Compiler | 编译执行计划,优化查询路径 |

| Execution Engine | 执行查询任务(支持MapReduce、Tez、Spark等多种引擎) |

| HDFS | 底层存储系统,存储实际数据(按表、分区、桶组织) |

!Hive架构图 (示意图需替换为实际图片链接)

环境搭建与配置

依赖安装:

- Hadoop集群(版本兼容)

- MySQL/PostgreSQL(用于Metastore)

- JDK 8+

- Hive二进制包(官网下载)

配置文件关键参数:

| 参数 | 说明 | 示例值 |

|———————|————————————–|————————-|

|hive.metastore.uris| Metastore服务地址 |thrift://localhost:9083|

|hive.execution.engine| 执行引擎(MapReduce/Tez/Spark) |mr/tez/spark|

|hive.cli.print.header| CLI输出是否显示列名 |true|初始化元数据:

schematool -initSchema -dbType mysql

DDL操作与表设计

创建表:

CREATE TABLE user_behavior ( user_id STRING, action_time TIMESTAMP, page_url STRING, stay_time INT, session_id STRING ) PARTITIONED BY (dt STRING) STORED AS ORC COMMENT '用户行为日志表';

分区与桶:

- 分区:按时间/地域等维度划分数据,提升查询效率。

ALTER TABLE user_behavior ADD PARTITION (dt='2023-10-01');

- 桶:哈希分布数据至指定数量文件,优化Join性能。

CREATE TABLE sales ( order_id BIGINT, amount DECIMAL(10,2) ) CLUSTERED BY (order_id) INTO 10 BUCKETS;

- 分区:按时间/地域等维度划分数据,提升查询效率。

外部表与临时表:

- 外部表:数据删除时不删除HDFS文件。

CREATE EXTERNAL TABLE external_log (...) LOCATION '/external/logs/';

- 临时表:会话级生命周期,用于中间计算。

CREATE TEMPORARY TABLE temp_uv AS SELECT DISTINCT user_id FROM user_behavior;

- 外部表:数据删除时不删除HDFS文件。

数据加载与ETL操作

| 方法 | 适用场景 | 命令示例 |

|---|---|---|

| LOAD DATA | 本地文件导入 | LOAD DATA INPATH '/local/data.csv' INTO TABLE logs; |

| SCALE IMPORT | 多节点并行导入 | MSCK REPAIR TABLE user_behavior; |

| INSERT OVERWRITE | 覆盖写入(支持Select查询) | INSERT OVERWRITE TABLE partitioned_table PARTITION (dt) SELECT FROM staging; |

| 动态分区 | 按字段自动创建分区 | SET hive.exec.dynamic.partition=true; |

HiveQL查询实战

复杂查询示例:

SELECT DATE_FORMAT(action_time, 'HH') as hour, COUNT(DISTINCT user_id) as uv, SUM(CASE WHEN page_url LIKE '%checkout%' THEN 1 ELSE 0 END) as cart_events FROM user_behavior WHERE dt = '2023-10-01' GROUP BY hour ORDER BY hour;

窗口函数应用:

SELECT user_id, action_time, LAG(action_time,1) OVER (PARTITION BY user_id ORDER BY action_time) as last_visit_time FROM user_behavior;

CTE(公共表表达式):

WITH click_stream AS ( SELECT user_id, page_url, action_time FROM user_behavior WHERE action_type='click' ) SELECT FROM click_stream WHERE stay_time > 30;

性能优化策略

倾斜处理:

- 症状:少数Reducer任务执行极慢。

- 解决方案:

SET mapreduce.job.reduces=<更大数值>; -增加Reducer数量 SET hive.groupby.skewindata=true; -启用倾斜数据优化

ORC文件优化:

- 开启列式存储压缩:

STORED AS ORC TBLPROPERTIES ('orc.compress'='SNAPPY'); - 开启BloomFilter:

TBLPROPERTIES ('orc.bloom.filter.columns'='user_id,page_url');

- 开启列式存储压缩:

索引加速:

CREATE INDEX idx_user_id ON TABLE user_behavior (user_id) AS 'COMPACT' WITH DEFERRED REBUILD; ANALYZE TABLE user_behavior COMPUTE STATISTICS; -更新统计信息

企业级应用场景

场景1:电商大促分析

- 需求:统计每小时UV、PV、转化率。

- 实现:

- 按小时分区存储日志数据。

- 使用MapJoin加速用户ID与订单ID的关联。

- 通过CTE分层计算中间指标。

场景2:用户画像构建

- 流程:

- 抽取原始行为日志 → 清洗异常数据 → 聚合设备特征 → 关联用户属性。

- 使用动态分区按日期存储画像数据。

- 通过视图(VIEW)封装复杂逻辑。

常见错误与排查

| 错误代码 | 原因分析 | 解决方案 |

|---|---|---|

Error running job | 语法错误/字段类型不匹配 | 检查HiveQL语法,验证表结构 |

FileSystem closed | HDFS连接中断 | 重启Hive客户端,检查网络 |

Out of memory | Yarn资源不足 | 调整yarn.nodemanager.vmem-pmem-ratio参数 |

FAQs(常见问题解答)

Q1:Hive与关系型数据库的核心区别是什么?

A:Hive专为离线分析设计,支持PB级数据处理,但实时性差(分钟级延迟);而关系型数据库(如MySQL)适合OLTP场景,强调事务一致性和低延迟查询,Hive通过分布式计算框架实现横向扩展,而传统数据库依赖纵向硬件升级。

Q2:如何处理Hive中的小文件过多问题?

A:小文件会导致Map任务过多,消耗集群资源,可通过以下方式合并:

- 使用CombineHintSpecular:

SET hive.input.format=org.apache.hadoop.hive.ql.io.CombineHintSpecular; - 定期执行合并:

ALTER TABLE table_name CONCATENATE;(ORC格式表) - 调整采集频率:将数据先缓存到临时目录,达到阈值