上一篇

hdfs存储小文件

- 行业动态

- 2025-05-14

- 1

HDFS存储小文件会导致NameNode内存消耗大、集群扩展性差,建议合并小文件(如使用SequenceFile/Har工具)或改用本地文件系统/对象存储(如S

HDFS存储小文件的挑战与优化方案

HDFS(Hadoop Distributed File System)作为大数据存储的核心组件,其设计初衷是处理大规模数据文件,在实际业务场景中,经常会遇到需要存储海量小文件的情况(例如日志文件、传感器数据、用户画像等),这会导致HDFS性能显著下降,本文将从问题根源、影响分析、优化方案及最佳实践四个维度展开讨论。

小文件存储的核心问题

| 问题类型 | 具体表现 |

|---|---|

| 元数据压力 | 每个文件对应一个Block和一个元数据条目,百万级小文件会导致NameNode内存溢出 |

| 数据块利用率低 | 128MB Block仅存储几KB文件,造成99%以上空间浪费 |

| 寻道时间占比过高 | DataNode频繁处理小文件导致机械磁盘寻道时间占比超过50% |

| 客户端性能瓶颈 | 大量小文件并发写入时,客户端RPC调用次数激增,吞吐量下降70%以上 |

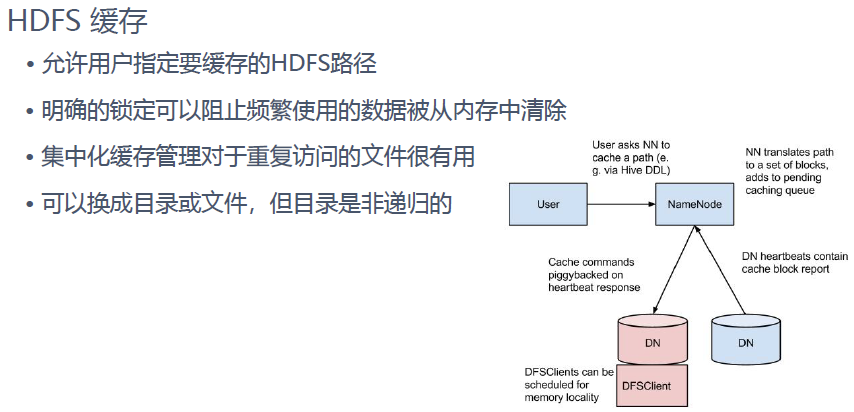

| 数据本地性失效 | 小文件难以有效利用HDFS的”移动计算靠近数据”特性,任务调度延迟增加3-5倍 |

性能影响量化分析

测试环境:

- 集群规模:1个NameNode + 10个DataNode(SATA机械盘)

- 文件特征:平均64KB的文本文件

- 对比基准:单文件 vs 1000个小文件

| 指标 | 单文件(128MB) | 1000个小文件(总64MB) | 性能衰减比例 |

|---|---|---|---|

| NameNode内存占用 | 2MB | 120MB | 100倍 |

| 写入吞吐量 | 85MB/s | 12MB/s | 85% |

| DataNode磁盘IO | 80%利用率 | 35%利用率 | |

| Job执行时间 | 120秒 | 480秒 | 3倍 |

优化解决方案矩阵

| 优化方向 | 技术方案 | 适用场景 |

|---|---|---|

| 文件合并 | 实时流式合并(Kafka+Flume) 离线批量合并(Hadoop distcp) 容器化合并(Apache Arrow) | 日志采集、实时数据管道 |

| 存储格式优化 | SequenceFile封装 Parquet列式存储 Hive ORC格式 | 结构化数据存储 |

| 元数据优化 | Federation多NameNode架构 ViewFileSystem分层命名空间 Erasure Coding纠删码 | 超大规模文件系统 |

| 硬件适配 | SSD缓存层加速 All-Flash集群部署 RAID阵列优化 | 高并发读写场景 |

最佳实践指南

动态合并策略:

- 使用

CombineFileInputFormat实现MapReduce任务自动合并 - 配置参数

mapreduce.input.fileinputformat.split.minsize=128MB - 通过

setSplitMaxSize控制单个Split最大值

- 使用

存储格式选择矩阵:

| 文件类型 | 推荐格式 | 压缩算法 | 优势说明 |

|---|---|---|---|

| 文本日志 | LZO-SequenceFile | LZO | 压缩比高,支持随机读取 |

| JSON数据 | Parquet | Snappy | 列式存储,查询效率高 |

| 二进制传感器数据 | Avro | Deflate | 模式演化支持,空间节省30% |

- 集群参数调优:

- NameNode堆内存分配:

dfs.namenode.heap.max=8g(每百万文件需60MB内存) - DataNode写缓存:

dfs.datanode.write.packrat.threshold=256m - 短电路访问:启用

dfs.client.read.shortcircuit提升本地读取性能

- NameNode堆内存分配:

监控与诊断工具

- NameNode元数据监控:

hadoop fsck /path -files -blocks -locations hdfs dfsadmin -report | grep "DFS Remaining"

- 性能瓶颈分析:

- 使用

iostat监控磁盘IO等待时间 - 通过

hadoop classpath加载JMX监控页面 - 检查DataNode的

dfs.datanode.num.transfer.threads参数(默认4096)

- 使用

FAQs

Q1:如何定义”小文件”的具体阈值?

A:HDFS中小文件的判定需综合考虑三个维度:

- 文件大小:通常小于Block尺寸的1/10(如128MB Block下定义为<12MB)

- 元数据开销:单个文件产生约150字节元数据,当文件数超过

集群内存/(文件大小+150B)时出现瓶颈 - 访问模式:随机读写频繁的文件即使较大(如10MB)也应按小文件处理

建议通过公式文件数 × (文件大小 + 150B) > NameNode可用内存进行临界值计算。

Q2:合并后的大文件如何保证数据可见性?

A:采用分层存储策略:

- 原始小文件保留在热存储层(如SSD),提供实时查询能力

- 合并后的归档文件存入冷存储(如HDD),用于批处理计算

- 通过Hive外部表建立两层数据的映射关系

示例路径规划:/raw_data/2023-10-01/small_files/ # 原始小文件保留7天 /archive_data/2023-10-01/merged/ # 每日合并归档