上一篇

hdfs存储编程

- 行业动态

- 2025-05-13

- 3

HDFS存储编程通过Java/Python API实现文件读写、分布式存储管理,支持高可用

HDFS存储编程详解

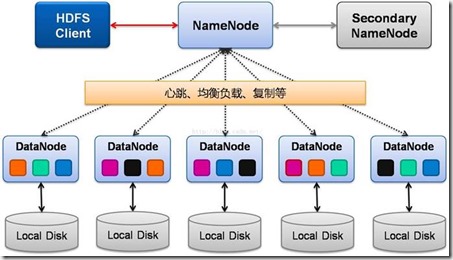

HDFS(Hadoop Distributed File System)是Hadoop生态系统中的分布式文件系统,专为大规模数据存储和高吞吐量访问设计,其存储编程涉及文件操作、目录管理、权限控制及性能优化等多个层面,本文将从编程接口、核心操作、性能调优及常见问题四个维度展开,结合代码示例与配置说明,帮助开发者掌握HDFS存储编程的核心技能。

HDFS编程接口与核心类库

HDFS提供多种编程语言的API,其中Java是原生支持的语言,其他语言(如Python、C#)可通过第三方库实现,以下是主流编程接口的核心组件:

| 编程语言 | 核心库/依赖 | 关键类/方法 |

|---|---|---|

| Java | hadoop-common + hadoop-hdfs | FileSystem, Path, DFSClient |

| Python | pydoop / hdfs | InsecureClient, AvroWriter |

| C# | Hadoop.Net | FileSystem, DistributedFileSystem |

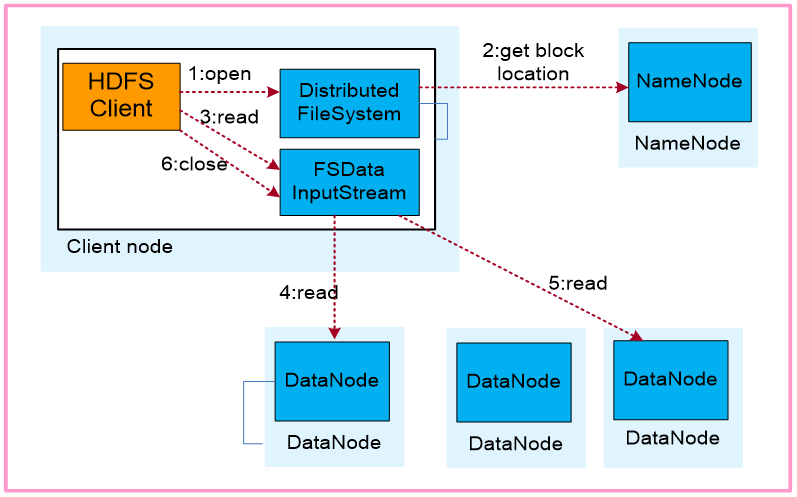

Java API 核心流程:

- 配置初始化:通过

Configuration对象加载HDFS配置(如core-site.xml、hdfs-site.xml)。 - 获取FileSystem实例:调用

FileSystem.get(conf)获取HDFS客户端。 - 执行文件操作:使用

FSDataInputStream/FSDataOutputStream读写数据,或调用FileSystem的create/delete方法。

示例代码(Java):

Configuration conf = new Configuration();

conf.set("fs.defaultFS", "hdfs://namenode:8020");

FileSystem fs = FileSystem.get(conf);

Path filePath = new Path("/user/data/input.txt");

// 写入数据

FSDataOutputStream out = fs.create(filePath);

out.writeBytes("Hello HDFS

");

out.close();

// 读取数据

FSDataInputStream in = fs.open(filePath);

String content = IOUtils.toString(in, StandardCharsets.UTF_8);

System.out.println(content);文件与目录操作

HDFS的文件操作与本地文件系统类似,但需注意分布式特性(如块存储、副本机制)。

| 操作类型 | 方法/命令 | 说明 |

|---|---|---|

| 创建文件 | fs.create(path) | 默认块大小128MB,副本因子3 |

| 删除文件 | fs.delete(path, recursive) | recursive=true时递归删除目录 |

| 重命名文件 | fs.rename(src, dst) | 原子操作,适用于文件或目录 |

| 列出目录 | fs.listStatus(dirPath) | 返回FileStatus数组,包含文件元数据 |

| 文件存在性检查 | fs.exists(path) | 检查路径是否存在 |

目录管理注意事项:

- HDFS目录结构扁平化设计更高效,避免过深路径。

- 使用

fs.mkdirs(path)创建多级目录,需确保权限充足。

权限与安全控制

HDFS支持基于POSIX的权限模型(读/写/执行)及ACL(访问控制列表),并通过Kerberos实现认证。

| 安全机制 | 配置项 | 作用 |

|---|---|---|

| 权限模式 | fs.permissions.umask-mode | 默认目录权限(如0777允许全访问) |

| Kerberos认证 | hadoop.security.authentication | 启用kerberos后需配置Keytab文件 |

| ACL | fs.namenode.acls.enabled | 细粒度控制用户/组访问权限 |

Java代码设置ACL示例:

// 为文件设置用户读写权限 AclStatus status = fs.getAclStatus(filePath); List<AclEntry> entries = new ArrayList<>(status.getEntries()); AclEntry entry = new AclEntry(AclEntryType.USER, "alice", AclEntryPermission.READ_EXECUTE, AclEntryPermission.WRITE); entries.add(entry); fs.modifyAclEntries(filePath, entries);

性能优化策略

HDFS性能受硬件配置、网络带宽及参数调优影响,以下为关键优化点:

| 优化方向 | 参数/配置 | 建议值 |

|---|---|---|

| 块大小 | dfs.blocksize | 大文件(>1GB)设为128MB或256MB |

| 副本因子 | dfs.replication | 开发环境设为1,生产环境设为3 |

| 数据压缩 | io.compression.codecs | 启用org.apache.hadoop.io.compress.SnappyCodec |

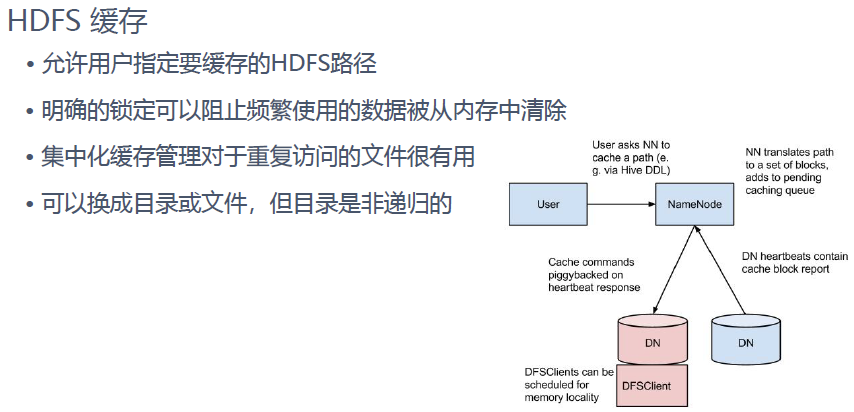

| 缓存策略 | fs.hdfs.impl.disable.cache | 设为true禁用客户端缓存以提高吞吐量 |

数据本地性优化:

- 将计算任务调度到数据所在节点(如YARN容器分配策略)。

- 使用

FileInputFormat的split机制减少跨节点数据传输。

常见问题与解决方案

问题1:写入大文件时NameNode内存溢出

原因:文件过大导致Metadata(如Block位置、副本信息)占用过多内存。

解决:

- 调整

dfs.namenode.handler.count(并发处理数)和dfs.namenode.name.cache(缓存大小)。 - 拆分大文件为多个小文件(如按时间分区)。

问题2:客户端无法连接HDFS(UnresolvedHost错误)

原因:core-site.xml中的fs.defaultFS配置错误或网络不通。

解决:

- 检查配置文件中的NameNode地址(如

hdfs://namenode:8020)。 - 确保客户端与NameNode的RPC端口(默认8020)互通。

FAQs

Q1:如何检查HDFS中某个文件是否存在?

A:使用FileSystem.exists(Path)方法,

boolean exists = fs.exists(new Path("/user/data/file.txt"));Q2:如何通过编程方式上传大文件到HDFS?

A:分两步处理:

- 本地分割大文件为多个Block(如128MB/块)。

- 逐块写入HDFS,示例(Java):

try (FSDataOutputStream out = fs.create(filePath, true)) { // 开启追加模式 byte[] buffer = new byte[1024 1024]; // 1MB缓冲区 int bytesRead; while ((bytesRead = inputStream.read(buffer)) > 0) { out.write(buffer, 0, bytesRead); } }