hdfs设置某目录存储

- 行业动态

- 2025-05-09

- 2

在HDFS中设置某目录存储需执行:1.使用

hadoop fs -mkdir /path创建目录;2.通过 hadoop fs -setrep设置副本数;3.在 hdfs-site.xml配置 dfs.replication调整全局默认值,或通过命令单独指定

HDFS设置某目录存储的详细说明

HDFS存储目录基础概念

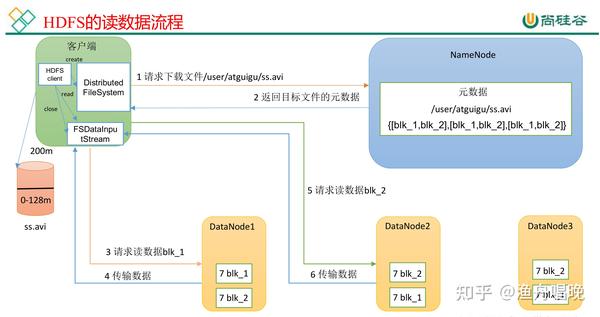

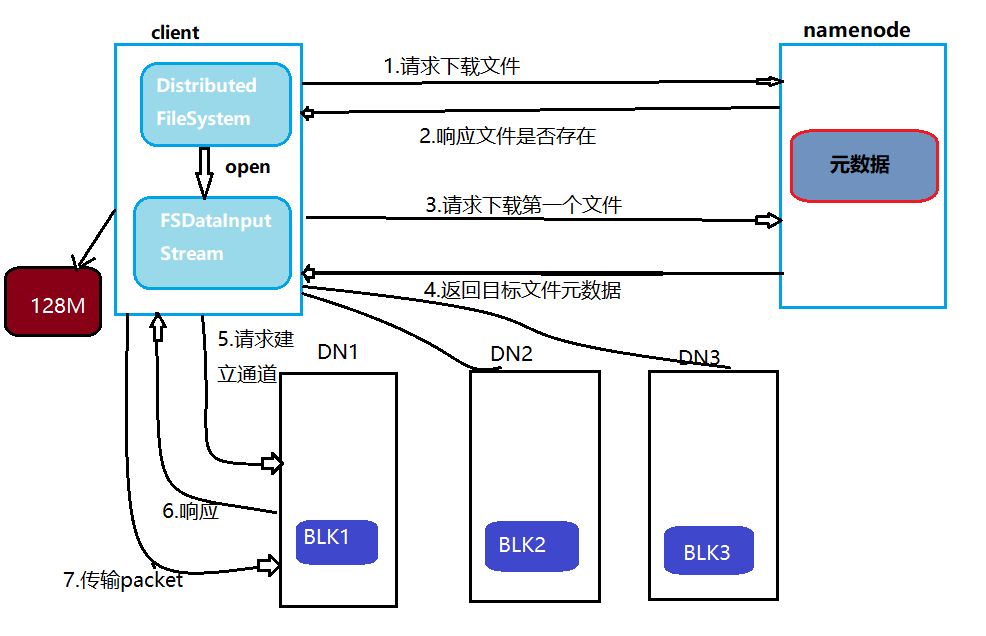

HDFS(Hadoop Distributed File System)采用主从架构,包含NameNode(元数据管理)和DataNode(实际数据存储),在HDFS中,目录本质上是文件系统中的层级结构,用于组织数据存储路径,用户可以通过配置和命令行工具指定特定目录的存储策略,例如数据块存放位置、副本数量等。

设置某目录存储的核心步骤

以下为将数据定向存储到HDFS指定目录的完整流程:

| 步骤 | 命令/配置示例 | 作用 | |

|---|---|---|---|

| 1 | 创建目标目录 | hdfs dfs -mkdir /user/data_dir | 定义数据存储路径 |

| 2 | 配置存储策略 | hdfs dfs -setrep -w 3 /user/data_dir | 设置副本数为3 |

| 3 | 调整块大小 | 修改dfs.blocksize参数 | 控制单个文件分块大小 |

| 4 | 数据写入验证 | hdfs dfs -put localfile.txt /user/data_dir | 测试存储效果 |

关键配置参数详解

HDFS提供多种参数控制目录存储行为,常用配置如下:

| 参数名称 | 默认值 | 作用描述 |

|---|---|---|

| dfs.replication | 3 | 全局副本系数,影响所有目录 |

| dfs.blocksize | 128MB | 单个数据块大小,影响文件拆分粒度 |

| dfs.namenode.replication.limit | 3 | NameNode最大允许副本数 |

| dfs.datanode.failed.writes.tolerated | 3 | DataNode失败写入尝试次数 |

局部覆盖配置方法:

通过hdfs dfs -setrep命令可单独设置某目录的副本数,

hdfs dfs -setrep -w 2 /user/data_dir # 将该目录副本数设为2

存储策略高级配置

存储类型策略

通过hdfs-site.xml启用异构存储:

<property> <name>dfs.storage.policy.satisfyer.classname</name> <value>org.apache.hadoop.hdfs.protocolPB.StoragePolicySatisfier</value> </property>

结合

hdfs storagepolicies命令创建策略,hdfs storagepolicies -createOne /user/data_dir ARCHIVE # 使用冷存策略

跨集群存储配置

需在core-site.xml中启用跨集群传输:<property> <name>dfs.cross.cluster.enabled</name> <value>true</value> </property>

存储目录验证方法

元数据检查

hdfs fsck /user/data_dir -files -blocks -locations

输出示例:

/user/data_dir/file1.txt 1 block(s): OK 0. BP-123456789-1234-5678-9012-ABCDEF G1 datanode1:50010存储容量监控

使用Web UI查看DataNode存储分布,或执行:hdfs dfsadmin -report

性能测试

通过TestDFSIO工具测试读写速度:hadoop jar /hadoop/share/hadoop/tools/lib/hadoop-test-4.x.jar TestDFSIO -write -nrFiles 100 -fileSize 1GB /user/data_dir/testio

常见问题与解决方案

| 问题现象 | 原因分析 | 解决方案 |

|---|---|---|

| 数据写入后副本数不符合预期 | 未正确应用局部配置 | 使用-setrep -w强制刷新配置,检查DataNode网络连通性 |

| 目录创建后权限不足 | 默认继承父目录权限 | 执行hdfs dfs -chmod 775 /user/data_dir调整权限 |

| 跨集群传输失败 | 目标集群未开放权限 | 在目标集群hdfs-site.xml添加dfs.permissions.enabled=false临时禁用权限 |

最佳实践建议

分层存储设计

热数据(频繁访问)与冷数据(长期存档)应分开存储,hdfs dfs -mkdir /hot_data # SSD存储 hdfs dfs -mkdir /cold_data # HDD存储

动态资源分配

配置dfs.datanode.failed.volumes.tolerated参数,允许DataNode在部分磁盘故障时继续服务。元数据优化

调整dfs.namenode.fs-limit和dfs.namenode.file-max参数,防止元数据溢出:<property> <name>dfs.namenode.fs-limit</name> <value>10000000</value> <!-支持千万级文件 --> </property>

FAQs

Q1: 如何将现有目录迁移到新的存储路径?

A1: 需执行以下步骤:

- 在新目标路径创建目录:

hdfs dfs -mkdir /new_path - 使用

-moveFromLocal参数迁移数据:hdfs dfs -mv /old_path/ /new_path - 更新上游作业配置中的存储路径

- 验证数据完整性:

hdfs fsck /new_path -files -blocks -locations

Q2: 设置目录存储策略后未生效怎么办?

A2: 排查顺序:

- 确认配置已持久化:检查

hdfs-site.xml或使用hdfs dfs -getrep查看当前策略 - 重启NameNode使配置生效:

stop-dfs.sh && start-dfs.sh - 检查DataNode日志是否存在存储拒绝记录(如磁盘满、权限不足)

- 验证客户端