上一篇

hadoop的数据仓库工具包括

- 行业动态

- 2025-05-12

- 1

Hadoop的数据仓库工具主要包括Hive(SQL查询)、HBase(分布式存储)、Impala(实时分析)等,支持大数据

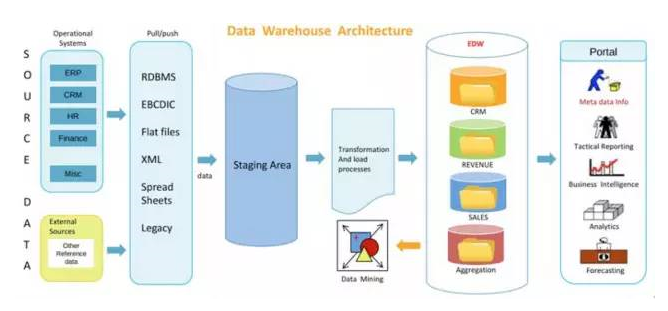

Hadoop生态系统中的数据仓库工具主要围绕分布式存储(HDFS)、计算框架(MapReduce/Spark)以及上层数据处理引擎展开,以下是常见的Hadoop数据仓库工具及其核心功能、特点与应用场景的详细分析:

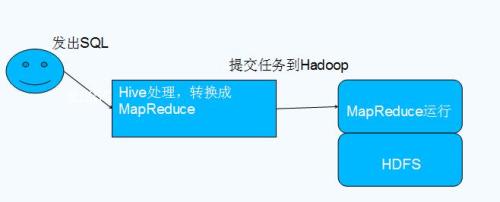

Apache Hive

功能定位

- SQL接口引擎:将SQL语句转换为MapReduce任务,支持类SQL语法(HiveQL)。

- 元数据管理:通过Metastore存储表结构、分区信息,兼容关系型数据库的Schema设计。

- 分区与桶:支持按时间、地域等字段分区,提升查询效率;桶(Bucket)机制实现数据均匀分布。

核心特点

- 批处理优化:适合大规模离线数据分析,单次查询可扫描TB级数据。

- ACID支持:通过事务管理保证数据一致性(需开启事务表)。

- 扩展性:支持自定义UDF(用户函数)和SerDe(序列化/反序列化库)。

适用场景

- 日志分析、用户行为分析等离线数仓场景。

- 需要与传统BI工具(如Tableau)集成的场景。

Apache Impala

功能定位

- 实时Mpp查询引擎:基于分布式架构,直接访问HDFS或HBase数据,无需依赖MapReduce。

- 与Hive兼容:复用Hive Metastore,支持HiveQL语法,可查询Hive表。

核心特点

- 低延迟:秒级响应复杂查询,适合交互式分析。

- 分布式执行:采用MPP(Massively Parallel Processing)架构,并行处理数据。

- 动态分区裁剪:根据查询条件跳过无关分区,减少IO开销。

适用场景

- 实时报表、即席查询等对响应时间要求高的场景。

- 与Hive混合使用(Hive处理批任务,Impala处理实时查询)。

Apache Presto

功能定位

- 分布式SQL查询引擎:支持跨数据源(HDFS、S3、关系型数据库等)的联邦查询。

- 无守护进程:不依赖Metastore,通过JDBC/ODBC连接多种数据源。

核心特点

- 多源数据整合:可同时查询Hive、MySQL、Kafka等不同数据源。

- 轻量级:无存储层,仅负责计算,资源消耗低。

- 标准SQL支持:兼容ANSI SQL,生态工具链丰富。

适用场景

- 多源数据联合分析(如Hadoop数据与关系库数据关联查询)。

- 临时性查询需求,避免长期维护成本。

Apache HBase

功能定位

- 分布式NoSQL数据库:基于HDFS,提供随机读写能力,支持高并发。

- 列式存储:按列族存储数据,适合稀疏数据集。

核心特点

- 实时读写:毫秒级延迟,适合实时数据更新(如物联网设备数据)。

- 版本控制:支持同一行数据的多版本存储。

- Schema灵活:无需预先定义严格Schema,适应快速变化的业务需求。

适用场景

- 实时数据仓库(如监控告警、用户实时画像)。

- 需要高吞吐量写入的场景(如日志流式处理)。

Sqoop

功能定位

- 数据导入导出工具:实现关系型数据库与Hadoop(HDFS/Hive/HBase)之间的数据传输。

- 增量导入:支持基于时间戳或主键的增量同步。

核心特点

- 并行处理:利用MapReduce加速数据迁移。

- 兼容性强:支持MySQL、Oracle、SQL Server等多种数据库。

适用场景

- 传统数仓数据迁移至Hadoop。

- 周期性同步业务库数据到Hive/HBase。

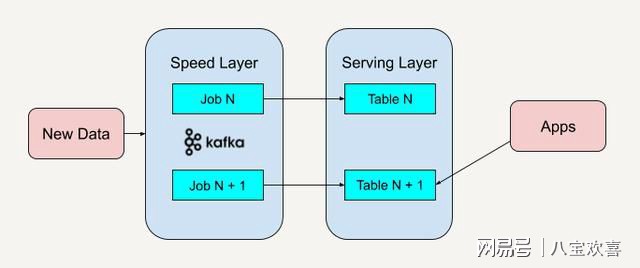

Flume

功能定位

- 日志采集工具:实时收集、聚合和传输海量日志数据到HDFS或HBase。

- 自定义Source/Sink:支持扩展多种数据源(如Kafka、syslog)和目标存储。

核心特点

- 高可用性:通过Channel保障数据缓冲与可靠性。

- 流式处理:适合实时数据采集(如网站访问日志)。

适用场景

- 实时日志流处理与存储。

- 配合Kafka构建实时数据管道。

工具对比表格

| 工具 | 核心功能 | 延迟 | 数据源支持 | 适用场景 |

|---|---|---|---|---|

| Hive | SQL批处理 | 高(分钟级) | HDFS、HBase | 离线分析、BI集成 |

| Impala | 实时MPP查询 | 低(秒级) | HDFS、Hive、HBase | 交互式分析、实时报表 |

| Presto | 跨源联邦查询 | 中等(秒级) | HDFS、S3、RDBMS | 多源数据联合分析 |

| HBase | 实时NoSQL存储 | 低(毫秒级) | HDFS、Kafka | 实时数据更新、高并发写入 |

| Sqoop | 批量导入导出 | RDBMS、HDFS、Hive | 传统数仓迁移、周期性同步 | |

| Flume | 日志流式采集 | Log、Kafka、HDFS | 实时日志处理、数据管道构建 |

FAQs

问题1:Hive和Impala如何选择?

- Hive:适合离线批处理任务,如ETL、复杂SQL分析,资源消耗较低但延迟高。

- Impala:适合实时交互式查询,如业务人员即席分析,需较高集群资源但延迟低。

- 建议:两者结合使用,Hive处理历史数据批量任务,Impala支持实时查询需求。

问题2:Presto能否替代Hive?

- 不能完全替代:Presto优势在于多源数据联邦查询和轻量级架构,但缺乏Hive的元数据管理和事务支持。

- 适用场景:短期项目或需要快速整合多数据源时优先选Presto;长期数仓建设仍需H