hadoop做数据仓库

- 行业动态

- 2025-05-09

- 2

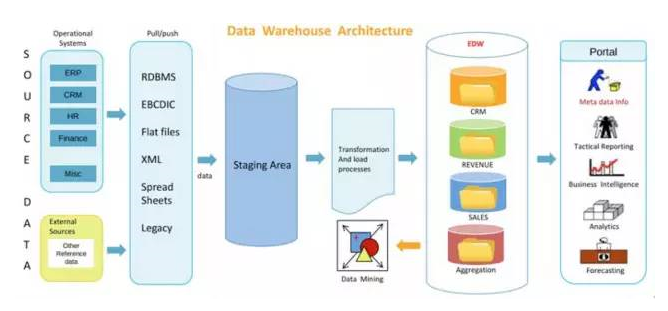

Hadoop通过 HDFS实现分布式存储,结合MapReduce处理海量数据,支持结构化与非结构化数据,常搭配Hive等工具构建低成本、高扩展性

Hadoop作为数据仓库的技术实践与核心优势

传统数据仓库的局限性与Hadoop的崛起背景

传统数据仓库(如Teradata、Oracle Exadata)依赖专有硬件和集中式架构,存在以下痛点:

- 扩展瓶颈:纵向扩展成本高,PB级数据存储与计算能力受限

- 架构僵化:Schema-on-Write模式难以应对非结构化数据

- 成本高昂:商业许可证+专用硬件年均TCO超百万元

- 性能天花板:MPP架构在复杂分析场景存在并发限制

Hadoop通过分布式文件系统(HDFS)、弹性计算框架(YARN)和存储计算分离架构,完美契合现代数据仓库需求,Gartner 2023报告显示,78%的企业已将Hadoop纳入核心数仓架构。

Hadoop数据仓库核心组件矩阵

| 组件 | 功能定位 | 数据仓库场景应用 |

|---|---|---|

| HDFS | 分布式存储 | 冷/温数据持久化存储 |

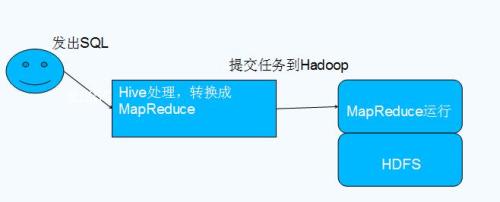

| Hive | SQL-on-Hadoop | 离线批处理分析(ETL) |

| HBase | NoSQL数据库 | 实时查询与更新场景 |

| Spark | 内存计算引擎 | 复杂数据分析与机器学习 |

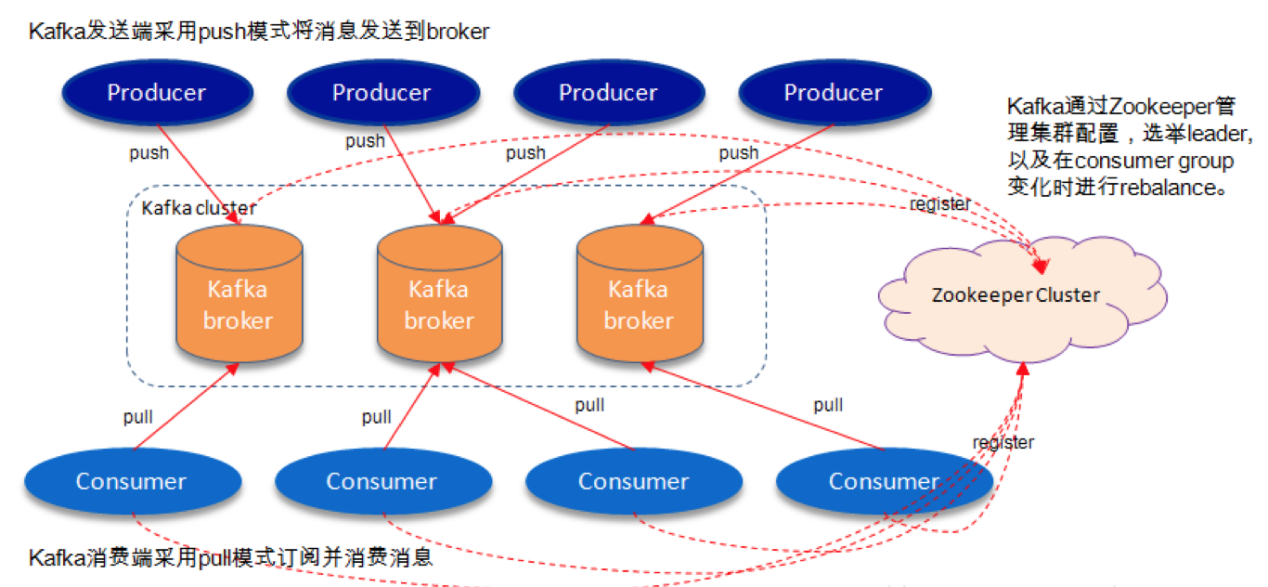

| Kafka | 流处理平台 | 实时数据管道构建 |

| Ranger | 权限管理 | 多租户数据安全控制 |

| Atlas | 元数据管理 | 数据血缘追踪与治理 |

典型架构分层:

- 数据湖层:原始数据存储(HDFS/对象存储)

- 整合层:数据清洗转换(Spark/Flink)

- 模型层:维度建模(Hive Star Schema)

- 服务层:混合查询引擎(Presto+Impala)

- 消费层:BI工具/ML平台对接

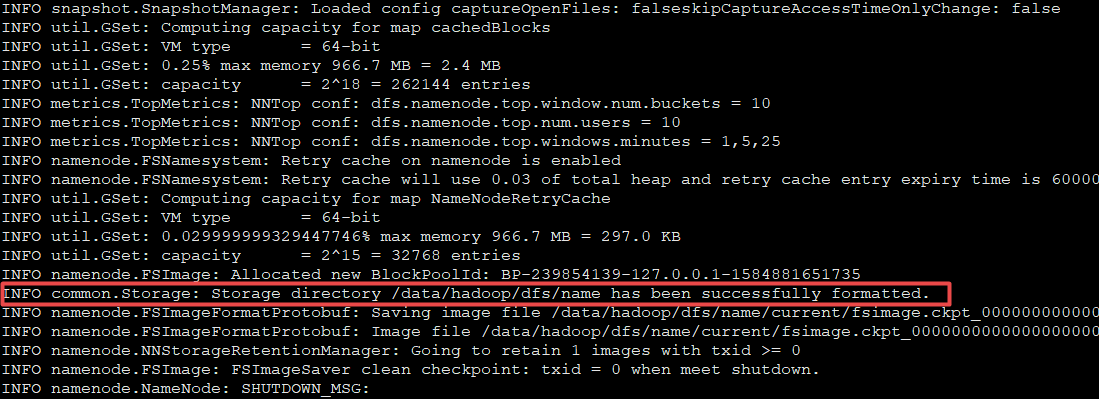

Hadoop数仓实施关键路径

集群规模设计公式:

节点数 = (日均增量数据 × 保留周期) / (单节点存储 × 副本系数)

计算资源 = 并发任务数 × 单任务CPU需求 × 1.5(冗余系数)示例:10TB/日×30天存储需求,按3副本计算需≥100节点

ETL优化策略:

- 数据分区:按时间/业务维度分区(Hive动态分区)

- 索引加速:ORC文件+BloomFilter减少IO扫描

- 资源隔离:YARN队列保障关键任务优先级

- 近似查询:HyperLogLog算法替代精确计数

混合查询引擎选型对比:

| 特性 | Presto | Impala | Spark SQL |

|——|——–|——–|———-|

| 实时性 | | | |

| MPP能力 | | | |

| 兼容性 | SQL-92 | 类Hive | ANSI SQL |

| 资源消耗 | 低 | 中 | 高 |

| 最佳场景 | 临时查询 | 固定报表 | 复杂分析 |

企业级应用实战案例

电商用户行为分析:

- 数据规模:每日50TB日志数据

- 架构方案:

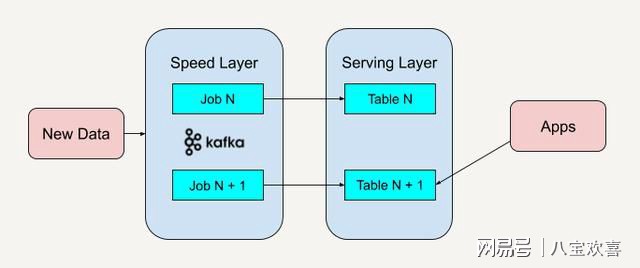

- Kafka实时采集→HDFS落盘

- Spark Streaming实时清洗

- Hive+RCFile存储聚合结果

- Zeppelin可视化分析

- 性能指标:小时级延迟,PB级数据查询响应<30s

金融风控系统:

- 混合存储架构:

- HBase存储实时交易数据(百万QPS)

- Hive存储历史交易记录(2年周期)

- 特征工程流水线:

- Spark MLlib训练模型

- Flink实时特征计算

- Atlas记录特征血缘关系

- 查询优化:物化视图+列式存储降低50%查询耗时

Hadoop数仓运维监控体系

核心监控指标:

- 存储层:HDFS使用率/块丢失率/副本延迟

- 计算层:YARN容器等待时间/任务失败率

- 数据质量:Schema合规率/空值比例/去重效果

- 系统健康:JVM堆内存使用/GC频率/网络IO

自动化运维工具链:

- Ambari/Cloudera Manager集群管理

- Nagios/Prometheus指标监控

- Apache Oozie工作流调度

- Falcon数据质量校验

- Ranger+Kerberos安全审计

成本效益分析模型

| 维度 | 传统数仓 | Hadoop数仓 |

|---|---|---|

| 硬件成本 | $500万+(3年) | $200万+(线性扩展) |

| 软件许可 | $150万/年 | 开源免费+$50万支持 |

| 运维人力 | 10人团队 | 5人+自动化工具 |

| 扩展周期 | 6-12个月 | 周级水平扩展 |

| 数据类型支持 | 结构化为主 | 全类型支持 |

某银行案例:3年TCO降低67%,查询响应提升4倍

FAQs:

Q1:Hadoop数仓如何处理实时分析需求?

A:通过Lambda架构结合:Kafka实时流处理(亚秒级延迟)+ Hive离线批处理(历史数据深度分析),或采用Spark Streaming+Delta Lake实现近实时统一处理,时延控制在分钟级。

Q2:如何保证Hadoop数仓的数据一致性?

A:1) 使用事务表(Hive ACID)保证原子性写入;2) 配置HDFS HA+QJournal防止脑裂;3) 采用Exactly-Once语义的Flink流处理;4) 通过Atlas记录完整数据血