上一篇

hadoop下的数据仓库

- 行业动态

- 2025-05-13

- 1

Hadoop数据仓库依托HDFS分布式存储,支持SQL查询,通过MapReduce高效处理海量数据

Hadoop下的数据仓库:架构、工具与实践

传统数据仓库的局限性与Hadoop的优势

传统数据仓库(如Teradata、Oracle Exadata)依赖专有硬件和垂直扩展架构,存在成本高、扩展性差、处理非结构化数据能力弱等问题,Hadoop作为分布式计算框架,通过廉价集群实现横向扩展,其HDFS(分布式文件系统)支持海量数据存储,MapReduce模型擅长批处理,为数据仓库提供了新的思路。

Hadoop数据仓库的核心优势:

- 弹性扩展:通过增加节点提升存储与计算能力。

- 低成本:利用普通PC服务器构建集群。

- 多源数据支持:结构化、半结构化(JSON、XML)、非结构化(日志、图像)均可处理。

- 高容错:数据副本机制保障可靠性。

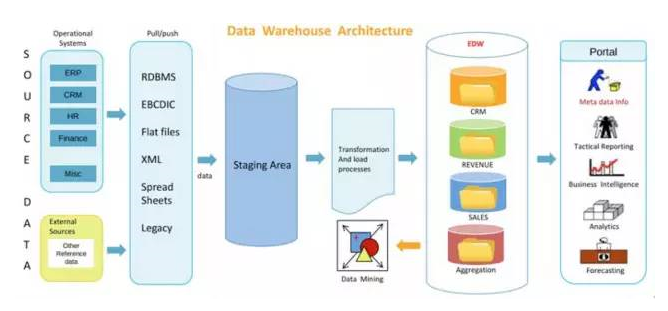

Hadoop数据仓库架构设计

Hadoop数据仓库的典型架构包含以下层级:

| 层级 | 功能 | 技术选型示例 |

|---|---|---|

| 数据源层 | 采集多类型原始数据(数据库、日志、API、文件等) | Flume、Sqoop、Kafka |

| 存储层 | 分布式存储原始数据与加工后数据 | HDFS、HBase、ICEBERG |

| 计算层 | 执行ETL、数据分析、机器学习任务 | MapReduce、Spark、Flink |

| 元数据层 | 管理数据目录、血缘关系、权限控制 | Hive Metastore、Apache Atlas |

| 服务层 | 提供SQL查询、BI工具对接、API服务 | Hive、Impala、Presto、Superset |

关键组件说明:

- HDFS:存储大规模数据集,适合高吞吐量场景。

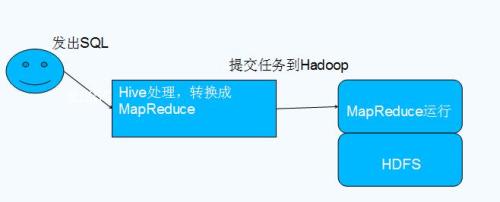

- Hive:基于Hadoop的SQL-on-Hadoop工具,适合离线分析。

- Spark:内存计算框架,提升迭代式算法效率。

- Airflow:调度ETL任务的工作流管理工具。

Hadoop数据仓库工具链对比

| 工具 | 定位 | 优势 | 适用场景 |

|---|---|---|---|

| Hive | 离线批处理SQL引擎 | 兼容性强,支持复杂查询,社区成熟 | 大规模历史数据分析 |

| Impala | 实时交互式查询引擎 | 低延迟,直接操作HDFS数据 | 即席查询、报表生成 |

| Spark SQL | 混合计算引擎 | 支持批流一体,优化执行计划 | 机器学习、实时+批处理混合任务 |

| Presto | 分布式SQL查询引擎 | 轻量级,跨数据源联邦查询 | 多源数据联合分析 |

| HBase | 实时NoSQL数据库 | 低延迟随机读写,支持亿级行表 | 实时日志分析、用户画像 |

工具组合策略:

- 离线分析:Sqoop导入数据 → Hive/Spark处理 → 结果存回HDFS。

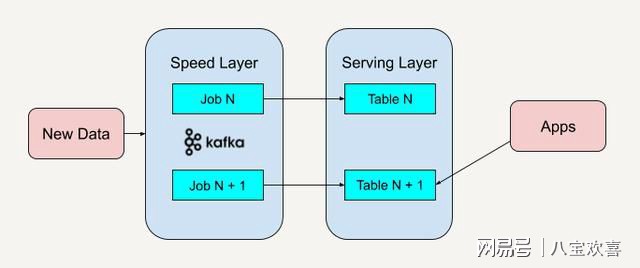

- 实时分析:Kafka流式采集 → Flink/Spark Streaming处理 → HBase存储。

- 混合场景:Impala快速查询近期数据,Hive处理历史数据。

Hadoop数据仓库的ETL实践

ETL(Extract-Transform-Load)是数据仓库的核心流程,Hadoop生态提供多种实现方式:

数据采集(Extract):

- Sqoop:从MySQL、Oracle等关系数据库导入数据到HDFS。

- Flume:实时采集日志文件,支持Tail监控。

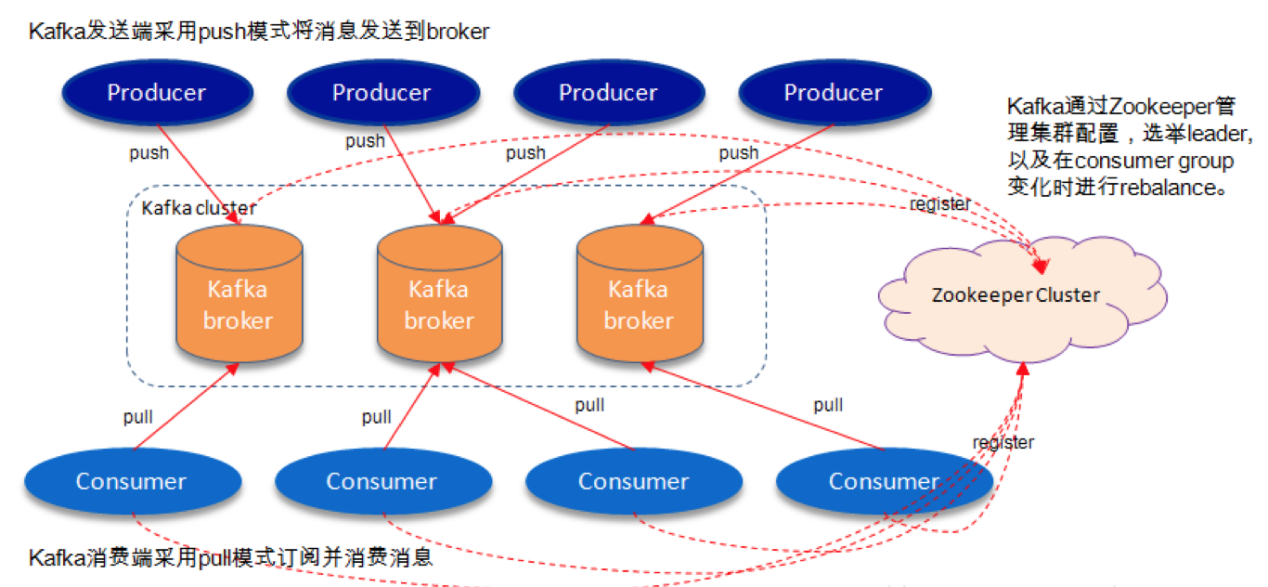

- Kafka:构建实时数据管道,缓冲流式数据。

数据清洗与转换(Transform):

- Hive/Spark SQL:编写UDF(用户自定义函数)处理脏数据。

- Apache NiFi:可视化设计ETL流程,支持数据路由与异常处理。

- Debezium:捕获数据库变更(CDC),实现增量同步。

数据加载(Load):

- 分区表优化:按时间、地域等字段分区,减少全表扫描。

- 文件格式选择:Parquet(列式存储,压缩率高)、ORC(优化Hive查询)。

- 索引加速:Hudi、Delta Lake支持Upsert操作与索引加速查询。

数据治理与性能优化

元数据管理:

- 使用Apache Atlas记录数据血缘关系。

- 通过RBAC(基于角色的访问控制)管理权限。

- 定期清理小文件(使用CombineFileInputFormat合并)。

性能调优:

- 存储优化:开启HDFS的3副本冗余,调整BlockSize(默认128MB)。

- 计算优化:倾斜数据预分区,调整Yarn资源池(CPU/Memory)。

- 查询优化:广播小表join,使用Tez替代MapReduce。

成本控制:

- 冷热数据分离:热数据存SSD(HBase)、冷数据存HDD。

- 动态资源分配:根据任务负载调整Yarn容器数量。

实际案例:电商用户行为分析仓库

某电商平台基于Hadoop构建数据仓库,实现以下功能:

- 数据源:用户点击日志(Flume采集)、订单库(Sqoop导入)、商品画像(Kafka流)。

- 存储层:HDFS存储原始日志,Hive表按天分区,HBase存储实时用户标签。

- 计算任务:

- Spark批量计算用户购买转化率(每日23:00执行)。

- Flink实时统计页面UV/PV,结果写入Redis供BI调用。

- 服务层:Superset连接Hive/Impala,生成GMV趋势、用户留存率等报表。

挑战与应对

| 挑战 | 解决方案 |

|---|---|

| 查询延迟高 | 引入Impala或Presto加速交互式查询,使用Redis缓存高频结果。 |

| 数据一致性保障 | 采用Kafka+Exactly Once语义保证流式处理一致性,Hive事务表支持ACID。 |

| 多租户资源隔离 | 配置Yarn队列限制不同部门资源使用,使用Kubernetes部署独立集群。 |

| Schema演化困难 | 使用Pandorafs等数据湖格式支持Schema-less存储,Iceberg/Hudi支持时间旅行。 |

FAQs

Q1:Hadoop数据仓库如何优化小文件过多导致的性能问题?

A1:

- 合并小文件:使用Hadoop CombineFileInputFormat或Spark的repartition合并小文件。

- 合理分区:按时间、业务类型等字段预分区,避免单分区数据量过大或过小。

- 压缩存储:采用Snappy、LZO等轻量压缩算法减少文件体积。

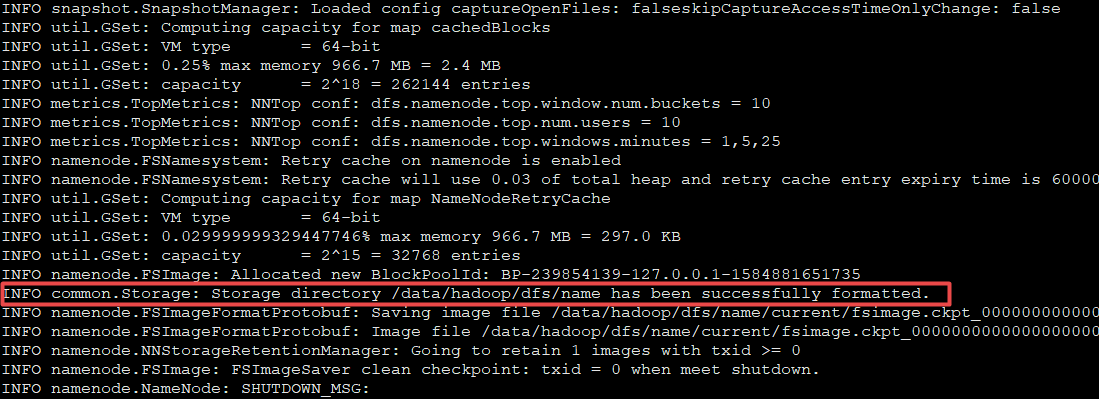

- 调整HDFS参数:增大

dfs.blocksize(如从128MB调至256MB)以减少块数量。

Q2:如何保证Hadoop数据仓库中流批一体的数据一致性?

A2:

- 时间戳对齐:流式任务(如Flink)与批量任务(如Hive)均以事件时间为准,窗口对齐。

- Kafka偏移量管理:流处理完成后提交偏移量,批处理从Kafka消费时从已提交偏移开始。

- 事务表支持:使用Hive ACID事务表或Iceberg事务,确保Upsert操作原子性。

- 数据校验:通过Checksum或哈希值比对