上一篇

hadoop集群建数据仓库

- 行业动态

- 2025-05-08

- 4

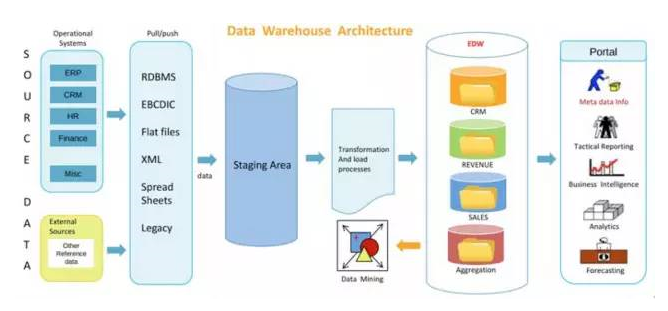

基于Hadoop集群构建数据仓库,利用HDFS实现海量数据分布式存储,通过MapReduce进行并行计算,结合Hive完成数据仓库建模与SQL分析,支持ETL工具集成,实现低成本、高可

Hadoop集群构建数据仓库的全流程解析

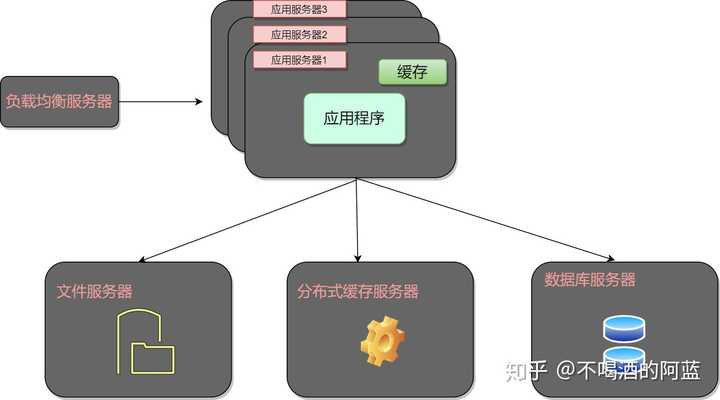

需求分析与架构设计

在构建基于Hadoop的数据仓库前,需明确业务目标和技术边界,与传统数据仓库不同,Hadoop生态支持PB级数据处理,适合非结构化/半结构化数据场景,以下是核心设计要素:

| 维度 | 传统数仓 | Hadoop数仓 |

|---|---|---|

| 数据类型 | 结构化为主 | 结构化/非结构化混合 |

| 扩展方式 | 纵向扩展 | 横向扩展(Scale-out) |

| 计算模式 | MPP并行计算 | MapReduce/Spark分布式计算 |

| 存储成本 | 高(专有硬件) | 低(廉价PC服务器) |

| 实时性 | 强(物化视图) | 弱(批处理为主) |

典型架构分层:

- 数据源层:业务数据库(MySQL/Oracle)、日志系统、文件系统

- ODS层:操作数据存储,保留原始数据特征

- DWD层:明细数据层,完成数据清洗/标准化

- DWS层:汇总数据层,构建轻度聚合主题

- ADS层:应用数据层,面向业务报表的数据集市

集群环境搭建

硬件选型

- 节点配置:建议采用同质化配置,典型配置为:

CPU: Intel Xeon Gold 6348 (16核/32线程) 内存: 128GB DDR4 ECC 存储: RAID10阵列(4×960GB SAS HDD)+ 2TB NVMe缓存 网络: 千兆/万兆以太网(建议双网卡冗余)

- 规模估算:

| 数据规模 | NameNode | DataNode | YARN Node |

|———|———-|———-|———–|

| <10TB | 1 | 3 | 3 |

| 10-100TB| 3 | 10 | 10 |

| >100TB | 5 | 30+ | 30+ |

软件栈部署

# 基础环境配置 yum install java-1.8.0-openjdk -y yum install hadoop-3.2.2.tar.gz -y # 包含HDFS/YARN/MapReduce # 分布式协调服务 tar -xzf zookeeper-3.6.2.tar.gz ./zkServer.sh start # 启动ZooKeeper集群 # 元数据管理 tar -xzf hive-3.1.2.tar.gz export HIVE_HOME=/opt/hive-3.1.2

核心组件配置

HDFS优化配置

<!-hdfs-site.xml --> <property> <name>dfs.replication</name> <value>3</value> # 副本数根据机房可靠性调整 </property> <property> <name>dfs.blocksize</name> <value>134217728</value> # 128MB块大小 </property>

YARN资源调度

<!-yarn-site.xml --> <property> <name>yarn.nodemanager.resource.memory-mb</name> <value>81920</value> # 80GB内存分配 </property> <property> <name>yarn.scheduler.maximum-allocation-mb</name> <value>65536</value> # 单容器最大64GB </property>

Hive数仓特性

-创建分区表示例

CREATE TABLE user_log_dwd (

uid BIGINT,

event_time TIMESTAMP,

event_type STRING,

...

)

PARTITIONED BY (dt STRING)

STORED AS ORC

TBLPROPERTIES ('orc.compress'='SNAPPY');数据流水线构建

数据采集层

| 工具 | 适用场景 | 配置示例 |

|---|---|---|

| Flume | 日志流采集 | a1.source = netcat |

| Sqoop | RDB数据导入 | –split-by id –direct |

| Kafka | 实时消息队列 | auto.offset.reset=latest |

数据清洗流程

# PySpark清洗示例

df = spark.read.format("json").load("hdfs:///raw_data/")

clean_df = df.filter(df.event_type.isNotNull())

.withColumn("ts", unix_timestamp("event_time"))

.dropDuplicates()

clean_df.write.mode("overwrite").parquet("hdfs:///dwd/")数据建模规范

- 高基数维度处理:

-创建字典表 CREATE TABLE dim_user ( uid BIGINT, user_name STRING, ... ) STORED AS Kudu; -支持快速更新

- 时间维度设计:

-时间维度层次化 CREATE TABLE dim_time ( day_id BIGINT, week_id INT, month_id INT, quarter_id INT, year_id INT ) STORED AS MEMORY; -小尺寸维度表

性能优化策略

存储优化

| 优化项 | 方案 |

|---|---|

| 文件大小 | 通过CombineTextInputFormat合并小文件,设置mapreduce.job.split.metainfo.maxsize=100MB |

| 列式存储 | ORC格式比Parquet减少20%存储空间,开启Snappy压缩 |

| 索引加速 | 创建BloomFilter索引减少HDFS扫描量 |

计算优化

- 谓词下推:

-Hive开启谓词下推 SET hive.optimize.cp=true; SELECT FROM dwd_table WHERE dt='2023-08-01';

- 数据倾斜处理:

// Spark处理倾斜逻辑 val df = spark.read.parquet("hdfs:///dwd/") .repartition(col("user_id")) // 按倾斜键预分区 .groupBy("user_id") .agg(sum("amount")) .withColumn("rand", rand()) // 添加随机数打破数据倾斜

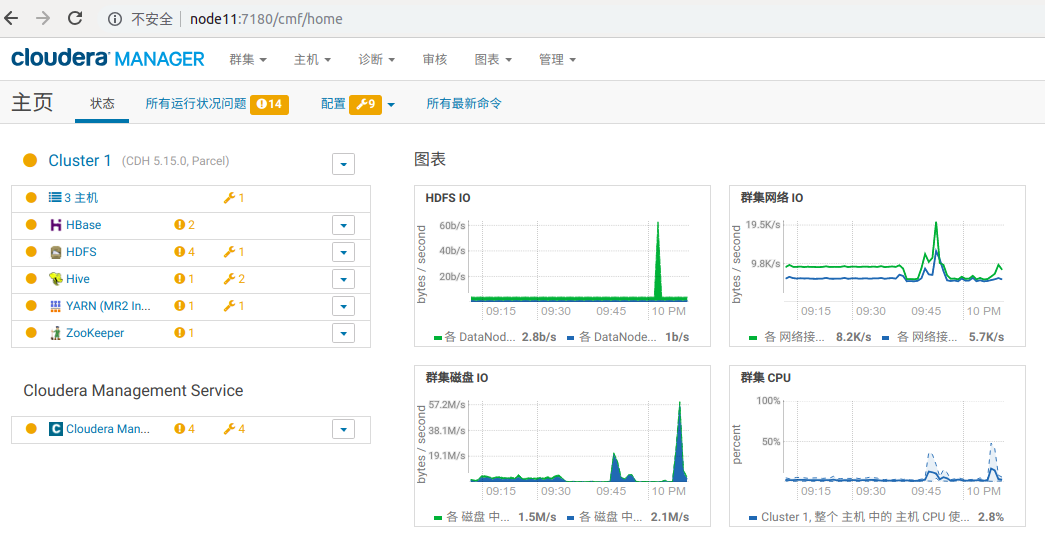

运维监控体系

监控指标矩阵

| 监控层级 | 关键指标 | 阈值示例 |

|---|---|---|

| HDFS | NameNode内存使用率 | <80% |

| YARN | AppMaster运行时间 | <120s |

| Hive | 查询响应时间 | <30s(简单查询) |

| Spark | Executor失联率 | <5% |

自动化运维工具链

# 使用Apache Ambari进行集群管理 ambari-server setup # 安装Hadoop管理插件包:HDFS/YARN/Hive/Spark/ZooKeeper # 配置告警规则:磁盘使用率>90%触发邮件通知

典型应用场景

用户行为分析

-DWS层宽表设计 CREATE TABLE dws_user_behavior ( uid BIGINT, visit_date STRING, page_views INT, stay_time BIGINT, last_visit_date STRING, ... -聚合30+维度字段 ) STORED AS ORC;

实时数仓架构

graph TD

A[Kafka] --> B{Spark Streaming}

B --> C[HBase]

B --> D[Druid]

C --> E[Phoenix]

D --> F[Grafana]成本控制方案

| 优化方向 | 实施策略 |

|---|---|

| 存储成本 | 冷热数据分离,使用HDFS存档冷数据,Impala/HBase存储热数据 |

| 计算成本 | 动态资源分配,设置YARN队列限额,非高峰时段执行批量作业 |

| 网络成本 | 跨机房部署时启用HDFS异构复制,减少数据传输带宽消耗 |

FAQs

Q1:Hadoop数据仓库如何处理数据倾斜问题?

A1:可通过以下组合策略解决:

- 预处理阶段:使用Hive的

DISTRIBUTE BY提前打散数据分布 - 计算阶段:在Spark中启用

spark.sql.shuffle.partitions=2000增大分区数 - 算法优化:对热点key添加随机前缀,例如

UUID.randomUUID().toString().substring(0,5) - 特殊处理:对极值key单独处理,使用

pairRDD.sample(false, fraction)采样过滤

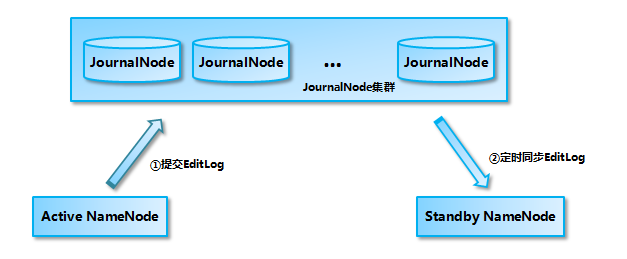

Q2:如何保障Hadoop数仓的数据一致性?

A2:建议采取多层保障机制:

- 事务管理:使用Hive ACID事务或Kudu存储引擎保证行级事务

- 数据校验:建立CRC校验机制,在Sqoop导入时启用

--check-column参数 - 版本控制:通过时间戳分区(

PARTITION(dt))实现数据版本管理 - 对账体系:构建数据血缘追踪系统,记录ETL任务的输入