上一篇

分布式文件存储系统的选择

- 行业动态

- 2025-05-04

- 3

根据需求场景、数据一致性、扩展性、

分布式文件存储系统的选择指南

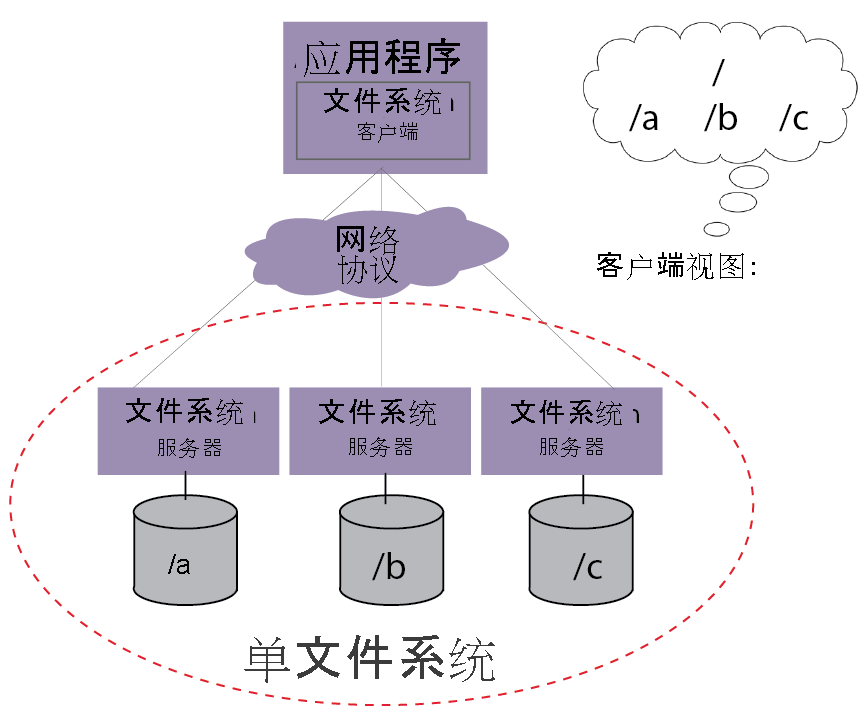

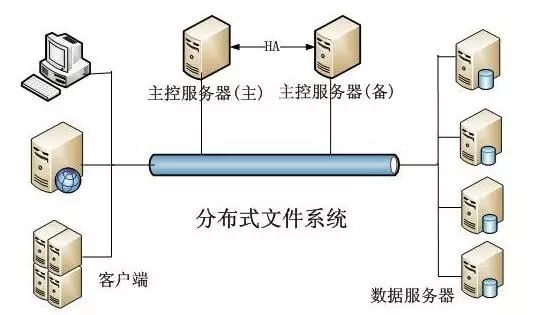

在数字化时代,企业面临的数据量呈指数级增长,传统集中式存储已难以满足高性能、高可用和低成本的需求,分布式文件存储系统凭借其横向扩展能力、容错性和灵活部署优势,成为海量数据存储的首选方案,市场上存在多种技术路线,如何选择适合自身业务需求的系统至关重要,以下从核心考量因素、主流技术对比、选型建议及实践案例四个维度展开分析。

核心考量因素

数据特性与访问模式

- 数据类型:结构化数据(如日志)、非结构化数据(图片、视频)、半结构化数据(JSON/XML)对存储系统的元数据管理和索引能力要求不同。

- 访问模式:高频读写(如电商平台)、大文件顺序读写(基因测序)、小文件随机访问(CDN缓存)需匹配不同的架构设计。

- 数据规模:EB级数据需关注扩展性,TB级可能更注重成本效益。

一致性与可用性权衡

- 强一致性(如Ceph):适用于金融交易、订单系统,需牺牲部分性能。

- 最终一致性(如MinIO):适合日志、音视频等容忍短暂延迟的场景。

- CAP定理:在分布式系统中,需根据业务优先级选择CP(一致性+分区容错)或AP(可用性+分区容错)。

兼容性与生态支持

- 协议兼容:是否支持POSIX、S3、HDFS等标准协议,直接影响与现有应用的集成成本。

- 工具链成熟度:如Prometheus监控、Kubernetes编排、Flink数据处理等生态支持。

成本与运维复杂度

- 硬件成本:商用系统(如NetApp) vs 开源软件(如Ceph)。

- 运维门槛:自动化部署(如Ansible)、Web管理界面、社区活跃度。

- 长期TCO:需综合硬件折旧、人力投入和扩容成本。

主流分布式文件存储系统对比

| 系统名称 | 架构特点 | 数据一致性 | 扩展性 | 兼容协议 | 典型场景 | 优点 | 缺点 |

|---|---|---|---|---|---|---|---|

| HDFS | Master-Slave架构 | 强一致性(写入时) | 横向扩展(千节点) | HDFS、POSIX | 大数据分析(Hadoop生态) | 高吞吐量、深度集成大数据工具链 | 低延迟场景性能差、依赖Java生态 |

| Ceph | 一体化存储(对象+块+文件) | 可配置(强/ | 无中心点(CRUSH算法) | CephFS、S3、iSCSI | 云存储、虚拟化、混合负载 | 统一存储、活跃社区、多协议支持 | 配置复杂、硬件兼容性问题频发 |

| GlusterFS | 纯用户态分布式文件系统 | 最终一致性 | 弹性扩展(动态扩容) | NFS、CIFS、HTTP | 传统企业NAS替代、媒体共享 | 零元数据服务器、低延迟 | 小文件性能差、社区维护停滞 |

| MinIO | 对象存储(S3兼容) | 最终一致性 | 无缝扩展(Kubernetes原生) | S3、GCS、Azure Blob | 云原生应用、备份归档 | 高性能、轻量化、容器化部署 | 仅支持对象存储、元数据功能有限 |

| FastDFS | 轻量级文件系统(分组架构) | 最终一致性 | 分组横向扩展 | HTTP/FTP | 图片/视频存储(社交平台) | 高并发小文件优化、低硬件要求 | 功能单一、缺乏POSIX支持 |

| MooseFS | Metadata Server集群 | 强一致性 | 线性扩展(百节点) | NFS、CIFS、HTTP | 日志收集、文档管理系统 | 元数据冗余、Active-Active模式 | 扩展上限较低、商业版许可成本高 |

| JuiceFS | Redis元数据+对象存储后端 | 可配置一致性 | 动态扩展(依赖底层) | POSIX、S3、HDFS | 混合云存储、AI训练数据湖 | 秒级扩容、跨云兼容、弹性按需付费 | 元数据依赖外部Redis、复杂权限管理 |

选型建议与实践策略

按业务场景匹配

- 互联网企业:优先MinIO(云原生)或Ceph(混合负载),支持容器化部署。

- 传统企业:HDFS(大数据)或GlusterFS(NAS替代),兼容现有Linux生态。

- 监控与日志:Elasticsearch+FastDFS组合,优化小文件吞吐。

- 混合云环境:JuiceFS+对象存储(如AWS S3),实现跨云灾备。

技术栈兼容性

- 若现有架构基于Hadoop,直接选用HDFS;若使用AWS,MinIO可无缝对接S3。

- Kubernetes环境推荐MinIO或Rook+Ceph,利用CNI插件简化存储网络配置。

成本优化策略

- 硬件复用:Ceph可同时提供块、对象和文件存储,减少单点故障。

- 冷热分层:结合对象存储(如MinIO)和本地SSD缓存,降低冷数据访问延迟。

- 开源替代:小规模集群(<50节点)可选用GlusterFS或MooseFS,避免商业授权费用。

实践案例参考

某电商平台图片库

- 需求:亿级小文件(商品图片)、高并发读写、低成本。

- 方案:FastDFS+Nginx反向代理,分组存储按商品类目划分,结合Redis缓存热点数据。

- 效果:单集群支持10万QPS,硬件成本降低40%。

基因测序数据湖

- 需求:PB级大文件(FASTQ序列)、低延迟读取、强一致性。

- 方案:Ceph文件存储+RBD块存储,配置CRUSH地图优化数据局部性。

- 效果:聚合带宽达10GB/s,数据完整性校验耗时减少70%。

跨国企业备份系统

- 需求:多区域容灾、去重压缩、跨云迁移。

- 方案:JuiceFS+阿里云OSS+AWS S3,元数据服务部署在VPC内网。

- 效果:备份RTO<5分钟,存储成本较传统SAN降低65%。

FAQs

Q1:如何判断业务是否需要分布式文件存储?

A1:若出现以下情况,需考虑分布式存储:

- 单台服务器存储容量接近极限(如100TB以上)。

- 业务峰值导致IO瓶颈(如并发读写超1万/秒)。

- 数据丢失风险高(如缺乏冗余备份)。

- 需要跨地域灾备或多活架构。

Q2:如何测试分布式存储系统的性能瓶颈?

A2:建议通过以下步骤:

- 基准测试:使用FIO、DD等工具模拟顺序/随机读写,记录IOPS和吞吐量。

- 扩展性测试:逐步增加节点,观察性能线性度和元数据服务瓶颈。

- 故障模拟:随机断网、宕机节点,验证数据恢复时间和一致性保障。

- 混合负载测试:结合真实业务场景(如70%读+30%写),评估延迟