分布式文件存储系统技术及实现

- 行业动态

- 2025-05-05

- 3

分布式文件存储系统通过数据分片、冗余备份和一致性哈希实现海量数据存储,典型如HDFS采用主从架构,支持横向扩展与高可用,适用于

分布式文件存储系统技术及实现

分布式文件存储系统

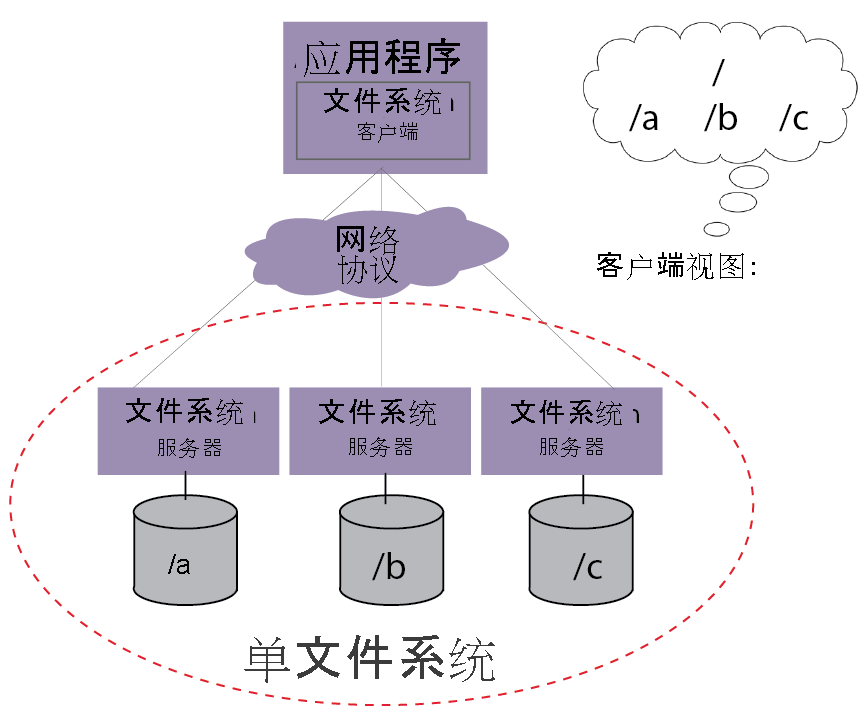

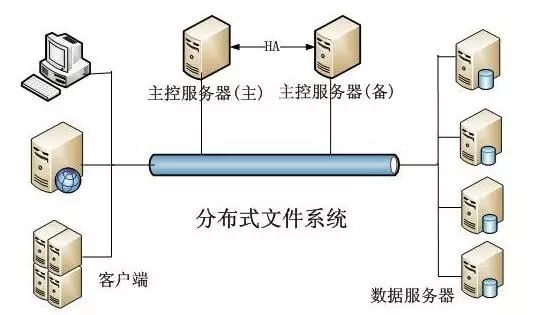

分布式文件存储系统是一种通过网络将多个物理存储节点整合为统一存储资源的技术架构,其核心目标是解决传统集中式存储的容量瓶颈、性能限制和单点故障问题,同时提供高可用性、高扩展性和低成本的数据存储服务,典型应用场景包括云计算基础设施、大数据分析、内容分发网络(CDN)、视频存储等。

核心特性:

- 数据分片与分布:将文件拆分为多个块并分散存储在不同节点

- 冗余备份:通过副本或纠删码实现数据容错

- 元数据管理:独立系统维护文件元信息(如路径、权限、块位置)

- 透明访问:客户端无需感知数据物理位置,通过统一接口访问

- 动态扩展:支持在线增减存储节点不影响服务

系统架构设计

现代分布式文件存储系统通常采用分层架构,主要包括:

| 层级 | 功能描述 |

|---|---|

| 客户端层 | 提供API接口(如POSIX兼容、RESTful API),处理文件切分与合并 |

| 元数据层 | 管理文件目录结构、块位置映射、权限控制(常用分布式数据库或专用元数据服务器) |

| 存储层 | 实际存储数据块,处理数据读写、复制、恢复 |

| 网络层 | 负责节点间通信,优化数据传输效率(如RDMA、TCP优化) |

典型架构对比:

| 系统 | 架构特点 | 适用场景 |

|---|---|---|

| HDFS (Hadoop) | 主从架构,单一NameNode管理元数据 | 大数据批处理 |

| Ceph | 无中心架构,CRUSH算法实现数据分布 | 云存储、高性能计算 |

| GlusterFS | 纯分布式架构,服务器端聚合 | 企业级NAS、虚拟化存储 |

| Swift (OpenStack) | 对象存储,对称架构 | 云原生应用、日志存储 |

核心技术实现

数据分片策略:

- 固定分块:按固定大小(如64MB/128MB)分割文件

- 动态分块:根据数据特征智能划分(如RAID式条带化)

- 哈希分片:使用一致性哈希实现负载均衡(如Ceph的CRUSH算法)

数据冗余机制:

| 类型 | 实现方式 | 容错能力 | 存储开销 |

|—————-|———————————-|———-|———-|

| 副本策略 | 3副本分布在不同机架/数据中心 | 高 | 3x |

| 纠删码 | Reed-Solomon编码(如8+4配置) | 中 | 1.5x |

| 混合模式 | 热数据用副本,冷数据用纠删码 | 最优 | 动态 |元数据管理优化:

- 水平扩展:采用分布式数据库(如ZooKeeper集群、etcd)

- 缓存加速:客户端本地缓存元数据(如HDFS的ClientCache)

- 分层存储:高频访问元数据存放在内存数据库(如Redis)

一致性保证:

- 强一致性:基于Quorum协议(如多数节点确认即生效)

- 最终一致性:采用版本向量(Vector Clocks)解决冲突

- 因果一致性:通过时间戳排序保证操作顺序

典型系统实现分析

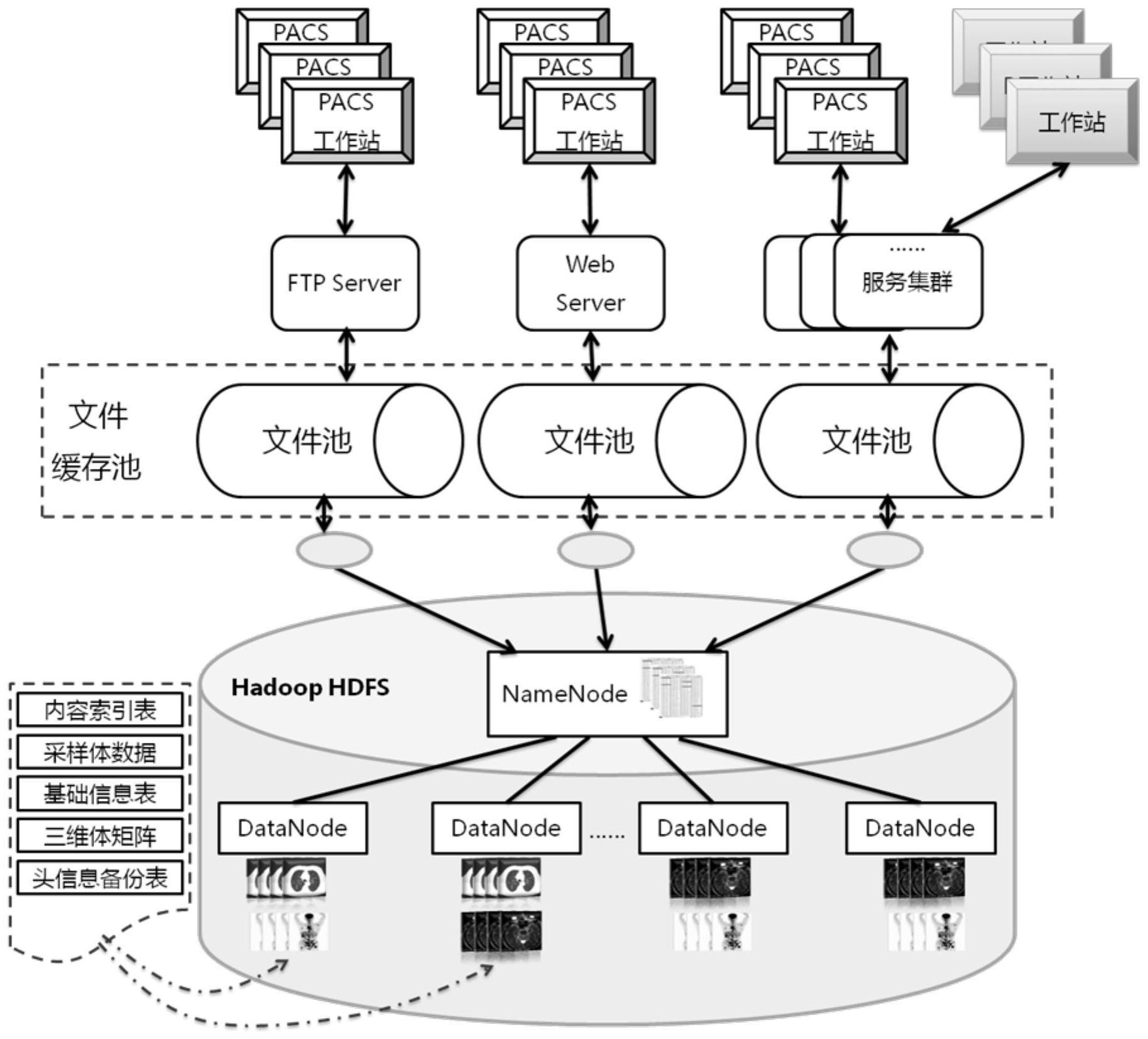

Hadoop Distributed File System (HDFS)

- 架构:Master-Slave模式,NameNode管理元数据,DataNode存储数据块

- 关键实现:

- 块默认128MB,支持流式写入

- 三副本策略,跨机架部署

- FsImage+EditLog元数据持久化

- 心跳机制监控DataNode状态

- 局限性:NameNode单点故障,不适合小文件存储

Ceph分布式存储

- 架构:无中心节点,Monitor维护集群状态,OSD存储数据

- 创新技术:

- CRUSH算法实现数据均匀分布

- RADOS网关提供对象/块/文件统一存储

- 蓝色存储(BlueStore)优化SSD写入

- 优势:自动负载均衡,支持异构硬件混布

GlusterFS

- 架构:纯分布式设计,无元数据服务器

- 核心机制:

- Brick卷组成分布式逻辑卷

- 弹性哈希(Elastic Hash)实现动态扩展

- 服务器端聚合(Server-side Merging)减少客户端请求

- 适用场景:中小规模集群,需要快速部署的场景

性能优化策略

数据局部性优化:

- 计算任务就近读取(如YARN调度器感知数据位置)

- 跨机房部署时优先读取同城副本

网络传输优化:

- 零拷贝技术(如Java NIO)

- 压缩传输(Snappy/LZ4算法)

- 并行TCP连接(多块并发传输)

负载均衡机制:

- 动态权重调整(根据磁盘IOPS/网络带宽)

- 热点数据自动迁移(基于访问频率统计)

- 分级存储策略(SSD缓存层+HDD冷存储)

安全与可靠性保障

访问控制:

- ACL权限模型(如HDFS的owner/group/other三级权限)

- RBAC角色授权(Ceph的CephX认证体系)

- 透明加密(TLS传输+磁盘加密)

故障恢复机制:

- 心跳超时检测(默认30秒间隔)

- 自动副本重建(如HDFS的Balancer工具)

- 脑裂防护(基于Paxos协议的仲裁机制)

数据完整性验证:

- 校验和(MD5/SHA-1)逐块验证

- 纠删码校验矩阵(如Reed-Solomon的Gauss消元法)

- 周期性Scrub扫描(Ceph的Scrub进程)

实践部署要点

硬件选型建议:

| 组件 | 推荐配置 |

|—————|————————————————————————–|

| 元数据节点 | SSD硬盘+高主频CPU(如Intel Xeon Gold系列) |

| 存储节点 | SAS HDD+NVMe缓存盘(读写分离架构) |

| 网络设备 | 10/25Gbps以太网+RDMA网卡(RoCE协议) |软件配置参数:

- HDFS:dfs.replication=3,io.file.buffer.size=131072

- Ceph:osd_pool_default_size=3,osd_max_backfills=3

- GlusterFS:transport.socket.timeout=60,performance.stat-prefetch=yes

监控体系构建:

- 基础指标:磁盘IO延迟、网络吞吐量、CPU利用率

- 高级监控:数据分布热力图、副本一致性状态、恢复进度

- 告警阈值:SMART错误>5%、副本缺失>10分钟、元数据延迟>500ms

挑战与未来发展趋势

当前技术瓶颈:

- 跨地域部署时的网络延迟问题(>10ms显著影响性能)

- 小文件存储效率低下(元数据开销占比过大)

- 混合云场景下的数据一致性保障

- 存储成本与性能的平衡(SSD/HDD混布策略优化)

演进方向:

- 智能存储:AI驱动的数据布局优化(如强化学习训练放置策略)

- 边缘协同:支持P2P直传与边缘缓存(减少核心节点压力)

- 量子存储:后量子密码学保障长期数据安全

- 绿色存储:基于PUE(Power Use Efficiency)的动态节能算法

FAQs

Q1:如何选择适合业务的分布式文件系统?

A1:需综合考虑以下维度:

- 数据特征:HDFS适合大文件批处理,Swift适合小对象存储

- 一致性要求:金融数据选强一致性系统,日志数据可接受最终一致

- 扩展需求:预计节点数>50建议Ceph,<20节点可考虑GlusterFS

- 运维能力:商业支持选EMC Isilon,开源优先Ceph/MinIO

Q2:如何处理分布式存储中的数据不一致问题?

A2:解决方案包括:

- 版本控制:为每个数据块维护版本号(如乐观锁机制)

- 冲突检测:使用向量时钟标记更新顺序(如Riak的因果一致性)

- 事务日志:WAL(Write-Ahead Logging)保证操作原子性

- 定期校验:后台Scrub任务比对副本差异(Ceph每6小时全量