上一篇

分布式文件存储系统常用

- 行业动态

- 2025-05-05

- 3

分布式文件存储系统常用分片、副本、一致性哈希等技术,结合元数据管理实现高可用与扩展性,需在CAP定理中权衡,典型如HDFS

分布式文件存储系统核心技术解析与实践指南

分布式文件存储系统核心概念

分布式文件存储系统通过将数据分散存储在多个节点上,实现数据的高可用性、可扩展性和高性能访问,其核心特性包括:

| 特性 | 描述 |

|---|---|

| 数据分片 | 将大文件拆分为多个块(Block)或对象(Object)分布存储 |

| 元数据管理 | 维护文件目录结构、权限、位置映射等关键信息 |

| 数据冗余 | 通过副本、纠删码等技术保障数据可靠性 |

| 负载均衡 | 动态分配读写请求到不同存储节点 |

| 容错机制 | 节点故障时自动切换数据副本,保证服务连续性 |

| 可扩展性 | 支持在线扩展存储容量和计算能力 |

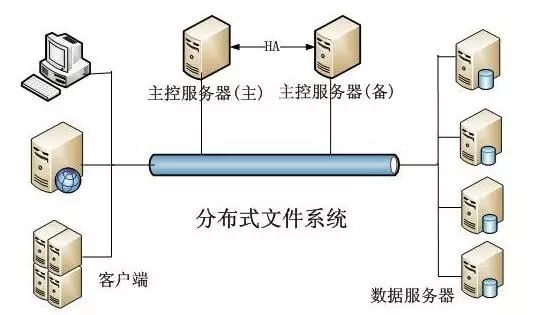

典型架构包含三个核心组件:

- 客户端(Client):负责发起文件操作请求

- 元数据服务器(MDS):管理文件元信息

- 存储节点(Storage Node):实际存储数据块

主流分布式文件存储系统对比

以下是当前广泛应用的分布式文件存储系统特性对比:

| 系统名称 | 架构类型 | 数据冗余方式 | 元数据管理 | 最佳应用场景 | 社区活跃度 |

|---|---|---|---|---|---|

| HDFS | Master-Slave | 3副本 | 单Active NameNode | 大数据分析(Hadoop生态) | |

| Ceph | 无中心架构 | CRUSH算法+副本/EC | MON集群 | 云存储、块存储、对象存储 | |

| GlusterFS | 纯分布式 | 分布式AFR | 弹性哈希分布 | 企业级NAS、媒体存储 | |

| MooseFS | 主从架构 | N+M冗余策略 | 集中式元数据 | 中小规模文件共享 | |

| MinIO | 对象存储 | Erasure Coding | etcd/DNS | 云原生应用、机器学习数据集 | |

| JuiceFS | 混合架构 | 弹性副本+强一致性 | Redis/MySQL | 容器化环境、实时分析 | |

| FastDFS | 分组架构 | 分组复制+同步写 | Tracker集群 | 大规模图片/视频存储 |

技术选型关键指标:

- 数据一致性:强一致性(Ceph/MinIO) vs 最终一致性(HDFS/GlusterFS)

- 扩展性:横向扩展能力(Ceph/MinIO) vs 纵向扩展瓶颈(传统HDFS)

- 存储效率:纠删码(EC)比副本节省50%空间但增加计算开销

- 元数据性能:集中式(HDFS)存在瓶颈,分布式(Ceph)扩展性强

- 协议支持:POSIX兼容(Ceph/GlusterFS)、S3 API(MinIO)、自定义协议(FastDFS)

关键技术组件详解

元数据管理方案:

- 集中式(HDFS):单点性能瓶颈,依赖ZooKeeper实现HA

- 分布式哈希表(Ceph):基于CRUSH算法的动态映射

- 弹性分区(GlusterFS):按目录哈希分配元数据服务器

- 内存数据库(JuiceFS):使用Redis实现亚毫秒级响应

数据分片策略:

| 策略类型 | 优点 | 缺点 | 适用场景 |

|—————-|———————-|———————-|———————-|

| 固定大小分块 | 简单高效 | 小文件产生碎片 | HDFS/Ceph |

| 对象存储 | 元数据开销小 | 不支持文件内操作 | MinIO/S3 |

| 智能分块 | 优化冷热数据分布 | 实现复杂 | Ceph RBD |

| 日志结构 | 顺序写入高性能 | 随机读取效率低 | Kafka日志存储 |容灾恢复机制:

- 主动复制:同步/异步写入副本(HDFS默认3副本)

- 纠删编码:将数据转换为校验矩阵(MinIO采用Reed-Solomon算法)

- 版本控制:快照+增量备份(Ceph支持时间点回滚)

- 跨机房同步:基于RAFT协议的多副本同步(TiKV/etcd集群)

典型应用场景与实践建议

大数据分析平台:

- 推荐组合:HDFS + Impala/Spark

- 优化要点:启用短回路访问本地数据,配置YARN资源调度

- 典型案例:Facebook用HDFS存储PB级日志数据

云原生存储:

- 推荐方案:MinIO + Kubernetes CSI驱动

- 关键参数:设置合适的EC编码参数(如k=4,m=2)

- 监控指标:关注PROVISIONER_CONVERSION_TIMEOUT等异常

分发:

- 适配系统:Ceph + NGINX-RTMP模块

- 性能调优:开启Ceph的OSD自动平衡功能,配置SSD缓存层

- 安全策略:启用RBAC权限控制,对接Keystone认证

容器化环境:

- 最佳实践:JuiceFS挂载到Pod,使用Redis作为元数据存储

- 注意事项:设置合理的文件句柄上限(ulimit -n)

- 性能优化:启用FUSE缓存,调整DIRENT_CACHE_SIZE参数

系统选型决策树

graph TD

A[业务需求] --> B{数据规模?}

B -->|<10TB| C[MooseFS/GlusterFS]

B -->|10TB-100TB| D[Ceph/HDFS]

B -->|>100TB| E[Ceph+MinIO混合架构]

A --> F{访问模式?}

F -->|高频小文件| G[Ceph/MinIO]

F -->|顺序大文件| H[HDFS]

A --> I{协议兼容性?}

I -->|POSIX| J[Ceph/GlusterFS]

I -->|S3 API| K[MinIO]常见问题与解决方案FAQs

Q1:HDFS在写入大量小文件时性能低下怎么办?

- 解决方案:

- 启用Hadoop的Federation特性,将元数据分散到多个NameNode

- 使用SequenceFile/Avro合并小文件

- 调整dfs.replication参数降低副本数

- 部署异构存储架构,将小文件迁移到对象存储(如MinIO)

Q2:Ceph集群出现OSD失联如何处理?

- 排查步骤:

- 检查ceph osd tree查看失联节点状态

- 查看对应主机网络连通性(ping/telnet)

- 检查磁盘SMART状态(ceph osd df)

- 重启osd.

进程并查看日志(journalctl -u ceph-osd) - 如果持续失联,执行ceph osd out <osd.id>标记失效节点

未来技术演进趋势

- 存算分离架构:通过NVMe-oF协议实现计算与存储解耦

- Serverless存储:按需自动扩缩容,按实际使用量计费

- AI增强调度:基于机器学习预测热点数据分布

- 量子存储探索:利用量子纠缠特性实现超高密度存储

- 绿色存储技术:通过MAID(Massive Array of Idle Disks)降低待机功耗

当前主流系统仍在持续迭代,建议关注上游社区的技术路线图(如Ceph的Octopus/Pacific版本新特性),同时结合硬件发展趋势(如ARM服务器、傲腾持久内存)进行架构优化,对于关键业务场景,建议采用混合云存储策略,将热数据存放在本地高性能存储,冷数据归档到对象存储,并通过生命周期策略实现