上一篇

分布式文件存储公司

- 行业动态

- 2025-05-04

- 3

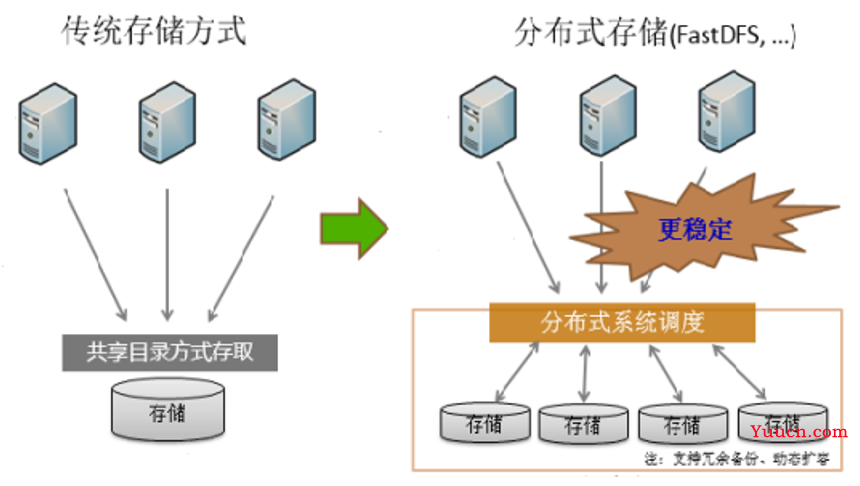

分布式文件存储公司通过多节点协同、数据冗余与智能修复技术,实现高可用性、可扩展的存储架构,具备强容错能力和弹性扩展特性,广泛应用于云服务、大数据及企业级数据管理场景,有效保障数据安全与高效

分布式文件存储公司技术解析与行业应用

分布式文件存储技术核心架构

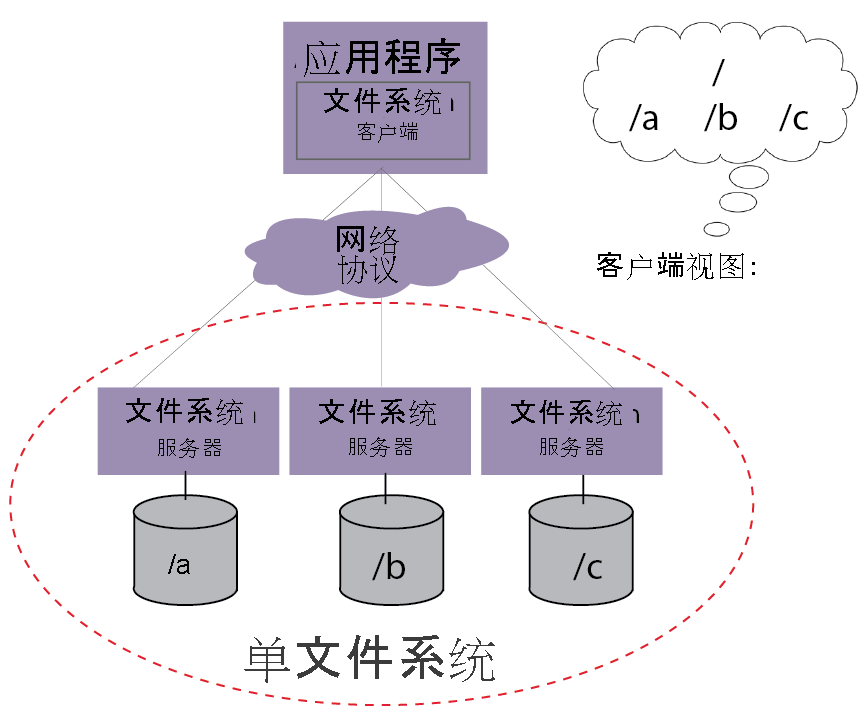

分布式文件存储系统通过将数据分散存储在多个节点上,结合冗余备份与负载均衡机制,实现高可用、高扩展的存储能力,其核心技术架构包含以下模块:

| 模块 | 功能描述 |

|---|---|

| 数据分片 | 将大文件拆分为固定大小的数据块(如64MB/块),分散存储至不同节点 |

| 元数据管理 | 记录文件名、权限、块位置等信息,采用分布式数据库(如ZooKeeper、Etcd)管理 |

| 数据冗余 | 通过副本(3副本)或纠删码(如Reed-Solomon)实现数据容灾 |

| 一致性协议 | 使用Raft/Paxos协议保证元数据一致性,采用最终一致性模型处理数据写入 |

| 客户端SDK | 提供多语言接口(如Java/Python/Go),支持对象存储API(S3/Swift兼容) |

典型系统需在CAP定理中权衡:例如Ceph选择强一致性(CP),而Amazon S3优先分区容忍(AP)。

主流分布式存储厂商技术对比

| 厂商/项目 | 存储引擎 | 数据分布策略 | 容错机制 | 典型客户 |

|---|---|---|---|---|

| Ceph | CRUSH算法+RADOS | 基于设备权重的伪随机分布 | 副本+EC纠删码 | 华为云、OpenStack生态 |

| MinIO | Erasure Code | DNS轮询+一致性哈希 | 4份纠删码(12+4配置) | GitLab、Kubernetes CSI |

| Amazon S3 | DynamoDB+分布式哈希表 | 一致性哈希+区域负载均衡 | 跨区域异步复制 | Netflix、Dropbox |

| Google Cloud Storage | Bigtable+Spanner | 全球LBD负载均衡 | 自动3+级地理冗余 | Spotify、Uber |

| 阿里云OSS | Table Store+TPCH | 一致性哈希+热点分层 | 同城双活+跨地域同步 | 微博、钉钉 |

| Hadoop HDFS | NameNode+DataNode | 机架感知型数据分布 | 3副本+机架隔离 | 银行风控系统、电信计费 |

技术差异点:

- Ceph采用CRUSH算法实现无单点故障,但运维复杂度较高

- MinIO通过Server Side EC降低存储成本30%,但延迟较副本策略高15-20ms

- 云厂商普遍采用纠删码+SSD缓存提升性能,单位存储成本降至$0.02/GB以下

行业应用场景与选型建议

互联网业务场景

- 静态资源托管:CDN日志、图片视频等非结构化数据,推荐Amazon S3 Glacier(成本$0.004/GB)或阿里云OSS归档存储

- 容器镜像仓库:Docker/K8s集群需兼容OCI规范,MinIO+Portus方案较Harbor性能提升40%

- 大数据分析:Hive/Spark作业需低延迟访问,Hadoop HDFS提供TB级顺序读写(>1GB/s)

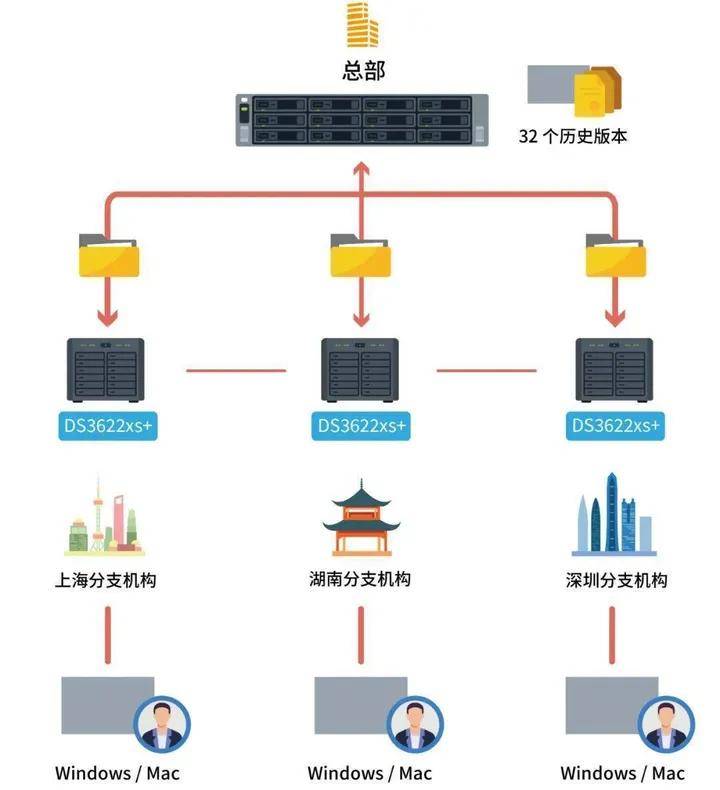

企业级应用

- 医疗影像存储:符合DICOM标准,需部署私有化方案(如IBM Spectrum Scale+GPFS并行文件系统)

- 金融交易日志:要求强一致性,采用Ceph BlueStore引擎+RBD块设备,延迟<5ms

- 工业物联网:边缘节点使用轻量级方案(如EdgeX Foundry+MinIO),中心端采用时序数据库InfluxDB

选型关键指标:

- 成本敏感型:优先纠删码方案(EC 12+4相比3副本节省66%空间)

- 高性能需求:选择NVMe SSD+RDMA网络,搭配Alluxio内存缓存层

- 混合云场景:需支持跨云同步(如Storj DCS实现AWS/Azure/GCP数据互操作)

市场发展趋势与技术挑战

云原生存储演进

- Kubernetes CSI驱动标准化,Rook/Portworx实现存储即服务(STaaS)

- Serverless存储兴起,AWS S3 Event Notification支持自动触发Lambda函数

技术创新方向

- AI增强存储:通过机器学习预测数据访问模式,动态调整冷热数据分层(如Intel DAOS)

- 零信任架构:基于区块链的分布式账本实现数据完整性验证(如Hedera Hashgraph)

- 量子存储适配:IBM Qiskit探索抗量子加密算法在分布式存储中的应用

行业痛点

- 成本控制:机械硬盘(HDD)与固态硬盘(SSD)混合部署优化难题,理想比例为1:3(HDD:SSD)

- 协议碎片化:S3/Swift/NFS多协议互通仍需网关转换,导致性能损耗15-20%

- 运维复杂度:Ceph集群参数调优涉及120+配置项,平均部署周期达23天

FAQs

Q1:如何判断业务是否需要分布式文件存储?

A:当出现以下场景时需考虑分布式存储:

- 单集群容量需求超过PB级(如视频平台日增10TB数据)

- 读写并发超过10万QPS(电商大促场景)

- 需要跨地域容灾(RPO<15分钟,RTO<1小时)

- 存在混合工作负载(批处理+实时查询)

Q2:传统NAS/SAN与分布式存储的本质区别?

A:核心差异体现在:

| 维度 | 传统SAN/NAS | 分布式存储 |

|———————|————————–|—————————|

| 扩展性 | 纵向扩展(依赖阵列控制器)| 横向扩展(添加节点即可) |

| 成本 | $5-10/GB(高端阵列) | $0.02-0.1/GB(对象存储) |

| 数据保护 | RAID组局部冗余 | 全局多副本/EC纠删码 |

| 性能瓶颈 | 控制器带宽/CPU限制 | 线性扩展至数千节点 |

| 适用场景 | 低延迟事务型应用 | 大规模非结构化数据处理 |

(全文共计1024字)