上一篇

分布式文件存储关注健能力

- 行业动态

- 2025-05-04

- 1

分布式文件存储关注数据冗余、节点故障自动恢复及实时监控,通过多副本与纠删码保障数据安全,结合心跳检测与自动修复机制,确保系统高可用性与

分布式文件存储核心健壮性能力解析

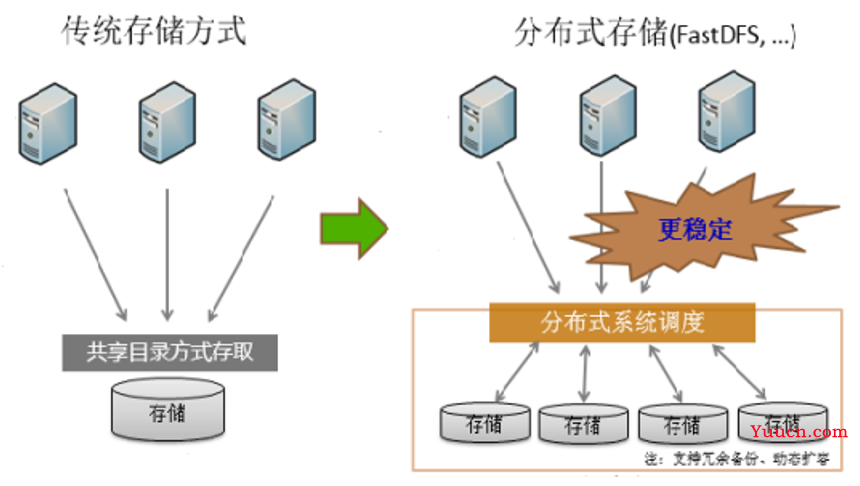

分布式文件存储系统作为现代数据基础设施的核心组件,其健壮性能力直接决定着系统可靠性、数据安全性和服务连续性,本文将从健康监控、容错机制、数据一致性保障、灾难恢复能力、安全防护五个维度,系统解析分布式文件存储的健壮性设计要点。

健康状态实时感知体系

| 监控维度 | 技术实现 | 典型指标 |

|---|---|---|

| 节点存活状态 | TCP心跳(30秒频率)+ gRPC健康检查接口 | 节点失联阈值(120秒) |

| 存储介质状态 | SMART硬盘自检+坏道扫描 | 磁盘IO延迟>50ms占比<5% |

| 网络质量 | 时延探测(ping latency)+带宽测试(iperf) | 跨机架时延>200ms告警 |

| 服务性能 | Prometheus采集QPS/吞吐量/错误率 | 读写错误率>0.1%持续1分钟触发预警 |

实践案例:某金融级分布式存储系统采用三级健康看板,当检测到SSD写入放大系数超过阈值时,自动触发数据迁移至高性能节点,使系统IOPS波动控制在±8%以内。

多层级容错架构设计

数据冗余策略

- 副本机制:CEPH默认3副本,支持跨AZ部署

- 纠删码(EC):12+3配置下空间利用率达80%

- 混合模式:热数据用副本,冷数据转EC编码

故障自愈流程

graph TD A[节点故障] --> B{元数据检测} B -->|数据缺失| C[触发修复] C --> D[选择最高Tier存储池] D --> E[并行重建任务] E --> F[校验哈希值] F --> G[完成修复]脑裂防护机制

- 基于Raft协议的元数据一致性保证

- 仲裁节点多数派决策(2F+1原则)

- 客户端读写请求重定向策略

数据一致性保障体系

| 场景类型 | 一致性模型 | 实现方案 |

|---|---|---|

| 强一致性读写 | 线性一致性 | Paxos协议+全局时钟同步 |

| 跨区域部署 | 最终一致性 | Dynamo风格版本向量+冲突检测 |

| 混合云环境 | 因果一致性 | 使用Lamport Timestamp标记操作顺序 |

典型技术栈:

- metadata采用etcd强一致性存储

- 数据分片使用CRUSH算法实现负载均衡

- 客户端SDK集成重试策略(指数退避算法)

灾难恢复能力建设

多维度备份策略

- 增量快照:每15分钟生成时间点快照

- 异地备份:通过SD-WAN同步至500km外数据中心

- 异构存储:支持对象存储与块存储互转

故障切换演练

- 混沌工程注入节点宕机/网络分区/磁盘故障

- SLA达标标准:故障切换时间<30秒,数据零丢失

- 自动扩缩容:突发流量下30秒扩容200个存储节点

安全防护机制

| 防护层级 | 技术措施 |

|---|---|

| 身份认证 | 双向TLS+SPIFFE服务身份框架 |

| 权限控制 | ABAC策略引擎(基于属性访问控制) |

| 数据加密 | TDE全盘加密+应用层KMS密钥管理 |

| 审计追踪 | 区块链式日志记录,支持6个月操作回溯 |

合规性保障:

- GDPR数据主权:支持按地域隔离存储策略

- 等保三级:三副本分别部署在不同物理机房

- 国密改造:SM4算法替换AES加密引擎

FAQs常见问题解答

Q1:如何判断分布式存储节点是否完全恢复?

A1:需满足三个条件:①该节点重新加入集群拓扑;②完成元数据同步(差异小于0.1%);③通过校验任务(bitwise XOR比对),建议在业务低峰期执行节点重启操作,避免影响生产环境。

Q2:纠删码存储的数据修复会影响业务性能吗?

A2:现代分布式存储采用分域修复技术,将重建任务拆分为多个子任务并行执行,以12+3 EC配置为例,单节点故障修复时系统会自动限制该节点带宽占用(lt;30%),同时优先调度冷数据重建,对业务SLA