上一篇

分布式文件存储go

- 行业动态

- 2025-05-05

- 1

分布式文件存储基于多节点冗余存储,Go语言凭借并发优势实现高效数据分片与容错

分布式文件存储系统设计与Go语言实现详解

分布式文件存储核心概念

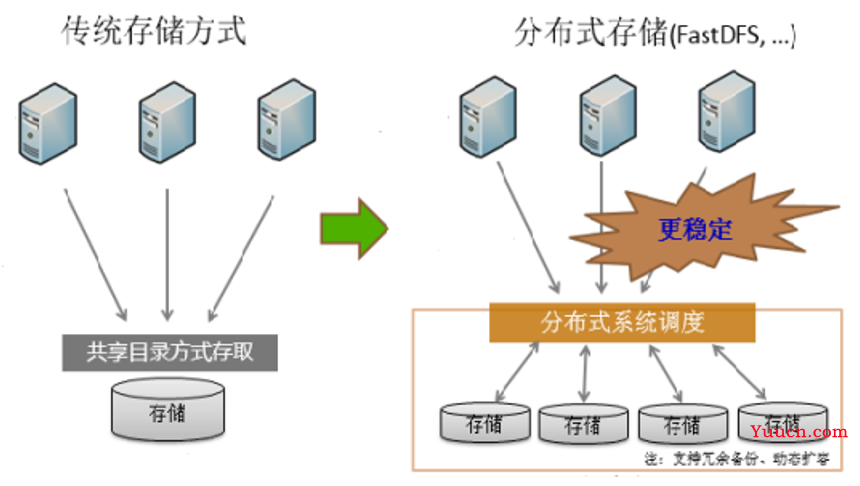

分布式文件存储系统通过将数据分散存储在多个节点上,实现高可用、高扩展和高性能的文件管理,与传统集中式存储相比,其核心优势在于:

| 特性 | 集中式存储 | 分布式存储 |

|---|---|---|

| 容量扩展 | 受限于单节点硬件 | 线性扩展 |

| 可靠性 | 单点故障风险 | 多副本冗余 |

| 访问性能 | 受单节点IO限制 | 并行访问优化 |

| 地理分布 | 需复杂代理配置 | 天然支持多地域 |

典型应用场景包括云存储服务(如AWS S3)、大数据分析平台(如Hadoop HDFS)、视频内容分发网络等。

系统架构设计要点

元数据管理

- 采用分布式元数据服务(如Etcd/ZooKeeper集群)

- 目录结构采用树形扁平化设计(类似Ceph的CRUSH算法)

- 元数据分片策略:哈希取模+虚拟节点实现负载均衡

数据分片与存储

固定大小分块(如64MB)提升并行度

纠删码(Erasure Coding)替代传统3副本:

// 使用Reed-Solomon算法实现10+4纠删码 import "github.com/klauspost/reedsolomon" encoder, _ := reedsolomon.New(10, 4) // 10数据片+4校验片 data := make([][]byte, 10) // 填充数据分片 encoded := encoder.Encode(data) // 生成14个编码分片

一致性保障机制

- 强一致性场景:采用Raft协议实现元数据同步

- 最终一致性场景:版本向量(Vector Clocks)冲突检测

- 混合模式:目录结构强一致,文件内容最终一致

Go语言实现关键技术

网络通信层

- gRPC框架实现节点间RPC调用

- Protobuf定义存储服务接口:

service StorageService { rpc StoreBlock(stream BlockData) returns (StoreResponse); rpc RetrieveBlock(BlockRequest) returns (stream BlockData); }

存储节点管理

- 动态加入/离开的集群成员管理

- 基于一致性哈希的负载均衡:

type ConsistentHash struct { rings []int // 哈希环 nodeMap map[int]string// 虚拟节点映射 replicas int // 每个节点的虚拟节点数 }

故障检测与恢复

- 心跳机制实现节点存活监测

- 数据自愈流程:

- 检测丢失分片(通过校验和比对)

- 触发数据重建任务

- 从幸存副本恢复数据

性能优化策略

并发控制

- 使用Go的

sync.WaitGroup实现并行数据写入 - 限流控制避免单个节点过载:

var limiter = make(chan struct{}, 100) // 最大并发数100 for _, block := range blocks { limiter <struct{}{} go func(b Block) { defer func() { <-limiter }() // 处理分块存储 }(block) }

- 使用Go的

缓存加速

- LRU缓存实现元数据热访问加速

- 本地SSD缓存热点数据块

- 客户端缓存预读机制:

cache := NewLRUCache(1024102410) // 10MB缓存 if data, ok := cache.Get(blockID); ok { return data } // 缓存未命中时读取存储节点

网络优化

- 零拷贝技术减少数据复制次数

- UDP加速批量数据传输(配合FEC前向纠错)

- 连接池复用TCP连接降低延迟

完整示例代码框架

package main

import (

"google.golang.org/grpc"

pb "storage/proto"

)

type StorageNode struct {

pb.UnimplementedStorageServiceServer

metadata MetadataService

storage LocalStorage

}

func (s StorageNode) StoreFile(ctx context.Context, req pb.StoreRequest) (pb.StoreResponse, error) {

// 1. 元数据服务注册文件

meta, err := s.metadata.RegisterFile(req.FileName, req.Size)

if err != nil { return nil, err }

// 2. 分块上传并行处理

var wg sync.WaitGroup

for _, block := range meta.Blocks {

wg.Add(1)

go func(b BlockMeta) {

defer wg.Done()

s.storage.WriteBlock(b, req.DataStream)

}(block)

}

wg.Wait()

// 3. 返回存储凭证

return &pb.StoreResponse{Checksum: meta.Checksum}, nil

}技术对比与选型建议

| 特性 | Ceph/HDFS | MinIO | 自建Go系统 |

|---|---|---|---|

| 协议兼容性 | 专有协议 | S3 API | 自定义API |

| 二次开发灵活性 | 低 | 中 | 高 |

| 学习成本 | 高 | 中 | 中 |

| 性能调优空间 | 有限 | 较大 | 极大 |

建议在需要深度定制的场景(如特定纠删码策略、特殊元数据结构)选择自建系统,其他情况优先考虑成熟方案。

FAQs

Q1:如何保证跨区域部署时的数据一致性?

A1:采用分层一致性策略:1) 核心元数据使用Raft协议保证强一致;2) 区域间通过异步复制+版本号机制实现最终一致;3) 关键操作(如目录创建)采用2PC协议确保原子性,建议设置合理的写Quorum(如多数节点确认即成功)。

Q2:遇到存储节点突然离线如何处理?

A2:系统会自动执行以下步骤:1) 通过心跳超时标记节点失效;2) 重新计算数据分布并触发数据迁移;3) 对未完成上传的文件进行断点续传;4) 根据副本策略创建新副本,整个过程对上层业务透明,恢复后节点会自动同步