上一篇

分布式消息产品如何使用

- 行业动态

- 2025-05-05

- 3

分布式消息产品使用需三步:1.选产品(如Kafka/RabbitMQ)搭建集群;2.配置主题/队列并定义消息格式;3.通过SDK实现生产者发送、消费者订阅,配合监控工具保障消息可靠性与

分布式消息产品使用方法详解

基础概念与核心组件

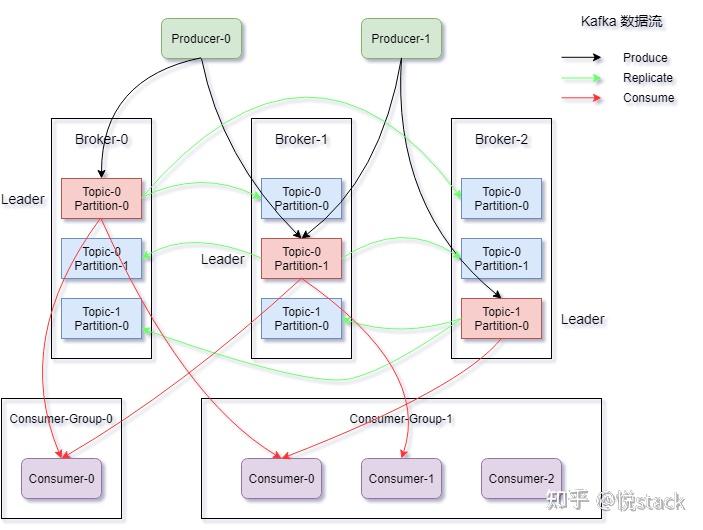

分布式消息产品通过异步通信机制解决高并发、数据一致性、服务解耦等问题,其核心组件包括:

| 组件 | 功能描述 |

|---|---|

| Producer | 消息生产者,负责将业务数据封装为消息并发送到消息队列 |

| Consumer | 消息消费者,订阅队列并处理消息 |

| Broker | 消息中间件服务器,负责存储、转发消息 |

| Topic | 消息主题,用于区分不同业务场景(如订单、日志) |

| Message Queue | 消息队列,提供先进先出的存储结构 |

| Zookeeper | 协调服务(如Kafka),管理集群元数据和配置信息 |

使用流程与关键步骤

需求分析与产品选型

根据业务场景选择合适产品:

- 高吞吐量场景:Kafka(单节点百万级TPS)

- 复杂路由场景:RabbitMQ(支持Exchange交换)

- 金融级可靠性:RocketMQ(支持可靠投递、事务消息)

- 云原生场景:阿里云MQ、AWS SQS

架构设计原则

| 设计目标 | 实现方案 |

|---|---|

| 高可用性 | 部署多Broker集群,启用主从复制(如Kafka ISR机制) |

| 负载均衡 | 按Key哈希分区,Consumer Group自动负载分配 |

| 消息顺序性 | 启用Partition有序消费(Kafka)、RocketMQ顺序消息 |

| 监控告警 | 集成Prometheus监控JMX指标,设置消息积压、延迟等阈值告警 |

生产环境部署

- 集群部署:至少3个Broker节点,部署在不同AZ

- 参数调优:

- Kafka:

num.partitions根据并发量设置,replication.factor≥3 - RocketMQ:

brokerSuspendMaxTimeMillis设置故障转移时间

- Kafka:

- 安全配置:启用SASL/SSL加密,配置ACL权限控制

消息生产与消费

Producer端关键配置:

// Kafka示例

Properties props = new Properties();

props.put("bootstrap.servers", "broker1:9092,broker2:9092");

props.put("acks", "all"); // 等待全部副本确认

props.put("retries", 3); // 重试次数Consumer端关键逻辑:

// RocketMQ示例

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("group1");

consumer.subscribe("TopicA", "");

consumer.registerMessageListener(new MessageListenerConcurrently() {

@Override

public ConsumeConcurrentlyStatus consumeMessage(List<MessageExt> msgs) {

// 业务处理逻辑

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

}

});高级特性与最佳实践

消息可靠性保障

| 场景 | 解决方案 |

|---|---|

| 防止消息丢失 | 开启可靠投递(同步刷盘SYNC_FLUSH)、ACK确认机制 |

| 消息重复消费 | 消费者端实现幂等性(基于唯一消息ID去重) |

| 高峰削峰 | 启用消息堆积能力(如Kafka保留策略设置为”delete”) |

流量控制与限流

- Producer端:限制发送速率(如Kafka

max.in.flight.requests.per.connection) - Consumer端:设置消费速率(RocketMQ

pullThresholdSize) - Broker端:配置最大连接数、IP黑名单

消息轨迹追踪

- 启用消息轨迹(如RocketMQ

RELIABLE_DELIVER) - 集成Zipkin/Jaeger进行全链路追踪

- 日志记录关键节点耗时(Producer发送耗时、Broker存储耗时)

典型场景与案例分析

场景1:电商订单处理

| 环节 | 实现方式 |

|---|---|

| 订单创建 | Producer发送OrderCreate消息到order-topic |

| 库存扣减 | Consumer Group消费消息,执行库存服务 |

| 支付通知 | 通过消息扩展属性携带支付状态,触发WMS发货 |

| 最终一致性 | 使用事务消息(RocketMQ事务半消息)保证库存与订单状态一致 |

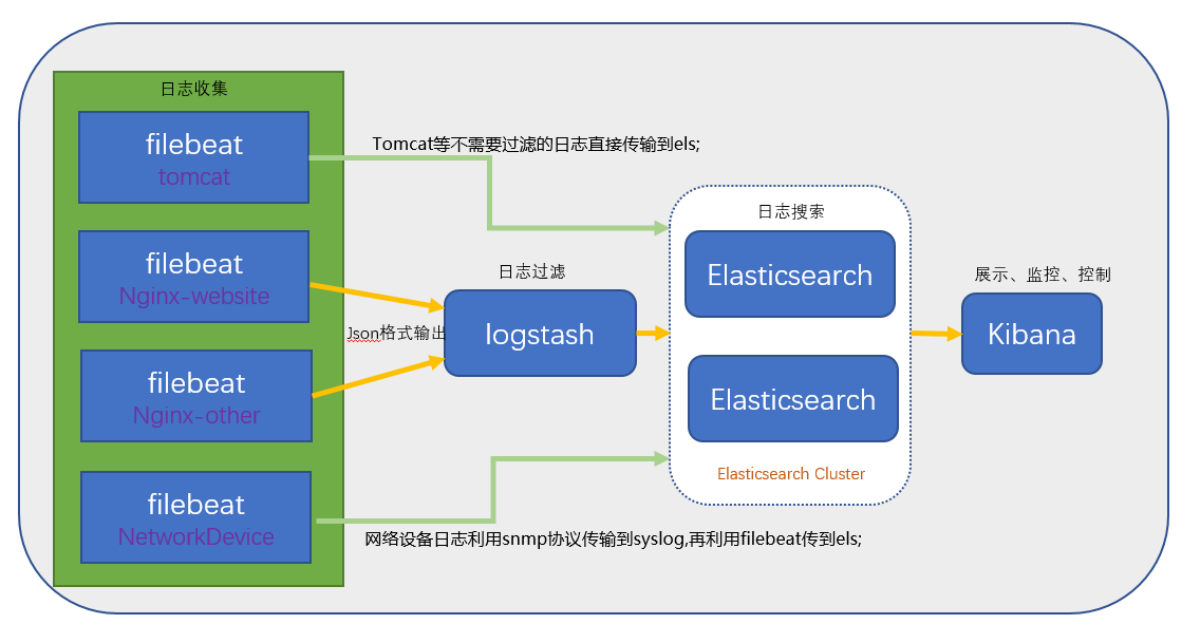

场景2:日志异步收集

- 架构:各服务节点作为Producer发送日志到

log-topic - Consumer:ELK集群消费消息,写入Elasticsearch

- 优化点:

- 压缩传输(启用Kafka

compression.type=LZ4) - 批量发送(设置

batch.size=16384) - 冷热分离(设置日志保留策略为7天)

- 压缩传输(启用Kafka

常见问题与解决方案

FAQs:

Q1:消息积压如何处理?

- 诊断步骤:

- 检查Broker磁盘IO是否饱和

- 分析Consumer消费速率(

consumer_offset增长情况) - 查看JVM堆内存使用(防止GC停顿)

- 解决方案:

- 临时扩容Consumer实例数

- 优化消息大小(控制在1KB以内)

- 开启Kafka

unclean.leader.election.enable=false防止数据丢失

Q2:如何保证消息不丢失?

- Producer侧:

- 设置

acks=all(Kafka)或可靠同步刷盘(RocketMQ) - 启用消息确认回调

- 设置

- Broker侧:

- 部署多副本集群(Kafka

min.insync.replicas=2) - 关闭自动删除(

log.retention.hours=168)

- 部署多副本集群(Kafka

- Consumer侧:

- 手动提交偏移量(非自动提交)

- 处理异常时返回RECONSUME(RocketMQ)或死亡信道(DL