上一篇

分布式消息系统1111活动

- 行业动态

- 2025-05-04

- 3

分布式消息系统在1111活动中支撑高并发场景,通过削峰填谷平缓流量峰值,异步解耦提升系统响应速度,并保障订单、库存等数据最终一致性,常用Kafka/RabbitM

分布式消息系统在1111活动中的核心作用与实践

业务背景与核心挑战

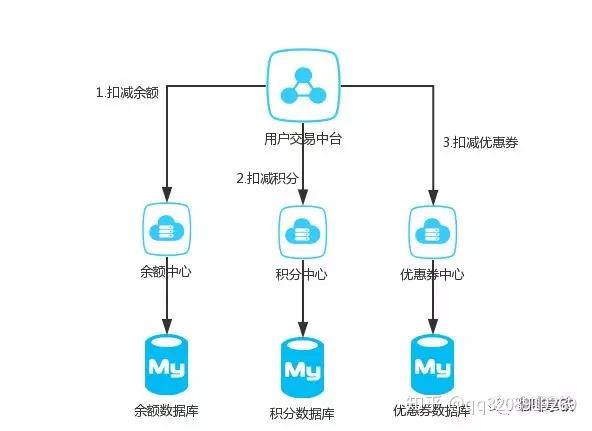

“1111”类电商大促活动具有典型的三高特征:高并发(每秒数十万级请求)、高密度(百万级订单并发)、高复杂度(多系统交互),传统单体架构在应对瞬时流量洪峰时存在明显瓶颈,而分布式消息系统通过异步解耦、削峰填谷、流量调控等机制,成为支撑大促活动的核心基础设施。

!分布式消息系统架构图

分布式消息系统核心组件解析

| 组件类型 | 典型代表 | 关键特性 | 适用场景 |

|---|---|---|---|

| 消息队列 | Kafka/RocketMQ | 高吞吐、持久化、分区存储 | 订单日志、库存同步 |

| 流计算引擎 | Flink/Spark Stream | 实时计算、窗口运算 | 实时大屏、风控预警 |

| 消息中间件 | RabbitMQ/ActiveMQ | 可靠投递、事务支持 | 支付回调、优惠券发放 |

| 配置中心 | Nacos/Apollo | 动态刷新、服务发现 | 流量开关、AB测试 |

关键技术实现路径

流量削峰机制

通过消息队列构建”缓冲带”,将突发流量异步处理:# 示例:基于RabbitMQ的削峰代码 def handle_request(data): # 快速响应客户端 send_ack(client) # 异步处理业务逻辑 rabbitmq.publish(exchange, routing_key, data)

消息顺序性保障

采用RocketMQ的顺序消息特性,保证关键业务处理顺序:

-订单处理消息表结构 CREATE TABLE order_message ( message_id BIGINT, order_id VARCHAR(32), PRIMARY KEY(message_id) ) WITH (kafka_props='partition_by=order_id');

高可用架构设计

- 多活部署:北京/上海/深圳三地机房容灾

- 负载均衡:基于权重的动态流量分配算法

- 自动扩容:根据队列长度自动扩展Consumer实例

典型业务场景实践

订单处理流程

sequenceDiagram participant Client participant API Gateway participant Order Service participant Message Queue participant Inventory Service Client->>API Gateway: 提交订单 API Gateway->>Order Service: 创建订单 Order Service->>Message Queue: 发送库存扣减消息 Message Queue->>Inventory Service: 处理库存

实时数据大屏

- 数据采集:Flink从Kafka消费订单消息

- 窗口计算:每5秒统计GMV、UV等指标

- 数据推送:通过WebSocket推送至前端

- 异常流量防护

| 防护策略 | 实现方式 | 阈值参数 |

|—————–|———————————–|————————|

| 请求限流 | 令牌桶算法+Redis计数器 | 5000 QPS/接口 |

| 熔断降级 | Sentinel集群保护模式 | 错误率>50%时熔断 |

| 消息背压 | 动态调整Consumer消费速率 | 队列长度>10万时告警 |

性能优化实战经验

JVM调优参数

| 参数名称 | 生产环境值 | 作用说明 |

|——————-|—————–|————————–|

| G1HeapRegionSize | 8GB | 大内存堆内存划分 |

| MaxDirectMemory | 64MB | DirectBuffer限制 |

| SurvivorRatio | 8 | Eden区与Survivor区比例 |网络优化方案

- 启用TCP快速打开(TCP_FASTOPEN)

- 配置Netty的SO_RCVBUF=16MB

- 使用RDMA(远程直接内存访问)技术

- 存储优化策略

- Kafka日志分段大小:1GB/段

- RocketMQ可靠投递:同步刷盘+异步复制

- SSD磁盘阵列:RAID10+读写分离架构

典型故障处理案例

案例1:消息积压处理

- 现象:Kafka某个Partition滞后超过1小时

- 处理步骤:

- 检查Consumer Group状态(under-replicated)

- 增加Consumer实例数(从10→20)

- 调整auto.offset.reset=latest

- 开启DLQ(死信队列)转移过期消息

案例2:消息重复消费

- 解决方案:

- 幂等性设计:基于唯一订单号去重

- 事务消息:RocketMQ可靠投递+本地事务检查

- 消费偏移管理:定期提交offset+人工干预

未来演进方向

- 云原生消息服务

- Serverless架构:按消息量自动扩缩容

- 多云混合部署:跨AWS/Azure/Aliyun消息互通

- 智能消息调度

- AI预测流量模型:提前预热消息队列

- 动态路由算法:基于业务优先级调度

- 新一代协议演进

- QUIC协议支持:降低网络延迟30%+

- HTTP/3消息传输:提升移动端兼容性

FAQs常见问题解答

Q1:如何应对消息中间件突然宕机的情况?

A1:需构建多层级容灾体系:

- 主备切换:部署双活消息集群,通过VIP自动漂移

- 数据备份:开启Kafka跨机房副本同步(min.insync.replicas>=2)

- 降级预案:临时关闭非核心业务的消息生产,优先保障订单主流程

- 监控告警:设置JMX指标阈值(如UnderReplicatedPartitions>5立即报警)

Q2:消息积压时应该如何进行应急处理?

A2:可采取分阶段处置方案:

- 紧急止血:暂停非关键业务的消息生产(如营销日志)

- 扩容消费:快速扩容Consumer实例,调整并行度参数

- 清理过期:设置消息TTL(如保留72小时),转移冷数据至归档存储

- 根因分析:检查Producer速率、Consumer处理效率、磁盘IO瓶颈等

- 预防措施:建立消息队列健康度评分模型(包含长度、延迟、失败率等