上一篇

分布式文件存储系统安装与使用

- 行业动态

- 2025-05-05

- 3

分布式文件存储系统安装需先搭建 分布式集群环境,配置各节点网络及存储资源,通过管理工具设置元数据与数据节点参数,启动集群服务后,客户端即可通过挂载点访问存储资源

分布式文件存储系统安装与使用指南

系统与选型分析

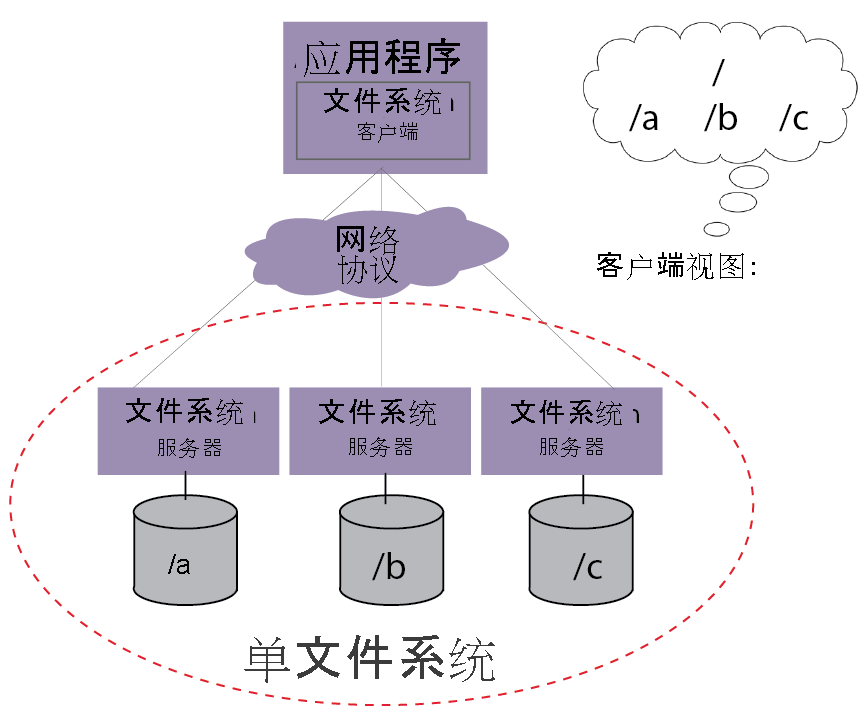

分布式文件存储系统通过将数据分散存储在多台服务器上,实现高可用、高扩展和高性能的文件管理,常见的开源系统包括Ceph、MinIO、GlusterFS等,以下从功能特性、适用场景和技术架构三个维度进行对比分析:

| 特性维度 | Ceph | MinIO | GlusterFS |

|---|---|---|---|

| 核心架构 | CRUSH算法+RADOS | DNS兼容S3协议 | 弹性哈希分布 |

| 存储类型 | 对象/块/文件统一存储 | 对象存储 | POSIX文件系统 |

| 扩展方式 | 动态扩展节点 | 横向扩展 | 卷级联扩展 |

| 数据冗余 | 副本/EC纠删码 | 副本+纠删码 | AFR/AFRC复制 |

| 接口协议 | S3/Swift/NFS/iSCSI | S3/GCS兼容 | NFS/SMB/HTTP |

| 典型场景 | 云存储底座/混合云 | 对象存储服务 | 传统企业NAS替代 |

环境准备与依赖安装

以Ceph为例,部署前需完成以下准备:

硬件要求:

- 至少3台物理服务器(建议奇数节点)

- 千兆网卡+LACP捆绑(推荐)

- SSD作为OS盘+HDD/NVMe作为存储盘

- 时间同步服务(NTP)

软件环境:

# 以CentOS 7为例 yum install -y epel-release yum install ceph-deploy ceph-common ceph-mds ceph-osd ceph-mon ntp python-argparse lsof tcpdump网络配置:

- 关闭防火墙:

systemctl stop firewalld - 配置免密SSH:

ssh-keygen && for host in {nodes}; do ssh-copy-id $host; done - 修改主机名解析:在

/etc/hosts添加所有节点IP与主机名映射

- 关闭防火墙:

集群部署实战步骤

初始化Monitor节点

# 在所有节点创建相同目录结构

for node in mon1 mon2 mon3 osd1 osd2; do

ssh $node "mkdir -p /var/lib/ceph/{mon,osd}/{cluster,tmp}"

done

# 使用ceph-deploy初始化集群

ceph-deploy new mon1 mon2 mon3

ceph-deploy mon create-initial配置OSD存储节点

# 为每台OSD节点准备磁盘(以vdb为例)

for node in osd1 osd2; do

ssh $node "mkfs.xfs -n -f /dev/vdb"

done

# 部署OSD并激活磁盘

ceph-deploy osd create osd1:/dev/vdb osd2:/dev/vdb

ceph osd pool init <poolname> 128客户端配置

# 安装客户端并获取密钥

yum install ceph-common -y

scp mon1:/etc/ceph/ceph.client.admin.keyring /etc/ceph/

# 挂载分布式文件系统

mkdir -p /mnt/cephfs

mount -t ceph $(grep host /etc/ceph/ceph.conf | awk '{print $2}'):/ /mnt/cephfs核心配置参数详解

| 参数类别 | 配置项 | 作用说明 |

|---|---|---|

| 存储池 | size | 对象存储大小(建议4K-64K) |

| 副本策略 | replication_size | 数据副本数量(默认3个) |

| CRUSH算法 | osd_pool_default_size | 每个PG包含的OSD数量(影响数据分布均匀性) |

| 网络优化 | tcp_congestion_algorithm | 拥塞控制算法(推荐bbr) |

| 安全设置 | auth_supported | 是否启用RBAC权限控制(生产环境必开) |

典型使用场景操作示例

文件上传下载

# 上传大文件(启用CRUSH重平衡) rados -p mypool put myfile.dat # 生成临时URL访问(MinIO示例) mc alias set myminio http://minio.example.com accesskey secretkey mc share download myminio/data/myfile.dat --expire 1h

存储容量扩展

# 新增OSD节点 ceph-deploy osd create newosd:/dev/vdc ceph osd crush reweight-osd newosd 0.15 # 逐步增加权重至1.0

监控与故障排查

实时状态查看

# 集群健康状态 ceph health detail # OSD负载情况 ceph osd df tree -f json | jq .nodes[0].children[].stats # 网络延迟检测 ceph osd perf stats

常见问题处理

| 故障现象 | 解决方案 |

|---|---|

| OSD失联报警 | 检查网络连通性,重启osd.target进程 |

| 数据写入延迟过高 | 调整osd_write_buffer_size参数,优化CRUSH拓扑结构 |

| 元数据服务器压力过大 | 增加MON节点数量,启用MDS缓存加速 |

| 客户端认证失败 | 同步密钥环文件,检查cephx权限配置 |

高级功能扩展

多站点容灾配置

# 在ceph.conf中配置跨区域副本

profile rgw-multisite {

role = "rgw-multisite"

...

# 指定主站点和灾备站点的存储池映射

data_pool = "multisite-data"

metadata_pool = "multisite-meta"

}冷热数据分层存储

# 创建生命周期策略(Ceph S3接口)

radosgw-admin bucket modify --bucket mybucket --set-lifecycle '{"rules":[{"status":"Enabled","ID":"ExpireOldVersions","prefix":"","tag":"","noncurrent_days":30}]}'FAQs

Q1:如何选择合适的分布式存储系统?

A:根据业务需求选择:

- 需要兼容S3协议且轻量级部署 → MinIO

- 需要块/对象/文件统一存储 → Ceph

- 传统企业级NAS替代 → GlusterFS

- 温数据归档 → OpenEBS/Rook(Kubernetes环境)

Q2:遇到”OSD weight mismatch”告警如何处理?

A:执行以下步骤:

- 检查各OSD实际容量:

ceph osd df - 调整CRUSH权重:

ceph osd crush reweight-osd {osd_id} {new_weight} - 触发数据再平衡:

ceph osd crush rebalance - 监控集群直到告警消失(`ceph health