上一篇

hadoop存储网页

- 行业动态

- 2025-05-13

- 5

Hadoop用HDFS分布式存储网页,将数据分块(默认128MB/块)并多副本 存储,结合MapReduce框架

Hadoop存储网页的核心技术解析与实践指南

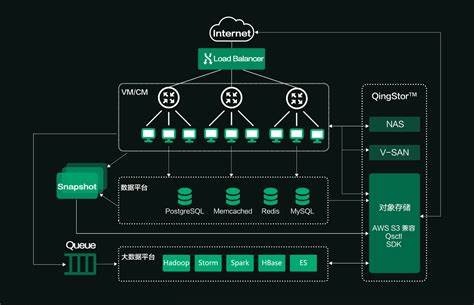

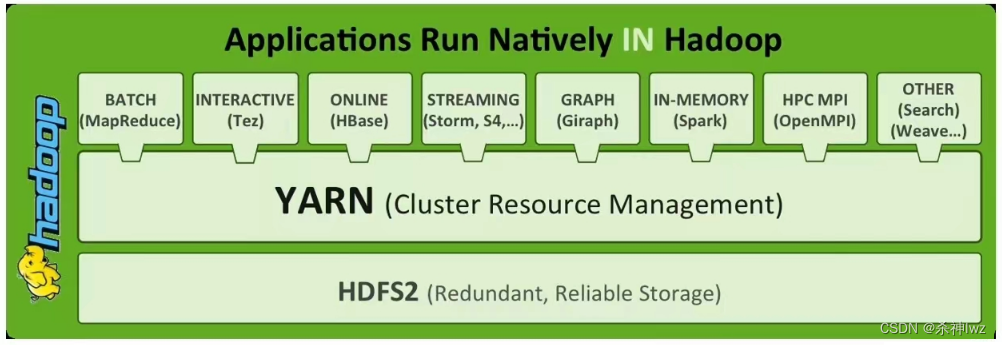

Hadoop存储体系架构

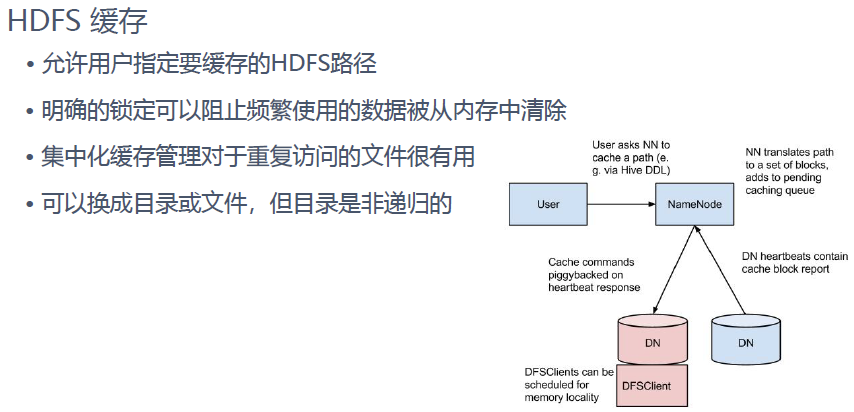

Hadoop作为分布式存储与计算框架,其存储核心由HDFS(Hadoop Distributed File System)实现,HDFS采用主从架构,包含以下关键组件:

| 组件 | 功能描述 |

|---|---|

| NameNode | 元数据管理节点,存储文件目录树及块位置信息,协调客户端访问 |

| DataNode | 数据存储节点,负责实际数据块的存储与读写操作 |

| SecondaryNameNode | 辅助节点,定期合并日志与元数据,减轻NameNode压力 |

| Block | 基础存储单元,默认128MB(可配置),支持数据块冗余存储 |

存储特性:

- 三副本机制:每个数据块默认存储3个副本,分布在不同机架/节点,保障高可用性

- 流式写入:支持TB/PB级大文件顺序写入,优化磁盘IO效率

- 移动计算模式:通过MapReduce将计算任务推送到数据存储节点,减少网络传输

网页存储全流程实现

基于Hadoop的网页存储系统典型架构如下:

网页抓取层 → 数据清洗层 → HDFS存储层 → 索引构建层 → 应用服务层数据采集阶段

- 使用Nutch/Scrapy等爬虫框架抓取网页内容

- 典型配置示例:

<property> <name>http.max.delay</name> <value>15000</value> <!-设置抓取延迟防止被封IP --> </property>

数据预处理

- 格式标准化:将HTML/JS/CSS等多类型内容统一为WARC格式

- 去重处理:基于URL哈希+内容指纹双重校验

- 字段提取:使用Apache Tika解析正文、标题、元数据等关键信息

HDFS存储实现

- 目录结构设计:

/webdata/ ├── domain=example.com/ │ ├── year=2023/ │ │ ├── month=07/ │ │ │ └── day=25/ │ │ │ └── page_hash=abcd1234/ │ │ │ ├── content.warc │ │ │ └── metadata.json - 存储策略:

- 开启HDFS透明加密(

dfs.encryption.enabled=true) - 设置副本策略:重要页面保留3副本,普通内容保留2副本

- 压缩存储:启用Snappy压缩算法(

dfs.block.compress=true)

- 开启HDFS透明加密(

索引构建

- 使用Apache Solr/Elasticsearch建立倒排索引

- MapReduce任务示例:

public class WebIndexBuilder { public static void main(String[] args) { // 输入路径:HDFS中的网页存储目录 // 输出路径:Solr索引存储位置 Job job = Job.getInstance(new Configuration()); job.setJarByClass(WebIndexBuilder.class); job.setMapperClass(HtmlParserMapper.class); job.setReducerClass(IndexMergeReducer.class); job.setOutputKeyClass(Text.class); job.setOutputValueClass(MapWritable.class); FileInputFormat.addInputPath(job, new Path(args[0])); FileOutputFormat.setOutputPath(job, new Path(args[1])); System.exit(job.waitForCompletion(true) ? 0 : 1); } }

性能优化关键技术

针对网页存储特性,需进行多项系统优化:

| 优化维度 | 技术方案 |

|---|---|

| 小文件问题 | 使用SequenceFile/Avro合并小文件 启用HDFS块级缓存( dfs.client.write.packet.delay=100ms) |

| 元数据压力 | 启用Hadoop Federation多NameNode架构 调整 dfs.namenode.fs-limit=1000000参数 |

| 查询延迟 | 构建二级索引(Lily HBase Indexer) 使用Parquet列式存储格式 |

| 存储成本 | 设置自动清理策略(hdfs dfs -setrep -w 1 /archive/old_pages)采用异构存储(SSD+HDD混合部署) |

典型应用场景对比

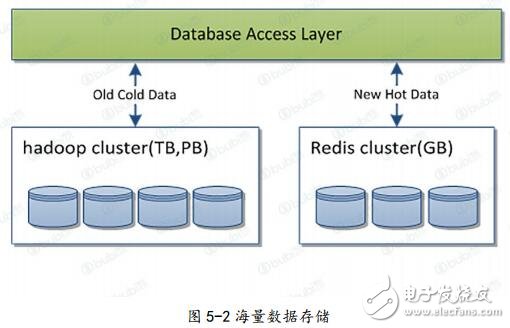

不同业务场景下的存储方案选择:

| 场景类型 | 推荐方案 | 关键参数 |

|---|---|---|

| 搜索引擎 | HDFS+Lucene | 索引刷新周期<5分钟,副本数=3,块大小=64MB |

| 舆情监控 | Kafka+Flume+HDFS | 数据保留周期=30天,消费组并行度=10,压缩格式=LZ4 |

| 网页归档 | HDFS-RAID(EC纠删码) | 编码效率=1.4,容忍丢失2个数据块,存储节省40% |

| 实时分析 | HDFS+Iceberg | 采用快照表,支持时间旅行查询,写入并发=500 |

常见问题与解决方案

Q1:如何处理海量小文件存储?

- 解决方案:

- 使用Hadoop Archive(HAR)打包文件,将10,000个小文件合并为1个归档文件

- 配置

dfs.support.append=false禁用追加写,强制顺序写入 - 采用Erasure Coding编码策略,空间利用率提升至85%以上

Q2:如何保证网页内容的时效性?

- 解决方案:

- 建立版本化存储机制,按时间分区存储(如/2023/07/25/)

- 配置TTL(Time To Live)策略,自动清理过期数据

- 使用Delta Lake实现增量更新,仅同步修改内容

未来技术演进方向

随着存储技术的发展,Hadoop生态正在向以下方向演进:

- 存储引擎升级:逐步支持S3兼容对象存储(通过Hadoop S3a API)

- 计算存储分离:结合Kubernetes实现存算资源独立扩展

- 智能分层:基于机器学习实现冷热数据自动分层(HDFS+对象存储)

- 安全增强:集成Kerberos认证与Ranger权限管理,支持FIPS 140-2加密标准

通过上述技术体系的构建与优化,Hadoop已成为处理PB级网页数据的工业级解决方案,在互联网档案保存、商业搜索引擎、大数据分析等领域发挥着不可替代的作用,实际应用中需根据具体业务需求,在存储成本、查询性能、数据完整性之间取得最佳平衡