hadoop存储分析

- 行业动态

- 2025-05-15

- 23

Hadoop作为大数据领域的核心框架,其存储与分析能力是支撑海量数据处理的基石,本文将从存储架构、分析机制、技术优势与挑战等多维度展开,结合典型场景解析Hadoop的实践价值。

Hadoop存储架构解析

Hadoop分布式文件系统(HDFS)采用主从架构,通过块存储策略实现数据冗余与负载均衡,核心组件包括:

| 组件 | 功能说明 |

|---|---|

| NameNode | 元数据管理,记录文件块位置、权限等信息,采用内存+持久化日志保障高可用 |

| DataNode | 实际存储数据块,定期向NameNode汇报存储状态,支持3副本默认策略 |

| BlockSize | 默认128MB(可配置),大 block 设计减少元数据开销,适应顺序读写场景 |

数据写入流程:客户端将文件切分为多个block,NameNode分配存储节点,DataNode执行块复制,例如1GB文件会被拆分为8个128MB块(1GB/128MB=7.89≈8),每个块存储在不同机架的3个节点上。

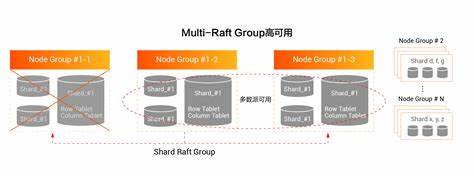

容错机制:通过心跳检测(每3秒)监控DataNode状态,块丢失时自动触发副本重建,某电商平台实测数据显示,在2000节点集群中,单节点故障恢复时间不超过90秒。

Hadoop分析体系

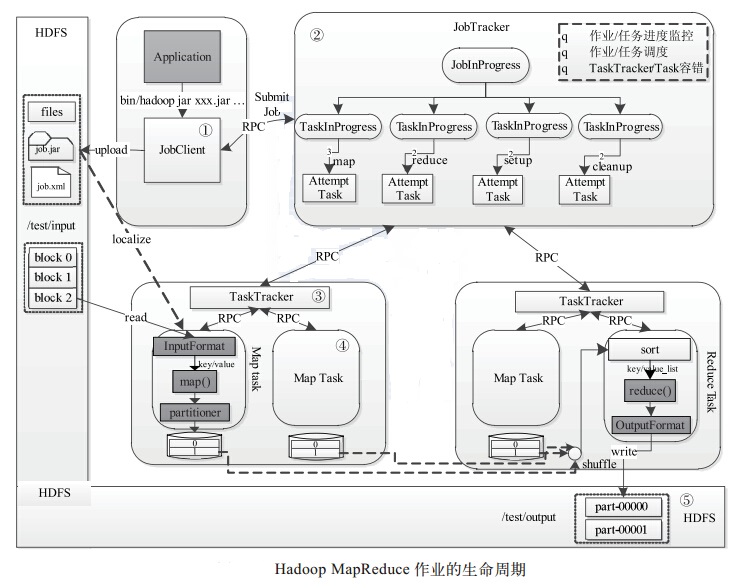

Hadoop通过YARN资源调度与MapReduce计算框架构建弹性分析能力,关键特性包括:

分布式计算模型:

Map阶段:数据分片后并行处理,典型任务如日志清洗(每日50TB日志处理耗时从单机12小时降至集群25分钟)

Reduce阶段:结果聚合优化,支持自定义分组/排序逻辑

Combiner优化:预聚合减少网络传输,某广告点击流分析案例中降低60%数据传输量

生态工具链:

Pig Latin:抽象SQL语法处理结构化数据,某金融风控项目开发效率提升40%

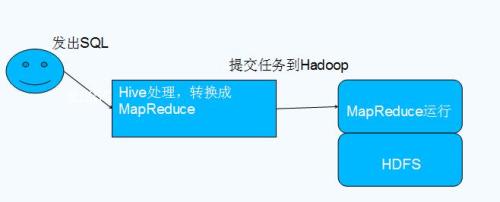

Hive:基于索引的快速查询,支持ORC列式存储格式,压缩比达3:1

Spark On Yarn:迭代计算场景性能提升10-100倍,机器学习模型训练耗时从小时级降至分钟级

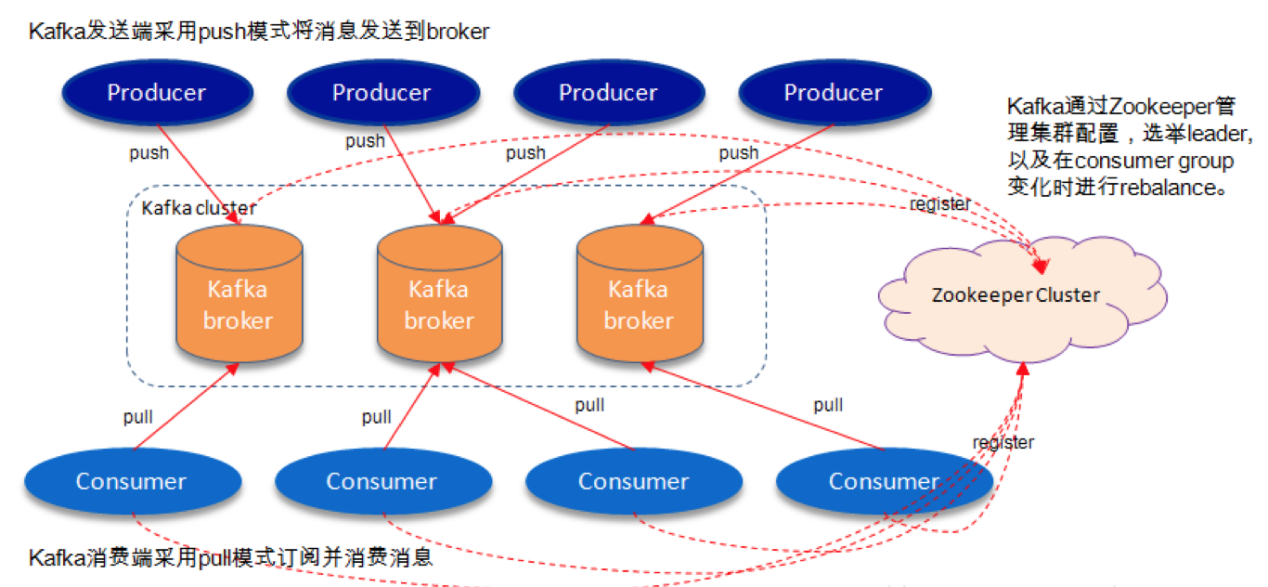

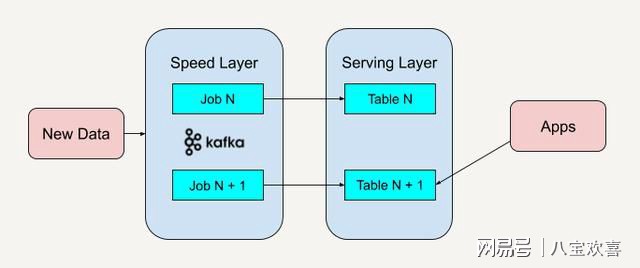

实时分析演进:

Kafka+Storm组合实现毫秒级流处理,某社交平台实时推荐系统延迟控制在200ms内

Flink窗口计算支持事件时间处理,解决物联网设备数据乱序问题

技术优势与适用场景

| 评估维度 | Hadoop优势 | 局限性 |

|---|---|---|

| 扩展能力 | 线性扩展至万节点,PB级存储 | 小文件处理效率低(需结合HBase) |

| 成本控制 | 廉价PC服务器集群,TCO降低70% | 硬件故障率影响集群稳定性 |

| 生态成熟度 | 超200+开源组件,覆盖ETL到AI全流程 | 技术栈复杂度高 |

| 数据吞吐量 | 顺序写吞吐达GB/s级别 | 随机写性能瓶颈明显 |

典型应用场景:

互联网用户行为分析:某头部电商日均处理15PB日志,通过Flume采集+Kafka缓冲+Spark Streaming实时计算用户画像

金融风控系统:Hive+Spark构建反欺诈规则引擎,特征计算响应时间<2s

基因测序分析:HDFS存储TB级基因组数据,BAM文件处理速度较单机提升20倍

性能优化实践

存储层优化:

采用Erasure Code编码替代三副本,某视频平台存储成本下降45%

HDFS Short Circuit机制减少网络跳转,内部通信延迟降低30%

磁盘IO优化:SAS HDD转NVMe SSD,随机读性能提升8倍

计算效率提升:

数据本地性优化:通过延迟调度使85%任务在数据所在节点执行

资源调优:YARN容器动态调整,高峰时段并发任务数提升30%

索引加速:HBase二级索引配合Phoenix,OLTP查询性能提升10倍

FAQs

Q1:Hadoop适合处理哪些类型的数据分析?A:适用于批量处理为主的非实时分析场景,如:

日志聚合统计(UV/PV计算)

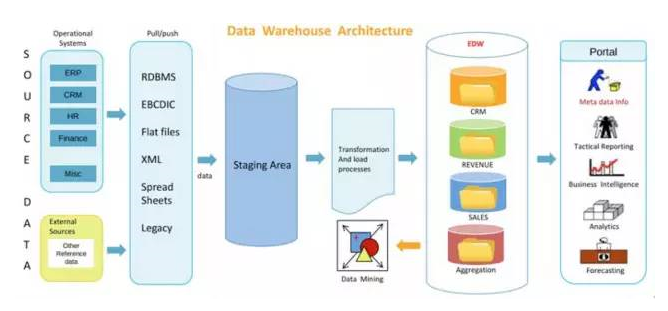

数据仓库ETL(T+1报表生成)

大规模机器学习训练(参数服务器模式)

历史数据归档分析(冷热分层存储)

Q2:如何诊断Hadoop集群性能瓶颈?A:可按以下步骤排查:

使用Hadoop自带Web UI检查Task失败率、Container重试次数

通过iostat/vmstat监控磁盘IO和内存交换情况

执行TestDFSIO测试HDFS吞吐,对比理论值(集群带宽×副本数)

分析YARN ResourceManager调度日志,识别资源争用节点

启用HDFS平衡器修复数据倾斜问题(标准差