上一篇

hadoop存储数据丢失

- 行业动态

- 2025-05-14

- 5

Hadoop采用多副本存储机制,默认3份数据分存不同节点,通过心跳监测节点状态,DataNode故障时NameNode自动触发副本重建,结合HDFS块 存储特性

Hadoop存储数据丢失的原因与解决方案深度解析

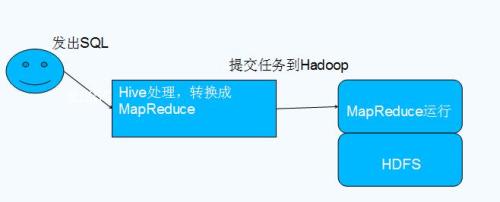

Hadoop作为分布式存储与计算框架,其核心组件HDFS(Hadoop Distributed File System)通过数据块复制机制保障数据可靠性,在实际运行中仍可能因多种原因导致数据丢失,本文将从技术原理、常见场景、解决方案等维度进行系统性分析。

Hadoop存储机制与数据冗余原理

| 核心组件 | 功能说明 |

|---|---|

| NameNode | 管理元数据(文件路径、块位置、副本信息) |

| DataNode | 存储实际数据块并执行副本复制 |

| Block | 默认128MB数据块,默认3副本存储 |

| Replication | 副本因子可配置(默认3),决定数据冗余度 |

数据写入流程:

- 客户端将文件切分为多个Block

- 第一个副本存于第一个DataNode

- 第二个副本存于不同机架的第二个DataNode

- 第三个副本存于同机架第三个DataNode

- NameNode记录元数据并监控副本状态

数据丢失的六大核心原因

硬件故障引发的链式反应

- 典型场景:

- 多个DataNode同时发生硬盘故障

- 机房断电导致RAID阵列失效

- 网络交换机故障引发机架级联失效

- 技术细节:

- HDFS默认3副本策略依赖跨机架存储,若同一机房多个节点故障,可能触发”副本孤岛”效应

- 未启用机架感知(Rack Awareness)策略时,副本可能集中存储在单供电路径下

- 案例:某企业HDFS集群中3个DataNode因UPS故障同时掉电,导致某文件3个副本全部丢失

软件配置错误

- 高危配置项:

| 参数 | 风险说明 |

|———-|————–|

| dfs.replication | 设置为1时无冗余保护 |

| dfs.hosts.exclude | 错误排除合法节点导致存储能力下降 |

| ha.zookeeper.quorum | ZooKeeper配置错误引发NameNode脑裂 | - 特殊场景:

- 修改hdfs-site.xml后未全集群同步配置

- 动态扩容时未正确更新NameNode元数据

人为误操作

- 高频错误类型:

hdfs dfs -rm -r /data误删除目录hdfs namenode -format错误格式化NameNode- 覆盖写入未备份的临时文件

- 防护机制:

- 启用HDFS ACL(访问控制列表)限制删除权限

- 配置审计日志(Audit Log)追踪敏感操作

网络分区与通信故障

- 影响路径:

- Heartbeat信号丢失导致DataNode被标记为Dead

- 客户端写入时与DataNode通信中断

- 跨数据中心同步失败引发版本冲突

- 关键参数:

dfs.heartbeat.interval(默认3秒)dfs.client.block.write.retries(重试次数)

磁盘静默错误与坏块

- 隐患类型:

- 未被SMART检测的突发坏道

- 文件系统元数据损坏(如EXT4的超级块损坏)

- RAID控制器缓存刷写失败

- 诊断工具:

hdfs fsck /path -files -blocks -locationsbadblocks -v /dev/sdX

软件缺陷与版本兼容性

- 历史Bug案例:

- Hadoop 2.7.0版本存在的NameNode内存泄漏问题

- HDFS HA模式下JournalNode数据不一致

- Kerberos认证配置错误导致权限混乱

- 升级风险:

- 滚动升级时版本混用(如2.x与3.x混合)

- 新特性引入的配置变更(如EC纠删码模式)

数据丢失的预防与应急方案

预防性措施矩阵

| 防护层级 | 具体措施 |

|---|---|

| 硬件层 | RAID10阵列 + 热备盘 SSD缓存异常监控 |

| 网络层 | 双上行链路 + BGP路由冗余 NTP时间同步 |

| 系统层 | 开启EC纠删码(6+3策略) 启用CRUSH算法优化存储分布 |

| 应用层 | 客户端本地缓存 + Checkpoint机制 重要数据双集群备份 |

应急恢复流程

graph TD

A[数据丢失发现] --> B{判断类型};

B -->|硬件故障| C[检查SMART状态];

B -->|配置错误| D[回滚配置文件];

B -->|误删除| E[从快照恢复];

B -->|网络故障| F[强制副本均衡];

C --> G[更换故障磁盘];

D --> H[重启受影响服务];

E --> I[验证恢复完整性];

F --> J[触发Balancer];高级容灾方案

- 异地多活架构:

- 部署异步复制到异地数据中心

- 使用QJournal实现NameNode高可用

- 版本化存储:

- 结合HBase实现时间轴查询

- 使用Delta Lake管理数据版本

- 混合云存储:

- AWS S3兼容存储桶作为冷数据层

- Azure Data Lake集成方案

典型故障处理案例分析

案例1:副本不足导致的永久数据丢失

- 故障现象:

hdfs fsck显示某文件缺少2个副本 - 根因分析:

- DataNode1/DataNode2硬盘故障未及时替换

- TaskTracker任务占用磁盘空间导致存储不足

- 解决步骤:

- 执行

hdfs balancer重新分配数据块 - 检查

dfs.datanode.failed.volumes.tolerated参数(默认3) - 清理

/tmp目录下过期任务数据

- 执行

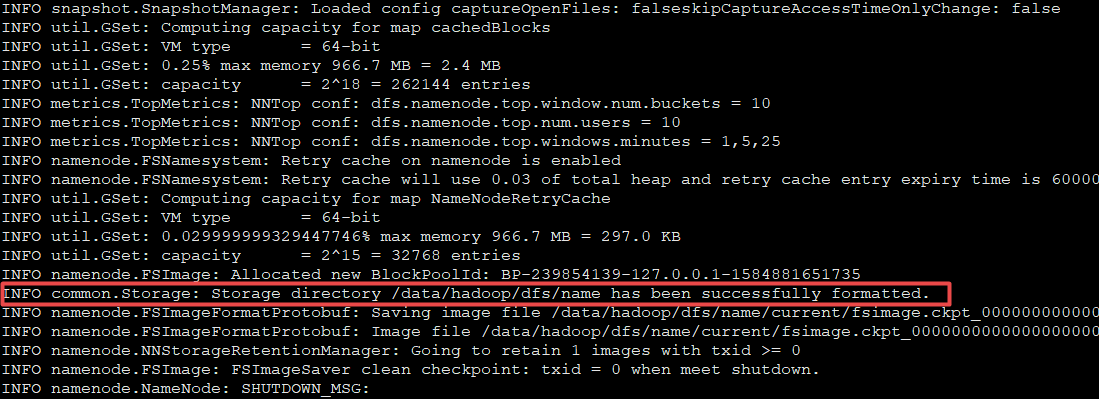

案例2:误格式化NameNode的灾难恢复

- 抢救流程:

- 立即停止所有DataNode写入操作

- 从最近一次BackupNode获取元数据快照

- 启用安全模式(

hdfs dfsadmin -safemode enter) - 对比

version文件确认数据一致性 - 逐步启动各DataNode并执行Recovery

FAQs

Q1:如何检测DataNode的磁盘健康状态?

A:可通过以下组合方案实现:

- 每日执行

smartctl -a /dev/sdX检查SMART属性 - 配置Nagios监控

/hadoop/disk/health目录的I/O延迟 - 启用HDFS的

DataNode.proactive.balance.threshold参数自动迁移老化数据 - 使用

hdparm测试磁盘读写速度基线值

Q2:HDFS的副本因子设置为多少最安全?

A:需根据业务SLA分级配置:

- 核心业务数据:RF=3 + 跨AZ部署

- 温数据:RF=2 + 本地SSD缓存加速

- 日志类数据:RF=1 + 开启EC纠删码(6+3策略)

- 注意:每增加1个副本,存储成本增加