上一篇

hadoop存储配置

- 行业动态

- 2025-05-12

- 3

Hadoop存储基于HDFS架构,核心配置包括数据块大小(默认128MB)、副本数(默认3)、NameNode/DataNode存储路径及高可用配置(如HA模式),需平衡性能

Hadoop存储配置详解

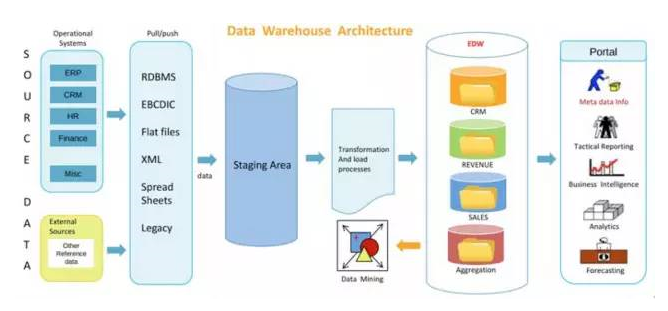

Hadoop分布式文件系统(HDFS)是Hadoop生态的核心组件之一,其存储配置直接影响集群的性能、可靠性和资源利用率,以下从存储架构、核心参数配置、容量规划、磁盘管理、数据均衡与修复、性能优化及安全性等多个维度展开详细说明。

HDFS存储架构

HDFS采用主从架构,包含以下关键角色:

| 组件 | 功能 |

|—————|————————————————————————–|

| NameNode | 管理元数据(文件路径、权限、块位置等),不存储实际数据。 |

| DataNode | 存储实际数据块,定期向NameNode发送心跳和块报告。 |

| Secondary NameNode | 辅助NameNode检查点,不参与实时元数据管理(Hadoop 3.x已弃用)。 |

数据存储流程:

- 客户端将文件切分为固定大小的块(默认128MB)。

- NameNode记录块的元数据(如块ID、副本位置)。

- DataNode按策略存储数据块并维护副本。

核心存储参数配置

HDFS的核心配置集中在hdfs-site.xml文件中,以下是关键参数及其作用:

| 参数 | 默认值 | 作用 | 调优建议 |

|---|---|---|---|

dfs.replication | 3 | 数据块副本数量 | 根据业务可靠性需求调整(如冷存储可降为2,高可用场景保持3)。 |

dfs.blocksize | 128MB | 数据块大小 | 大文件场景可增大(如256MB),小文件合并工具(如Hadoop Archives)更适用。 |

dfs.namenode.name.dir | NameNode元数据存储路径 | 配置多路径(如/data1/name, /data2/name)实现元数据冗余。 | |

dfs.datanode.data.dir | DataNode数据块存储路径 | 配置多路径(如/data/dn1, /data/dn2)分散存储负载。 | |

dfs.hosts | 允许访问HDFS的主机列表 | 通过/etc/hadoop/conf/hosts文件指定,增强安全性。 | |

dfs.permissions.enabled | false | 是否启用HDFS权限控制 | 生产环境建议开启(设为true),配合ACL实现细粒度权限。 |

存储容量规划

单节点存储容量计算:

- DataNode可用空间 = 硬盘总容量 系统保留空间(如日志、临时文件)。

- 典型公式:

[

text{集群总容量} = text{DataNode数量} times text{单节点硬盘容量} times text{副本数} times text{恢复系数}

]

恢复系数:考虑硬盘故障时的数据冗余(通常取1.1~1.2)。

示例:

- 10个DataNode,每节点4TB硬盘,副本数3,恢复系数1.1。

- 总容量 = (10 times 4text{TB} times 3 times 1.1 = 132text{TB})。

磁盘管理与硬件选型

| 场景 | 硬盘类型 | RAID配置 | 适用场景 |

|---|---|---|---|

| 高吞吐量顺序读写 | 7200RPM HDD | RAID-6(或JBOD) | 冷存储、大数据分析 |

| 低延迟随机读写 | SAS SSD/NVMe | JBOD(禁用RAID) | 小文件密集型应用、元数据节点 |

| 混合负载 | SATA SSD + HDD | 分层存储(Hot/Cold) | 需平衡性能与成本的生产环境 |

Hadoop对RAID的支持:

- HDFS本身通过副本机制实现数据冗余,通常不需要RAID。

- 若使用RAID,需关闭HDFS副本(

dfs.replication=1),但会牺牲可靠性。

数据均衡与修复

数据倾斜处理:

- 现象:部分DataNode存储量接近满载,其他节点空闲。

- 解决方案:

- 启用

Balancer工具(命令:hdfs balancer -threshold <百分比>)。 - 手动调整块分布(需停止HDFS服务后移动数据)。

- 启用

数据块修复:

- 缺失块检测:NameNode定期扫描块报告,发现丢失块后触发副本重建。

- 坏盘处理:将故障磁盘标记为不可用(

dfs.hosts.exclude文件),HDFS自动创建新副本。

性能优化策略

| 优化方向 | 参数/方法 |

|---|---|

| 网络带宽 | 启用dfs.datanode.failed.writes.tolerated(允许少量写入失败),减少ACK延迟。 |

| 并发能力 | 调整dfs.client.block.write.locations.timeout(客户端选择块位置的超时时间)。 |

| 短路读取 | 启用shortcircuit.read.enabled(本地客户端直接读取本地DataNode数据)。 |

| 缓存策略 | 配置io.file.buffer.size(增大I/O缓冲区,如8KB→64KB)。 |

安全性配置

Kerberos认证:

- 修改

core-site.xml启用认证:<property> <name>hadoop.security.authentication</name> <value>kerberos</value> </property>

- 配置Keytab文件并同步KDC服务器。

- 修改

透明加密:

- 启用

dfs.encrypt.data.transfer,配合ssl-server.xml配置TLS证书。

- 启用

ACL权限控制:

- 使用

-setfacl命令设置目录/文件的访问控制列表(如限制用户仅读权限)。

- 使用

FAQs

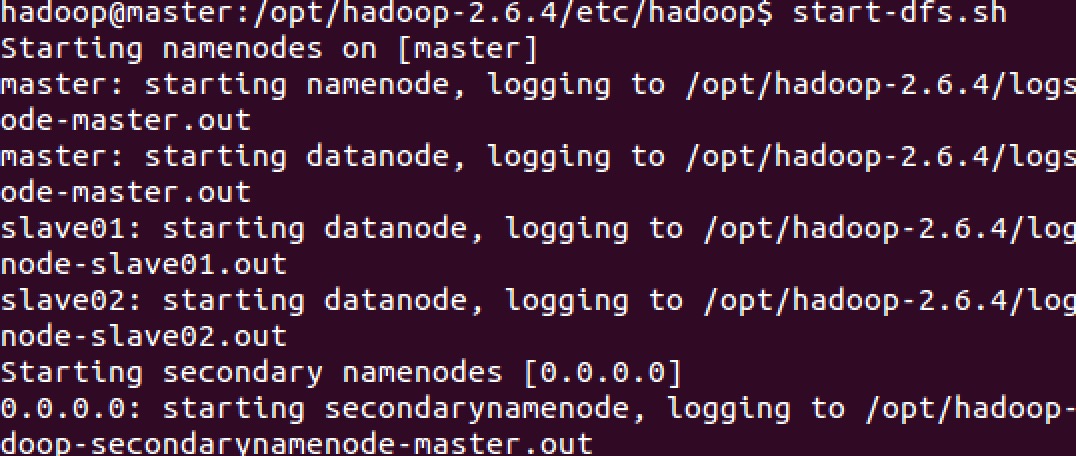

Q1:如何动态增加DataNode节点?

- 步骤:

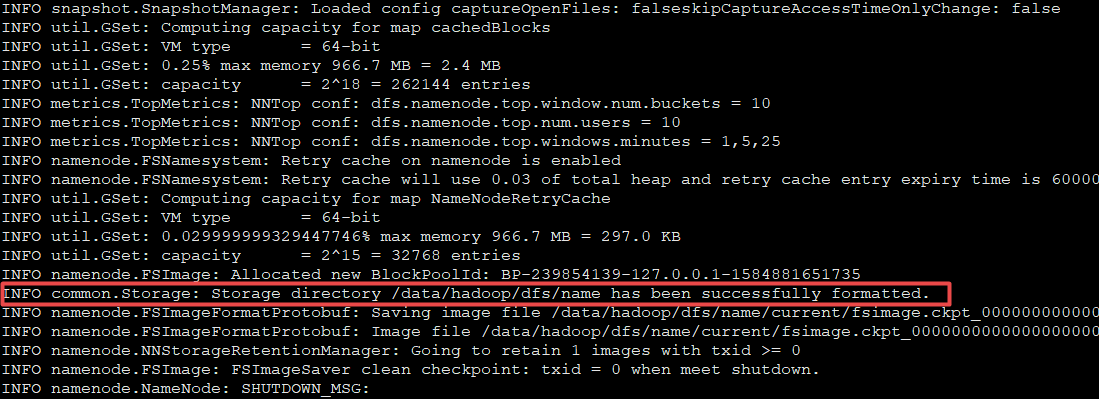

- 在新节点部署Hadoop并配置

dfs.datanode.data.dir。 - 将新节点主机名添加到NameNode的

dfs.hosts文件。 - 执行

hdfs dfsadmin -report查看集群状态,新节点会自动加入。

- 在新节点部署Hadoop并配置

Q2:DataNode磁盘故障后如何恢复?

- 处理流程:

- 将故障磁盘从

dfs.hosts.exclude文件中移除。 - NameNode会自动检测缺失块并触发副本重建。

- 替换故障磁盘后,重启DataNode并执行

hdfs dfsadmin -safemode leave退出

- 将故障磁盘从