上一篇

hadoop历史数据存储

- 行业动态

- 2025-05-08

- 2

Hadoop历史数据存储基于HDFS,以分布式方式保存,通过块存储和副本机制保障高可靠,支持冷热

Hadoop历史数据存储详解

Hadoop存储体系与历史数据特性

Hadoop作为分布式存储与计算框架,其核心组件HDFS(Hadoop Distributed File System)专为大规模数据设计,历史数据通常指不再频繁修改但需要长期保存的数据,例如日志、交易记录、传感器数据等,这类数据具有以下特点:

- 写入一次,读取多次(WORM特性)

- 数据量巨大且持续增长

- 需长期存档并支持合规性审计

- 查询模式以批量分析为主

Hadoop通过HDFS的块存储、副本机制和横向扩展能力,成为历史数据存储的优选方案。

HDFS存储机制与历史数据适配性

| 特性 | HDFS设计目标 | 历史数据需求匹配度 |

|---|---|---|

| 数据规模 | 支持PB级数据横向扩展 | 高(通过新增节点轻松扩容) |

| 存储成本 | 廉价硬件集群部署 | 高(硬件冗余成本低) |

| 数据持久性 | 3副本默认策略(可配置EC纠删码) | 中(需结合外部备份满足强一致性需求) |

| 数据访问模式 | 批处理优化(高吞吐顺序读写) | 高(历史数据以批量分析为主) |

| 元数据管理 | NameNode单点故障风险 | 需通过HA/Federation优化 |

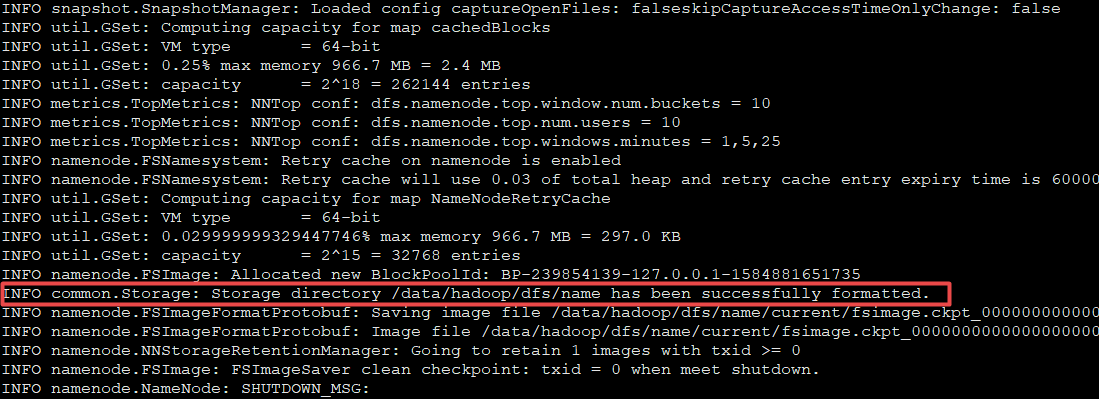

HDFS关键机制:

- 块存储(Block Storage)

数据被切分为固定大小(默认128MB)的块,分散存储在不同节点,支持并行处理。 - 副本机制

每个数据块默认存储3份副本,分布在不同机架内,平衡可靠性与读写性能。 - 追加式写入

支持向文件末尾追加数据(如日志流式写入),但不支持随机修改。

历史数据存储策略与优化

冷热数据分层存储

| 数据类型 | 存储位置 | 优化手段 |

|---|---|---|

| 热数据 | HDFS高频访问层 | 使用SSD缓存、提高副本数 |

| 温数据 | HDFS低频访问层 | 转换为列式存储(如Parquet/ORC) |

| 冷数据 | 低成本存储(如对象存储) | 开启HDFS异构存储支持(如ABTest) |

示例:

电商订单数据中,近3个月数据为热数据(实时分析),3-12个月为温数据(月度报表),1年以上为冷数据(合规存档),可通过Hadoop生态工具(如Apache Oozie)自动迁移冷数据至Amazon S3或HDFS归档目录。

数据压缩与存储格式优化

| 格式 | 压缩率 | 查询性能 | 适用场景 |

|---|---|---|---|

| Text/CSV | 低 | 低 | 临时数据或小规模数据集 |

| Avro | 中 | 中 | 混合型JSON数据存储 |

| Parquet | 高 | 高 | 列式存储(OLAP分析) |

| ORC | 高 | 高 | 列式存储(Hive优化) |

| SequenceFile | 中 | 中 | 二进制日志数据 |

优化建议:

- 对历史数据采用列式存储(Parquet/ORC),压缩比提升30%-50%,且支持谓词下推(Predicate Pushdown)。

- 启用Snappy/Zlib压缩算法,平衡压缩效率与CPU开销。

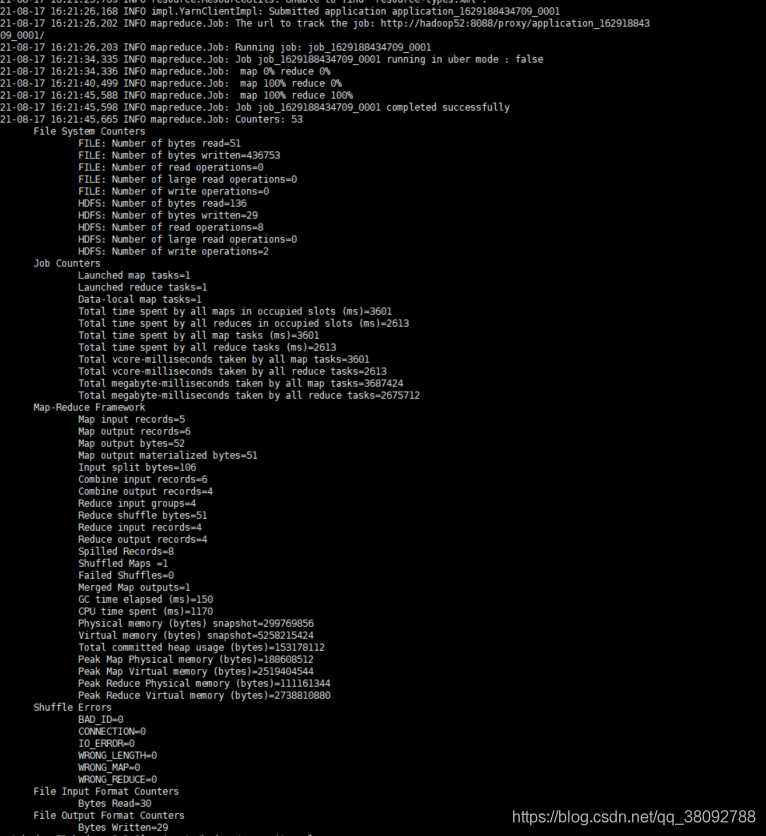

数据生命周期管理

通过Hadoop自带的hdfs dfs -setreplication命令调整副本数,或使用第三方工具(如Lifecycle Manager)实现自动化策略:

- 短期数据:保留3副本,存储于高性能磁盘。

- 中期数据:降低副本数至2,迁移至大容量SATA硬盘。

- 长期数据:副本数降为1,转存至对象存储(如MinIO)或磁带库。

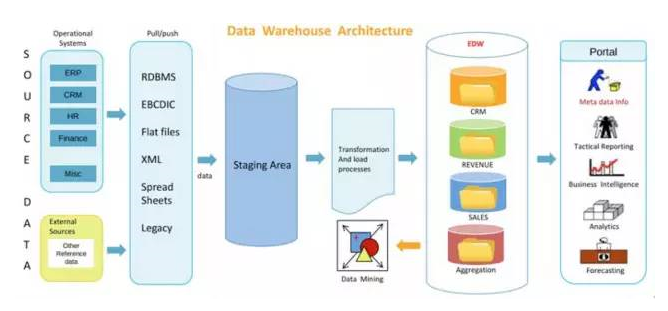

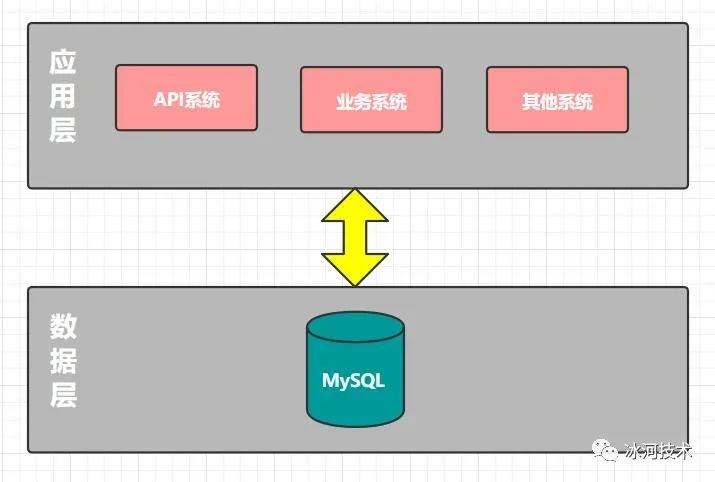

Hadoop与非关系型数据库的协同

| 场景 | Hadoop方案 | 替代方案对比 |

|---|---|---|

| 实时查询 | HBase(随机读写)+ Phoenix | 优于传统关系型数据库的横向扩展能力 |

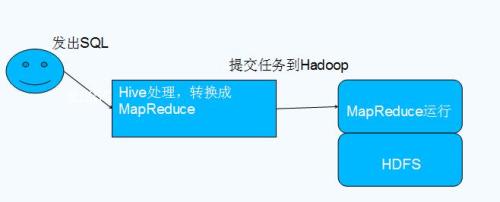

| 复杂分析 | Hive+Tez/Spark | 优于Elasticsearch的批量处理性能 |

| 时序数据 | InfluxDB+HDFS归档 | 优于纯时序数据库的长期存储成本 |

典型架构:

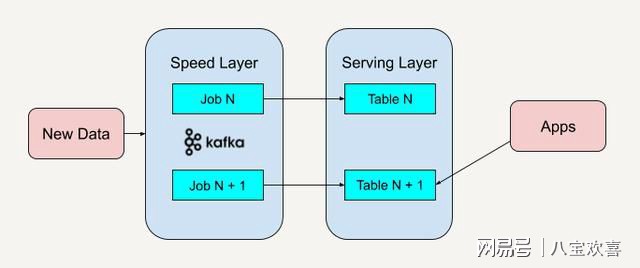

graph TD

A[数据采集] --> B{实时/批处理}

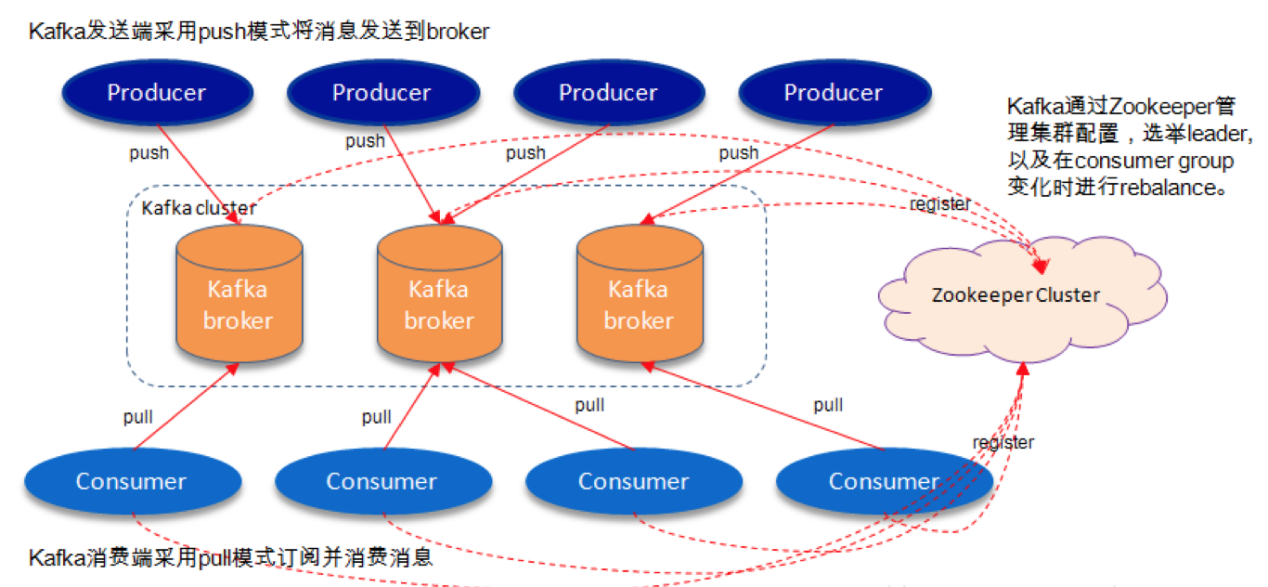

B -->|实时| C[Kafka→HBase]

B -->|批处理| D[HDFS→Hive]

C --> E[在线查询服务]

D --> F[离线分析与BI]

E --> G[Druid/Impala加速]

F --> G企业级实践案例

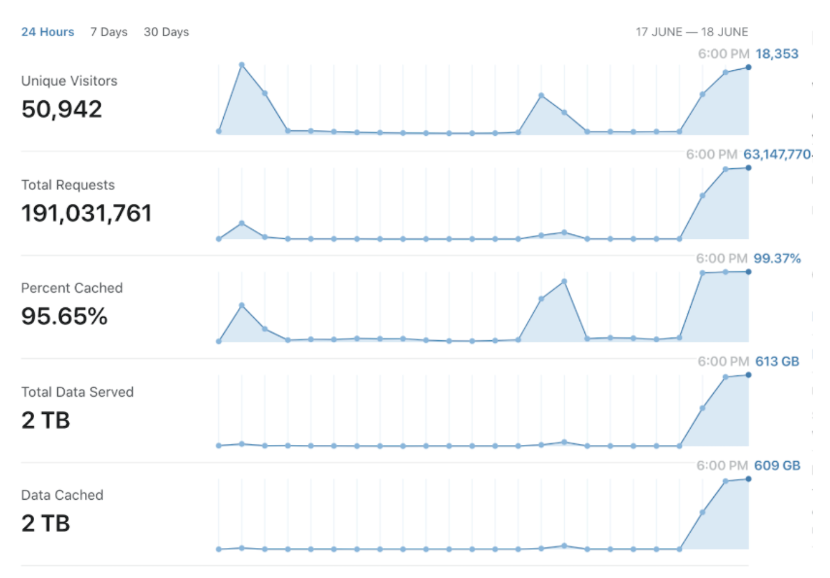

场景:金融交易历史数据存储

- 数据规模:每日新增10TB交易记录,需保存10年。

- 存储方案:

- 热数据:最近1年数据存储于HDFS,采用Parquet格式+Snappy压缩。

- 冷数据:1年以上数据迁移至Amazon S3,通过S3 Select支持按需查询。

- 合规审计:使用HDFS透明加密(TDE)和S3版本控制。

- 成本优化:冷数据存储成本降低60%,查询延迟增加<20%。

FAQs

Q1:Hadoop适合存储哪些类型的历史数据?

A1:

Hadoop最适合以下场景:

- 结构化/半结构化数据:如日志(JSON/AVRO)、时序数据(CSV/Parquet)。

- 大规模静态数据:需长期保存且访问频率低的数据(如档案、备份)。

- 分析型负载:支持复杂SQL(Hive)、机器学习(Spark)和实时查询(HBase)。

Q2:如何平衡HDFS存储成本与查询性能?

A2:

关键策略包括:

- 分层存储:热数据用SSD+高副本,冷数据用机械硬盘+低副本或对象存储。

- 格式优化:采用列式存储(Parquet/ORC)减少IO开销。

- 索引加速:对Hive表启用Bloom过滤器,或使用Impala提升