上一篇

hadoop离线分析视频

- 行业动态

- 2025-05-12

- 2

Hadoop通过HDFS分布式存储视频数据,利用MapReduce框架进行离线分析,实现视频解码、转码、特征提取等任务,其并行计算能力可高效处理海量视频,结合YARN资源调度优化集群利用率,最终输出结构化

Hadoop离线分析视频的核心技术与实践

在大数据时代,视频内容的分析需求日益增长,例如内容审核、推荐系统、广告投放、用户行为分析等场景,Hadoop作为分布式计算框架,凭借其高扩展性和可靠性,成为处理海量视频数据的重要工具,以下是Hadoop离线分析视频的关键技术路径与实践细节。

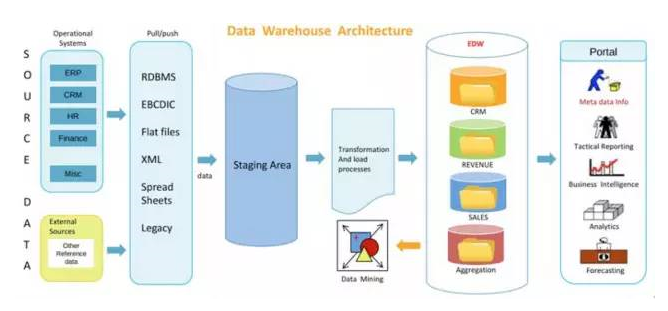

视频数据处理流程

视频分析的核心是将非结构化的视频数据转化为结构化信息,并通过分布式计算完成挖掘,典型流程如下:

| 阶段 | 任务描述 | 关键技术 |

|---|---|---|

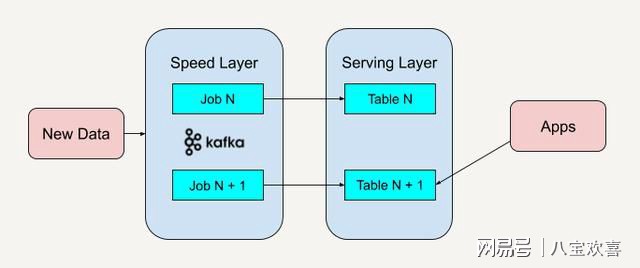

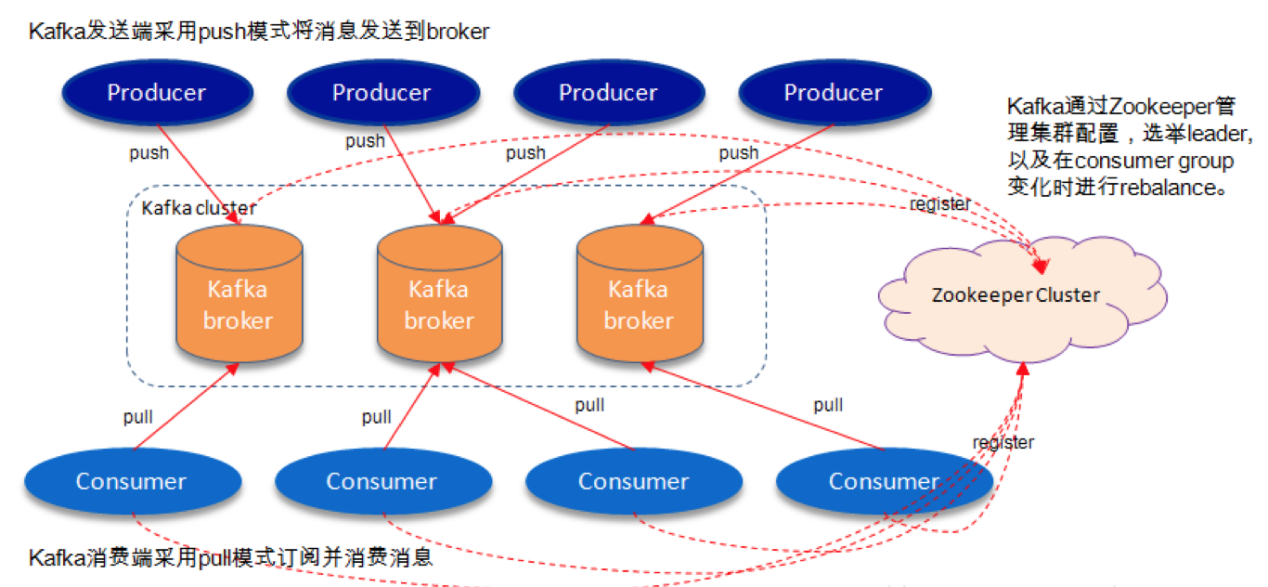

| 数据采集 | 从视频平台、摄像头、用户上传等渠道获取原始视频文件 | Flume、Kafka(实时采集)、HDFS(存储) |

| 数据预处理 | 视频解码、格式转换、分片、抽帧 | FFmpeg(视频处理工具)、MapReduce(分片处理) |

| 特征提取 | 提取关键帧、音频特征、字幕文本、物体检测等 | OpenCV(图像处理)、TensorFlow(AI模型)、Hive(元数据管理) |

| 分布式计算 | 基于Hadoop集群进行批量分析,如内容标签生成、用户观看时长统计 | MapReduce、Spark(迭代计算)、Pig(脚本化处理) |

| 结果存储与应用 | 将分析结果存入数据仓库或推送至下游系统 | HBase(实时查询)、MySQL(关系型存储)、BI工具(可视化) |

Hadoop核心组件在视频分析中的作用

HDFS(分布式文件系统)

- 视频存储:支持TB/PB级视频文件的分块存储(默认128MB/块),通过冗余备份保证数据安全。

- 场景适配:适合存储原始视频、预处理后的抽帧图片、特征数据等。

- 优化策略:启用HDFS的Erasure Coding特性减少存储冗余,或通过分层存储(热/温/冷数据)降低成本。

MapReduce/Spark

- 视频分片处理:将长视频拆分为多个片段并行处理,例如使用Map阶段进行抽帧,Reduce阶段聚合特征。

- 复杂任务示例:

- 统计用户观看行为:通过日志分析计算每个视频的播放量、完播率。

- 内容安全审核:结合AI模型(如YOLO)识别违规画面,标记敏感内容。

- 性能优化:使用Spark替代MapReduce提升迭代任务效率,或通过Tez引擎加速Hive查询。

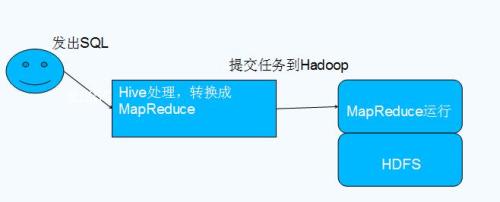

Hive/Impala

- 结构化数据处理:存储视频元数据(如标题、时长、标签)及分析结果(如用户画像表)。

- SQL分析:通过HiveQL执行复杂查询,统计某地区用户对特定品类视频的偏好”。

YARN资源调度

- 动态分配资源:根据任务优先级(如实时分析vs批量处理)调整集群资源。

- 典型配置:为视频转码任务分配更多内存和CPU核心,避免与数据分析任务争抢资源。

视频分析的关键技术实现

结构化

- 抽帧与关键帧提取:使用FFmpeg按固定时间间隔(如1帧/秒)抽取图片,结合OpenCV计算图像相似度,保留关键帧。

- 示例命令:

ffmpeg -i input.mp4 -vf "select=eq(n,0)" -vsync vfr keyframe.jpg # 提取第0帧

- 存储格式:将抽帧后的图片以序列文件(SequenceFile)存入HDFS,方便后续并行处理。

多维度特征提取

- 视觉特征:通过CNN模型(如ResNet)提取物体类别、场景类型(室内/户外)。

- 音频特征:使用MFCC算法提取音频频谱,识别背景音乐或语音内容。

- 文本特征:对字幕或评论进行分词(如结巴分词),生成TF-IDF向量。

分布式计算案例

- 场景:统计某直播平台中每个省份用户对游戏类视频的观看时长。

- 实现步骤:

- Map阶段:读取用户日志(包含用户ID、省份、视频分类、观看时长),按省份分类。

- Reduce阶段:汇总各省的游戏类视频总时长,输出结果。

- 代码片段(伪Java):

public class VideoViewMapReduce { public static void main(String[] args) { // Map逻辑:解析日志并输出<省份, 观看时长> // Reduce逻辑:累加各省时长 } }

性能优化与常见问题解决

数据本地性优化

- 问题:MapReduce任务频繁从远程节点读取视频分片,导致网络IO瓶颈。

- 解决方案:通过HDFS的Block放置策略(如机架感知)确保数据与计算任务同节点执行。

数据倾斜处理

- 场景:某些视频(如热门内容)的日志量远大于普通视频,导致Reduce阶段负载不均。

- 解决方法:

- 自定义分区器(Hash分区或范围分区)。

- 预先对视频ID进行采样,均衡分配任务。

存储成本控制

- 冷数据归档:将历史视频迁移至低成本存储(如AWS Glacier),仅保留元数据索引。

- 压缩策略:对视频分片使用Snappy或Zlib压缩,减少HDFS存储占用。

实际应用案例

短视频推荐系统

- 流程:

- 通过Hadoop分析用户观看历史,生成用户画像(如偏好类目、观看时段)。

- 结合视频内容标签(如搞笑、美食)计算相似度,推送候选列表。

- 技术栈:Spark MLlib(协同过滤)、Hive(存储特征矩阵)。

- 流程:

广告投放优化

- 目标:根据用户观看行为定向投放广告。

- 实现:

- 统计用户对不同广告的跳过率、转化率。

- 通过MapReduce聚类分析高价值用户群体。

FAQs

Q1:Hadoop处理视频分析相比Spark有什么优势?

A1:Hadoop的MapReduce适合高延迟容忍的批量任务(如全量日志分析),而Spark更适合需要迭代计算的场景(如机器学习模型训练),若任务以磁盘IO为主(如视频转码),Hadoop的HDFS可提供更高吞吐量;若以内存计算为主(如实时特征提取),Spark更高效。

Q2:如何处理视频分析中的数据倾斜问题?

A2:可通过以下方法解决:

- 预处理阶段:对视频ID或用户ID进行哈希分桶,分散数据分布。

- Map端合并:在Map阶段对相同Key的数据进行预聚合(Combiner),减少传输量。

- 自定义分区:根据Key的热度动态调整分区数量,例如热门视频分配更多Reduce