hadoop云计算平台在视频转码上的应用

- 行业动态

- 2025-05-10

- 1

Hadoop平台基于分布式架构实现视频并行转码,通过弹性计算资源调度提升处理效率,降低

Hadoop云计算平台在视频转码中的应用解析

视频转码的业务挑战与需求

视频转码是将原始视频转换为不同格式、分辨率或码率的过程,常见于影视制作、在线视频平台、直播服务等场景,随着超高清(4K/8K)、VR/AR内容及短视频爆发式增长,视频转码面临以下核心挑战:

- 计算密集型:转码需解码、重编码、滤镜处理等操作,单任务CPU占用率高,耗时久。

- 海量数据存储:原始视频文件体积大(如1小时4K视频约50GB),转码后需存储多版本文件。

- 高并发需求或直播场景需同时处理成千上万个转码任务。

- 成本控制:传统本地转码集群存在资源浪费(闲时闲置),而云服务需平衡性能与费用。

Hadoop作为分布式云计算平台,通过弹性扩展、高吞吐和低成本存储能力,为视频转码提供了高效解决方案。

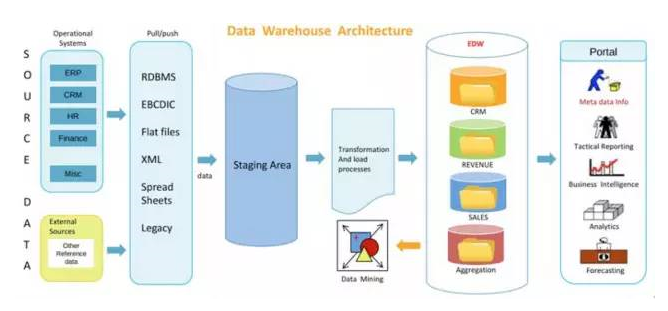

Hadoop平台的核心组件与视频转码适配性

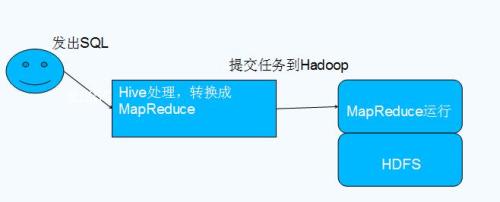

Hadoop生态系统包含HDFS(分布式存储)、YARN(资源调度)、MapReduce(计算框架)等模块,其特性与视频转码需求高度匹配:

| 组件 | 功能与转码适配性 |

|---|---|

| HDFS | 支持TB/PB级视频文件存储,通过块复制机制保障数据可靠性,适合存储原始视频和转码结果。 |

| YARN | 动态分配计算资源(CPU/内存),按需调度转码任务,避免资源争抢。 |

| MapReduce | 将转码任务拆分为多个子任务(如分片转码),并行处理加速整体流程。 |

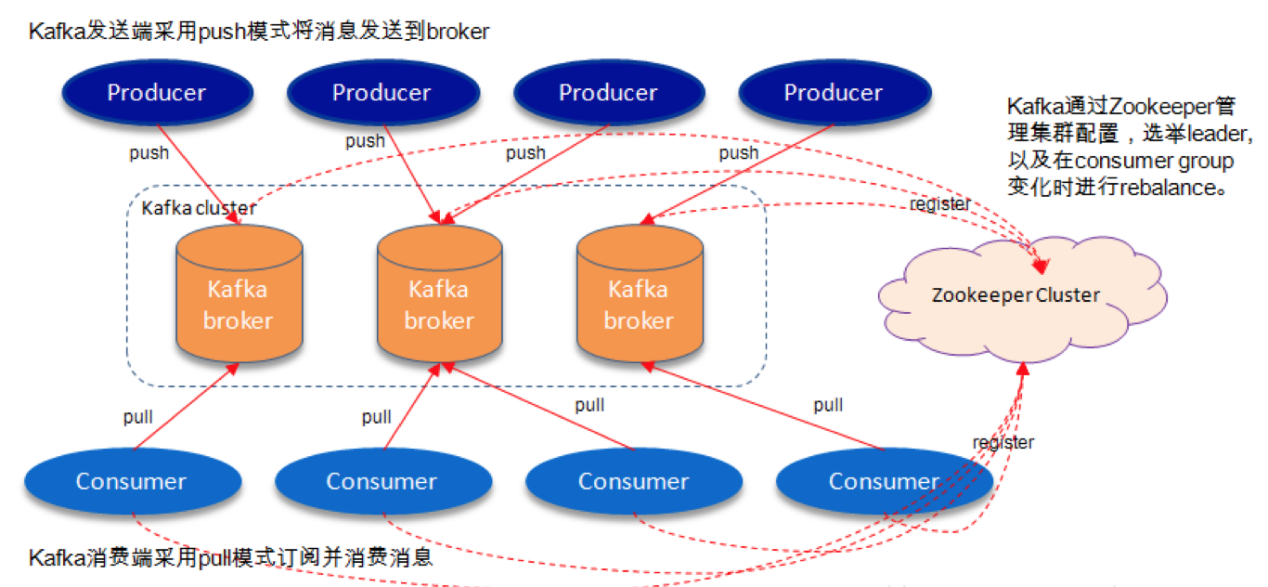

| Zookeeper | 协调分布式任务的状态监控,确保转码失败时自动重启或切换节点。 |

基于Hadoop的视频转码流程设计

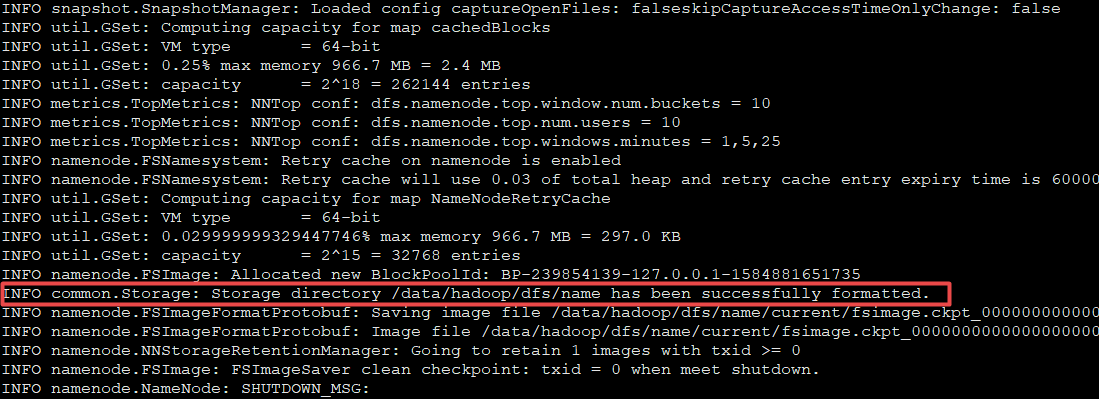

任务提交与切片

- 用户上传视频至HDFS,系统通过Splitter将视频按时间或文件大小切分为多个片段(如每段10分钟)。

- 每个片段作为Map任务输入,分配到不同计算节点。

分布式转码执行

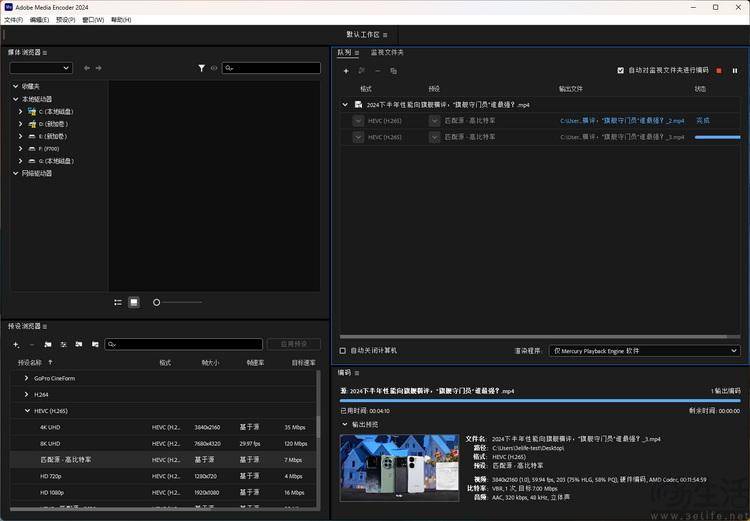

- 节点调用FFmpeg等转码工具处理分片,支持多格式(MP4/AVC、H.265/HEVC)和多分辨率(720p/1080p/4K)转换。

- YARN实时监控节点负载,动态调配空闲资源处理高优先级任务(如付费用户内容)。

结果合并与存储

- 转码后的分片通过Reduce阶段合并为完整视频,输出至HDFS或对象存储(如MinIO)。

- 元数据(码率、分辨率、时长)存入Hive/HBase,便于后续检索和分发。

示例架构图:

用户上传 → HDFS存储 → Splitter切片 → MapReduce转码 → 结果合并 → 存储/分发

↑ ↑

Zookeeper协调 YARN资源调度 Hadoop方案的优势与局限性

优势:

- 弹性扩展:通过YARN动态增减计算节点,应对流量高峰(如电商大促期间的短视频转码)。

- 成本优化:利用闲置服务器资源(如夜间低谷期)处理低优先级任务,降低硬件投入。

- 高可靠性:HDFS三副本存储防止数据丢失,MapReduce任务失败自动重试。

局限性:

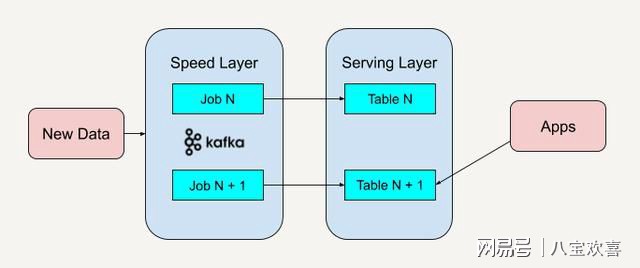

- 实时性不足:MapReduce适合批处理,低延迟场景(如直播实时转码)需结合Flink或Spark Streaming。

- 存储开销:HDFS存储多版本转码文件可能产生高额磁盘成本,需配合生命周期管理策略(如自动清理过期文件)。

实际应用案例与效果

某头部短视频平台采用Hadoop+Kubernetes混合架构:

- 场景:用户上传的1080p视频需转码为480p(低带宽)、720p(标清)、1080p(高清)三个版本。

- 实现:

- 通过自定义Splitter按视频关键帧切片,避免转码缝合瑕疵。

- YARN优先分配GPU节点处理高清转码,CPU节点处理标清任务。

- 成果:转码吞吐量提升3倍,存储成本降低40%(通过压缩算法和去重)。

常见问题与优化方向

Q1:Hadoop转码如何处理超长视频(如2小时电影)?

A1:采用分段转码策略,将视频切分为多个独立片段并行处理,最后通过FFmpeg的concat协议无损合并,避免单任务超时风险。

Q2:如何减少转码后的文件体积?

A2:

- 编码优化:使用H.265替代H.264,相同画质下压缩比提升50%。

- 动态码率调整:根据网络带宽自适应生成不同码率版本(如500kbps/1.5Mbps/4Mbps)。

- 存储层压缩:启用HDFS透明压缩(如LZO/Snappy),减少磁盘IO开销。

Hadoop通过分布式存储与计算能力,显著提升了视频转码的效率和性价比,尤其适合海量异步处理场景,未来可结合边缘计算(如CDN节点转码)和AI智能调度(预测任务优先级),