Hadoop云主机

- 行业动态

- 2025-05-11

- 2

Hadoop云主机基于分布式架构,支持弹性扩展与高可靠存储,集成HDFS、MapReduce等组件,专为大数据处理优化,具备低成本、高并发特性,适用于云端大规模数据分析与计算

Hadoop云主机:技术解析与应用场景全指南

Hadoop云主机的核心概念

Hadoop云主机是指基于云计算环境部署的Hadoop集群节点,通过虚拟化技术将物理服务器资源(CPU、内存、存储)进行池化,为用户提供可弹性扩展的分布式计算能力,其核心价值在于结合Hadoop的分布式存储与计算框架,与云平台的弹性资源管理能力,实现大数据处理的高效性与经济性。

| 特性 | 传统物理机 | Hadoop云主机 |

|---|---|---|

| 资源弹性 | 固定配置,扩容周期长 | 分钟级伸缩,支持自动扩缩容 |

| 运维成本 | 高(硬件采购+运维人力) | 低(按需付费,自动化运维) |

| 网络架构 | 依赖机房网络 | 集成云厂商高速网络(如VPC、RDMA) |

| 数据持久化 | 依赖本地存储 | 支持云存储(如S3、OSS)无缝对接 |

Hadoop云主机的技术架构

- 云平台层

主流云服务商(AWS、Azure、阿里云、Google Cloud)提供底层基础设施,包括:

- 计算资源:EC2(AWS)、VMware虚拟机(Azure)、弹性计算实例(阿里云)

- 存储服务:HDFS兼容对象存储(如S3、Blob Storage)、块存储(如EBS、Disk Storage)

- 网络组件:VPC私有网络、负载均衡、专线接入

- Hadoop生态集成

通过以下方式实现云原生适配:

- 容器化部署:使用Docker封装Hadoop组件,结合Kubernetes实现动态调度(如Apache YARN与K8s集成)

- 托管服务:云厂商提供的EMR(AWS)、HDInsight(Azure)、E-MapReduce(阿里云)等开箱即用服务

- 自定义集群:通过Terraform/Ansible脚本自动化部署Hadoop、Spark、Hive等组件

- 典型架构示例

graph TD A[云主机集群] --> B{HDFS存储} A --> C{YARN资源调度} A --> D[Spark计算引擎] B --> E[云对象存储] C --> F[任务队列] D --> G[数据湖接口] E --> H[冷数据归档] F --> I[动态资源分配] G --> J[BI工具对接]

Hadoop云主机的核心优势

弹性扩展能力

- 支持按需添加/移除节点,应对峰值计算需求(如双十一日志分析)

- 自动缩容闲置资源,节省成本(AWS Spot Instance可降低70%费用)

混合云灾备方案

- 跨区域部署实现异地容灾(如北京+上海双活)

- 结合云存储快照功能,数据恢复RTO<5分钟

多租户隔离机制

- 通过VPC网络划分实现客户数据隔离

- 基于Kerberos的认证体系保障集群安全

成本优化模型

| 成本项 | 优化策略 |

|——————|—————————————|

| 计算资源 | 使用预留实例+Spot实例混合计费 |

| 存储成本 | 热数据用SSD,冷数据转存Glacier |

| 网络带宽 | 启用VPC对等连接减少公网流量 |

典型应用场景与配置建议

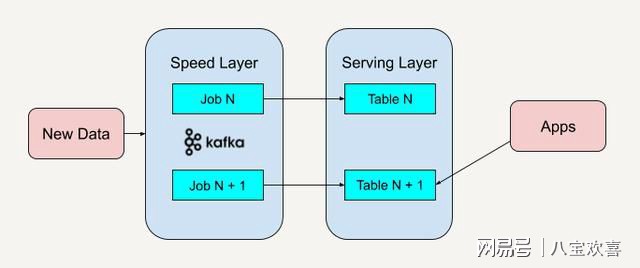

大规模日志分析

- 场景:电商平台每日10TB+访问日志处理

- 配置:

- 节点类型:计算型实例(如AWS C5.xlarge)

- 存储:HDFS三副本+S3冷热分层

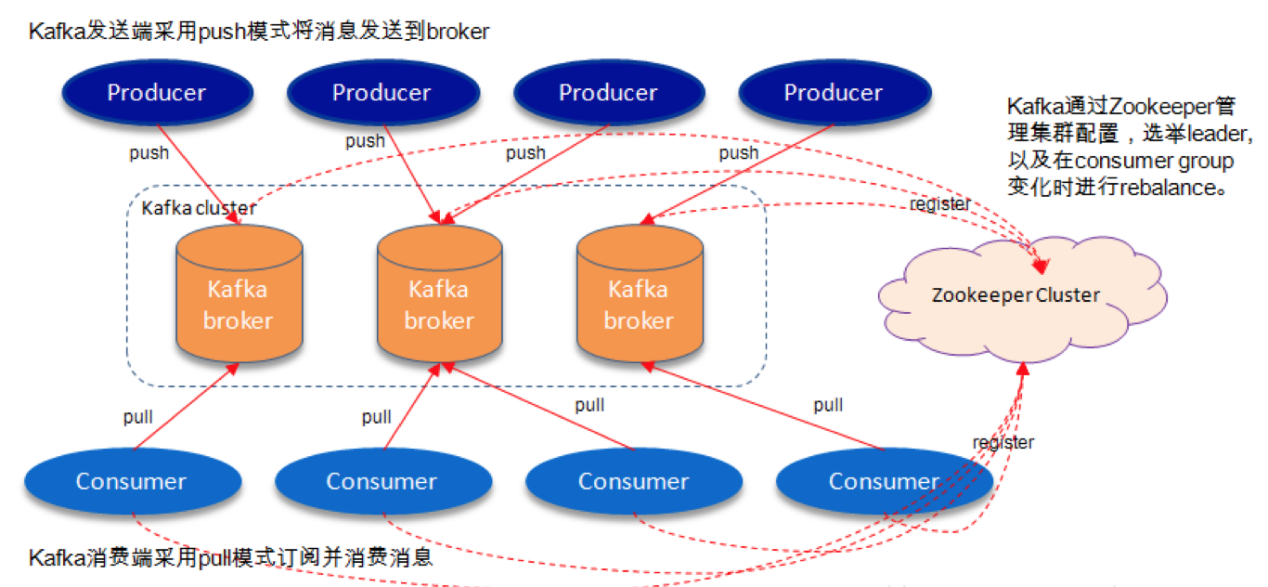

- 工具链:Flume采集→Kafka缓冲→Spark Streaming实时处理

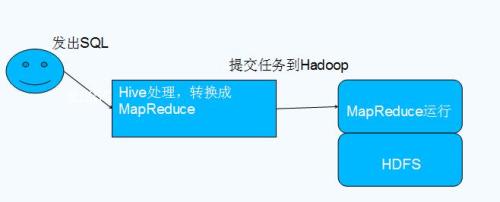

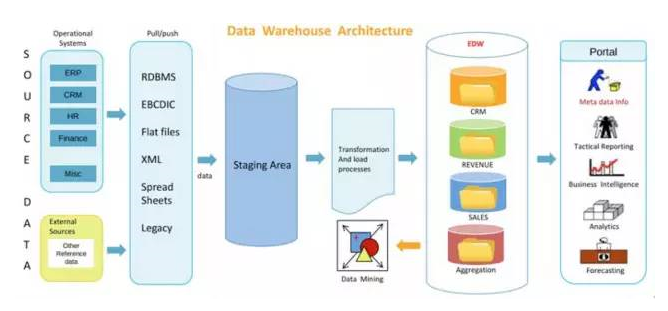

数据仓库加速

- 场景:传统数仓ETL任务耗时过长

- 配置:

- 采用Hadoop+Impala混合架构

- 云厂商专用加速实例(如AWS Graviton3)

- 开启HDFS短路读取(Short Circuit)

AI训练数据预处理

- 场景:图像/文本数据清洗与特征工程

- 配置:

- GPU实例(如Azure NC系列)+ Hadoop分布式缓存

- 集成TensorFlow On Spark框架

- 使用Alluxio加速数据近计算节点存储

性能优化关键策略

存储层优化

- HDFS BlockSize调整:视频流处理设为128MB,基因测序数据设为64KB

- 开启Erasure Coding编码(相比三副本节省50%存储空间)

- 使用云SSD(如AWS Nitro)提升元数据操作性能

计算资源调度

- 动态资源池划分:70%资源给批处理,3%给交互式查询

- 设置YARN Capacity Scheduler队列配额

- 启用Speculative Execution自动重试慢任务

网络调优

- 绑定ENA/RDMA高性能网卡(延迟<10μs)

- 配置TCP窗口缩放(window_scaling=2)

- 启用Hadoop Netty RPC优化(支持HTTP/2)

运维管理工具链

自动化部署

- Terraform模板管理多云环境

- Ansible Playbook实现Hadoop组件配置同步

- Packer制作黄金镜像(含JDK/Hadoop/Spark预装)

监控告警体系

| 监控指标 | 工具选择 |

|——————–|———————————-|

| YARN队列等待时间 | Prometheus+Grafana |

| HDFS可用空间 | Elasticsearch+Kibana |

| JVM垃圾回收频率 | CloudWatch自定义Metrics |日志分析系统

- 集中收集NameNode/DataNode/ResourceManager日志

- 使用ELK Stack进行异常检测(如磁盘IO突降告警)

- 定期生成集群健康报告(CPU利用率/磁盘坏块率)

安全与合规实践

数据加密方案

- 传输层:TLS 1.3加密RPC通信

- 存储层:HDFS透明加密(AES-256)+ SSE-KMS云服务加密

- 密钥管理:集成HashiCorp Vault实现密钥轮换

访问控制体系

- 基于RBAC模型配置用户权限(如HDFS超级用户组)

- 集成AD/LDAP实现企业统一认证

- 启用Hadoop Ranger插件细粒度控制(表级/列级权限)

合规性保障

- GDPR/CCPA数据主权要求:选择区域性云数据中心

- 等保三级审计:开启Hadoop审计日志(Audit Log)并保留180天

- PCI-DSS支付数据保护:禁用HDFS缓存,强制SSL加密

成本控制实战技巧

实例选型策略

- 计算密集型任务:选择高主频实例(如AWS C6g)

- 内存密集型任务:配置大内存实例(如Azure E80ads_v4)

- 长期任务:购买3年期预留实例节省65%费用

存储成本优化

- 生命周期策略:30天后自动将HDFS数据转存至低频存储(如AWS Glacier)

- 压缩算法:启用Snappy压缩减少50%存储空间

- 纠删码替代三副本:存储成本降低40%(需权衡读写性能)

资源复用方案

- 夜间批量任务与日间交互查询错峰运行

- 使用Spot实例处理非关键任务(成本低于On-Demand 90%)

- 集群空闲时释放计算节点,保留核心管理节点

FAQs

Q1:如何选择Hadoop云主机的操作系统?

A:推荐CentOS/Red Hat Enterprise Linux,因其内核参数优化更成熟,需注意:

- 关闭SELinux以避免Hadoop权限问题

- 配置内核参数

vm.max_map_count=262144防止创建文件失败 - 使用NTP服务保证集群时间同步(误差<1ms)

Q2:如何估算Hadoop云主机的所需规模?

A:按以下步骤计算:

- 数据量评估:总数据量×3(HDFS三副本)÷单节点存储容量=最小节点数

- 计算需求测算:任务复杂度×数据规模÷单机处理能力=并发节点数

- 网络带宽验证:聚合流量=节点数×单节点带宽×0.8(冗余系数),需小于云平台VPC带宽上限

建议初期按基准值的120%配置,后续根据监控数据动态调整