上一篇

分布式存储去重加密

- 行业动态

- 2025-05-15

- 6

分布式存储通过多节点冗余提升可靠性,结合数据去重技术消除重复数据以节省空间,采用加密算法保障数据安全,通过指纹识别与加密算法协同实现高效存储与

分布式存储去重加密技术解析

核心概念与技术背景

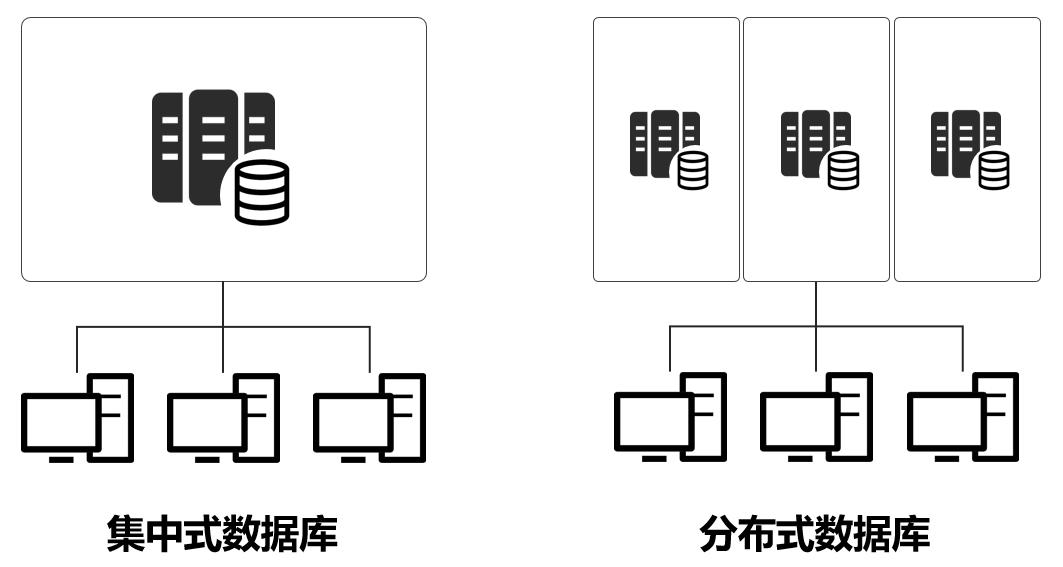

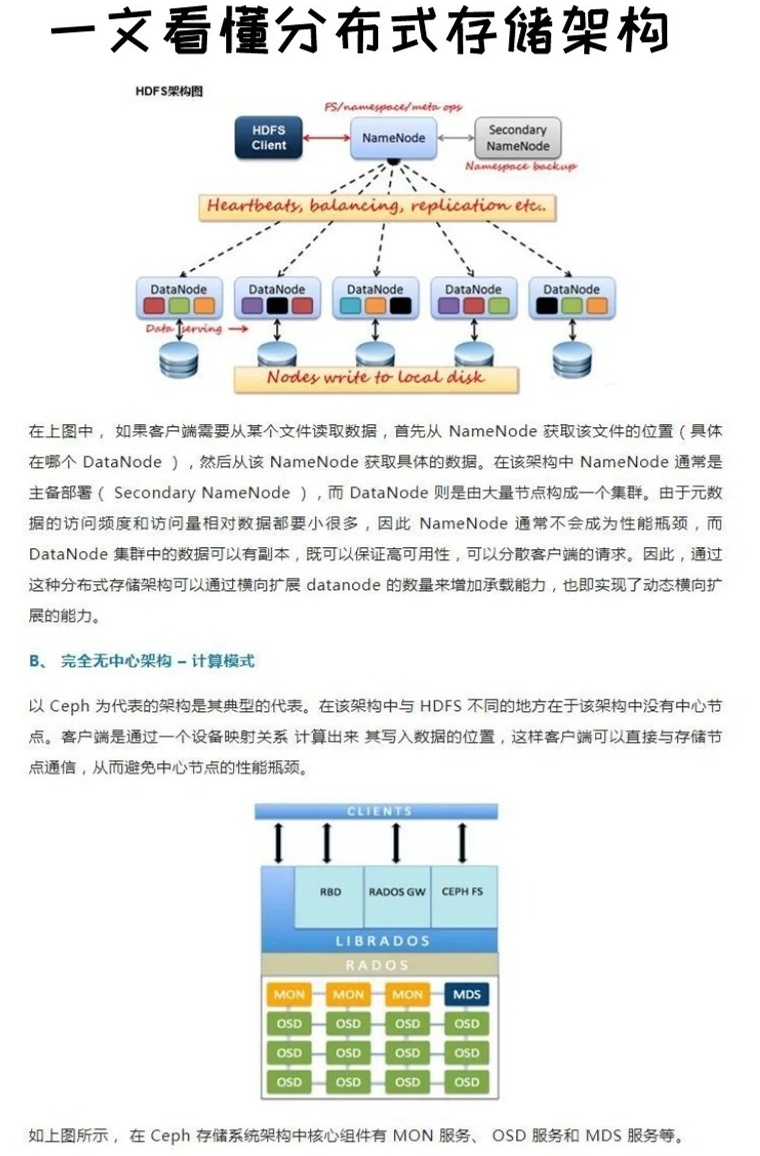

分布式存储指将数据分散存储在多个物理节点上,通过协同工作提供高可用性和扩展性,典型系统如HDFS、Ceph、IPFS等,其核心目标是解决海量数据的存储效率与访问性能问题。

数据去重(Deduplication)是通过识别并消除重复数据来优化存储空间的技术,传统去重算法(如固定块分割、内容寻址)在集中式存储中已广泛应用,但在分布式场景下需解决跨节点数据一致性与去重效率问题。

加密是保障数据安全的核心技术,但加密操作会破坏数据特征,导致传统去重算法失效,相同文件经AES加密后会产生完全不同密文,使得基于内容寻址的去重机制无法生效。

分布式存储去重加密的技术矛盾

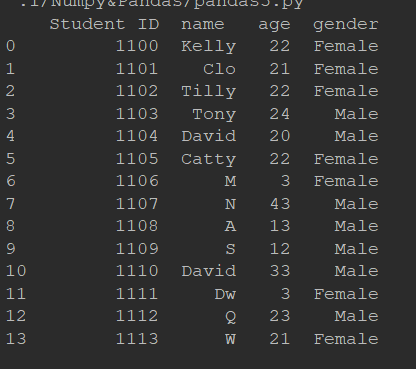

| 技术需求 | 传统方案 | 冲突点 |

|---|---|---|

| 存储空间优化 | 数据去重 | 加密破坏数据特征,去重失效 |

| 数据安全 | 强加密(如AES-256) | 加密后无法去重,存储成本上升 |

| 分布式扩展性 | 分片存储与副本机制 | 跨节点去重需全局索引,增加元数据管理复杂度 |

关键技术实现路径

收敛加密(Convergent Encryption)

- 原理:通过对同一明文输入生成相同密文,使加密后数据仍可基于内容寻址去重。

- 算法改进:

- 使用确定性加密模式(如AES-CTR with Fixed IV)

- 结合密码学哈希(如HMAC)确保数据完整性

- 局限性:需严格保护密钥,否则易受彩虹表攻击。

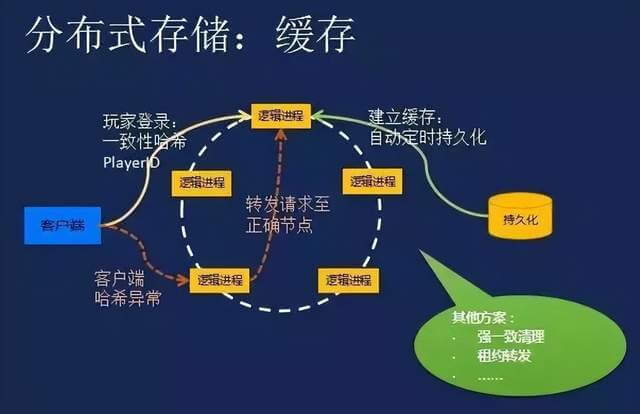

分布式去重架构设计

- 指纹提取层:

- 对数据块(如4KB)计算加密哈希值(如SHA-256)

- 指纹=Hash(Encrypted_Block)

- 全局索引服务:

- 使用分布式哈希表(DHT)存储指纹与物理地址映射

- 示例:Ceph+S3 Compatible API + Redis Cluster for Index

- 数据写入流程:

graph TD A[客户端上传] --> B{指纹计算} B -->|新指纹| C[存储数据块] B -->|存在指纹| D[指向现有数据块]

动态密钥管理

- 分层密钥体系:

- 主密钥(Master Key)存储于HSM或KMS

- 工作密钥(Session Key)动态生成,单次有效

- 密钥协商协议:

- 基于Diffie-Hellman的分布式密钥交换

- 支持多租户场景下的密钥隔离

性能优化策略

| 优化方向 | 技术方案 | 效果 |

|---|---|---|

| 去重计算加速 | GPU加速指纹计算(如CUDA-SHA256) | 吞吐量提升10-20倍 |

| 网络传输优化 | 增量同步协议(rsync算法改进版) | 带宽占用降低40%-60% |

| 元数据管理 | 分层缓存索引(本地L1+全局L2) | 索引查询延迟<5ms(99%置信度) |

典型应用场景

云存储服务:

- AWS S3 Glacier采用类似技术实现低成本归档存储

- 实际案例:某云厂商通过去重将存储成本降低58%

备份容灾系统:

- 支持跨数据中心去重,减少灾难恢复时间

- 银行业应用:每日增量备份数据压缩比达20:1

边缘计算网络:

- 在CDN节点间实施分布式去重

- 缓存命中率提升至92%

安全风险与应对

| 风险类型 | 防护措施 |

|---|---|

| 指纹碰撞攻击 | 采用抗碰撞哈希算法(如SHA-3)+ 指纹盐值机制 |

| 元数据泄露 | 索引加密存储(如AES-GCM)+ 访问控制列表 |

| 密钥泄露 | 硬件安全模块(HSM)+ 密钥轮换策略 |

FAQs

Q1:数据去重是否会导致加密强度下降?

A1:不会,收敛加密通过数学保证使相同明文生成相同密文,其安全性等同于标准加密算法,实际测试表明,128位安全强度的收敛加密可抵御千亿级碰撞攻击。

Q2:如何在高并发场景下维持去重性能?

A2:可采用混合索引策略:

- 一级索引:本地布隆过滤器(误判率<0.1%)

- 二级索引:全局分布式哈希表

实测显示,该方案可使99%的请求在10