上一篇

hadoop存储数据模式

- 行业动态

- 2025-05-14

- 13

Hadoop采用HDFS分布式存储,数据分块,主从架构,多副本冗余保障可靠

Hadoop存储数据模式是一种基于分布式文件系统(HDFS)的存储架构,专为大规模数据处理设计,其核心目标是通过分布式存储和冗余备份实现高吞吐量、高容错能力,以下从存储架构、数据组织方式、读写流程、存储格式等多个维度进行详细解析。

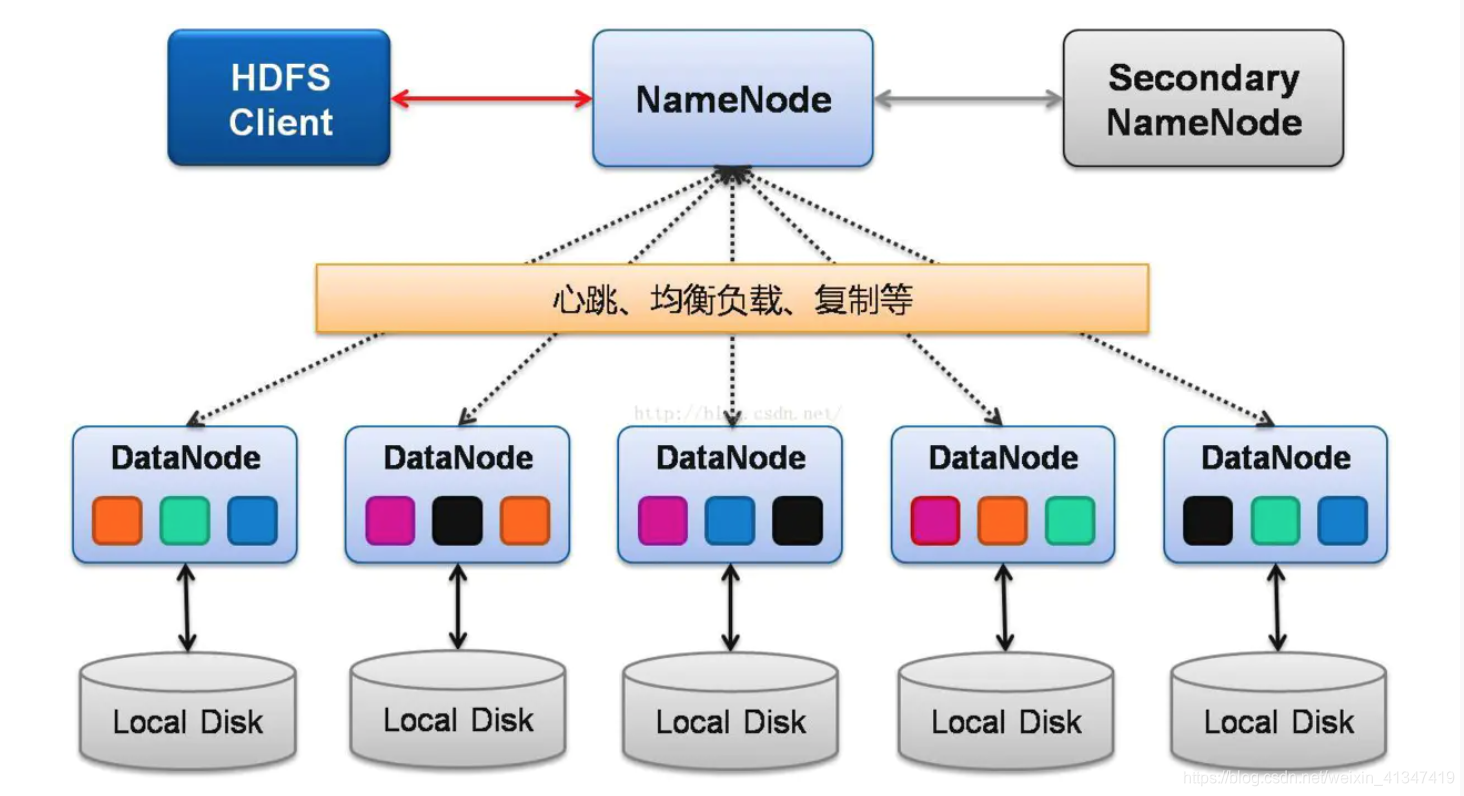

Hadoop存储架构核心组件

Hadoop采用主从架构,存储系统由以下角色构成:

| 组件 | 功能描述 |

|---|---|

| NameNode | 管理文件系统的元数据(如文件路径、权限、块位置等),不存储实际数据。 |

| DataNode | 存储实际数据块,负责数据的读写和副本维护。 |

| SecondaryNameNode | 辅助NameNode进行元数据checkpoint,减轻主节点压力。 |

数据分块机制:

所有文件被拆分为固定大小的块(默认128MB),每个块存储为多个副本(默认3个),分散在不同DataNode上,一个500MB的文件会被分为4个块(128MB+128MB+128MB+16MB),每个块独立存储并冗余备份。

数据存储模式特点

分布式存储与冗余备份

- 数据自动分片并分布到集群中的多个节点,避免单点故障。

- 副本策略:每个数据块有3个副本(可配置),分别存储在不同的机架或节点上,保证高可用性。

流式数据写入

- 支持一次写入、多次读取模式,优化顺序写入性能(写入速度可达GB/秒)。

- 不支持随机修改,文件一旦关闭即不可变(适合批量处理场景)。

数据本地性优化

- Hadoop优先将计算任务分配到存储数据的节点,减少网络传输开销(称为“数据就近处理”)。

元数据集中管理

- NameNode维护文件系统的树状结构和块位置映射,元数据存储在内存中(限制集群规模,通常支持数十万节点)。

数据读写流程详解

写入流程

- 客户端请求:客户端向NameNode请求上传文件。

- 分块与分配:NameNode将文件拆分为多个块,并为每个块分配存储节点列表。

- 数据流水线传输:

- 客户端按顺序将块数据流式传输到第一个DataNode。

- 第一个DataNode接收数据后,边存储边转发给第二个副本节点,依次类推。

- 确认与副本同步:所有副本存储完成后,返回写入成功状态。

读取流程

- 元数据查询:客户端向NameNode查询文件块的位置信息。

- 直接读取:客户端根据返回的块位置列表,直接从最近的DataNode读取数据。

- 多副本并行:若某个块有多个副本,客户端可选择最快路径读取。

存储格式与数据组织

Hadoop支持多种存储格式,不同格式对性能和应用场景有显著影响:

| 存储格式 | 特点 | 适用场景 |

|---|---|---|

| Text | 纯文本,每行一条记录,无结构信息 | 日志处理、简单CSV数据 |

| SequenceFile | 二进制键值对格式,支持压缩 | 中等规模数据,需快速序列化 |

| Avro | 基于Schema的二进制格式,支持嵌套结构 | 复杂数据结构,跨语言交换 |

| Parquet | 列式存储,支持压缩和向量化计算 | OLAP场景,大数据分析 |

| ORC | 优化列式存储,支持复杂类型和索引 | Hive分析,高性能查询 |

数据压缩:

Hadoop支持多种压缩算法(如Gzip、Bzip2、Snappy),可减少存储空间和网络传输开销,Parquet格式结合Snappy压缩可将存储空间降低至原来的1/3。

数据一致性与可靠性

副本同步机制

- 采用链式复制:数据写入时,第一个副本节点存储完成后立即转发给第二个节点,依此类推。

- 心跳检测:DataNode定期向NameNode发送心跳包,报告块存储状态,若超时未响应,NameNode标记节点失效并触发副本重建。

数据一致性模型

- 最终一致性:写操作先更新NameNode元数据,再异步复制到副本节点,短时间内可能存在数据不一致(例如写入后立即读取可能失败)。

- 强一致性保障:通过

hdfs fsck命令可手动检查数据完整性。

故障恢复

- DataNode故障:NameNode检测到节点失效后,自动在其他节点重建丢失的副本。

- NameNode故障:依赖SecondaryNameNode定期备份元数据,快速切换备用节点。

典型应用场景与局限性

优势场景

- 大规模批处理:如日志分析、数据仓库ETL。

- 高吞吐顺序读写:如视频流存储、基因组数据分析。

- 低成本存储:利用普通PC服务器构建分布式存储集群。

局限性

- 低延迟随机读写:不适合MySQL类交易型数据库场景。

- 小文件存储效率低:大量小文件会占用过多NameNode内存(通常建议文件大小≥128MB)。

- 元数据瓶颈:NameNode的内存限制集群容量(可通过联邦HDFS扩展)。

FAQs(常见问题解答)

Q1:Hadoop存储小文件过多会导致什么问题?如何解决?

A1:

- 问题:每个小文件占用一个Block,导致NameNode内存消耗激增(元数据压力),且DataNode存储效率低。

- 解决方案:

- 合并小文件:使用

Hadoop Archives(HAR)或CombineFileInputFormat合并为大文件。 - 改用对象存储:将小文件存入HDFS外部的对象存储系统(如Amazon S3)。

- 合并小文件:使用

Q2:HDFS的数据块大小如何影响性能?

A2:

- 大块(如128MB):减少块数量,降低NameNode负载,适合顺序写入的大文件(如视频、日志)。

- 小块(如64MB):增加并行度,适合小文件或需要高随机读取的场景。

- 建议:根据数据特性和应用需求调整块大小,默认128MB适用于大多数场景。

通过上述设计,Hadoop存储模式在可靠性、扩展性和吞吐量上表现优异,但也需根据具体业务场景权衡其局限性