hadoop存储图片

- 行业动态

- 2025-05-14

- 1

Hadoop通过HDFS实现图片分布式存储,具备高容错与可扩展性,适合海量图片数据管理,支持并行处理与高并发访问,但需考虑

Hadoop存储图片的详细解析与实践指南

Hadoop作为分布式存储与计算框架,在海量数据处理领域占据重要地位,对于图片这类非结构化数据的存储,Hadoop通过HDFS(Hadoop Distributed File System)提供了高可靠、可扩展的解决方案,以下从技术原理、存储策略、优化方法及实际应用场景展开详细分析。

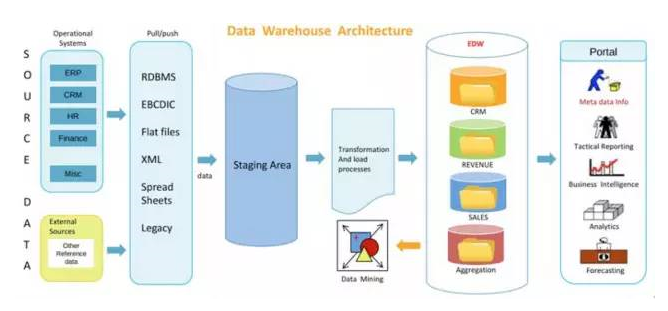

Hadoop存储图片的技术架构

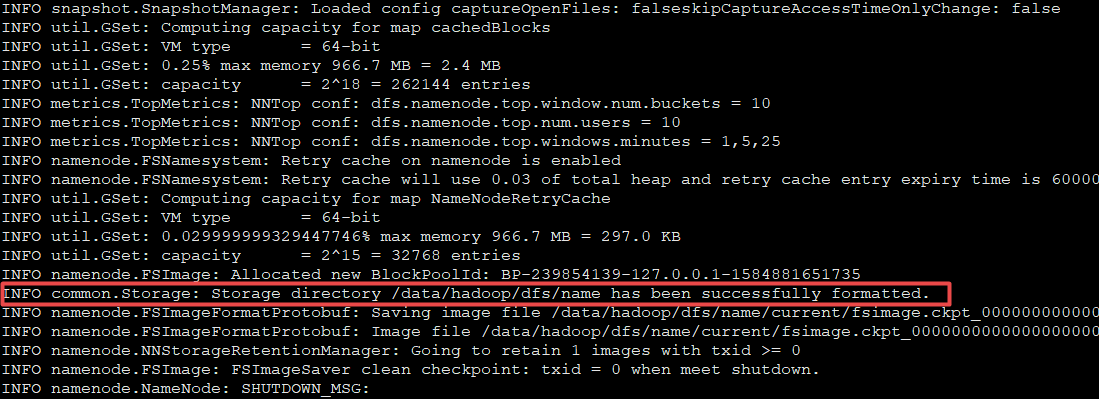

Hadoop存储图片的核心依赖HDFS,其架构特点如下:

| 组件 | 功能描述 |

|—————-|—————————————————————————–|

| NameNode | 管理文件元数据(路径、权限、块位置等),不存储实际数据。 |

| DataNode | 存储图片数据块(Block),默认每块128MB,可配置。 |

| SecondaryNameNode | 辅助NameNode检查点,不参与实际存储。 |

图片存储流程:

- 上传阶段:图片通过客户端分割为多个Block(若图片大小超过块阈值)。

- 分块存储:每个Block被复制到多个DataNode(默认3副本),保证容错性。

- 元数据管理:NameNode记录文件路径、Block位置、副本信息等。

图片存储的关键配置与优化

Hadoop存储图片需针对图片特性(如小文件、高并发访问)进行参数调优。

| 优化方向 | 具体措施 |

|---|---|

| 块大小调整 | 默认128MB的块大小对小图片(如1MB)效率低,可改为64MB或更小(通过dfs.blocksize参数)。 |

| 副本因子 | 根据容错需求调整副本数(dfs.replication),例如冷数据可设为2副本。 |

| 压缩存储 | 启用Block压缩(如LZO、Snappy),减少存储空间和网络传输带宽。 |

| 文件合并 | 对小图片(如缩略图)采用合并存储(如SequenceFile或MapFile格式),降低元数据压力。 |

示例配置(hdfs-site.xml):

<property> <name>dfs.blocksize</name> <value>67108864</value> <!-64MB --> </property> <property> <name>dfs.replication</name> <value>2</value> </property>

Hadoop存储图片的挑战与解决方案

| 问题 | 解决方案 |

|---|---|

| 小文件元数据压力 | 合并小文件为大文件(如每天批量合并); 使用HFile格式存储; 启用HDFS联邦(Federation)分散元数据负载。 |

| 随机读写性能低 | 结合Alluxio(缓存层)加速访问; 预处理图片为固定尺寸,减少动态计算。 |

| 存储成本高 | 采用异构存储(热数据用SSD,冷数据用HDD); 开启EC(纠删码)替代三副本。 |

图片存储格式与预处理建议

格式选择:

- 原始格式:保留高质量(如TIFF、PNG),但占用空间大。

- 压缩格式:JPEG、WebP平衡质量与体积,适合存储。

- 转换建议:上传前统一转换为WebP格式,可减少50%以上存储空间。

元数据设计:

- 自定义属性:

image_type(如头像、商品图)、resolution(分辨率)、tags(标签)。 - 示例路径:

/images/2023/10/01/product_12345.jpg。

- 自定义属性:

Hadoop与其他存储方案对比

| 特性 | Hadoop(HDFS) | 对象存储(如AWS S3) | 传统NAS/SAN |

|---|---|---|---|

| 扩展性 | 横向扩展,支持EB级数据 | 横向扩展,无上限 | 纵向扩展,容量受限 |

| 延迟 | 高(毫秒级) | 低(微秒级) | 低(微秒级) |

| 成本 | 硬件成本低,维护复杂 | 按需付费,运维简单 | 硬件成本高,运维复杂 |

| 适用场景 | 海量图片归档、批处理分析 | 高频访问的图片服务(如CDN) | 低延迟访问的小规模存储 |

实际应用案例

电商平台图片库:

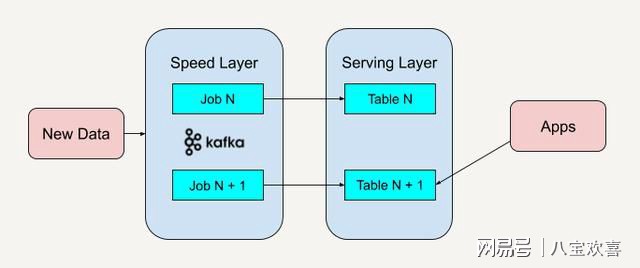

- 场景:存储亿级商品图片,支持高并发访问。

- 方案:HDFS存储原图,结合Alluxio缓存热点数据,使用Spark进行图片特征提取(如去重、分类)。

医疗影像存储:

- 场景:PB级CT/X光片存储,需长期归档。

- 方案:HDFS三副本存储,开启EC纠删码降低存储成本,配合HBase存储元数据(如患者ID、检查时间)。

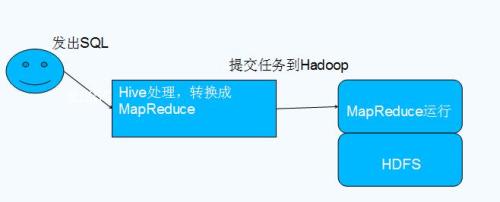

社交媒体图片处理:

- 场景:用户上传图片的存储与智能压缩。

- 方案:HDFS分块存储,Spark Streaming实时压缩(如BMP转JPEG),Hive记录用户操作日志。

常见问题与FAQs

Q1:Hadoop适合实时图片访问吗?

A1:Hadoop的HDFS设计以高吞吐和批处理为主,随机读写延迟较高(通常在百毫秒级),若需低延迟访问,建议:

- 结合Alluxio(内存级缓存)加速热点数据;

- 将实时访问的图片同步至Redis或对象存储(如MinIO)。

Q2:如何处理海量小图片的存储?

A2:小文件(如缩略图)直接存储会导致NameNode元数据压力大,优化方案:

- 合并存储:使用SequenceFile或MapFile将多个小文件合并为一个大文件;

- 分层存储:热数据(近期上传)存入HDFS,冷数据迁移至廉价存储(如JBOD);

- 启用HDFS联邦:通过多个NameSpace分散元数据负载。

Hadoop存储图片的核心优势在于其扩展性、高吞吐和低成本,但需针对小文件、随机访问等场景进行深度优化,通过调整块大小、合并文件、结合缓存系统等手段,可显著提升存储效率,实际部署时需权衡业务需求(如访问频率、数据热度)与技术成本,选择混合存储方案(如HDFS+对象存储)以达到