分布式数据采集系统如何安装

- 行业动态

- 2025-05-08

- 2

分布式数据采集系统安装指南

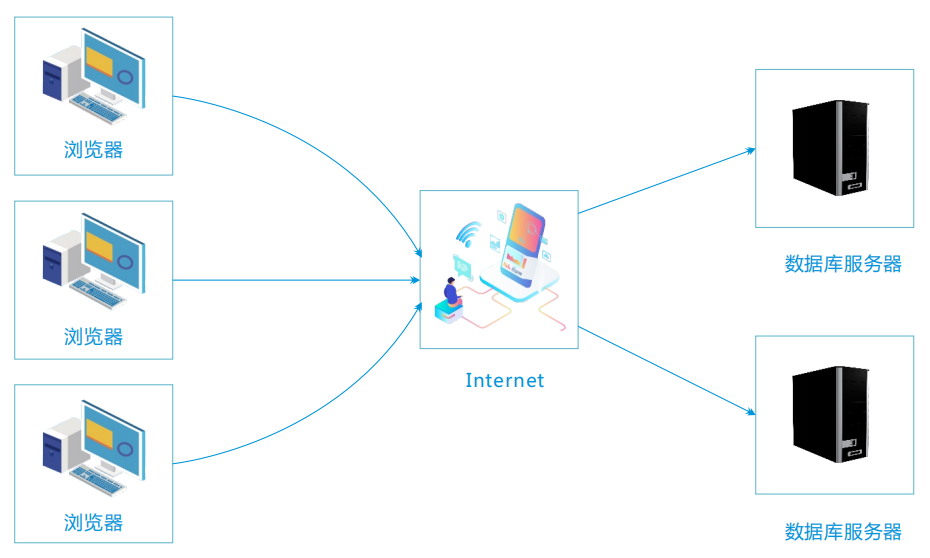

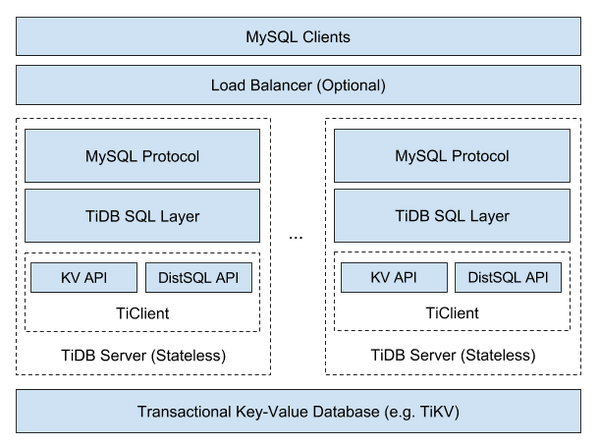

系统架构与组件说明

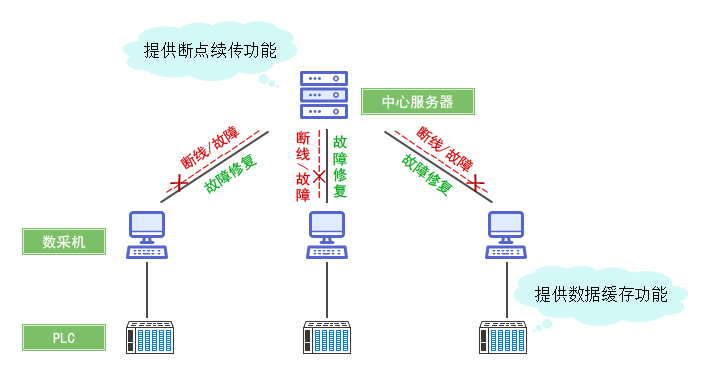

分布式数据采集系统通常由以下核心组件构成:

| 组件类型 | 功能描述 |

|—————–|————————————————————————–|

| 采集节点 | 负责从数据源(传感器、日志、API等)实时采集数据 |

| 消息队列 | 实现数据的异步传输与缓冲(如Kafka、RabbitMQ) |

| 中心服务器 | 数据聚合、清洗、存储调度的核心节点 |

| 数据库集群 | 存储原始数据(如HDFS)和结构化数据(如MySQL/PostgreSQL) |

| 监控模块 | 实时监控系统状态与数据流(如Prometheus+Grafana) |

安装前准备

硬件要求:

- 中心服务器:建议4核CPU/8GB内存/500GB SSD(需运行数据库和消息队列)

- 采集节点:2核CPU/4GB内存/50GB存储(根据并发量调整)

- 网络:各节点需保证<5ms延迟的局域网环境

软件环境:

- 操作系统:CentOS 7.6+/Ubuntu 20.04+(所有节点需一致)

- Java环境:JDK 1.8+(部分组件依赖)

- 时间同步:NTP服务(所有节点时间误差需<1s)

安全准备:

- SSH免密登录:生成RSA密钥对并在各节点配置

authorized_keys - 防火墙策略:开放必要端口(如22、80、443、6379等)

- SSH免密登录:生成RSA密钥对并在各节点配置

安装步骤详解

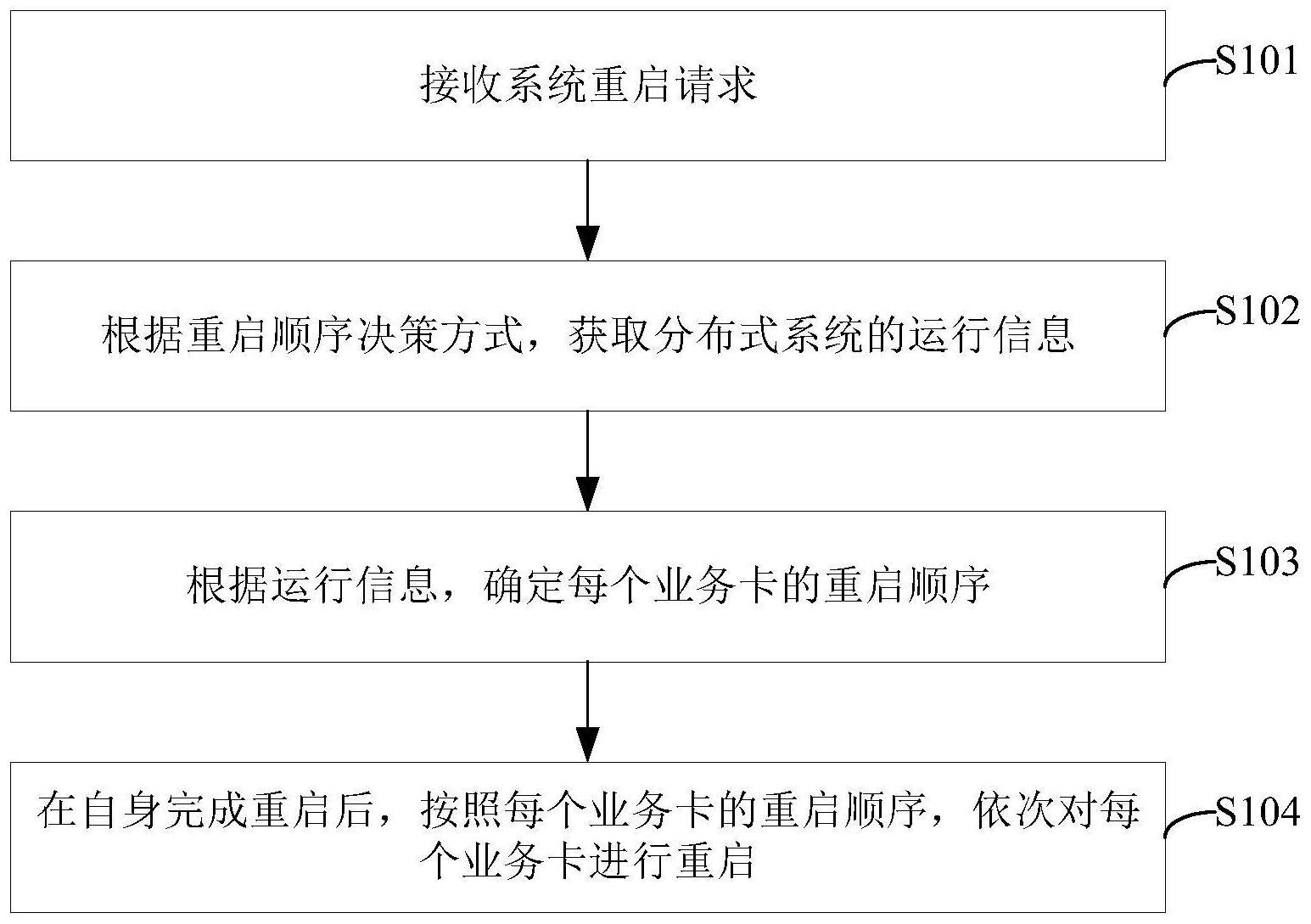

阶段1:中心服务器配置

基础环境搭建:

# 更新系统 yum update -y # 安装必要工具 yum install wget tar vim net-tools -y # 配置主机名解析 echo "192.168.1.100 center.example.com" >> /etc/hosts

数据库部署:

| 数据库类型 | 安装命令 | 初始配置项 |

|—————|——————————————|——————————-|

| MySQL |yum install mariadb-server -y| innodb_buffer_pool_size=4G |

| PostgreSQL |yum install postgresql-server -y| shared_buffers=512MB |

| Redis |yum install redis -y| maxmemory 8gb |

消息队列部署:

# 安装Kafka(示例) wget https://archive.apache.org/dist/kafka/2.8.0/kafka_2.13-2.8.0.tgz tar -xzf kafka_2.13-2.8.0.tgz # 启动ZooKeeper服务 bin/zookeeper-server-start.sh config/zookeeper.properties # 启动Kafka broker bin/kafka-server-start.sh config/server.properties

阶段2:采集节点部署

标准化镜像制作:

# 创建Ansible playbook name: Data collector setup hosts: collector_group tasks: name: Install Python dependencies yum: name=python3-pip state=present name: Deploy collector script copy: src=./collector.py dest=/usr/local/bin/collector.py mode=755 environment: JAVA_HOME: /usr/java/jdk1.8.0_281配置文件同步:

使用rsync将中心服务器的config.json模板推送到各节点:rsync -avz --delete config/ config.json root@192.168.1.101:/etc/collector/

阶段3:服务集成与调试

数据库连接测试:

# collector.py 片段 def test_db_connection(): try: conn = pymysql.connect(host='center.example.com', user='admin', password='secret') print("Database connection successful") except Exception as e: print(f"Connection failed: {e}")消息队列验证:

# 创建测试主题 kafka-topics.sh --create --topic test-topic --bootstrap-server localhost:9092 --partitions 3 --replication-factor 1 # 发送测试消息 echo "test message" | kafka-console-producer.sh --broker-list localhost:9092 --topic test-topic

关键配置参数表

| 组件 | 关键参数 | 推荐值 | 说明 |

|---|---|---|---|

| Kafka | log.retention.hours | 168 | 保留7天数据 |

| MySQL | innodb_flush_log_at_trx_commit | 1 | 平衡性能与数据安全 |

| Collector | batch_size | 1000 | 单次提交消息数 |

| Network | keep_alive_time | 300 | 网络保活时间(秒) |

系统验证流程

连通性测试:

# 从采集节点测试中心服务器连通性 ping -c 5 center.example.com telnet center.example.com 3306 # 测试MySQL端口

数据采集模拟:

# 在采集节点运行测试脚本 def simulate_data(): while True: data = {"timestamp": time.time(), "value": random.randint(0,100)} producer.send('test-topic', json.dumps(data)) time.sleep(1)监控仪表盘配置:

- Prometheus抓取目标配置:

scrape_configs: job_name: 'kafka' static_configs: targets: ['localhost:9092']

- Prometheus抓取目标配置:

常见问题与解决方案

问题1:采集节点频繁出现TimeoutException

解决方案:

- 检查中心服务器防火墙是否开放对应端口

- 调整

collector.json中的timeout参数(建议30-60秒) - 优化网络路由(使用

traceroute诊断)

问题2:消息队列出现积压

解决方案:

- 增加Kafka分区数量(

--partitions参数) - 提升消费者组处理能力(增加采集节点数量)

- 调整

batch_size为500-2000区间测试最佳值

FAQs

Q1: 如何实现采集节点的高可用配置?

A1: 可通过以下方式实现:

- 部署至少3个采集节点组成集群

- 使用Keepalived实现VIP漂移

- 配置消息队列的自动消费组重平衡机制

- 定期执行

kafka-reassign-partitions.sh进行分区再分配

Q2: 遇到数据库写入失败应该如何排查?

A2: 按以下顺序排查:

- 检查网络连通性(

nc -z center.example.com 3306) - 查看数据库磁盘空间(

df -h /var/lib/mysql) - 分析慢查询日志(

tail -n 100 slow.log) - 调整连接池参数(

max_connections建议设置为CPU