上一篇

分布式数据采集系统故障排除

- 行业动态

- 2025-05-07

- 3

分布式数据采集系统故障排除需检查网络连通性、节点状态、数据源配置,确认负载均衡策略,结合日志分析定位异常模块

分布式数据采集系统故障排除指南

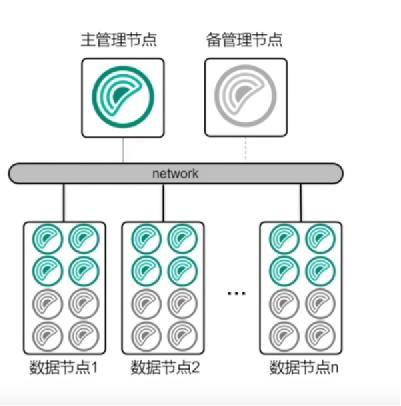

分布式数据采集系统(Distributed Data Collection System, DDCS)是现代大数据架构的核心组件之一,其稳定性直接影响数据质量和业务决策,由于分布式系统的复杂性,故障排查需要系统性的方法,以下从故障分类、排查流程、工具使用及典型案例四个维度展开分析。

故障分类与典型特征

| 故障类型 | 典型表现 | 可能原因 |

|---|---|---|

| 网络通信故障 | 节点失联、数据传输延迟、心跳包丢失 | 网络分区、防火墙阻断、带宽不足、DNS解析失败 |

| 节点硬件/软件故障 | 单节点数据采集中断、CPU/内存资源耗尽、进程崩溃 | 磁盘损坏、内存泄漏、操作系统崩溃、进程异常 |

| 数据一致性问题 | 数据重复、字段缺失、时间戳错乱 | 时钟同步失效、事务冲突、数据清洗逻辑错误 |

| 配置错误 | 任务分发不均、采集规则未生效、数据存储路径错误 | 配置文件版本不一致、动态参数更新失败、权限设置 |

| 负载过载 | 队列积压、任务延迟、系统响应变慢 | 流量突发、资源分配不合理、并发限制过低 |

故障排查流程

日志分析

- 优先级:从系统日志、应用日志、网络日志入手,定位首次异常时间点。

- 关键日志:

- System Log:检查

/var/log/syslog(Linux)或系统事件查看器(Windows)。 - Application Log:查看采集Agent(如Flume、Logstash)的输出日志。

- Network Log:通过

tcpdump或Wireshark捕获网络包,分析TCP重传、超时等异常。

- System Log:检查

- 示例:若日志中出现

Connection reset by peer,可能是网络中断或防火墙拦截。

网络诊断

- 连通性测试:

- 使用

ping测试节点间基础连通性。 - 通过

telnet或nc检查端口开放状态(如Agent监听的端口)。

- 使用

- 链路质量检测:

traceroute追踪数据包路径,识别丢包或延迟过高的节点。iperf测试带宽和延迟,判断是否因网络拥塞导致传输失败。

- 防火墙规则:检查

iptables或云平台安全组规则,确保必要端口开放。

- 连通性测试:

节点状态检查

- 资源监控:

- 通过

top、htop或free命令查看CPU、内存使用率。 - 使用

df -h检查磁盘剩余空间,避免因存储不足导致写入失败。

- 通过

- 进程管理:

- 确认采集Agent(如Beats、Fluentd)是否正常运行。

- 检查进程是否被OOM Killer终止(通过

dmesg查看内核日志)。

- 容器化环境:若基于Docker/K8s,需检查Pod状态、资源配额及健康探针配置。

- 资源监控:

数据一致性验证

- 时间戳对齐:使用

ntpq -p检查NTP服务状态,确保各节点时钟同步(误差<10ms)。 - 数据去重:通过

awk或Python脚本统计字段唯一值,识别重复数据。 - 字段完整性:抽样对比原始数据与入库数据,检查关键字段(如ID、时间戳)是否缺失。

- 时间戳对齐:使用

配置复核

- 版本一致性:检查各节点配置文件(如

config.yaml)是否为同一版本。 - 动态参数:验证环境变量(如

DATABASE_URL)、密钥(如Kafka的SASL认证)是否正确。 - 权限校验:测试Agent对目标存储(如HDFS、Elasticsearch)的读写权限。

- 版本一致性:检查各节点配置文件(如

常用工具与命令

| 场景 | 工具/命令 |

|---|---|

| 日志实时监控 | tail -f /var/log/app.log 或 less +F |

| 网络抓包分析 | Wireshark、tcpdump -i eth0 port 5044(捕获Flume端口数据包) |

| 进程资源消耗 | ps -ef | grep fluentd + jstack PID(分析Java进程线程状态) |

| 分布式追踪 | Jaeger、Zipkin(集成到Agent中) |

| 配置差异对比 | diff config_node1.yaml config_node2.yaml |

| 数据一致性检查 | redis-cli MONITOR(监控Redis队列) + elasticsearch-sql(查询ES数据) |

典型案例分析

案例1:网络分区导致数据丢失

- 现象:部分节点数据未写入Kafka,日志显示

TimeoutException: failed to send record。 - 排查步骤:

ping目标Broker节点,发现间歇性丢包。traceroute发现中间路由节点存在高延迟。- 调整Kafka客户端

retries=5并启用acks=all,确保数据可靠投递。

- 根因:网络抖动导致RPC超时,未充分重试。

案例2:单节点磁盘满触发采集中断

- 现象:Agent进程频繁重启,日志提示

Disk is full。 - 排查步骤:

df -h发现/data/logs目录已用100%。- 清理过期日志(

find /data/logs -type f -mtime +7 -exec rm {} ;)。 - 配置

logrotate自动压缩归档旧日志。

- 根因:存储空间未扩容,且无日志清理策略。

预防性措施

- 监控体系:部署Prometheus+Grafana监控节点资源、网络延迟、队列长度。

- 冗余设计:采用Kafka/RabbitMQ等消息队列缓冲数据,避免单点故障。

- 自动化测试:使用Chaos Engineering工具(如ChaosBlade)模拟网络分区、节点宕机。

- 配置管理:通过Ansible/Puppet统一分发配置文件,减少人为错误。

FAQs

Q1:如何防止分布式数据采集中的“数据孤岛”问题?

A1:需确保以下几点:

- 所有节点使用统一的时间源(NTP/PTP)。

- 消息队列(如Kafka)设置合理的

retention.ms,避免数据过期。 - 定期执行跨节点数据对账(如通过UUID或哈希校验)。

Q2:节点频繁重启如何定位根本原因?

A2:建议分步排查:

- 检查系统日志(如

/var/log/kern.log)是否存在OOM或内核崩溃。 - 分析Agent进程崩溃前的线程堆栈(

gdb或jstack)。 - 验证依赖库版本兼容性(如glibc、OpenSSL)。

- 启用核心转储(

ulimit -c unlimited)生成Core Dump文件