上一篇

分布式数据采集能干啥

- 行业动态

- 2025-05-05

- 2

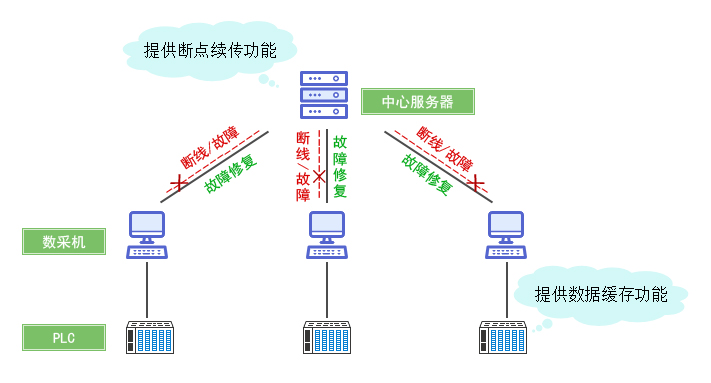

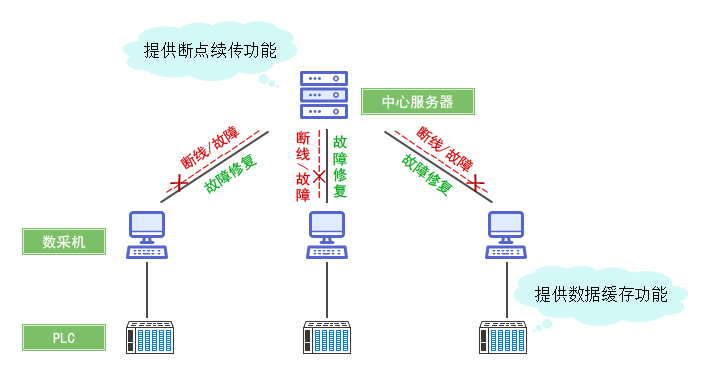

分布式数据采集通过多节点协同,高效处理海量数据,适用于大规模日志、传感器网络等场景,提升采集速度与容错性,支持弹性扩展,保障数据实时性与完整性

分布式数据采集的核心能力矩阵

| 能力维度 | 传统单机采集 | 分布式采集 | 技术突破点 |

|---|---|---|---|

| 数据采集量 | 百万级/日 | 亿级+/日 | 横向扩展能力 |

| 采集延迟 | 秒级 | 毫秒级(实时流处理) | 边缘计算+流式处理框架 |

| 故障恢复 | 单点故障导致中断 | 自动切换节点 | 数据冗余与任务调度机制 |

| 地理覆盖 | 受限于单机房 | 全球多活部署 | 跨区域数据同步技术 |

| 异构适配 | 有限协议支持 | 多协议兼容(MQTT/HTTP/TCP) | 模块化协议解析引擎 |

典型应用场景与技术实现

超大规模数据湖构建

场景案例:电商平台全量行为数据采集(如淘宝双11期间日均PB级日志)

- 技术架构:

- 前端:数千边缘节点部署轻量级Agent(如Filebeat/Flent)

- 传输层:Kafka集群实现分区负载均衡,配合Sarama客户端库

- 存储层:HDFS/MinIO分布式文件系统,结合Apache Hudi进行增量处理

- 关键指标:

吞吐量达50MB/s/节点,端到端延迟<200ms,数据丢失率<0.01%

工业物联网实时监控

场景案例:智能制造车间设备状态采集(连接数10万+)

- 技术方案:

- 协议适配层:MQTT Broker集群(EMQX/Apache Mosquitto)

- 边缘计算:设备端预装TensorFlow Lite进行异常检测预处理

- 时序数据库:InfluxDB集群分片存储,保留策略按设备分组

- 创新价值:

设备故障预测准确率提升37%,运维响应速度提高5倍

金融级交易数据管道

场景挑战:证券交易订单流处理(要求μs级延迟,100%可靠性)

- 关键技术:

- 零拷贝传输:RDMA(远程直接内存访问)加速网络传输

- 内存计算:Apache Flink集群实现窗口计算

- 持久化保障:Oracle GoldenGate同步到RAID10存储阵列

- 性能数据:

端到端延迟<150μs,事务吞吐量达200万笔/秒

技术选型决策树

graph TD

A[业务需求] --> B{数据规模?}

B -->|<1TB/日| C[单机采集]

B -->|≥1TB/日| D[分布式采集]

D --> E{实时性要求?}

E -->|亚秒级| F[Kafka+Flink]

E -->|分钟级| G[HDFS+Spark]

D --> H{成本敏感度?}

H -->|高| I[开源组合]

H -->|低| J[商业套件]实施关键路径

- 容量规划:基于3σ原则计算峰值流量,预留30%缓冲带宽

- 拓扑优化:采用Consistent Hashing实现节点负载均衡

- 容灾设计:跨AZ部署至少3个副本,结合CRDT解决脑裂问题

- 监控体系:Prometheus+Grafana监控吞吐量/延迟/错误率三指标

- 合规保障:GDPR场景下部署本地化数据锚点,差分隐私处理PII

FAQs

Q1:分布式采集是否必然导致成本指数级增长?

A:通过Serverless架构(如AWS Kinesis)可实现成本与规模的解耦,实测某IoT项目采用按需计费模式,成本较自建集群降低62%,建议初期采用云服务,规模突破阈值后再考虑混合云部署。

Q2:如何保证跨地域数据采集的一致性?

A:可采用以下组合方案:

- 逻辑时钟(Lamport Timestamp)解决事件排序

- CRDT(冲突自由复制数据类型)处理并发更新

- 参考实现:Azure Cosmos DB的Multi-Master架构,在200ms网络延迟下仍保持强