上一篇

如何高效配置GPU服务器环境?

- 行业动态

- 2025-05-07

- 4

本教程详细讲解GPU服务器环境配置流程,包括驱动安装、CUDA/cuDNN部署、深度学习框架搭建等核心步骤,提供多版本组件适配方案及环境验证方法,适用于TensorFlow/PyTorch等主流框架的加速环境搭建,附常见问题解决方案。

准备工作

在开始配置GPU服务器环境前,确保以下条件已满足:

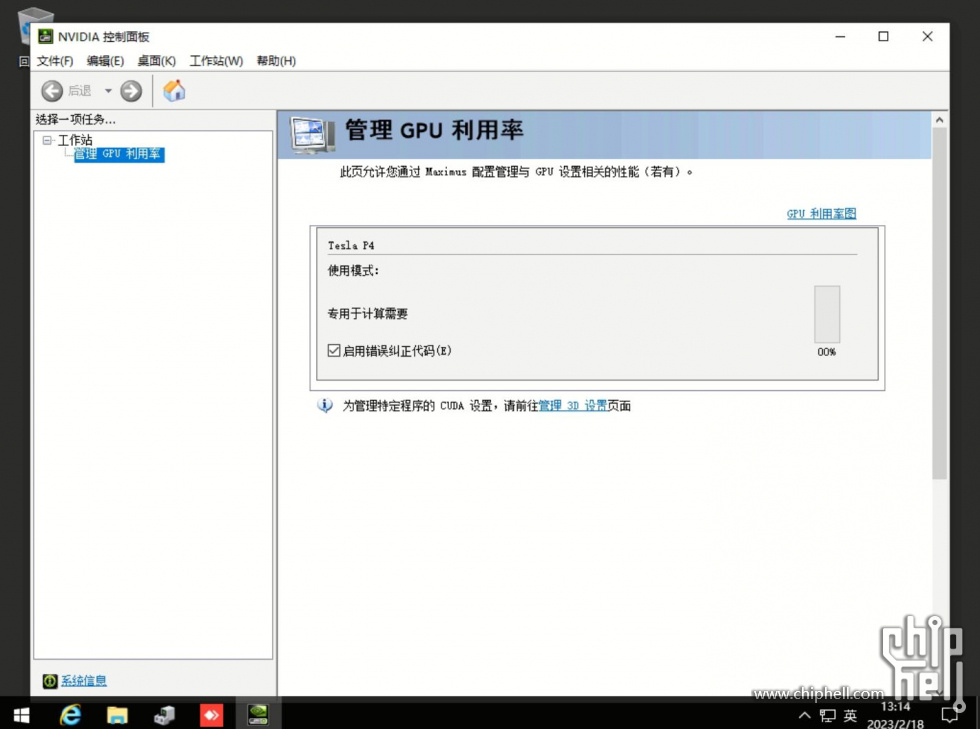

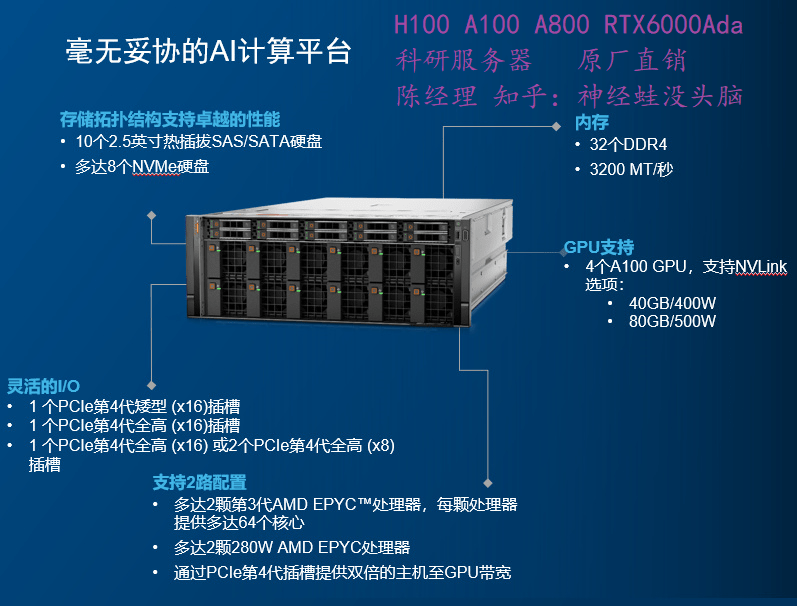

- 硬件要求:支持CUDA的NVIDIA显卡(如Tesla、RTX系列)。

- 操作系统:推荐Ubuntu 20.04/22.04 LTS或CentOS 7/8(本文以Ubuntu 22.04为例)。

- 网络环境:稳定的网络连接,用于下载驱动及依赖包。

安装系统与更新

# 更新系统软件包 sudo apt update && sudo apt upgrade -y # 安装基础工具 sudo apt install -y build-essential cmake g++ gcc make

安装NVIDIA显卡驱动

步骤1:禁用默认驱动

# 禁用nouveau驱动 sudo bash -c "echo 'blacklist nouveau' >> /etc/modprobe.d/blacklist-nouveau.conf" sudo bash -c "echo 'options nouveau modeset=0' >> /etc/modprobe.d/blacklist-nouveau.conf" sudo update-initramfs -u sudo reboot # 重启生效

步骤2:安装官方驱动

方法一(推荐):通过官方PPA仓库安装

sudo add-apt-repository ppa:graphics-drivers/ppa sudo apt update ubuntu-drivers devices # 查看推荐驱动版本 sudo apt install -y nvidia-driver-535 # 以535版本为例 sudo reboot

方法二:手动下载驱动(适用于内网环境)

- 访问NVIDIA驱动下载页面,选择对应显卡型号和系统版本。

- 上传驱动文件(如

NVIDIA-Linux-x86_64-535.86.05.run),执行:sudo chmod +x NVIDIA-Linux-x86_64-*.run sudo ./NVIDIA-Linux-x86_64-*.run

验证驱动安装

nvidia-smi # 若显示GPU信息,则成功

安装CUDA Toolkit

步骤1:下载CUDA安装包

- 访问CUDA下载页面,选择与驱动兼容的版本(如CUDA 12.2)。

- 根据系统版本选择安装命令(例如Ubuntu 22.04):

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2204/x86_64/cuda-ubuntu2204.pin sudo mv cuda-ubuntu2204.pin /etc/apt/preferences.d/cuda-repository-pin-600 wget https://developer.download.nvidia.com/compute/cuda/12.2.2/local_installers/cuda-repo-ubuntu2204-12-2-local_12.2.2-535.104.05-1_amd64.deb sudo dpkg -i cuda-repo-ubuntu2204-12-2-local_*.deb sudo cp /var/cuda-repo-ubuntu2204-12-2-local/cuda-*-keyring.gpg /usr/share/keyrings/ sudo apt update sudo apt install -y cuda

步骤2:配置环境变量

echo 'export PATH=/usr/local/cuda/bin:$PATH' >> ~/.bashrc echo 'export LD_LIBRARY_PATH=/usr/local/cuda/lib64:$LD_LIBRARY_PATH' >> ~/.bashrc source ~/.bashrc

验证CUDA安装

nvcc --version # 查看CUDA编译器版本

安装cuDNN库

步骤1:下载cuDNN

- 访问NVIDIA cuDNN页面(需注册账号)。

- 选择与CUDA版本匹配的cuDNN(如CUDA 12.x对应cuDNN 8.9.x)。

步骤2:安装并配置

# 解压文件并复制到CUDA目录 sudo tar -xzvf cudnn-linux-x86_64-8.9.4.25_cuda12-archive.tar.xz sudo cp cudnn-*-archive/include/cudnn*.h /usr/local/cuda/include sudo cp -P cudnn-*-archive/lib/libcudnn* /usr/local/cuda/lib64 sudo chmod a+r /usr/local/cuda/include/cudnn*.h /usr/local/cuda/lib64/libcudnn*

配置深度学习框架环境

使用Conda管理环境

# 安装Miniconda wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh bash Miniconda3-latest-Linux-x86_64.sh # 创建并激活虚拟环境 conda create -n dl_env python=3.9 conda activate dl_env # 安装PyTorch(需匹配CUDA版本) conda install pytorch torchvision torchaudio pytorch-cuda=12.1 -c pytorch -c nvidia # 安装TensorFlow pip install tensorflow[and-cuda]==2.12.0

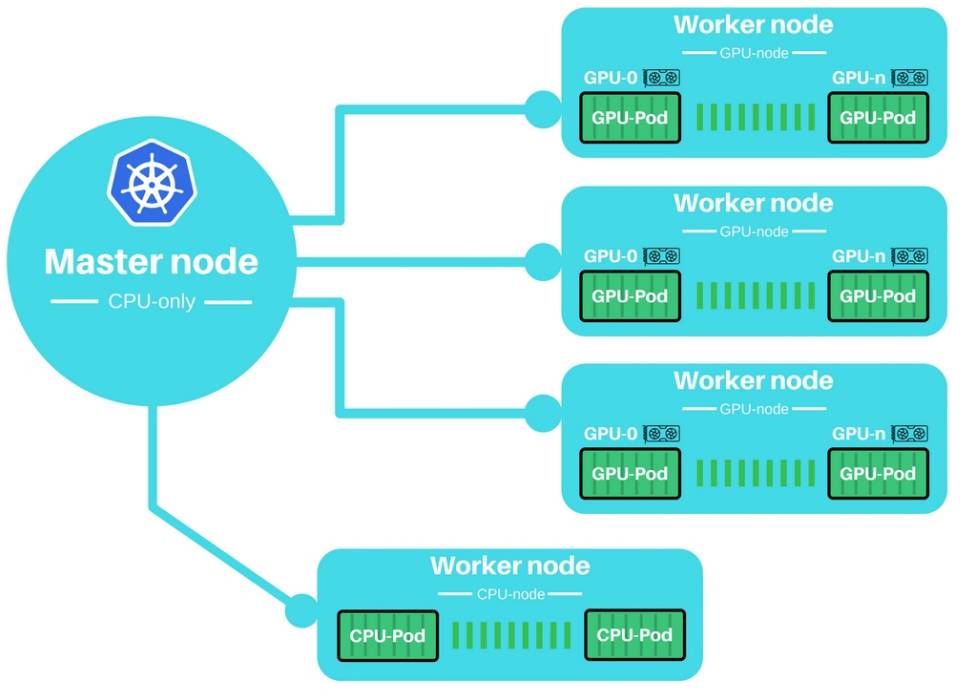

使用Docker容器

# 安装Docker sudo apt install -y docker.io sudo systemctl start docker # 拉取NVIDIA官方镜像 docker pull nvcr.io/nvidia/pytorch:23.08-py3 # 运行容器并挂载GPU docker run --gpus all -it --rm nvcr.io/nvidia/pytorch:23.08-py3

环境验证与性能测试

PyTorch验证:

import torch print(torch.cuda.is_available()) # 输出True表示成功 print(torch.rand(2,3).cuda()) # 测试GPU张量计算

TensorFlow验证:

import tensorflow as tf print(tf.config.list_physical_devices('GPU'))基准测试工具:

使用nvidia-smi监控GPU使用率,或使用NVIDIA NGC Benchmarks进行性能评估。

常见问题与维护建议

- 驱动冲突:若出现黑屏或驱动加载失败,尝试通过恢复模式卸载驱动后重新安装。

- CUDA路径问题:检查

LD_LIBRARY_PATH和PATH是否包含CUDA目录。 - 定期更新:每季度检查NVIDIA驱动和CUDA版本更新,确保兼容性。

引用说明

- NVIDIA驱动程序安装指南:https://docs.nvidia.com/datacenter/tesla/tesla-installation-notes/index.html

- CUDA官方文档:https://docs.nvidia.com/cuda/

- PyTorch安装指南:https://pytorch.org/get-started/locally/

- TensorFlow GPU支持文档:https://www.tensorflow.org/install/gpu

(本文持续更新,欢迎在评论区留言反馈问题或建议。)