GPU对服务器配置有哪些关键要求?如何优化性能提升计算效率?

- 行业动态

- 2025-05-07

- 3

GPU对服务器的要求

在人工智能、大数据分析和高性能计算(HPC)等领域的快速发展下,GPU(图形处理器)已成为现代服务器的核心组件之一,GPU的部署并非简单地将显卡插入服务器即可,其对服务器的硬件、软件和整体架构提出了严格的要求,以下是企业或开发者在部署GPU服务器时需重点关注的十大核心要素。

硬件配置的匹配性

CPU与GPU的协同能力

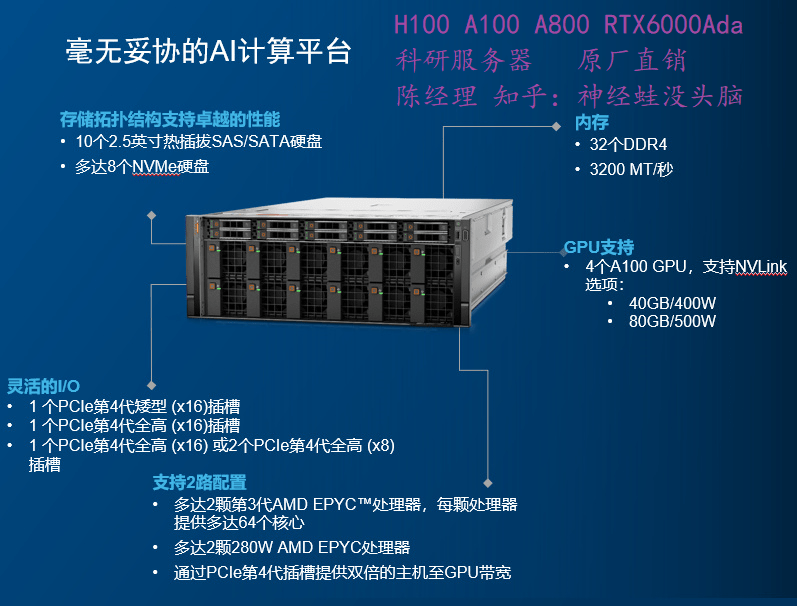

GPU需要与CPU高效协作,尤其是在并行计算任务中,建议选择支持多线程的高性能CPU(如Intel Xeon或AMD EPYC系列),并与GPU(如NVIDIA A100、H100或AMD Instinct系列)形成性能互补,避免因CPU瓶颈导致GPU算力浪费。内存容量与带宽

显存密集型任务(如深度学习模型训练)要求服务器配备大容量内存(建议≥512GB),并支持高带宽(如DDR5或HBM技术),以满足GPU与内存之间的快速数据交换需求。PCIe接口版本与数量

GPU需通过PCIe接口与服务器连接,推荐使用PCIe 4.0或5.0版本,以提供更高的传输速率(如PCIe 5.0的32 GT/s),多GPU部署时,需确保服务器拥有足够数量的PCIe插槽,并支持NVIDIA NVLink或AMD Infinity Fabric等互联技术。

散热与电源设计的严苛性

散热系统的可靠性

GPU的高功耗特性(如单卡功耗可达300W以上)要求服务器采用高效散热方案,包括风冷、液冷或混合散热系统,需确保服务器机箱风道设计合理,避免因温度过高导致降频或硬件损坏。电源冗余与稳定性

多GPU服务器通常需要≥1600W的电源功率,并支持80 PLUS铂金或钛金认证,冗余电源设计(如2+1电源模块)可避免因电源故障导致的服务中断。

软件与驱动的兼容性

操作系统与驱动程序

需确保服务器操作系统(如Linux发行版、Windows Server)与GPU驱动完全兼容,以NVIDIA为例,需定期更新CUDA Toolkit和驱动程序以支持最新算法框架。虚拟化与容器化支持

若服务器需承载虚拟化环境(如VMware、Kubernetes),需确认GPU支持SR-IOV或MIG(多实例GPU)技术,以实现算力资源的动态分配。

网络与存储的扩展性

高速网络接口

分布式计算场景(如AI集群)要求服务器配备25G/100G以太网或InfiniBand网卡,以降低多节点通信延迟。存储性能优化

GPU计算常伴随海量数据读写,需搭配NVMe SSD或分布式存储系统,确保I/O吞吐量匹配GPU处理速度。

安全与运维的长期性

硬件监控与管理

通过IPMI或Redfish协议实现远程监控,实时跟踪GPU温度、功耗和负载状态,预防硬件故障。安全加固

针对GPU计算节点,需启用固件签名验证、数据加密传输(如TLS 1.3)及访问控制策略,防范侧信道攻击或数据泄露。

典型应用场景与配置参考

| 场景 | 推荐配置 |

|---|---|

| 深度学习训练 | 8×NVIDIA A100 GPU + AMD EPYC 9754 CPU + 1TB内存 + PCIe 5.0 + 液冷散热 |

| 科学计算(如气象模拟) | 4×AMD Instinct MI250X + 双路Intel Xeon Platinum + 512GB内存 + InfiniBand HDR |

| 实时渲染 | NVIDIA RTX A6000 ×4 + 高速NVMe存储 + 10G网络 |

GPU服务器的选型与部署需从任务需求、硬件兼容性、运维成本三个维度综合考量,企业应优先选择通过行业认证(如NVIDIA Certified System)的服务器产品,并制定长期升级计划以应对技术迭代。

引用说明

- NVIDIA官方文档《DGX系统技术白皮书》

- 《IEEE高性能计算架构指南》(2025版)

- IDC报告《全球AI基础设施市场预测》(2025)