hdfs如何存储

- 行业动态

- 2025-05-15

- 7

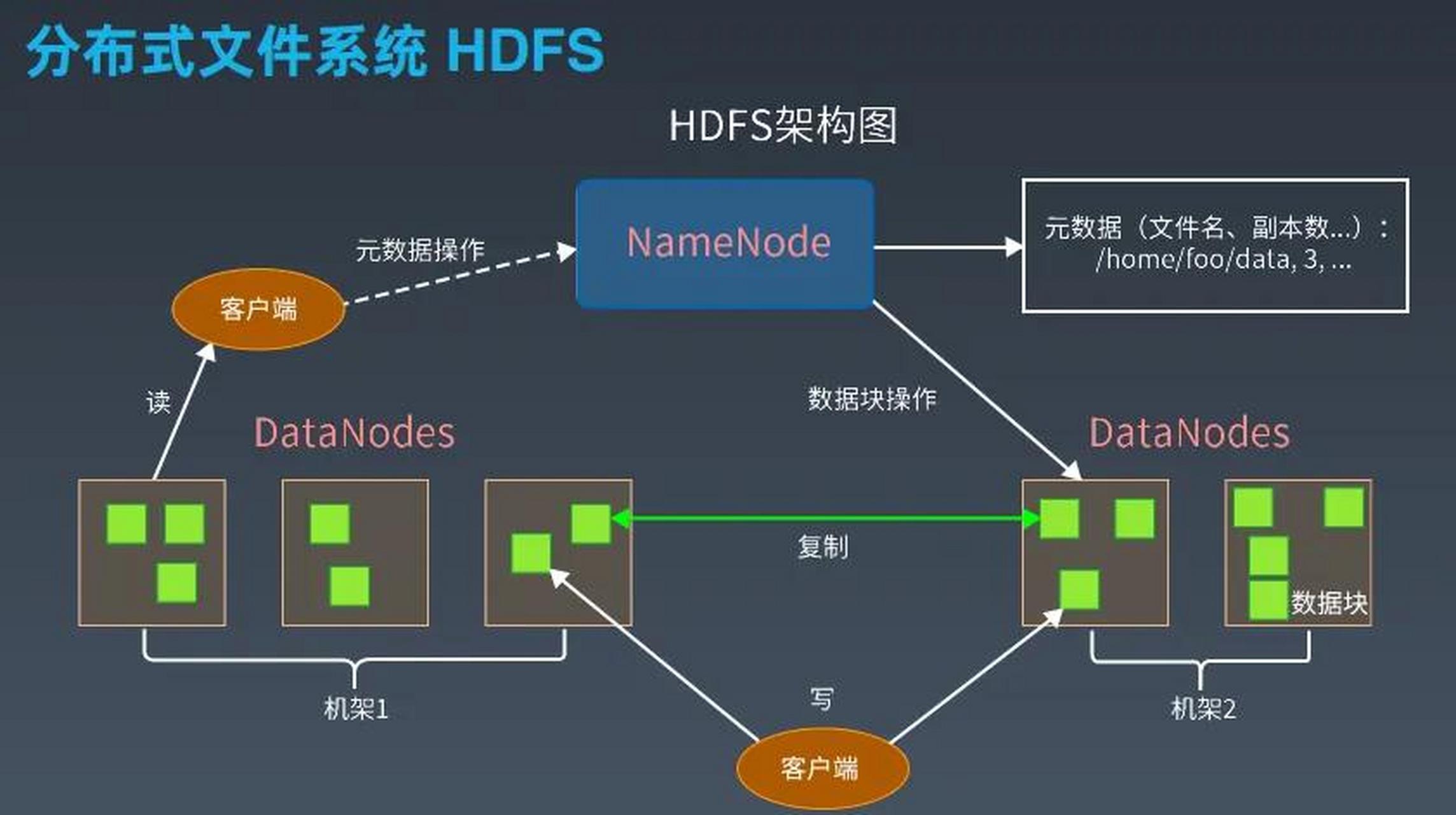

HDFS(Hadoop Distributed File System)作为大数据存储的基石,其存储机制围绕分布式、高容错和高效读写设计,以下从核心架构、数据分块、元数据管理、副本策略等角度详细解析其存储原理。

HDFS核心架构与存储角色

HDFS采用主从架构,包含两类关键节点:

| 组件 | 功能 |

|————-|————————————————————————–|

| NameNode | 管理文件系统的元数据(如文件路径、权限、块位置),不存储实际数据。 |

| DataNode | 负责存储数据块(Block),执行NameNode的指令(如创建/删除/复制数据块)。 |

存储流程:

- 客户端将文件拆分为固定大小的数据块(默认128MB)。

- NameNode记录每个块的元数据(如块ID、副本位置)。

- DataNode按NameNode指令存储数据块,并定期发送心跳和块报告。

数据分块与存储格式

块存储机制

- 固定块大小:文件被切分为多个等大的块(如128MB),即使最后一个块不满也单独存储。

- 优势:

- 支持大文件并行处理(块可独立读写)。

- 简化存储分配(无需动态计算文件碎片)。

- 例外:极小文件可合并存储(如Hadoop Archive或联邦存储优化)。

数据块结构

每个数据块包含:

- Block ID:全局唯一标识符。

- :原始文件片段。

- 元数据校验:通过Checksum验证数据完整性。

- 版本信息:记录块的生成时间和副本状态。

元数据管理(NameNode的核心职责)

NameNode通过以下方式高效管理元数据:

| 元数据类型 | 存储方式 | 作用 |

|———————-|————————————–|——————————————|

| FsImage | 磁盘文件(序列化快照) | 保存文件系统的整体结构(如目录树、块映射)。 |

| EditLog | 事务日志(追加写入) | 记录元数据的增量变更(如新建/删除文件)。 |

| 内存中的元数据缓存 | 运行时加载FsImage+EditLog到内存 | 快速响应客户端请求(如文件查找、块定位)。 |

Secondary NameNode:

- 定期合并FsImage和EditLog,减轻NameNode重启时的加载压力。

- 注意:它不提供高可用,仅用于辅助元数据持久化。

数据副本策略与可靠性

副本数量与存储规则

- 默认副本数:3份(可配置)。

- 副本分配逻辑:

- 第一个副本:随机选择DataNode(负载均衡)。

- 第二个副本:与第一个副本不同机架(避免机架级故障)。

- 第三个副本:与第一个副本同机架(减少跨机架传输)。

- 机架感知:通过拓扑树(Topology Tree)优化副本分布,降低网络延迟。

数据可靠性保障

- 心跳机制:DataNode每3秒向NameNode发送心跳,报告块状态和存储容量。

- 块报告:DataNode定期(每小时)上报所有块的完整列表,用于校验数据完整性。

- 副本自动恢复:若某个块的副本数低于设定值,NameNode自动触发复制任务。

数据读写流程

写入流程

- 客户端请求上传文件,NameNode返回可用DataNode列表。

- 客户端按顺序将数据块流水线传输至DataNode(第一个副本→第二个→第三个)。

- DataNode边存储边向NameNode确认完成状态。

- NameNode更新元数据(记录块位置和副本状态)。

读取流程

- 客户端请求读取文件,NameNode返回块位置列表。

- 客户端直接从最近的DataNode读取数据(支持多块并行下载)。

- 若某个块损坏,客户端从其他副本读取并通知NameNode修复。

存储优化与扩展

大文件优化

- 块大小调整:大文件可增大块尺寸(如256MB),减少元数据开销。

- 本地性优先:计算任务优先读取本地DataNode的数据(如MapReduce任务)。

小文件问题

- Hadoop Archive(HAR):合并小文件为归档文件,减少NameNode压力。

- 联邦HDFS:通过多个NameNode分担元数据管理。

高可用方案

- HA模式:配置Active/Standby双NameNode,通过ZooKeeper协调切换。

- JournalNode:共享EditLog实现元数据同步,避免单点故障。

FAQs

Q1:HDFS为什么默认块大小为128MB?可以调整吗?

A1:128MB是平衡磁盘IO和寻址效率的折中值,若文件较大,增大块尺寸可减少块数量,降低NameNode元数据压力;但过大会浪费小文件存储空间,需根据实际场景调整(如大数据分析推荐保持默认)。

Q2:如果NameNode宕机,HDFS还能正常读写吗?

A2:不能,NameNode是元数据的唯一权威,宕机会导致全集群不可写(读操作仍可访问已缓存的元数据),高可用(HA)集群通过Standby NameNode接管服务,但仍需依赖共享存储(如JournalNode)保证