hive数据仓库中的业务问题

- 行业动态

- 2025-05-11

- 13

Hive数据仓库中的业务问题分析与解决方案

数据加载延迟问题

业务场景:业务部门反馈每日ODS层数据延迟2小时以上,导致下游报表无法及时更新。

核心原因:

- 数据源(如Kafka)消费速度慢,消费者组Partition分配不均

- Loader作业未开启并行加载,单节点处理瓶颈

- 小文件过多导致HDFS写入IO瓶颈

解决方案对比表:

| 优化方向 | 具体措施 | 效果评估 |

|—————-|————————————————————————–|——————————|

| 并行度提升 | 设置mapreduce.job.split.metainfo.maxsize为2MB,启用多Mapper加载 | 加载速度提升3-5倍 |

| 数据预处理 | 使用Repartition Compactor合并小文件,设置hive.merge.smallfiles.avgsize=64MB | 减少80%小文件数量 |

| 资源隔离 | 通过YARN队列分配专属资源池,设置yarn.scheduler.capacity=50% | 资源争抢率下降60% |

复杂查询性能瓶颈

典型症状:

- 30+字段的JOIN查询耗时超过1小时

- WITH子句嵌套超过3层时内存溢出

- 动态分区插入导致元数据锁争用

根因分析:

- CBO优化器统计信息过时(最后一次ANALYZE在7天前)

- 倾斜Key未做特殊处理(某维度值包含90%数据)

- 未启用Vectorization执行引擎

优化方案:

-开启向量执行引擎

SET hive.vectorized.execution.enabled = true;

SET hive.vectorized.execution.reducemode = all;

-处理数据倾斜

SET hive.groupby.skewindata = true;

INSERT OVERWRITE TABLE target

SELECT

CASE

WHEN count() > 10000 THEN 'hot_key'

ELSE key

END,

sum(value)

FROM source

GROUP BY key

DISTRIBUTE BY CASE WHEN count() > 10000 THEN 'hot_key' ELSE key END;数据质量保障机制缺失

常见问题:

- 上游系统传来脏数据(如NULL值、非规字符)

- 业务指标计算逻辑变更未同步到数仓

- 缺少数据校验的自动化流程

质量管控体系:

数据校验阶段:

- 使用

hive.check.column属性验证字段格式 - 创建约束(CONSTRAINT)限制非规值范围

ALTER TABLE sales ADD CONSTRAINT cst_amount CHECK (amount >= 0);

- 使用

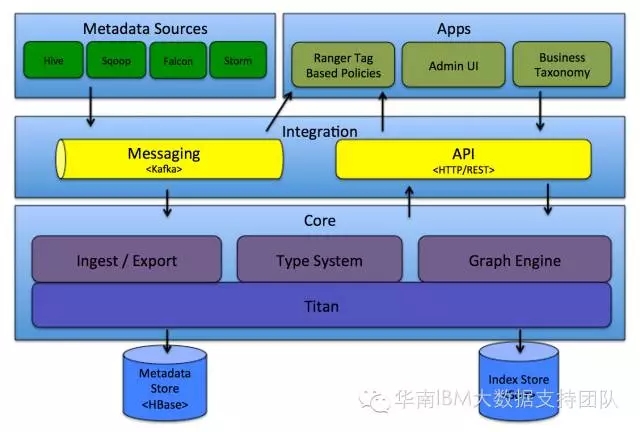

血缘追踪:

- 启用Hive ACID事务记录

- 集成Apache Atlas进行元数据管理

监控告警:

- 配置DataQualityAlerts插件,监控关键指标波动(如DSBC超过5%)

- 建立数据健康度评分体系(完整性30%+一致性30%+时效性40%)

存储成本优化困境

现状分析:

- 历史数据占用HDFS容量达80%

- ORC文件压缩比仅为2:1

- 未实施冷热数据分层

优化策略矩阵:

| 优化层级 | 技术方案 | 预期收益 |

|—————-|————————————————————————–|————————–|

| 存储格式 | 采用ORC+Zlib组合,设置orc.compress=ZLIB | 压缩比提升至5:1 |

| 数据生命周期 | 使用Hive Time Travel保留30天快照,过期数据转存至冷存储(如AWS Glacier) | 存储成本下降40% |

| 索引优化 | 对高频查询字段建立BloomFilter索引,设置hive.bloomfilter.columns | 扫描量减少60% |

权限管理复杂性

权限痛点:

- RBAC模型配置错误导致数据泄露(如开发环境误用生产权限)

- 动态分区表权限继承异常

- 临时表权限未及时回收

安全加固方案:

细粒度授权:

GRANT SELECT ON TABLE sales TO ROLE_reporting; GRANT INSERT ON TABLE sales_temp TO ROLE_etl;

动态权限审计:

- 部署Sentry Audit日志分析,检测异常访问模式

- 设置权限变更告警阈值(如单日超过5次授权操作)

临时对象管理:

- 启用

hive.strict.temporary.tables=true强制命名空间隔离 - 配置TempTableCleaner定时清理72小时未使用的临时表

- 启用

实时性需求挑战

传统Hive局限:

- 批处理延迟>15分钟

- 无法处理流式数据

- 微批处理效率低下

实时化改造路径:

架构演进:

- 搭建Kappa架构,Hive作为顺序存储层,Flink处理实时流

- 使用Hudi实现近实时upsert能力

技术融合:

-创建Hudi表 CREATE TABLE hudi_table ( uuid STRING, event_time TIMESTAMP, data STRUCT<...> ) COMMENT 'Merge On Read table' STORED AS HUDI;

混合计算:

- 离线任务:T+1批量处理(Hive on Tez)

- 实时任务:5秒微批处理(Flink SQL)

- 交互查询:Impala即时响应(物化视图加速)

FAQs

Q1:Hive分区表设计有哪些最佳实践?

A:应遵循”少而精”原则,建议:

- 按业务时间周期(日/小时)分区,避免过度碎片化

- 使用哈希分区分散热点数据,示例:

PARTITION (hash_key) - 动态分区需设置

hive.exec.dynamic.partition.max.parts=1000防止生成过多分区 - 定期执行

MSCK REPAIR TABLE修复元数据不一致问题

Q2:如何诊断Hive作业的资源消耗异常?

A:可通过以下步骤排查:

- 查看YARN ResourceManager的App详情页,检查Container分配情况

- 分析Hive日志中的Stage详细信息,关注Map/Reduce阶段耗时分布

- 使用

EXPLAIN DEPENDENCY检查查询计划中是否存在全表扫描 - 监控JVM堆内存使用情况,调整

mapreduce.map.memory.mb和`hive.t