上一篇

hive数据仓库数据导入mysql

- 行业动态

- 2025-05-07

- 2364

将Hive数据导出为CSV文件,通过MySQL LOAD DATA语句或Sqoop工具实现高效导入

Hive数据仓库数据导入MySQL的详细流程与实践

前置准备工作

环境依赖检查

- 确保Hive集群正常运行,MySQL服务已启动

- 安装MySQL JDBC驱动(如mysql-connector-java-8.0.xx.jar)

- 在Hive客户端配置

hive-site.xml添加MySQL驱动路径<property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:mysql://localhost:3306/metastore_db?createDatabaseIfNotExist=true</value> </property>

权限配置

- 为MySQL创建专用用户并授权

CREATE USER 'hive_user'@'%' IDENTIFIED BY 'password'; GRANT ALL PRIVILEGES ON target_db. TO 'hive_user'@'%'; FLUSH PRIVILEGES;

- 为MySQL创建专用用户并授权

网络连通性验证

- 执行测试命令:

telnet mysql_host 3306 # 或使用nc命令 nc -zv mysql_host 3306

- 执行测试命令:

数据导出阶段

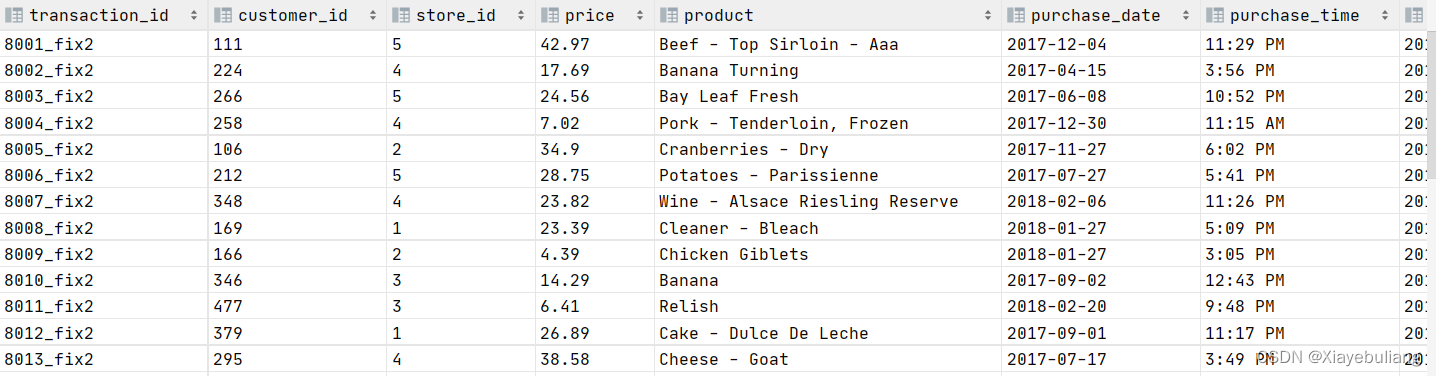

| 导出方式 | 适用场景 | 性能特征 |

|---|---|---|

| Hive SQL导出 | 小数据量(GB级) | 中等 |

| HDFS文件导出 | 中数据量(TB级) | 高 |

| Sqoop导出 | 大数据量(PB级) | 最高 |

Hive SQL导出示例

INSERT OVERWRITE LOCAL DIRECTORY '/tmp/export_data' ROW FORMAT DELIMITED FIELDS TERMINATED BY 't' SELECT FROM source_table;

HDFS文件导出

hadoop fs -get /user/hive/warehouse/source_table/ /local/path/

数据转换处理

字段映射规则

| Hive类型 | MySQL类型 | 转换建议 |

|———|———-|———|

| STRING | VARCHAR | 限制最大长度 |

| DOUBLE | DECIMAL | 保留精度 |

| TIMESTAMP | DATETIME | 格式化处理 |

| ARRAY/MAP | JSON | 序列化存储 |数据清洗脚本示例(Python)

import pandas as pd

加载数据

df = pd.read_csv(‘export_data/part-‘, sep=’t’, low_memory=False)

类型转换

df[‘timestamp_field’] = pd.to_datetime(df[‘timestamp_field’])

df[‘double_field’] = df[‘double_field’].astype(float)

缺失值处理

df.fillna({‘string_field’: ‘N/A’, ‘int_field’: 0}, inplace=True)

保存清洗后数据

df.to_csv(‘cleaned_data.csv’, index=False)

# 四、数据导入MySQL

1. LOAD DATA方式

```sql

LOAD DATA LOCAL INFILE 'cleaned_data.csv'

INTO TABLE target_table

FIELDS TERMINATED BY ','

ENCLOSED BY '"'

LINES TERMINATED BY '

'

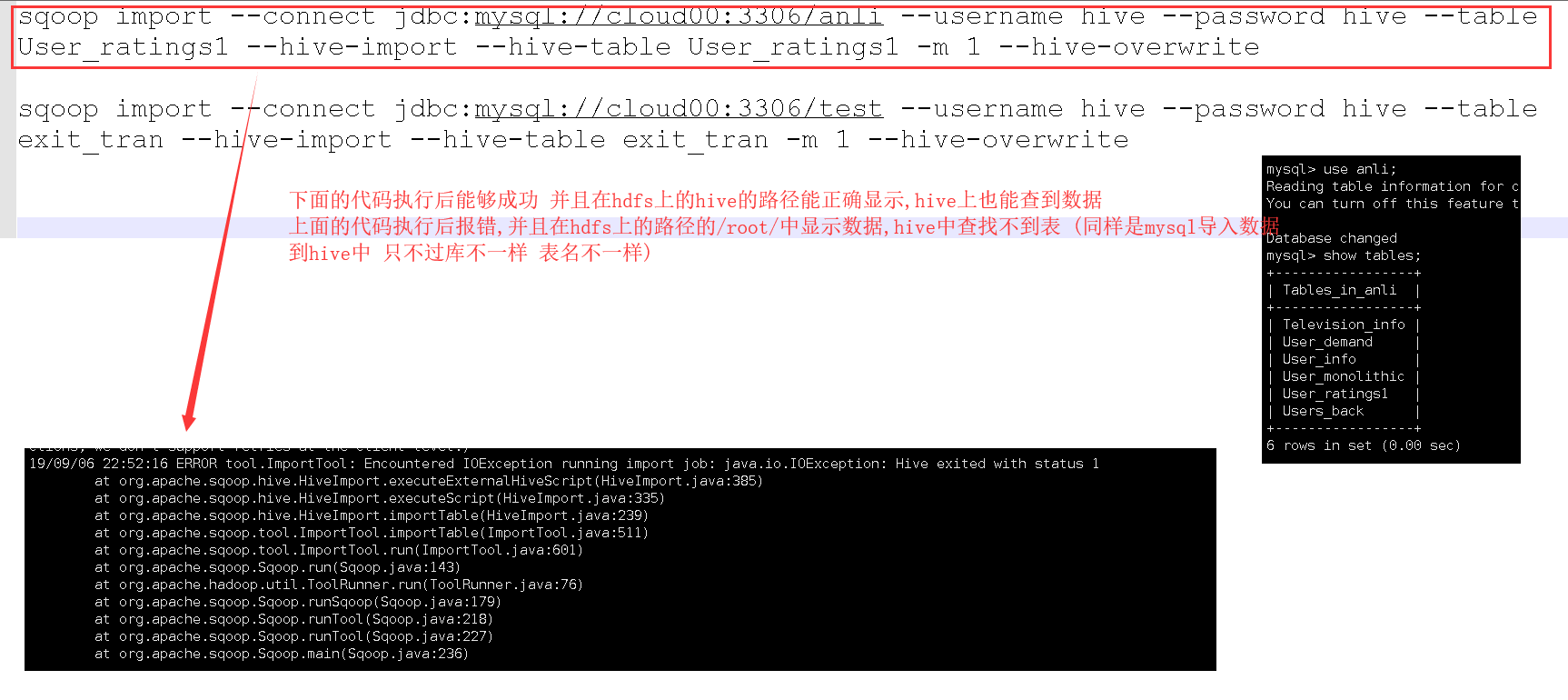

IGNORE 1 LINES;Sqoop导入命令

sqoop import --connect jdbc:mysql://mysql_host:3306/target_db --username hive_user --password password --table target_table --columns "col1,col2,col3" --direct --m 4 --input-fields-terminated-by '�01' /user/hive/warehouse/source_table/

性能优化策略

并行度调整

- Sqoop设置

--num-mappers参数(建议值为集群节点数×2) - MySQL配置

innodb_buffer_pool_size为物理内存的60-80%

- Sqoop设置

索引管理

- 导入前禁用索引:

ALTER TABLE target_table DISABLE KEYS; - 导入后重建索引:

ALTER TABLE target_table ENABLE KEYS;

- 导入前禁用索引:

批量提交设置

SET autocommit=0; START TRANSACTION; LOAD DATA ... ; COMMIT;

数据验证方案

记录数比对

SELECT COUNT() FROM source_table; -Hive侧 SELECT COUNT() FROM target_table; -MySQL侧

抽样校验

SELECT FROM source_table LIMIT 100; SELECT FROM target_table LIMIT 100;

一致性哈希校验

md5sum source_file > source_hash.txt md5sum target_file > target_hash.txt diff source_hash.txt target_hash.txt

常见问题处理

| 问题现象 | 解决方案 |

|---|---|

| 字符集错误 | 设置--charset=utf8参数 |

| 字段截断 | 调整MySQL字段长度或使用VARCHAR(MAX) |

| 内存溢出 | 增加sqoop-mapreduce.map.memory.mb配置 |

| 主键冲突 | 导入前清空目标表或使用ON DUPLICATE KEY |

FAQs

Q1: 如何处理Hive分区表的数据导入?

A1: 需要遍历所有分区执行导出操作,可使用以下脚本:

for partition in $(hive -e "SHOW PARTITIONS table_name"); do sqoop import --hive-partition-options "-p $partition" ... done

Q2: 导入过程中出现OutOfMemory错误怎么办?

A2: 可通过以下方式优化:

- 调整Map任务内存:

--mapreduce-map.memory.mb=4096 - 启用压缩:

--compression-codec=org.apache.hadoop.io.compress.SnappyCodec - 分批导入:按时间