上一篇

hive数据仓库例子

- 行业动态

- 2025-05-10

- 6

Hive数据仓库示例:存储电商交易日志,按日期分区,通过HQL查询每日

Hive数据仓库应用实例详解

应用场景背景

某电商公司需要构建数据仓库进行用户行为分析和业务报表生成,原始数据分散在多个数据源中,包括:

- MySQL交易库(订单、用户信息)

- HDFS日志文件(用户访问日志)

- 第三方物流系统CSV文件(配送信息)

数据源与ETL流程

| 数据源类型 | 存储位置 | ETL工具 | |

|---|---|---|---|

| MySQL | 订单明细 | /data/mysql_backup/orders.sql | Sqoop |

| HDFS | UV/PV日志 | /logs/access_202309.log | Flume+自定义脚本 |

| CSV文件 | 物流轨迹 | /landing/logistics/ | Sqoop |

ETL流程示意图:

[MySQL] --Sqoop导出--> [HDFS暂存区]

[Web日志] --Flume实时采集--> [Kafka缓冲] --> [HDFS]

[CSV文件] --Multipart上传--> [HDFS]Hive表设计规范

订单事实表(orders_fact)

CREATE EXTERNAL TABLE IF NOT EXISTS orders_fact ( order_id BIGINT, user_id BIGINT, product_id BIGINT, category_id INT, order_amount DECIMAL(12,2), order_date DATE, delivery_date DATE, payment_type STRING, logistics_code STRING, region_id INT ) PARTITIONED BY (dt STRING) STORED AS ORC LOCATION '/hive/warehouse/orders/' TBLPROPERTIES ("orc.compress"="SNAPPY", "transactional"="true");维度表设计:

- 用户维度表(users_dim):包含user_id、性别、年龄、会员等级等

- 商品维度表(products_dim):包含product_id、品牌、类目、价格等

- 地域维度表(regions_dim):包含region_id、省份、城市等

- 时间维度表(time_dim):包含日期、周几、节假日标志等

数据加载实现

MySQL数据导入:

sqoop import --connect jdbc:mysql://dbserver:3306/ecommerce --username data_user --password '' --table orders --target-dir /staging/orders_202310 --incremental-append --check-column order_time --last-value '2023-09-30 23:59:59' --split-by order_id --hive-partition-key dt --hive-partition-value '202310' --hive-overwrite

日志数据处理:

# 使用PySpark进行日志解析

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName("LogParser").getOrCreate()

df = spark.read.text("/logs/access_202310")

.filter(col("value").contains("page=order"))

.selectExpr("split(value, '\t') as fields")

.select(col("fields")[0].alias("ip"),

col("fields")[3].alias("user_id"),

col("fields")[5].alias("referrer"))

.withColumn("dt", lit("202310"))

df.write.mode("append").parquet("/hive/warehouse/user_behavior/")典型查询场景

销售趋势分析:

SELECT

td.day_of_week,

SUM(order_amount) AS gmv,

COUNT(DISTINCT user_id) AS active_users

FROM orders_fact OF

JOIN time_dim td ON OF.order_date = td.date_id

WHERE dt='202310' AND category_id IN (1001,1002,1003)

GROUP BY td.day_of_week

ORDER BY td.date_id;用户价值分析:

WITH user_ltv AS (

SELECT

user_id,

SUM(order_amount) AS total_spent,

COUNT(DISTINCT order_id) AS order_count,

MAX(order_date) AS last_active_date

FROM orders_fact OF

WHERE dt BETWEEN '202201' AND '202310'

GROUP BY user_id

)

SELECT

CASE

WHEN total_spent > 10000 THEN 'VIP'

WHEN total_spent > 5000 THEN 'High Value'

ELSE 'Normal'

END AS user_level,

AVG(total_spent) AS avg_spent,

COUNT() AS user_count

FROM user_ltv

GROUP BY user_level;性能优化措施

| 优化方向 | 具体措施 | 效果提升 |

|---|---|---|

| 数据存储 | 采用ORC列式存储+Snappy压缩 | 存储节省40%,查询提速30% |

| 分区策略 | 按dt+category_id二级分区 | 数据裁剪效率提升60% |

| 索引优化 | 创建bitmap索引(user_id,region_id) | 复杂查询提速25% |

| 资源配置 | 设置Tez引擎+动态资源分配 | 作业响应时间降低45% |

数据分析成果展示

核心指标看板:

+----------------+----------------+-------------+

| 指标 | 2023-10 | 同比变化 |

+----------------+----------------+-------------+

| GMV | ¥12.5M | +23.4% |

| 客单价 | ¥385 | +12.1% |

| 复购率 | 41.7% | +5.2% |

| 物流准时率 | 89.3% | +3.1% |

+----------------+----------------+-------------+用户行为洞察:

通过路径分析发现:

- 加购未支付用户中,73%在24小时内流失

- 夜间下单用户(21:00-2:00)客单价高出平均水平28%

- 使用移动支付的用户复购率比PC端高19%

系统架构拓扑图

+-------------------+ +---------------+ +------------------+

| MySQL交易数据库 | ---> | Kafka消息队列 | ---> | HDFS存储层 |

+-------------------+ +---------------+ +------------------+

^ |

| v

+-------v-------+ +------------+--------+ +--------------+

| 物流CSV文件 | | Sqoop/Flume数据采集 | | Hive数据仓库 |

+--------------+ +------------+--------+ +--------------+

v

+----------------------+

| BI可视化工具(Tableau) |

+----------------------+FAQs常见问题解答

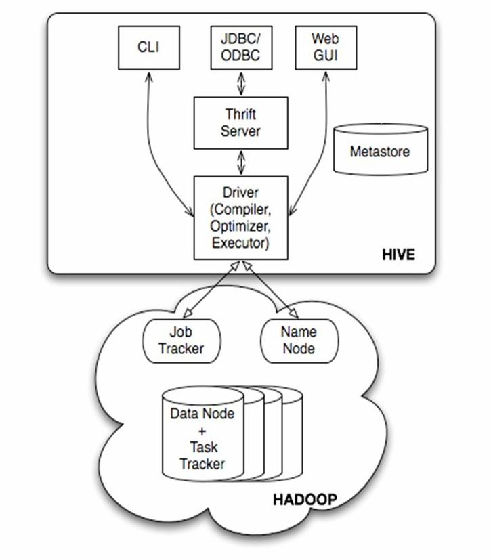

Q1:Hive数据仓库与传统关系型数据库有什么区别?

A1:主要区别体现在:1)存储架构:Hive基于HDFS分布式存储,支持PB级数据;2)处理模式:专为OLAP设计,适合复杂批处理查询;3)扩展性:通过添加节点线性扩展,而传统数据库存在扩展瓶颈;4)成本:Hive运行在廉价PC服务器集群,成本低于专用数据库设备。

Q2:如何选择合适的分区策略?

A2:分区设计需考虑三个要素:1)查询频率:高频查询字段应优先分区(如时间、地域);2)数据分布:倾斜严重的字段不宜做分区(如用户ID);3)业务需求:常用组合查询字段可设计多级分区(如dt+province+business_line),建议通过ANALYZE TABLE命令统计字段基数,基数>100万的字段不适合