上一篇

hive数据仓库从入门到实战

- 行业动态

- 2025-05-10

- 8

《Hive数据仓库从入门到实战》系统讲解基于Hadoop的Hive工具,涵盖安装配置、架构原理、SQL语法及 数据仓库设计,通过电商/日志等场景案例,深入调优策略与ETL实战,助力掌握

Hive数据仓库从入门到实战

Hive基础概念与核心特性

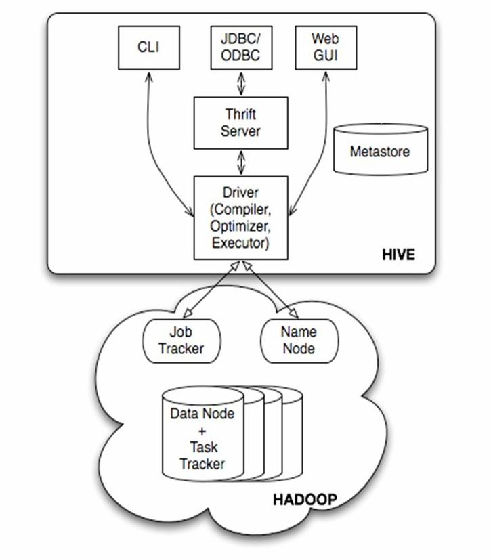

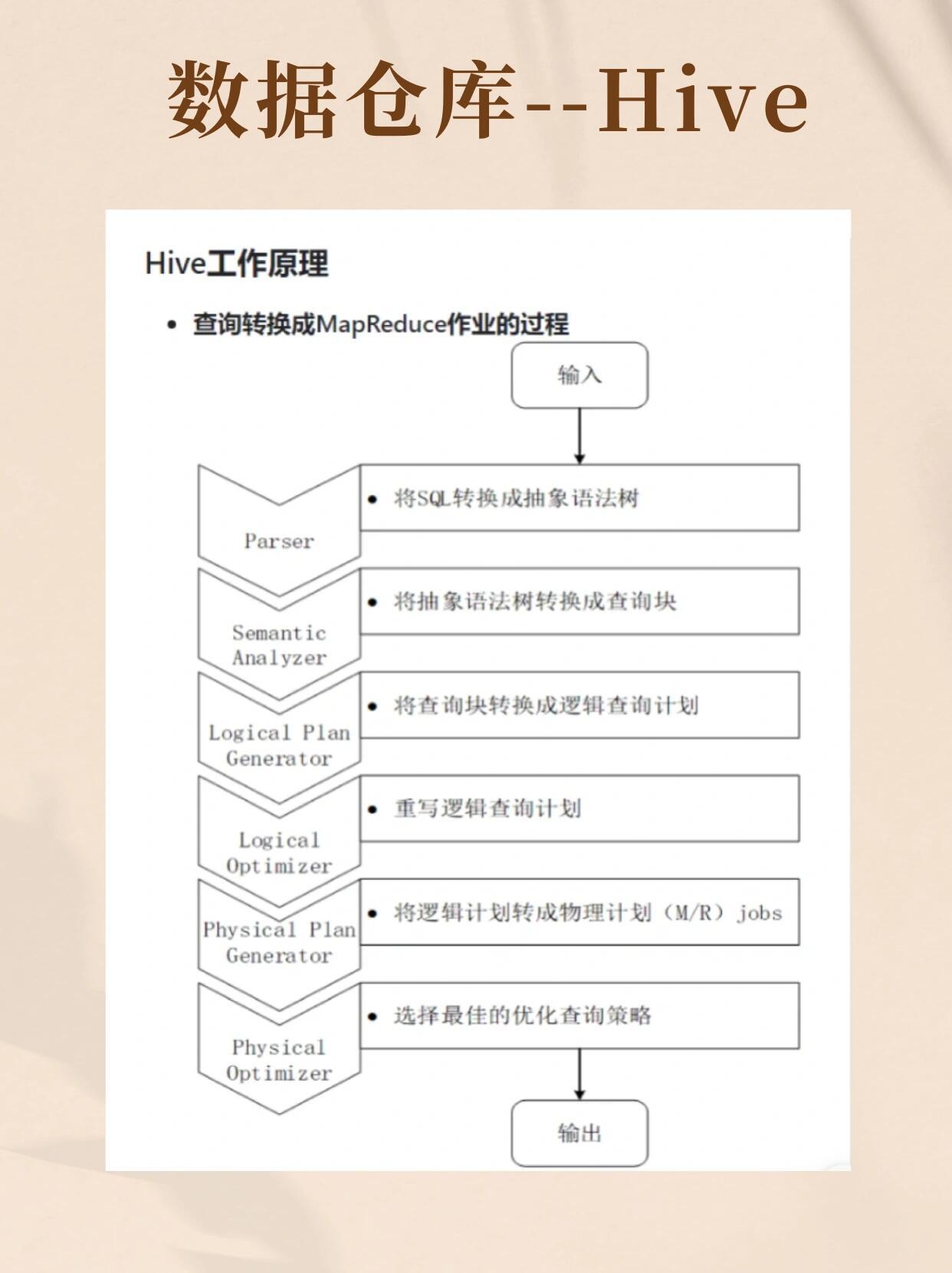

Hive是基于Hadoop的数据仓库工具,通过类SQL语言(HiveQL)实现对大规模数据的分析和处理,其核心特点包括:

- 结构化存储:支持表、分区、桶等组织形式

- 离线计算:依赖MapReduce/Tez/Spark执行引擎

- 兼容SQL:提供HiveQL方言,支持大部分标准SQL语法

- 扩展性:可处理PB级数据,横向扩展能力优异

| 特性 | 说明 |

|---|---|

| 数据存储 | 基于HDFS,支持文本/ORC/Parquet等多种格式 |

| 计算引擎 | 可插拔式设计(MR/Tez/Spark) |

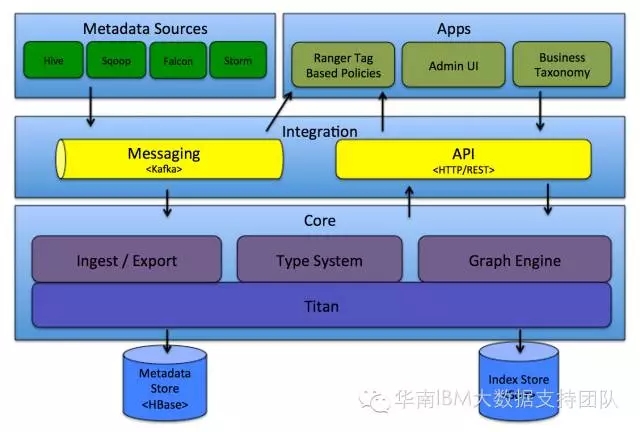

| 元数据管理 | 使用关系型数据库(如MySQL)存储元数据 |

| 权限控制 | 集成Apache Ranger/Sentry实现细粒度权限管理 |

环境搭建与基础操作

安装部署

- 前置条件:已部署Hadoop集群(2.x+版本)

- 下载Hive二进制包(apache.org/hive)

- 配置hive-site.xml核心参数:

<property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:mysql://localhost:3306/hive_metastore</value> </property> <property> <name>hive.execution.engine</name> <value>tez</value> <!-可选mr/spark --> </property>

- 初始化元数据库:

schematool -initSchema

基础语法示例

-创建外部表(避免数据重复存储) CREATE EXTERNAL TABLE user_logs ( user_id STRING, event_time TIMESTAMP, event_type STRING, session_id STRING ) ROW FORMAT DELIMITED FIELDS TERMINATED BY 't' STORED AS TEXTFILE LOCATION '/data/user_logs/'; -简单查询 SELECT event_type, COUNT() FROM user_logs WHERE event_time > '2023-01-01' GROUP BY event_type;

高级功能与优化策略

分区与桶

- 分区:按时间/地域等维度物理分割数据

CREATE TABLE orders ( order_id BIGINT, user_id STRING, order_date DATE ) PARTITIONED BY (dt STRING) -按天分区 STORED AS ORC;

- 桶:哈希取模实现数据均匀分布,提升JOIN效率

CLUSTERED BY (user_id) INTO 10 BUCKETS -10个桶

- 分区:按时间/地域等维度物理分割数据

索引与事务

- 索引:对频繁查询字段建立COMPACT/BITMAP索引

- ACID事务:开启

hive.txn.manager支持插入/更新/删除原子性

性能优化技巧

- 开启向量执行:

SET hive.vectorized.execution.enabled=true - 使用ORC格式:支持列式存储+压缩+统计信息加速查询

- 并行执行:调整

hive.exec.parallel参数(默认8个任务) - 数据倾斜处理:启用

hive.groupby.skewindata=true自动优化

- 开启向量执行:

实战案例:电商用户行为分析

需求:统计每日各省份用户访问次数,并关联订单数据计算转化率

数据准备

- 用户行为表(带地理IP解析后的省份字段)

- 订单事实表(包含下单时间、用户ID)

核心SQL

WITH daily_visits AS ( SELECT province, COUNT(DISTINCT user_id) AS visit_users, DATE_FORMAT(event_time, 'yyyy-MM-dd') AS log_date FROM user_behavior_logs WHERE event_type = 'page_view' GROUP BY province, log_date ), daily_orders AS ( SELECT province, COUNT(DISTINCT order_id) AS order_count, order_date FROM orders GROUP BY province, order_date ) SELECT v.log_date, v.province, v.visit_users, o.order_count, (o.order_count / v.visit_users) AS conversion_rate FROM daily_visits v LEFT JOIN daily_orders o ON v.province = o.province AND v.log_date = o.order_date;执行优化

- 为

province字段创建BITMAP索引 - 使用ORC存储格式+SNAPPY压缩

- 设置

mapreduce.job.reduces=50提升并发度

- 为

常见问题与解决方案

Q1:Hive查询速度慢如何解决?

- 开启列式存储(ORC/Parquet)+ 开启压缩

- 合理设计分区策略(按高频查询字段分区)

- 使用Tez/Spark替代MapReduce引擎

- 采集表统计信息:

ANALYZE TABLE table_name COMPUTE STATISTICS

Q2:如何处理小文件过多问题?

- 合并小文件:

INSERT OVERWRITE DIRECTORY配合CONCATENATE - 启用合并插入:

SET hive.merge.mapfiles=true - 调整HDFS blocksize(如64MB→128MB)

- 使用ORC格式+ZLIB压缩减少文件数量

技术生态与演进方向

- 集成体系:与Sqoop(数据导入)、Oozie(工作流调度)、Superset(可视化)无缝对接

- 实时化演进:通过Hive on Tez/Spark实现近实时分析,结合Kafka构建流批一体架构

- 云原生适配:支持AWS EMR/Azure HDInsight等托管服务,适配Serverless场景

- 智能优化:基于机器学习的自动参数调优(如华为MindS