上一篇

如何高效搭建GPU云计算平台?

- 行业动态

- 2025-05-02

- 4027

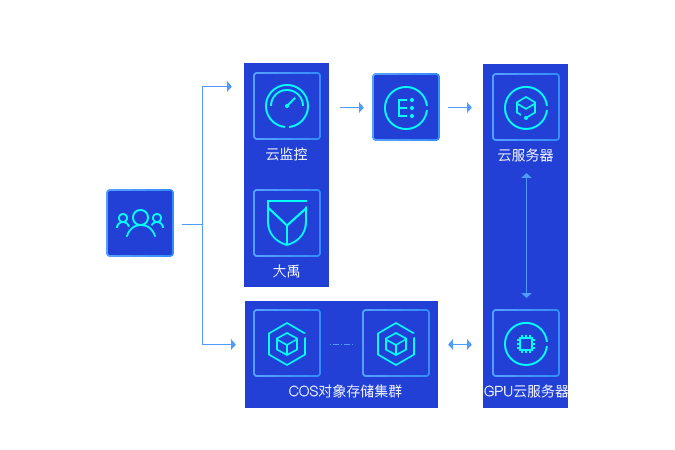

GPU云计算平台搭建基于高性能GPU集群,通过虚拟化技术整合计算资源,支持分布式深度学习训练与推理,平台需部署多节点协同管理、弹性伸缩调度系统,优化数据传输与存储性能,结合容器化部署确保环境隔离,同时提供安全监控和成本优化功能,满足高效能计算与灵活资源需求。

GPU云计算平台搭建指南

在人工智能、深度学习、科学计算等领域,GPU(图形处理器)因并行计算能力成为核心算力载体,搭建一个高效、稳定的GPU云计算平台,既能满足企业对高性能计算的需求,又能通过弹性资源分配降低成本,以下从技术选型、架构设计到实施步骤,详细解析如何构建一个符合企业需求的GPU云平台。

为什么需要GPU云计算平台?

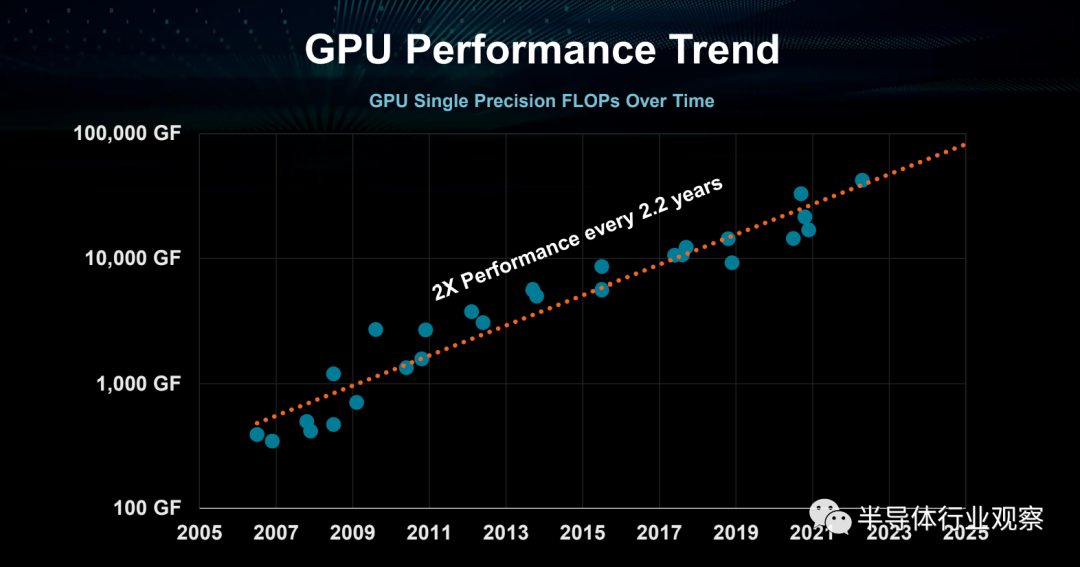

- 算力需求爆炸增长

传统CPU难以满足深度学习模型训练、渲染等任务的并行计算需求,而单张GPU的算力有限,通过云计算实现多GPU协同可大幅提升效率。 - 资源弹性与成本优化

企业无需一次性投入高昂硬件成本,可按需租用算力,避免资源闲置。 - 支持多场景应用

涵盖AI模型训练、3D渲染、基因测序、金融建模等,适配科研机构、互联网企业、医疗机构等多样化需求。

GPU云平台的核心技术架构

硬件层:GPU选型与集群部署

- GPU型号选择:

- NVIDIA系列:A100/V100适用于通用深度学习;H100/T4针对推理优化;RTX系列适合中小规模训练。

- AMD Instinct系列:MI250X在性价比和开源生态中表现突出。

- 服务器配置:

- 单节点多GPU架构(如8卡服务器)需支持PCIe 4.0以上带宽,避免通信瓶颈。

- 网络互联采用InfiniBand或100G以太网,保证低延迟数据传输。

虚拟化与资源调度

- GPU虚拟化技术:

- 硬件级隔离:NVIDIA vGPU、AMD MxGPU支持将单卡划分为多个虚拟GPU,供不同用户独占使用。

- 容器化方案:Docker + Kubernetes结合NVIDIA GPU Operator,实现容器内GPU资源动态分配。

- 调度系统:

开源框架:Slurm、Apache Mesos;商业化方案:VMware vSphere、OpenStack Nova GPU Support。

存储与网络优化

- 分布式存储:Ceph、GlusterFS提供高吞吐存储池,适配大规模数据集读写。

- 高速网络:RDMA(远程直接内存访问)技术降低GPU节点间通信延迟,提升分布式训练效率。

实施步骤:从0到1搭建GPU云平台

需求分析与规划

- 明确目标场景(如训练/推理)、预计用户规模、预算等。

- 选择公有云、私有云或混合云部署模式。

硬件采购与部署

- 采购GPU服务器、网络设备(交换机、网卡)、存储设备。

- 部署机房需满足散热(液冷/风冷)、电力冗余(双路供电)要求。

软件环境搭建

- 操作系统:Ubuntu/CentOS + GPU驱动(NVIDIA CUDA Toolkit或AMD ROCm)。

- 虚拟化层:安装KVM/Xen,配置vGPU或GPU直通模式。

- 管理平台:OpenStack或Kubernetes集成GPU插件(如NVIDIA GPU Cloud)。

安全与监控

- 防火墙隔离、用户权限控制(RBAC)。

- 部署Prometheus + Grafana监控GPU利用率、温度、任务队列状态。

成本优化与运维策略

- 动态伸缩:基于负载自动扩缩容GPU实例,节省闲置成本。

- 混合云架构:敏感数据存于私有云,峰值算力调用公有云(如AWS EC2 GPU实例)。

- 开源工具替代:使用Kubeflow替代商业MLOps平台,降低许可费用。

典型应用场景与案例

- AI模型训练

某自动驾驶公司通过GPU云平台,将模型训练时间从30天缩短至5天。

- 医疗影像分析

三甲医院部署私有GPU云,实现CT影像实时AI辅助诊断。

- 影视渲染

渲染农场利用云平台弹性资源,应对4K/8K视频制作高峰期需求。

挑战与应对方案

- 兼容性问题:不同框架(TensorFlow/PyTorch)对GPU型号和CUDA版本有要求,需统一环境版本。

- 运维复杂度:通过自动化脚本(Ansible)批量管理节点,减少人工干预。

- 安全风险:启用GPU内存加密(如NVIDIA A100的MIG功能),防止数据泄漏。

未来趋势

- AI芯片异构计算:集成GPU、FPGA、ASIC(如TPU)的混合算力池。

- 绿色计算:液冷技术降低GPU集群能耗,符合碳中和目标。

- 边缘云协同:在边缘节点部署轻量级GPU算力,减少数据传输延迟。

引用来源

- NVIDIA官方文档:vGPU技术白皮书

- Red Hat:OpenStack GPU加速指南

- IEEE论文《GPU Virtualization for Cloud Computing》

- IDC报告《2025全球AI基础设施市场预测》

通过以上步骤与策略,企业可高效搭建高性价比的GPU云计算平台,充分释放算力潜能,支撑业务创新与增长。