GPU计算服务器真能带来性能飞跃还是营销噱头?

- 行业动态

- 2025-05-08

- 5

GPU计算服务器好不好?全面解析优缺点与应用场景

在数字化与智能化浪潮下,GPU计算服务器逐渐成为企业、科研机构甚至个人开发者关注的焦点,但究竟它是否值得投入?本文从技术原理、核心优势、潜在不足、适用场景等多维度展开分析,帮助您做出更理性的决策。

什么是GPU计算服务器?

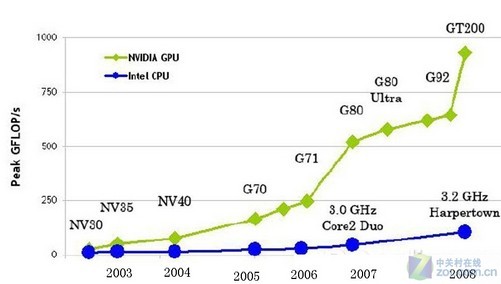

GPU计算服务器是一种搭载图形处理器(GPU)的高性能服务器,与传统CPU(中央处理器)不同,GPU拥有数千个计算核心,专为并行计算设计,擅长处理大规模、高密度的数据运算任务。

典型配置包括多块高性能GPU(如NVIDIA A100/A800、H100等),搭配高速内存、大容量存储和高带宽网络,适合需要实时计算或海量数据处理的场景。

GPU计算服务器的核心优势

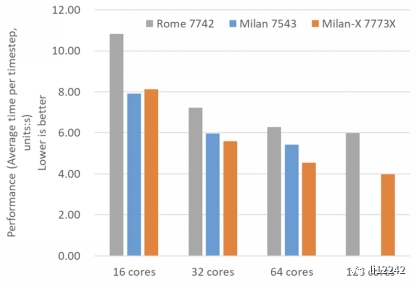

超强算力,效率提升显著

- 并行计算能力:GPU可同时处理数千个线程,适合机器学习训练、图像渲染、科学模拟等任务,训练一个AI模型,GPU服务器可能将时间从CPU的10天缩短至10小时。

- 单精度/双精度浮点性能:以NVIDIA A100为例,其FP32性能达19.5 TFLOPS,远超传统CPU的算力水平。

应用场景广泛

- 人工智能与深度学习:模型训练、推理加速(如ChatGPT等大语言模型)。

- 科学计算:气候模拟、基因测序、流体动力学分析。

- 图形渲染与虚拟化:影视特效、3D建模、云游戏。

- 数据分析:实时大数据处理、金融高频交易。

高性价比的长期投资

虽然初期采购成本较高,但GPU服务器能大幅缩短任务时间,降低人力与电力成本,某生物医药公司采用GPU集群后,药物筛选效率提升80%,研发周期压缩6个月。

支持主流开发框架

CUDA、TensorFlow、PyTorch等工具链成熟,开发者可快速迁移现有项目。

GPU服务器的潜在不足

初始成本较高

高端GPU(如H100)单价可能超过万元,且需配套散热、供电系统,中小企业可能面临预算压力。

能耗与运维复杂度

单台GPU服务器功耗可达500W以上,需专业机房环境;驱动更新、集群管理需要技术人员支持。

不适用于所有场景

对于依赖单线程性能的任务(如传统数据库查询),CPU服务器可能更高效。

如何判断是否需要GPU服务器?

可通过以下问题自测:

任务类型:是否涉及大量矩阵运算、并行计算?

数据规模:是否需要处理TB级数据或高分辨率图像?

时效性要求:是否需要实时或近实时结果?

预算规划:能否承担硬件采购与运维成本?

举例:

- 若团队正在开发自动驾驶算法,需处理数万小时的视频数据——GPU服务器是刚需。

- 若仅用于搭建企业官网或内部OA系统——传统CPU服务器更合适。

选购与部署建议

按需选择硬件配置

- 入门级:NVIDIA T4(低成本推理场景)

- 高性能:A100/H100(训练大模型、科学计算)

- 扩展性:支持多卡并联的机架式服务器。

关注软硬件生态兼容性

确保驱动、框架版本与业务代码适配。

灵活选择部署方式

- 自建机房:适合数据敏感型企业。

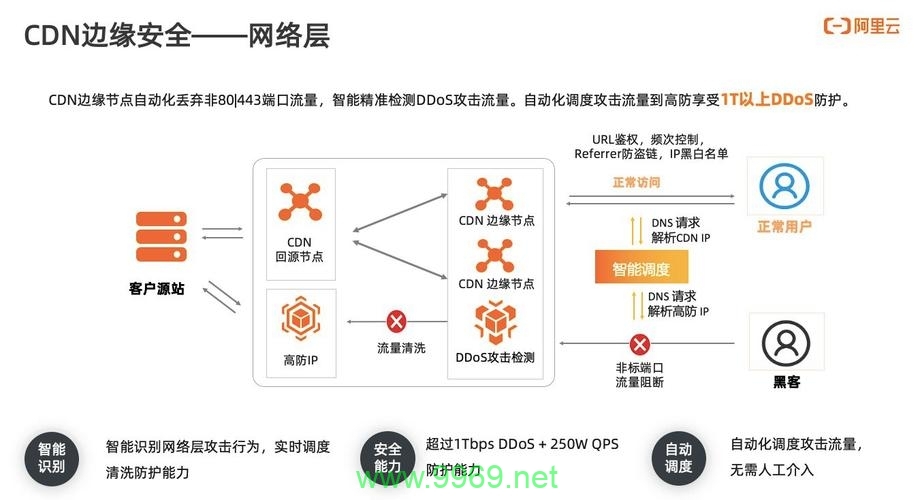

- 云服务租用:AWS EC2、阿里云GN7等按需付费,降低初期投入。

未来趋势:GPU服务器将成算力基础设施

据IDC预测,2025年全球AI算力需求将增长50倍,其中90%由GPU承担,随着生成式AI、元宇宙、自动驾驶等技术落地,GPU服务器的市场需求将持续爆发。

GPU计算服务器是高算力需求场景的“利器”,但需结合业务实际评估投入产出比,对于追求技术创新与效率提升的团队,它不仅是工具,更是抢占技术高地的核心竞争力。

引用说明

- NVIDIA官方技术白皮书《A100 Tensor Core GPU架构解析》

- IDC报告《全球人工智能基础设施市场预测(2025-2027)》

- 阿里云《企业GPU算力选型指南》2025版