上一篇

hadoop集群中分布式数据仓库

- 行业动态

- 2025-05-09

- 4518

Hadoop集群中的分布式数据仓库基于HDFS构建,支持PB级数据存储与并行处理,具备高扩展性与容错能力,适用于大数据分析

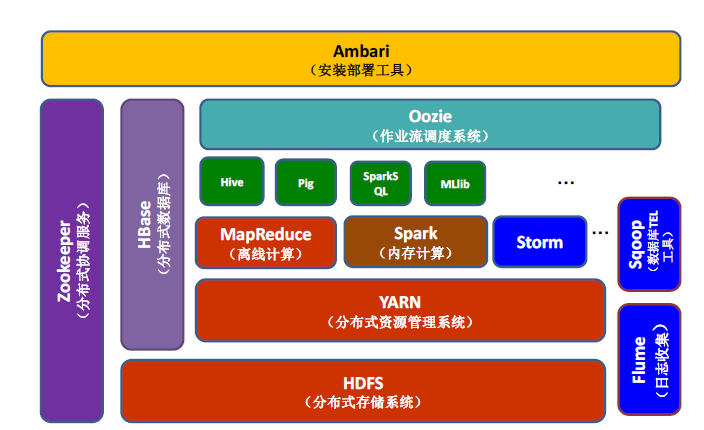

在Hadoop集群中构建分布式数据仓库是企业处理海量数据、实现高效分析的核心方案,以下从架构设计、关键技术组件、数据存储与管理、数据处理流程及优化策略等方面展开详细说明。

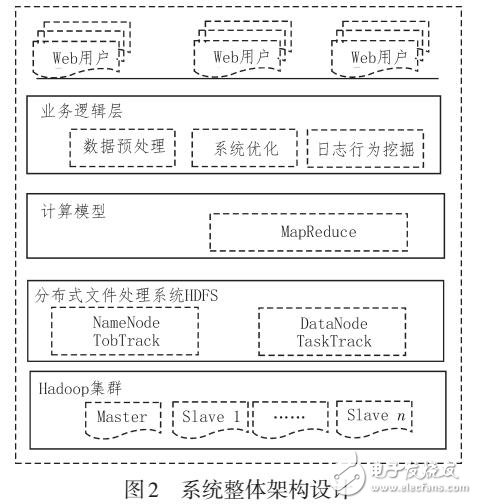

分布式数据仓库架构设计

分布式数据仓库的架构通常采用分层设计,以实现高可用性、可扩展性和高性能,典型架构分为以下层级:

| 层级 | 功能描述 | 核心技术组件 |

|---|---|---|

| 数据源层 | 接入多源异构数据(如数据库、日志、传感器数据等) | Sqoop、Flume、Kafka |

| 数据存储层 | 持久化存储原始数据与加工后数据,支持横向扩展 | HDFS、Hive、ICEBERG |

| 数据加工层 | 数据清洗、转换、聚合,构建结构化数据集 | MapReduce、Spark、Flink |

| 数据服务层 | 提供SQL查询、OLAP分析、实时计算等服务 | Hive、Impala、Presto |

| 元数据管理层 | 管理表结构、分区信息、权限等元数据 | Hive Metastore、Atlas |

关键技术组件与选型

存储引擎

- HDFS:作为底层分布式文件系统,提供高容错、低成本存储,适合存储大规模原始数据。

- Hive:基于HDFS构建数据仓库,支持SQL语法(HiveQL),适合离线批处理。

- Iceberg/Hudi:支持ACID事务、时间旅行(Time Travel),解决Hive无法高效更新的问题。

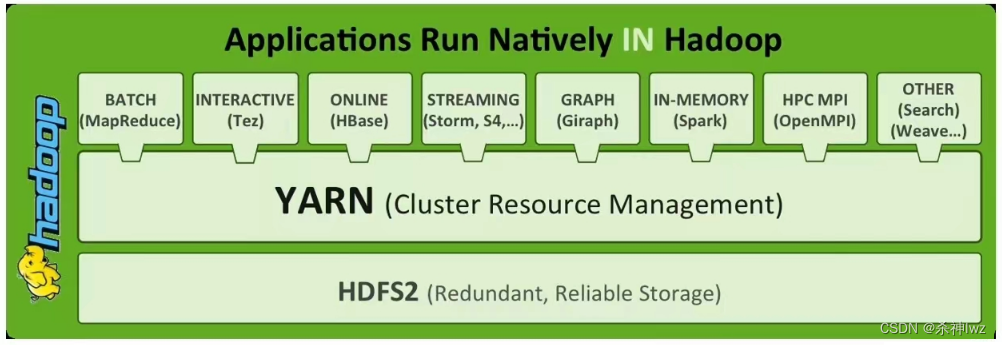

计算引擎

- MapReduce:适用于高延迟、大吞吐量的离线任务(如ETL)。

- Spark:支持内存计算与迭代式算法,适合机器学习和实时处理。

- Impala/Presto:提供低延迟的交互式SQL查询,适合即席分析。

数据集成工具

- Sqoop:实现关系型数据库与HDFS/Hive的数据导入导出。

- Flume/Kafka:用于实时日志流、事件流的采集与传输。

数据存储与管理策略

数据分区与分桶

- 分区(Partition):按时间、地域等维度划分数据,减少查询扫描范围,按天分区存储日志数据。

- 分桶(Bucket):对关键字段哈希分桶,均匀分布数据,提升并行度,按用户ID分桶实现负载均衡。

存储格式选择

| 格式 | 特点 | 适用场景 |

|---|---|---|

| Parquet | 列式存储,压缩率高,支持向量化计算 | OLAP分析、复杂查询 |

| ORC | 优化列式存储,支持轻量级索引 | Hive高并发查询 |

| Avro | 支持Schema演化,适合动态数据结构 | 日志流、半结构化数据 |

元数据管理

- Hive Metastore:集中管理表定义、分区信息,但存在单点故障风险。

- Atlas:支持多数据源元数据统一管理,提供血缘分析(Lineage)能力。

数据处理流程

数据采集

- 批量导入:使用Sqoop从MySQL/Oracle导入数据至HDFS。

- 实时流式:通过Flume采集日志文件,或Kafka接收事件流。

数据清洗与转换

- ETL作业:基于Spark编写清洗逻辑(如去重、缺失值填充)。

- 数据标准化:统一时间格式、单位转换(如流量字节转MB)。

数据建模与存储

- 星型模型:事实表(Fact Table)关联维度表(Dimension Table),适合业务分析。

- 宽表设计:冗余存储常用维度,减少JOIN操作,提升查询性能。

数据分析与应用

- OLAP查询:通过Hive/Impala执行复杂SQL,生成报表。

- 机器学习:使用Spark MLlib训练模型,结果存储回数据仓库。

性能优化策略

资源调优

- YARN资源配置:调整AM/Executor内存、并行度(parallelism),避免资源争抢。

- 动态资源分配:启用Capacity Scheduler,为不同队列分配专属资源。

查询优化

- 谓词下推(Predicate Pushdown):过滤条件尽早在数据节点执行,减少IO。

- 广播变量:小表广播至所有节点,避免Shuffle阶段数据传输。

存储优化

- 文件大小控制:单个HDFS文件建议128MB~1GB,避免过多小文件。

- 压缩编码:启用Snappy/LZO压缩,配合BloomFilter加速数据跳过。

常见问题与解决方案

FAQs

Q1:如何选择Parquet与ORC格式?

A1:Parquet更适合通用场景,支持更多压缩算法(如Zstd);ORC专为Hive优化,索引效率更高,若需跨引擎兼容(如Impala+Spark),优先Parquet。

Q2:如何处理数据倾斜问题?

A2:

- 预处理阶段:对倾斜键(如热门用户ID)打散分桶。

- 计算阶段:使用Spark的

skewed参数自动平衡分区。 - 事后补救:对倾斜Key单独计算,最后合并结果。

通过以上架构设计与技术实践,Hadoop集群中的分布式数据仓库能够高效支撑PB级数据的存储与分析,为企业决策