hadoop集群ip网络设置

- 行业动态

- 2025-05-09

- 2

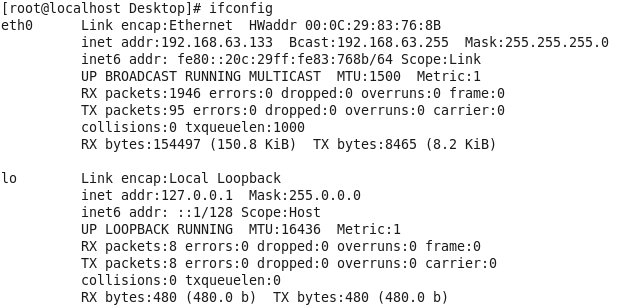

Hadoop集群IP网络设置需配置静态IP,修改/etc/hosts实现主机名解析,关闭防火墙或开放必要端口,配置SSH免密登录

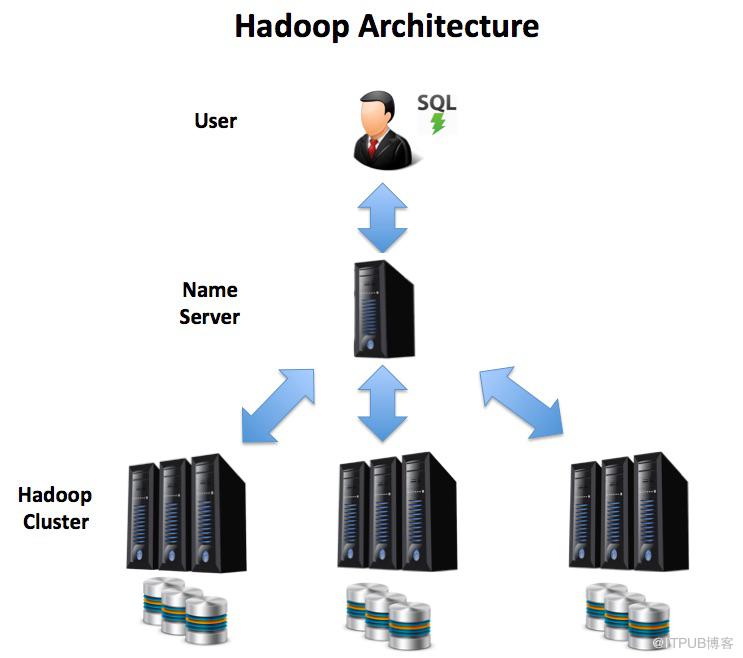

Hadoop集群IP网络设置详解

网络规划基础原则

在部署Hadoop集群前,合理的IP网络规划是保障集群稳定运行的核心要素,以下是关键设计原则:

| 规划维度 | 具体要求 |

|---|---|

| IP地址分配 | 采用静态IP绑定,避免DHCP动态分配导致节点标识变化 |

| 子网划分 | 建议使用/24或更小的子网掩码,保证所有节点处于同一广播域 |

| 网关配置 | 所有节点需指向相同网关,确保跨节点通信能力 |

| DNS解析 | 推荐部署内部DNS服务器或维护完整的/etc/hosts映射表 |

| 端口预留 | 需开放HDFS(50010-50020)、YARN(8030-8050)、Hive(9083)等关键端口 |

主机名与IP绑定配置

修改/etc/hosts文件

在所有节点配置统一的主机名解析规则,示例如下:168.1.100 namenode.example.com namenode 192.168.1.101 datanode1.example.com datanode1 192.168.1.102 datanode2.example.com datanode2

禁用反向DNS查找

编辑/etc/hadoop/core-site.xml添加:<property> <name>hadoop.security.dns.reverse.lookup</name> <value>false</value> </property>

SSH免密配置

生成密钥对并分发公钥:ssh-keygen -t rsa for node in namenode datanode1 datanode2; do ssh-copy-id $node@hostname; done

核心配置文件网络参数

core-site.xml

<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://namenode:8020</value> <!-使用主机名而非IP --> </property> <property> <name>hadoop.proxyuser.root.hosts</name> <value>.example.com</value> <!-允许指定域内的节点 --> </property> </configuration>

hdfs-site.xml

<configuration> <property> <name>dfs.namenode.rpc-address</name> <value>namenode:8020</value> <!-明确指定RPC通信地址 --> </property> <property> <name>dfs.datanode.address</name> <value>0.0.0.0:50010</value> <!-监听所有网络接口 --> </property> </configuration>

yarn-site.xml

<configuration> <property> <name>yarn.resourcemanager.hostname</name> <value>namenode</value> <!-资源调度器绑定地址 --> </property> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle:9001</value> <!-Shuffle服务端口配置 --> </property> </configuration>

防火墙与安全组配置

| 协议类型 | 端口范围 | 用途说明 |

|---|---|---|

| TCP | 8020 | NameNode RPC通信 |

| TCP | 50010-50020 | DataNode数据传输 |

| TCP | 8030-8032 | ResourceManager通信 |

| TCP | 8040-8042 | NodeManager通信 |

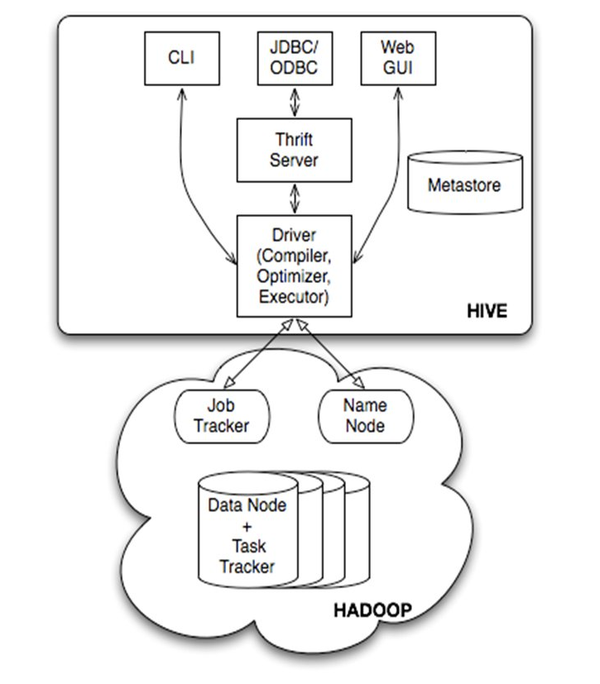

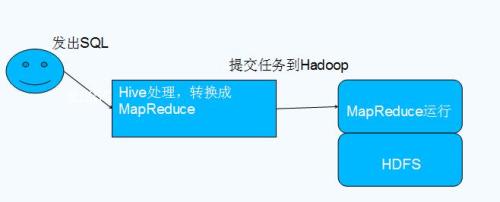

| TCP | 9083 | HiveServer2服务 |

| UDP | 50010-50020 | DataNode心跳检测(可选配置) |

Linux防火墙配置示例:

firewall-cmd --permanent --add-port=8020/tcp firewall-cmd --permanent --add-port=50010-50020/tcp firewall-cmd --reload

高可用网络架构设计

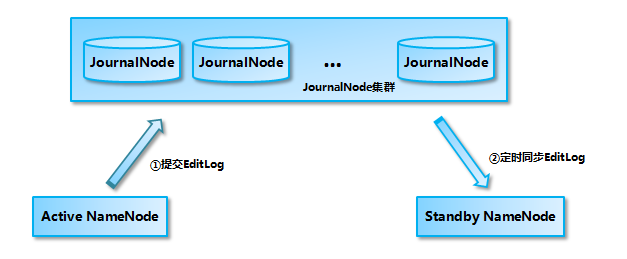

双活NameNode部署

- 配置Active/Standby模式

- 共享存储使用QJACKSON协议或NFS+ZooKeeper方案

- JournalNode集群部署在不同机架

跨机房集群网络优化

- 采用BGP多线接入保障网络质量

- 配置Hadoop拓扑感知脚本(topology_script.sh)

- 启用短回路优先策略:

<property> <name>net.topology.script.file.name</name> <value>/etc/hadoop/topology_script.sh</value> </property>

网络冗余方案

| 方案类型 | 实现方式 |

|———-|————————————————————————–|

| 多网卡绑定 | 使用bond0绑定eth0/eth1,配置LACP协议 |

| VRRP | 通过keepalived实现VIP漂移 |

| NAT | 配置haproxy做负载均衡,隐藏内部网络结构 |

典型故障排查指南

节点无法通信

- 检查/etc/hosts解析是否正确

- 验证防火墙规则是否阻断必要端口

- 测试ping通性和端口连通性:

for node in namenode datanode1 datanode2; do nc -zv $node 8020; done

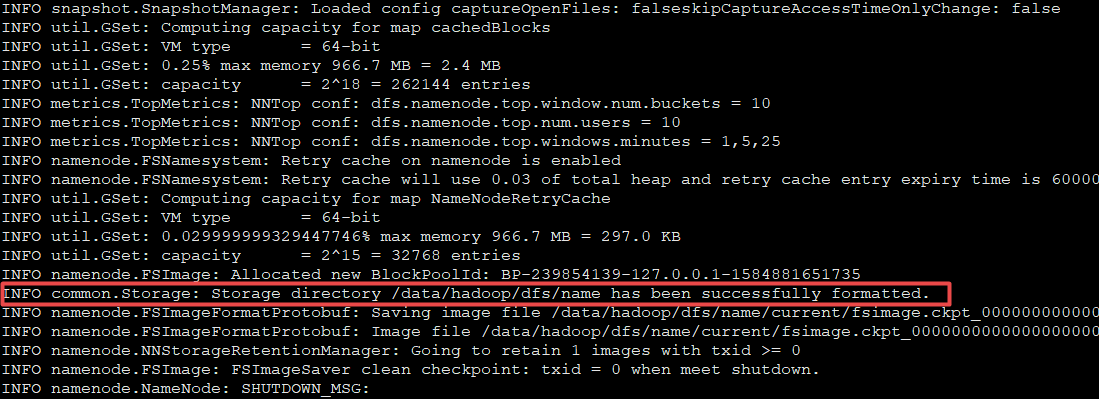

DataNode注册失败

- 确认dfs.datanode.address配置正确

- 检查50010-50020端口是否被占用

- 查看namenode日志中的连接拒绝报错

YARN容器分配异常

- 验证yarn.resourcemanager.hostname解析正确

- 检查8030-8032端口的网络可达性

- 确认NodeManager的aux-services配置完整

安全增强措施

Kerberos认证配置

- 修改core-site.xml启用认证:

<property> <name>hadoop.security.authentication</name> <value>kerberos</value> </property>

- 配置krb5.conf文件,指定KDC服务器地址

- 生成keytab文件并分发到各节点

- 修改core-site.xml启用认证:

SSL加密通信

- 生成证书并配置HTTPS:

<property> <name>dfs.https.enable</name> <value>true</value> </property>

- 强制客户端使用SSL连接:

<property> <name>dfs.client.use.ssl</name> <value>true</value> </property>

- 生成证书并配置HTTPS:

网络隔离策略

- 划分管理网络(10.0.0.x)和数据网络(192.168.x)

- 配置VLAN实现流量隔离

- 限制SSH访问来源IP白名单

性能优化建议

MTU设置

- 根据网络环境调整Jumbo Frame:

ifconfig eth0 mtu 9000

- HDFS参数同步调整:

<property> <name>dfs.datanode.max.transfer.threads</name> <value>4096</value> <!-根据MTU值优化 --> </property>

- 根据网络环境调整Jumbo Frame:

零拷贝优化

- 启用短路读写:

<property> <name>dfs.client.read.packet.threshold</name> <value>134217728</value> <!-128MB --> </property>

- 配置DIGEST校验:

<property> <name>dfs.datanode.digest.algorithm</name> <value>CRC32C</value> </property>

- 启用短路读写:

网络拓扑感知

- 自定义拓扑脚本示例:

#!/bin/bash case "$1" in namenode) echo "1" ;; datanode) echo "2" ;; ) echo "3" ;; esac

- 配置rack awareness:

<property> <name>net.topology.script.number.of.parts</name> <value>3</value> </property>

- 自定义拓扑脚本示例:

FAQs常见问题解答

Q1: 集群中存在动态IP地址会有什么影响?

A1: 动态IP会导致以下问题:

- 节点重启后IP变化,/etc/hosts需要频繁更新

- NameNode元数据中的节点标识失效,引发数据块丢失告警

- YARN容器分配时因地址变更导致任务提交失败

建议方案:在/etc/cloud/cloud.cfg.d/disable_network_config.cfg中禁用NetworkManager:network: {config: false}并通过ifcfg-eth0配置文件固定MAC地址与IP绑定。

Q2: 如何实现跨网段Hadoop集群通信?

A2: 跨网段部署需要:

- 配置路由表实现网段互通:

ip route add 192.168.2.0/24 via 192.168.1.254 dev eth0

- 修改hdfs-site.xml启用跨网段发现:

<property> <name>dfs.datanode.address</name> <value>0.0.0.0:50010</value> <!-监听所有接口 --> </property>

- 在防火墙设置中允许网段间通信:

firewall-cmd --permanent --add-rich-rule='rule family="ipv4" source address="192.168.2.0/2