上一篇

分布式数据库结构

- 行业动态

- 2025-05-06

- 3710

分布式数据库将数据分片存储于多节点,通过逻辑统一管理实现高可用与扩展性,常见主从、对等及混合结构,兼顾一致性与容错,适用于

分布式数据库结构详解

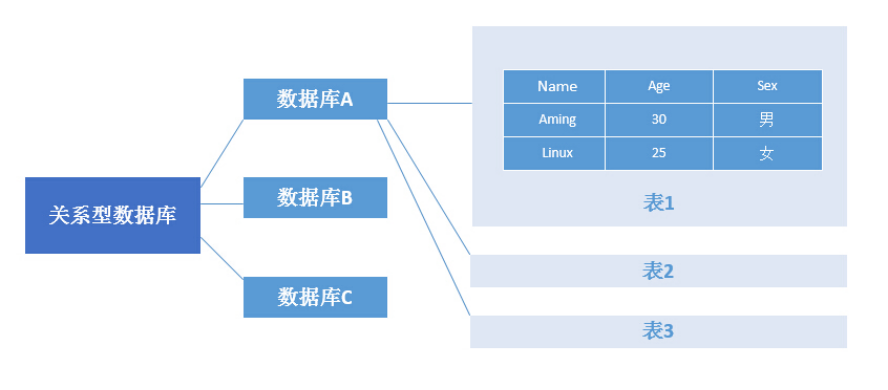

分布式数据库是一种将数据存储在多个物理节点上的数据库系统,通过分布式架构实现高可用性、可扩展性和容错能力,其核心目标是解决传统集中式数据库在性能、容量和可靠性方面的瓶颈,以下是分布式数据库结构的关键组成部分与设计原理:

分布式数据库的核心架构

分布式数据库的架构设计直接影响其性能、一致性和扩展性,常见的架构类型包括:

| 架构类型 | 特点 | 适用场景 |

|---|---|---|

| 主从复制(Master-Slave) | 一个主节点负责写操作,多个从节点同步数据,读写分离。 | 读多写少的场景(如内容分发平台) |

| 多主复制(Multi-Master) | 所有节点均可处理读写请求,数据通过冲突解决机制保持一致。 | 高并发读写且需低延迟的场景 |

| 分片(Sharding) | 数据按规则拆分到不同节点,每个节点独立管理部分数据。 | 海量数据存储与高吞吐量场景 |

| 混合架构 | 结合分片与复制,兼顾数据分布与高可用性。 | 大型互联网服务(如电商、社交) |

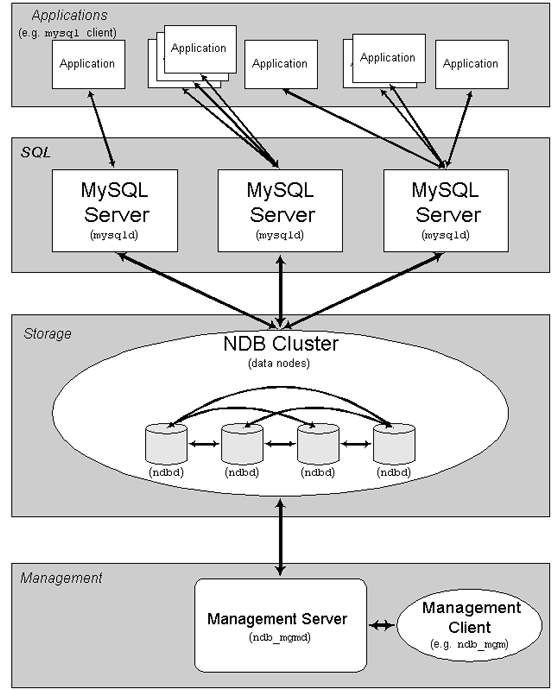

分布式数据库的核心组件

节点(Node)

- 存储节点:负责存储数据分片,支持水平扩展。

- 协调节点:管理元数据、路由请求、处理全局事务(如使用Raft或Paxos协议)。

数据分片(Sharding)

- 分片策略:

- 哈希分片:根据主键哈希值分配数据,均衡负载但范围查询效率低。

- 范围分片:按时间或ID范围划分数据,适合范围查询但易导致热点。

- 目录分片:通过目录表记录数据分布,灵活但依赖中心化目录管理。

- 分片示例:

-按用户ID哈希分片 SHARD_KEY = HASH(user_id) % 4 -假设4个分片

- 分片策略:

一致性协议

- CAP定理权衡:

- CP(一致性+分区容错):如HBase,强一致性但牺牲可用性。

- AP(可用性+分区容错):如Cassandra,允许临时不一致但保证高可用。

- 常见协议:

- Paxos/Raft:用于选举主节点和日志复制。

- Quorum NWR:通过读写多数节点实现最终一致性(如DynamoDB)。

- CAP定理权衡:

事务管理

- 分布式事务:通过两阶段提交(2PC)或三阶段提交(3PC)保证跨节点一致性,但性能开销大。

- BASE理论:牺牲强一致性,采用异步复制和最终一致性(如NoSQL数据库)。

数据分布与负载均衡

数据分布策略

- 垂直分片:按业务模块拆分数据库(如用户表、订单表分开存储)。

- 水平分片:按数据行拆分,支持动态扩展。

负载均衡机制

- 静态分片:预先定义分片规则,简单但灵活性差。

- 动态分片:根据负载自动迁移数据(如ShardingSphere的自动平衡)。

容错与高可用设计

副本机制

- 每个分片存储多个副本(如3个),通过投票机制选举主副本。

- 副本同步方式:同步刷盘(强一致)或异步复制(高可用)。

故障恢复

- 节点故障:自动切换到备用副本,重新分配数据。

- 网络分区:基于CAP定理选择优先保障可用性或一致性。

典型分布式数据库对比

| 数据库 | 架构类型 | 一致性模型 | 适用场景 |

|---|---|---|---|

| MySQL Cluster | 主从复制+共享存储 | 强一致性 | 中小型OLTP系统 |

| Cassandra | 多主复制+分片 | 最终一致性 | 大规模写入(如日志系统) |

| CockroachDB | 多主复制+Raft协议 | 线性一致性 | 云原生应用(如金融) |

| TiDB | 分布式HTAP | 可配置一致性 | 混合负载(OLTP+OLAP) |

分布式数据库的挑战

- 数据倾斜:热点数据导致部分节点负载过高,需通过虚拟分片或动态迁移解决。

- 全局事务成本:跨节点事务会显著降低性能,需权衡一致性与效率。

- 运维复杂度:节点扩容、数据迁移、故障恢复均需自动化工具支持。

FAQs

Q1:如何选择分布式数据库的分片策略?

A1:根据业务需求选择:

- 哈希分片:适合均匀分布的随机读写(如用户ID分散的场景)。

- 范围分片:适合时间序列或连续ID的查询(如订单按时间分片)。

- 混合分片:结合哈希与范围,例如先按哈希分片,再在分片内按范围排序。

Q2:分布式数据库如何应对节点故障?

A2:通过以下机制保障:

- 副本冗余:每个分片存储多个副本,主副本故障时自动切换。

- 心跳检测:协调节点定期检查节点状态,触发故障转移。

- 数据重建:故障节点恢复后,通过增量复制或全量备份恢复数据