上一篇

分布式文件存储space

- 行业动态

- 2025-05-04

- 1

分布式文件存储通过分片与冗余备份实现海量数据高效存储,具备扩展性强、高可用特点,适用于

分布式文件存储系统核心解析与空间管理策略

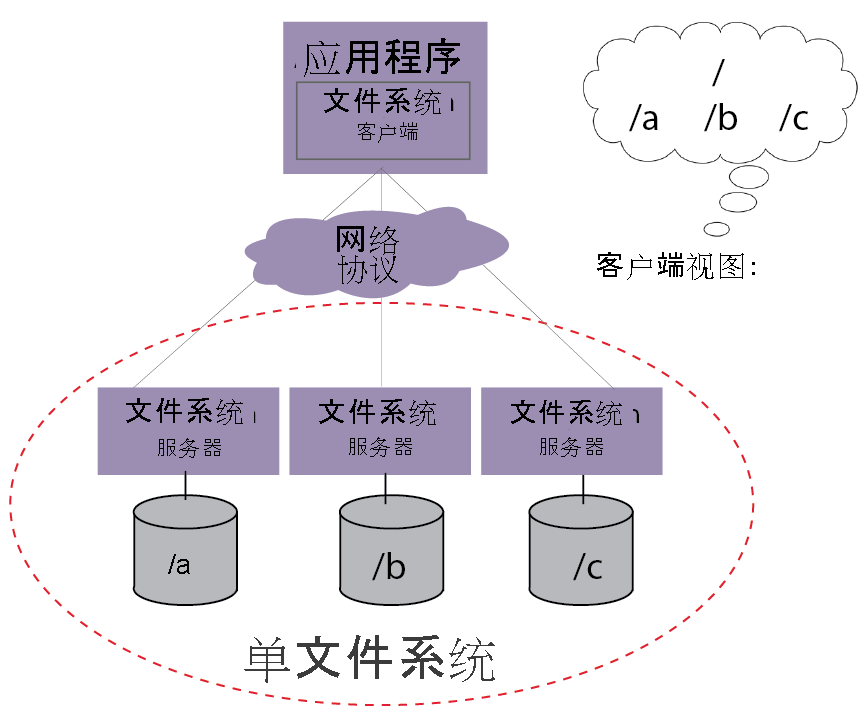

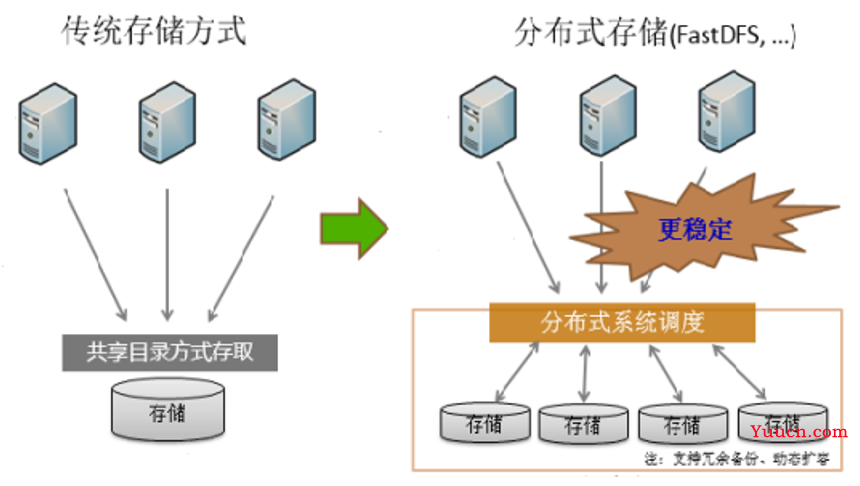

分布式文件存储基础架构

分布式文件存储系统通过将数据分散存储在多个物理节点上,实现高可用性、可扩展性和高性能,其核心架构通常包含以下模块:

| 组件 | 功能描述 |

|---|---|

| 客户端 | 负责数据上传/下载请求,与元数据服务器交互获取存储位置,执行数据分片和校验 |

| 元数据服务器 | 管理文件元信息(如目录结构、分块位置、权限),协调数据读写操作 |

| 存储节点 | 实际存储数据分块,处理数据读写请求,执行数据修复和冗余策略 |

| 监控模块 | 实时监测节点状态、网络延迟、存储容量,触发负载均衡和故障转移机制 |

典型系统如HDFS采用主从架构,Ceph通过CRUSH算法实现智能数据分布,而GlusterFS则采用纯分布式无中心节点的设计。

核心技术与空间优化机制

分布式存储系统的核心挑战在于如何高效利用物理存储空间(Physical Space)并最大化有效存储空间(Effective Space),以下是关键实现技术:

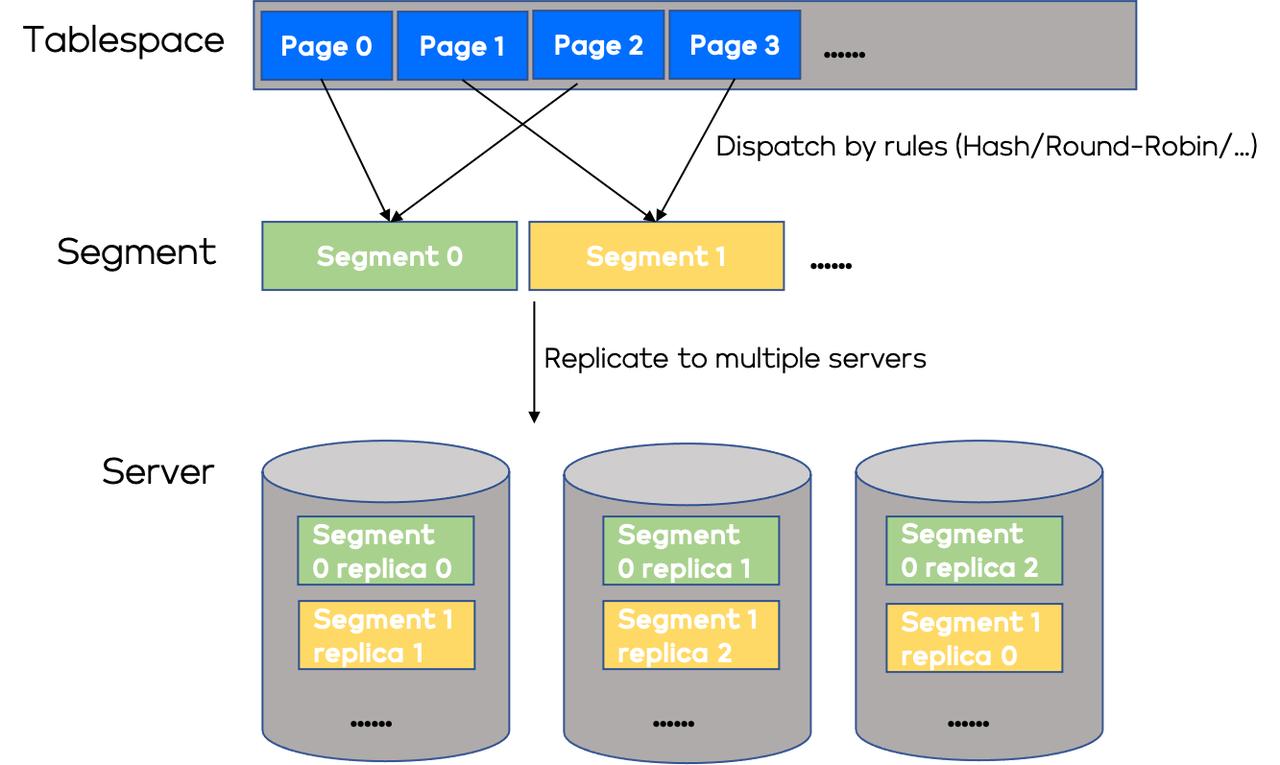

数据分片与冗余策略

- 固定分块:将文件切割为固定大小块(如HDFS的128MB),便于并行处理

- 动态分块:根据文件特性自适应分块(如Ceph的Object Storage)

- 冗余机制:

- 副本策略:3副本存储(如HDFS)占用300%物理空间

- 纠删码:将1份数据拆分为N份,生成M份校验数据,空间利用率提升至(N/(N+M)),例如RAID6的(6/8)

- 混合模式:热数据用副本,冷数据用纠删码

空间管理关键技术

| 技术 | 作用机制 | 空间增益 |

|———————|————————————————————————–|———-|

| 数据去重 | 哈希指纹检测重复数据块,仅存储唯一实例 | 最高90% |

| 压缩算法 | Zlib/Snappy/LZ4实时压缩,减少传输和存储数据量 | 50%-70% |

| 稀疏文件处理 | 仅记录非零数据块,适用于科学计算场景 | 90%+ |

| 动态空间回收 | 基于LSM树的元数据管理,支持快速删除大文件后的空间释放 | <1s |

容量规划与弹性扩展

- 横向扩展:通过添加存储节点线性提升容量,需平衡数据重分布成本

- 分层存储:

- 热层:SSD存储高频访问数据(空间占比5%-10%)

- 冷层:HDD/机械盘存储低频数据(空间占比60%-80%)

- 归档层:对象存储保存长期数据(空间占比15%-25%)

- 预留空间策略:保留15%-20%冗余应对数据增长突发

空间管理实践案例

以某EB级存储系统为例,采用混合架构实现空间优化:

| 层级 | 存储介质 | 容量占比 | 冗余策略 | 平均空间效率 |

|---|---|---|---|---|

| 热数据层 | NVMe SSD | 8% | 3副本 | 67% |

| 温数据层 | SATA SSD | 25% | 纠删码(8+4) | 5% |

| 冷数据层 | HC HDD | 55% | 纠删码(12+4) | 75% |

| 归档层 | 对象存储 | 12% | EC(10+4) | 7% |

通过智能分层和动态迁移机制,该系统实现:

- 日均数据写入量:50TB/s

- 存储空间利用率:71.3%

- 每TB存储成本:$0.12/月

空间管理挑战与解决方案

挑战1:数据倾斜导致空间浪费

- 现象:部分节点存储满溢,其他节点空闲

- 解决方案:

- CRUSH算法实现数据均匀分布

- 动态负载均衡(每日/每周数据迁移)

- 引入纠删码降低热点压力

挑战2:元数据膨胀

- 问题:海量小文件导致元数据占用过高(可达总空间的15%)

- 优化方案:

- 合并小文件为容器(如HDFS的BlockPool)

- 元数据分级存储(内存+SSD+HDD)

- 采用扁平化命名空间设计

FAQs

Q1:如何判断存储系统是否需要扩容?

A:当同时满足以下条件时应考虑扩容:

- 可用空间 < 总容量的15%

- 写入成功率 < 99.9%

- 数据重建队列长度 > 节点数×2

建议提前3-6个月规划,避免业务中断。

Q2:纠删码和副本策略如何选择?

A:决策依据:

- 读写性能需求:副本策略时延低(适合数据库日志)

- 存储成本敏感度:纠删码节省60%空间(适合大数据分析)

- 数据重要性:核心业务建议混合使用(热数据