分布式存储ppt

- 行业动态

- 2025-05-17

- 9

分布式存储技术详解

核心概念与定义

分布式存储是一种通过多台服务器协同工作,将数据分散存储在多个节点上的技术,其核心目标是解决传统集中式存储的容量瓶颈、性能限制和单点故障问题,以下是分布式存储的关键特性:

| 特性 | 说明 |

|---|---|

| 扩展性 | 支持横向扩展(Scale-out),通过增加节点提升容量和性能 |

| 容错性 | 数据冗余机制保证单点故障不影响业务,如副本、纠删码等 |

| 透明性 | 对上层应用表现为单一存储系统,隐藏底层分布式细节 |

| 负载均衡 | 数据自动分片并均匀分布到各节点,避免热点问题 |

| 地理分布 | 支持跨数据中心部署,实现数据就近访问和灾备 |

架构设计核心组件

客户端(Client)

- 负责发起数据读写请求

- 需具备负载均衡能力(如一致性哈希算法)

- 典型协议:POSIX、FTP、RESTful API

元数据管理(Metadata Service)

- 维护文件/块的元信息(如目录结构、权限、位置映射)

- 常见实现:

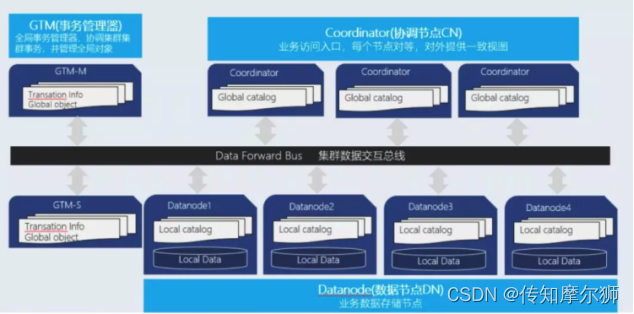

- 集中式:单点元数据服务器(如Ceph MON)

- 分布式:多节点共识协议(如HDFS NameNode Active/Standby)

数据存储节点(Storage Node)

- 实际存储数据分片(Block/Chunk)

- 关键功能:

- 数据冗余(副本数、纠删码策略)

- 本地缓存加速(如LRU缓存算法)

- 磁盘IO优化(顺序写入、SSD+HDD混合存储)

网络通信层

- 关键协议:gRPC、Thrift、HTTP/HTTPS

- 优化手段:

- 数据压缩(如Zstandard、Snappy)

- 零拷贝传输(减少CPU负载)

- 流量整形与QoS控制

数据分布与冗余策略

| 策略 | 原理 | 优缺点 |

|---|---|---|

| 副本复制 | 每份数据保存多个完整副本 | 简单易实现,但存储成本高(如3副本占300%空间) |

| 纠删码 | 通过编码算法生成冗余数据块 | 存储效率高(如RF=6时存储开销仅200%),但计算复杂度高 |

| 混合模式 | 热数据用副本,冷数据用纠删码 | 平衡性能与成本,需动态数据分类机制 |

典型纠删码算法对比:

- Reed-Solomon:经典算法,修复带宽高

- XOR-based:计算简单,仅支持两块数据恢复

- Cauchy Reed-Solomon:优化修复效率,适合大规模集群

一致性模型与CAP定理

CAP定理约束

| 维度 | 说明 | 典型场景选择 |

|———-|——————————|————————————-|

| Consistency | 数据强一致(如银行交易) | 牺牲可用性(如ZooKeeper选举) |

| Availability | 服务高可用(如电商首页) | 牺牲一致性(如最终一致性) |

| Partiition Tolerance | 分区容忍(跨数据中心) | 必须满足,导致CP或AP选择 |一致性保障方案

- 强一致性:Paxos/Raft协议(如Etcd集群)

- 最终一致性:版本向量(Vector Clocks)、冲突解决(如DNS记录更新)

- 因果一致性:基于时间戳的依赖关系(如消息队列)

性能优化关键技术

数据局部性优化

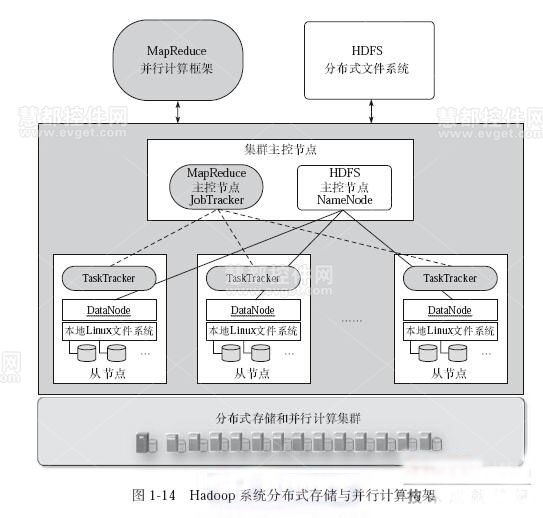

- 策略:将数据分片与计算任务绑定(如Hadoop MapReduce)

- 效果:减少跨节点数据传输,提升IO吞吐量

缓存分层设计

| 层级 | 作用 | 技术示例 |

|—————-|———————————–|————————–|

| L1(客户端) | 加速频繁访问的数据 | Memcached、LRU缓存 |

| L2(边缘节点) | 降低核心存储压力 | CDN节点、Redis集群 |

| L3(持久化) | 确保数据可靠性 | HDD/SSD混合存储 |并行读写优化

- 向量化IO:批量处理小文件(如合并为大Block)

- Pipeline处理:数据流式传输(如Spark Shuffle优化)

- 异步IO:非阻塞请求提升吞吐量(如Node.js事件驱动模型)

主流分布式存储系统对比

| 系统 | 架构特点 | 适用场景 | 最大短板 |

|---|---|---|---|

| HDFS | 主从架构,块存储,强顺序写入 | 大数据离线分析(如MapReduce) | 低延迟随机读写性能差 |

| Ceph | 统一存储(块/文件/对象),CRUSH算法 | 云存储、二级存储 | 元数据性能瓶颈 |

| GlusterFS | 纯分布式设计,无中心元数据 | 中小规模文件共享 | 扩展性受限 |

| MinIO | S3协议兼容,高性能对象存储 | 云原生应用、备份归档 | 元数据存储依赖外部数据库 |

| MongoDB | 文档型NoSQL,副本集+分片 | 高并发读写、半结构化数据 | 内存消耗大 |

典型故障处理流程

节点宕机检测

- 心跳机制(如每3秒发送Ping包)

- 超时阈值动态调整(避免误判)

数据恢复流程

- 副本缺失:优先从存活节点复制数据

- 纠删码丢失:触发重构计算(如RS编码恢复)

- 脑裂问题:仲裁机制(如Quorum > N/2)

数据一致性修复

- 版本冲突解决:时间戳优先、应用侧合并

- 事务回滚:基于WAL(Write-Ahead Log)重放

FAQs

Q1:分布式存储与集中式存储的核心区别是什么?

A1:集中式存储依赖单一设备,存在容量、性能和单点故障瓶颈;分布式存储通过多节点协同,实现容量线性扩展、负载均衡和高可用,但需解决数据一致性与网络延迟问题。

Q2:如何选择纠删码与副本策略?

A2:热数据(高频访问)建议用副本(如3副本)以保证低延迟;冷数据(低频访问)适合纠删码(如RF=6,EC=2)以节省存储空间,需结合业务SLA要求